Récemment, un de nos lecteurs nous a demandé comment optimiser le fichier robots.txt pour améliorer le référencement.

Le fichier Robots.txt indique aux moteurs de recherche comment explorer votre site, ce qui en fait un outil de référencement incroyablement puissant.

Dans cet article, nous allons vous afficher quelques astuces pour créer un fichier robots.txt parfait pour le référencement.

Qu’est-ce qu’un fichier Robots.txt ?

Robots.txt est un fichier texte que les propriétaires de sites web peuvent créer pour indiquer aux moteurs de recherche comment explorer et indexer les pages de leurs sites.

Il est généralement stocké dans le répertoire racine (également appelé dossier principal) de votre site. Le format de base d’un fichier Robots.txt est le suivant :

User-agent: [user-agent name]

Disallow: [URL string not to be crawled]

User-agent: [user-agent name]

Allow: [URL string to be crawled]

Sitemap: [URL of your XML Sitemap]

Vous pouvez avoir plusieurs lignes d’instructions pour permettre ou interdire des URL spécifiques et ajouter plusieurs plans de site. Si vous n’interdisez pas une URL, les moteurs de recherche supposent qu’ils sont autorisés à l’explorer.

Voici à quoi peut ressembler un fichier d’exemple Robots.txt :

User-Agent: *

Allow: /wp-content/uploads/

Disallow: /wp-content/plugins/

Disallow: /wp-admin/

Sitemap: https://example.com/sitemap_index.xml

Dans l’exemple ci-dessus de robots.txt, nous avons permis aux moteurs de recherche d’explorer et d’indexer les fichiers de notre dossier de téléversement WordPress.

Ensuite, nous avons interdit aux robots de recherche d’explorer et d’indexer les extensions et les dossiers d’administration de WordPress.

Dernier point, nous avons indiqué l’URL de notre sitemap XML.

Avez-vous besoin d’un fichier Robots.txt pour votre site WordPress ?

Si vous n’avez pas de fichier Robots.txt, les moteurs de recherche continueront d’explorer et d’indexer votre site. Toutefois, vous ne pourrez pas leur indiquer les pages ou les dossiers qu’ils ne doivent pas explorer.

Cela n’aura pas beaucoup d’impact lorsque vous démarrez un blog et que vous n’avez pas beaucoup de contenu.

Cependant, au fur et à mesure que votre site se développe et que vous ajoutez du contenu, vous souhaiterez probablement mieux contrôler la manière dont votre site est exploré et indexé.

Voici pourquoi.

Les robots de recherche disposent d’un quota d’exploration pour chaque site.

Cela signifie qu’il explore un certain nombre de pages au cours d’une session d’exploration. S’ils épuisent leur budget d’exploration avant d’avoir fini d’explorer toutes les pages de votre site, ils reviendront et reprendront l’exploration lors de la session suivante.

Cela peut ralentir le taux d’indexation de votre site.

Vous pouvez corriger ce problème en empêchant les robots de recherche d’essayer d’explorer des pages inutiles comme les pages d’administration de WordPress, les fichiers d’extension et le dossier des thèmes.

En interdisant les pages inutiles, vous enregistrez votre quota d’exploration. Cela aide les moteurs de recherche à explorer encore plus de pages sur votre site et à les indexer le plus rapidement possible.

Une autre bonne raison d’utiliser un fichier Robots.txt est d’empêcher les moteurs de recherche d’indexer une publication ou une page de votre site.

Ce n’est pas le moyen le plus sûr de masquer un contenu au grand public, mais cela vous aidera à empêcher un contenu d’apparaître dans les résultats de recherche.

À quoi ressemble un fichier Robots.txt idéal ?

De nombreux blogs populaires utilisent un fichier Robots.txt très simple. Leur contenu peut varier en fonction des besoins du site concerné :

User-agent: *

Disallow:

Sitemap: http://www.example.com/post-sitemap.xml

Sitemap: http://www.example.com/page-sitemap.xml

Ce fichier robots.txt autorise tous les robots à indexer l’ensemble du contenu et leur fournit un lien vers les sitemaps XML du site.

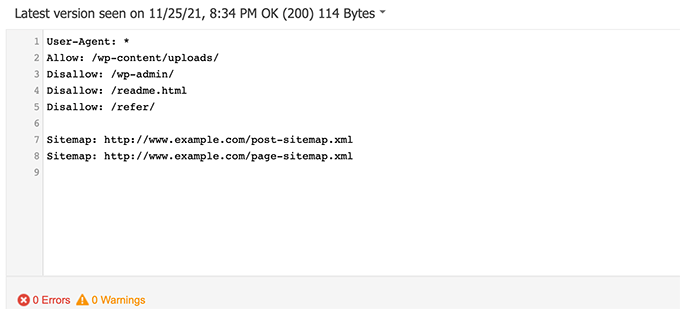

Pour les sites WordPress, nous recommandons les règles suivantes dans le fichier robots.txt :

User-Agent: *

Allow: /wp-content/uploads/

Disallow: /wp-admin/

Disallow: /readme.html

Disallow: /refer/

Sitemap: http://www.example.com/post-sitemap.xml

Sitemap: http://www.example.com/page-sitemap.xml

Cela permet aux robots de recherche d’indexer toutes les images et tous les fichiers de WordPress. Il empêche les robots de recherche d’indexer la zone d’administration de WordPress, le fichier readme et les liens d’affiliation masqués.

En ajoutant des sitemaps au fichier robots.txt, vous permettez aux robots de Google de trouver facilement toutes les pages de votre site.

Maintenant que vous savez à quoi ressemble un fichier robots.txt idéal, voyons comment créer un fichier robots.txt dans WordPress.

Comment créer un fichier Robots.txt dans WordPress

Il y a deux façons de créer un fichier Robots.txt dans WordPress. Vous pouvez choisir la méthode qui vous convient le mieux.

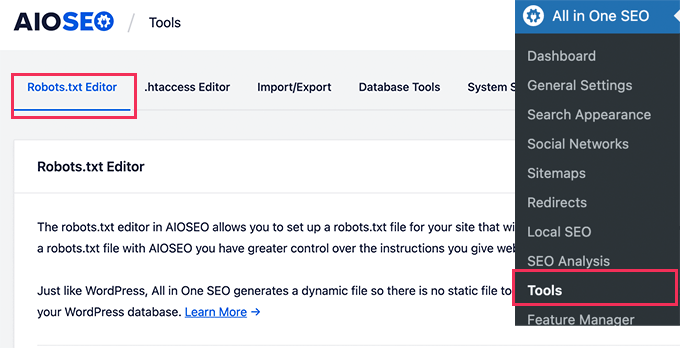

Méthode 1 : Modifier le fichier Robots.txt à l’aide de All in One SEO

All in One SEO, également connu sous le nom d’AIOSEO, est la meilleure extension WordPress SEO sur le marché, utilisée par plus de 3 millions de sites. Il est facile à utiliser et est livré avec un générateur de fichiers Robots.txt.

Pour en savoir plus, consultez notre avis détaillé sur AIOSEO.

Si vous n’avez pas encore installé l’extension AIOSEO, vous pouvez consulter notre guide étape par étape sur l’installation d’une extension WordPress.

Note : Une version gratuite d’AIOSEO est également disponible et dispose de cette fonctionnalité.

Une fois l’extension installée et activée, vous pouvez l’utiliser pour créer et modifier votre fichier robots.txt directement depuis votre zone d’administration WordPress.

Il vous suffit d’aller dans All in One SEO » Tools pour modifier votre fichier robots.txt.

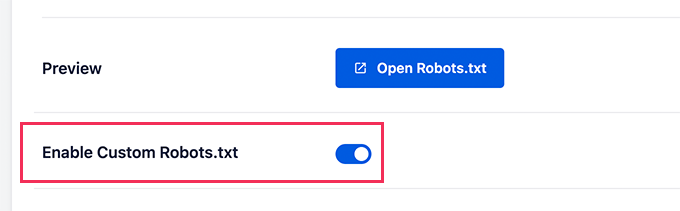

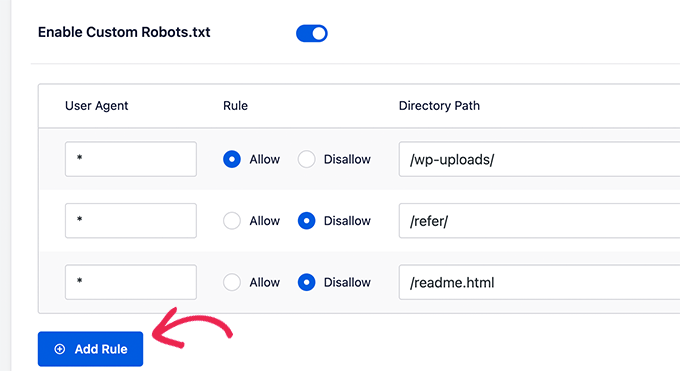

Tout d’abord, vous devez activer l’option de modification en cliquant sur le bouton « Enable Custom Robots.txt » (Activer les Robots.txt personnalisés), qui devient bleu.

En activant ce permutateur, vous pouvez créer un fichier Robots.txt personnalisé dans WordPress.

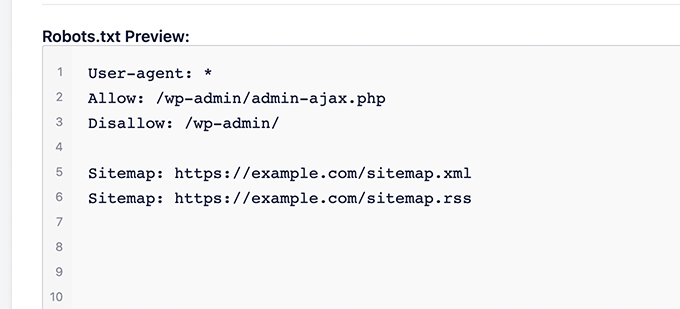

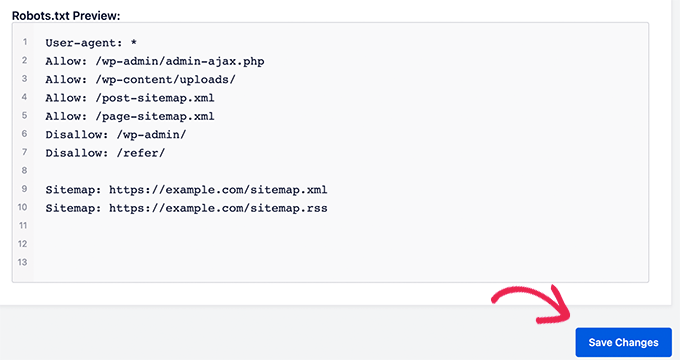

All in One SEO affichera votre fichier robots.txt existant dans la section ‘Prévisualisation Robots.txt’ en bas de votre écran.

Cette version affichera les règles par défaut qui ont été ajoutées par WordPress.

Ces règles par défaut indiquent aux moteurs de recherche de ne pas explorer vos fichiers WordPress centraux, autorisent les robots à indexer tout le contenu et leur fournissent un lien vers les sitemaps XML de votre site.

Désormais, vous pouvez ajouter vos propres règles personnalisées pour améliorer votre Robots.txt pour le référencement.

Pour ajouter une règle, saisissez un agent utilisateur dans le champ « Agent utilisateur ». L’utilisation d’un * permet d’appliquer la règle à tous les agents utilisateurs.

Sélectionnez ensuite si vous souhaitez « Autoriser » ou « Désactiver » l’exploration par les moteurs de recherche.

Saisissez ensuite le nom du fichier ou le chemin du répertoire dans le champ « Chemin du répertoire ».

La règle sera automatiquement appliquée à votre Robots.txt. Pour ajouter une autre règle, il suffit de cliquer sur le bouton « Ajouter une règle ».

Nous vous recommandons d’ajouter des règles jusqu’à ce que vous créiez le format Robots.txt idéal dont nous avons parlé plus haut.

Vos règles personnalisées ressembleront à ceci.

Une fois que vous avez terminé, n’oubliez pas de cliquer sur le bouton « Enregistrer les modifications » pour stocker vos modifications.

Méthode 2 : Modifier le fichier Robots.txt à l’aide de WPCode

WPCode est une puissante extension d’extraits de code qui vous permet d’ajouter du code personnalisé à votre site facilement et en toute sécurité.

Il comprend également une fonctionnalité très pratique qui vous permet de modifier rapidement le fichier robots.txt.

Note : Il existe également une extension WPCode gratuite, mais elle n’inclut pas la fonctionnalité d’éditeurs/éditrices de fichiers.

La première chose à faire est d’installer l’extension WPCode. Pour obtenir des instructions étape par étape, consultez notre guide du débutant sur l’installation d’une extension WordPress.

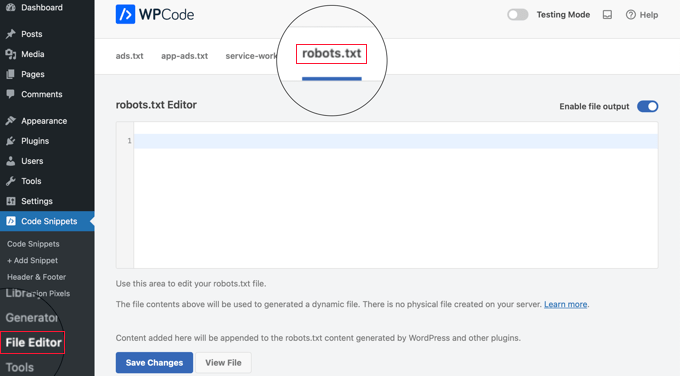

Une fois activé, vous devez vous rendre sur la page WPCode » Éditeurs/éditrices de fichiers. Une fois sur cette page, il suffit de cliquer sur l’onglet ‘robots.txt’ pour modifier le fichier.

Vous pouvez maintenant coller ou taper le contenu du fichier Robots.txt.

Une fois que vous avez terminé, n’oubliez pas de cliquer sur le bouton « Enregistrer les modifications » en bas de la page pour stocker les Réglages.

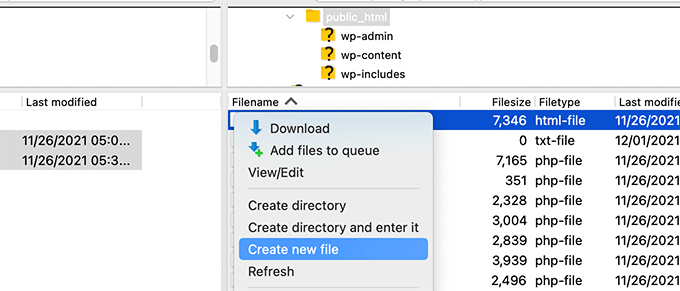

Méthode 3 : Modifier manuellement le fichier Robots.txt à l’aide du FTP

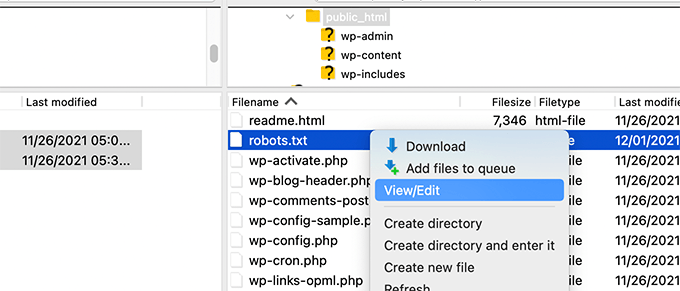

Pour cette méthode, vous devrez utiliser un client FTP pour modifier le fichier robots.txt. Vous pouvez également utiliser le gestionnaire de fichiers fourni par votre hébergeur WordPress.

Il suffit de se connecter aux fichiers de votre site WordPress à l’aide d’un client FTP.

Une fois à l’intérieur, vous pourrez voir le fichier Robots.txt dans le dossier racine de votre site.

Si vous n’en voyez pas, il est probable que vous n’ayez pas de fichier Robots.txt.

Dans ce cas, vous pouvez simplement aller de l’avant et en créer un.

Robots.txt est un fichier de texte brut, ce qui signifie que vous pouvez le télécharger sur votre ordinateur et le modifier à l’aide d’un éditeur de texte brut tel que Notepad ou TextEdit.

Après avoir enregistré vos modifications, vous pouvez téléverser le fichier Robots.txt dans le dossier racine de votre site.

Comment tester votre fichier Robots.txt ?

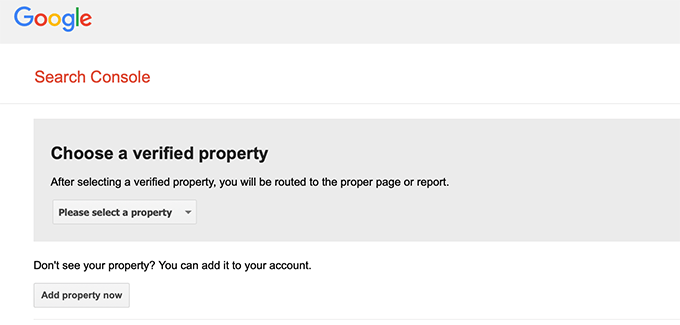

Une fois que vous avez créé votre fichier Robots.txt, il est toujours bon de le tester à l’aide d’un outil de test de robots.txt.

Il existe de nombreux outils de test de robots.txt, mais nous vous recommandons d’utiliser celui qui se trouve dans la Google Search Console.

Tout d’abord, vous devrez faire en sorte que votre site soit lié à Google Search Console. Si vous ne l’avez pas encore fait, consultez notre guide sur l ‘ajout de votre site WordPress à Google Search Console.

Ensuite, vous pouvez utiliser l’outil de test des robots de la Google Search Console.

Il vous suffit de sélectionner votre bien dans la liste déroulante.

L’outil récupère automatiquement le fichier Robots.txt de votre site et met en évidence les erreurs et les avertissements qu’il trouve.

Réflexions finales

L’objectif de l’optimisation de votre fichier robots.txt est d’empêcher les moteurs de recherche d’explorer les pages qui ne sont pas accessibles au public. Par exemple, les pages de votre dossier wp-plugins ou les pages de votre dossier d’administration WordPress.

Un mythe répandu parmi les experts en référencement est que le blocage des catégories, des identifiants et des pages d’archives de WordPress améliorera le taux d’exploration et se traduira par une indexation plus rapide et un meilleur classement.

Ce n’est pas vrai. C’est également contraire aux consignes de Google pour les webmasters.

Nous vous recommandons de suivre le format Robots.txt ci-dessus pour créer un fichier Robots.txt pour votre site.

Guides d’experts sur l’utilisation de Robots.txt dans WordPress

Maintenant que vous savez comment optimiser votre fichier robots.txt, vous pouvez consulter d’autres articles relatifs à l’utilisation de robots.txt dans WordPress.

- Glossaire : Robots.txt

- Comment cacher une page WordPress à Google

- Comment empêcher les moteurs de recherche d’explorer un site WordPress ?

- Comment supprimer définitivement un site WordPress de l’Internet

- Comment cacher facilement (Noindex) les fichiers PDF dans WordPress

- Comment corriger l’erreur « Googlebot ne peut pas accéder aux fichiers CSS et JS » dans WordPress

- Comment configurer correctement All in One SEO pour WordPress (Guide ultime)

Nous espérons que cet article vous a aidé à apprendre comment optimiser votre fichier WordPress robots.txt pour le référencement. Vous pouvez également consulter notre guide ultime de référencement WordPress et nos choix d’experts pour les meilleurs outils de référencement WordPress pour développer votre site.

Si vous avez aimé cet article, veuillez alors vous abonner à notre chaîne YouTube pour obtenir des tutoriels vidéo sur WordPress. Vous pouvez également nous trouver sur Twitter et Facebook.

Syed Balkhi says

Hey WPBeginner readers,

Did you know you can win exciting prizes by commenting on WPBeginner?

Every month, our top blog commenters will win HUGE rewards, including premium WordPress plugin licenses and cash prizes.

You can get more details about the contest from here.

Start sharing your thoughts below to stand a chance to win!

Moinuddin Waheed says

Thanks for this informative post about robots.txt file.

I didn’t know that websites should maintain this file in order to have a control over Google bots that how should they crawl over our pages and posts.

for beginner websites just starting out, is there a need to have robots.txt file or is there a way like plugin which can a make a robots.txt file for our website?

WPBeginner Support says

Most SEO plugins help with setting up the robots.txt for a new site to prevent bots from scrolling sections they shouuldn’t.

Administrateur

Jiří Vaněk says

Thanks to this article, I checked the robots.txt file and added URL addresses with sitemaps. At the same time, I had other problematic lines there, which were revealed by the validator. I wasn’t familiar with sitemaps in robots.txt until now. Thanks.

WPBeginner Support says

You’re welcome, glad our guide could help!

Administrateur

Stéphane says

Hi,

Thanks for that post, it becomes clearer how to use the robots.txt file. On most websites that you find while looking for some advice regarding the robots.txt file, you can see that the following folders are explicitly excluded from crawling (for WordPress):

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

I don’t really understand the reasons to exclude those folders (is there one actually?). What would be your take regarding that matter?

WPBeginner Support says

It is mainly to prevent anything in those folders from showing as a result when a user searches for your site. As that is not your content it is not something most people would want to appear for the site’s results.

Administrateur

zaid haris says

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

GSC show the coverage error for « Disallow: /wp-admin/ » Is this wrong?

WPBeginner Support says

For most sites, you do not want anything from your wp-admin to appear as a search result so it is fine and expected to receive the coverage area when you deny Google the ability to scan your wp-admin.

Administrateur

Hansini says

I am creating my robots.txt manually as you instructed for my WordPress site.

I have one doubt. when I write User-Agent: * won’t it allow another spamming robot to access my site?

Should I write User-Agent: * or User-Agent: Googlebot.?

WPBeginner Support says

The User-Agent line is setting the rules that all robots should follow on your site, if you specify a specific bot on that line it would be setting rules for that specific bot and none of the others.

Administrateur

Nishant says

What should we write to make google index my post?

WPBeginner Support says

For having your site listed, you would want to take a look at our article below:

https://www.wpbeginner.com/beginners-guide/how-do-i-get-my-wordpress-site-listed-on-google-beginners-guide/

Administrateur

Sanjeev Pandey says

should we also disallow /wp-content/themes/ ?

It is appearing in the search result when I run the command site:abcdef.com in google search

WPBeginner Support says

You would not want to worry about blocking your themes folder and as you write SEO-friendly content you should no longer see the themes as a search result.

Administrateur

Salem says

HI, What’s means » Disallow: /readme.html & Disallow: /refer/ » ?

WPBeginner Support says

That means you’re telling search engines to not look at any referral links or the readme.html file.

Administrateur

sean says

Hi, what are the pros and cons of blocking wp-content/uploads

Thank you

WPBeginner Support says

If you block your uploads folder then search engines would not normally crawl your uploaded content like images.

Administrateur

Piyush says

thanks for solve my problem

WPBeginner Support says

You’re welcome

Administrateur

Ravi kumar says

Sir i m very confused about robot.txt many time i submitted site map in blogger but the after 3,4 days coming the same issue what is the exactly robot.txt.. & how submit that please guide me

WPBeginner Support says

It would depend on your specific issue, you may want to take a look at our page below:

https://www.wpbeginner.com/glossary/robots-txt/

Administrateur

Prem says

If I no index a url or page using robots.txt file, does google shows any error in search console?

WPBeginner Support says

No, Google will not list the page but if the page is listed it will not show an error.

Administrateur

Bharat says

Hi

I have a question

i receive google search console coverage issue warning for blocked by robots.txt

/wp-admin/widgets.php

My question is, can i allow for wp-admin/widgets.php to robots.txt and this is safe?

WPBeginner Support says

IF you wanted to you can but that is not a file that Google needs to crawl.

Administrateur

Anthony says

Hi there, I’m wondering if you should allow: /wp-admin/admin-ajax.php?

WPBeginner Support says

Normally, yes you should.

Administrateur

Jaira says

May I know why you should allow /wp-admin/admin-ajax.php?

WPBeginner Support says

It is used by different themes and plugins to appear correctly for search engines.

Amila says

Hello! I really like this article and as I’m a beginner with all this crawling stuff I would like to ask something in this regard. Recently, Google has crawled and indexed one of my websites on a really terrible way, showing the pages in search results which are deleted from the website. The website didn’t have discouraged search engine from indexing in the settings of WordPress at the beginning, but it did later after Google showed even 3 more pages in the search results (those pages also doesn’t exist) and I really don’t understand how it could happen with « discourage search engine from indexing » option on. So, can the Yoast method be helpful and make a solution for my website to Google index my website on the appropriate way this time? Thanks in advance!

WPBeginner Support says

The Yoast plugin should be able to assist in ensuring the pages you have are indexed properly, there is a chance before you discouraged search engines from crawling your site your page was cached.

Administrateur

Amila says

Well yes and from all pages, it cached the once who doesn’t exist anymore. Anyway, as the current page is on « discourage » setting on, is it better to keep it like that for now or to uncheck the box and leave the Google to crawl and index it again with Yoast help? Thanks! With your articles, everything became easier!

WPBeginner Support says

You would want to have Google recrawl your site once it is set up how you want.

Pradhuman Kumar says

Hi I loved the article, very precise and perfect.

Just a small suggestion kindly update the image ROBOTS.txt tester, as Google Console is changed and it would be awesome if you add the link to check the robots.txt from Google.

WPBeginner Support says

Thank you for the feedback, we’ll be sure to look into updating the article as soon as we are able.

Administrateur

Kamaljeet Singh says

My blog’s robots.txt file was:

User-Agent: *

crawl-delay: 10

After reading this post, I have changed it into your recommended robots.txt file. Is that okay that I removed crawl-delay

WPBeginner Support says

It should be fine, crawl-delay tells search engines to slow down how quickly to crawl your site.

Administrateur

reena says

Very nicely described about robot.text, i am very happy

u r very good writer

WPBeginner Support says

Thank you, glad you liked our article

Administrateur

JJ says

What is Disallow: /refer/ page ? I get a 404, is this a hidden wp file?

Editorial Staff says

We use /refer/ to redirect to various affiliate links on our website. We don’t want those to be indexed since they’re just redirects and not actual content.

Administrateur

Sagar Arakh says

Thank you for sharing. This was really helpful for me to understand robots.txt

I have updated my robots.txt to the ideal one you suggested. i will wait for the results now

WPBeginner Support says

You’re welcome, glad you’re willing to use our recommendations

Administrateur

Akash Gogoi says

Very helpful article. Thank you very much.

WPBeginner Support says

Glad our article was helpful

Administrateur

Zingylancer says

Thanks for share this useful information about us.

WPBeginner Support says

Glad we could share this information about the robots.txt file

Administrateur

Jasper says

thanks for update information for me. Your article was good for Robot txt. file. It gave me a piece of new information. thanks and keep me updating with new ideas.

WPBeginner Support says

Glad our guide was helpful

Administrateur

Imran says

Thanks , I added robots.txt in WordPress .Very good article

WPBeginner Support says

Thank you, glad our article was helpful

Administrateur