Qui a WPBeginner abbiamo guidato milioni di utenti su come ottimizzare i loro siti web per la ricerca e aumentare il loro traffico organico. Abbiamo scoperto che un aspetto della SEO che i principianti spesso trascurano è il file robots.txt, che aiuta i motori di ricerca a scoprire, scansionare e indicizzare il vostro sito web.

Questo semplice file di testo agisce come un insieme di istruzioni, guidando i bot dei motori di ricerca su quali parti del vostro sito accedere e quali lasciare in pace.

Ottimizzando il file robots.txt, potete fare in modo che i motori di ricerca si concentrino sul crawling e sull’indicizzazione dei contenuti più importanti, evitando che sprechino risorse in aree meno importanti del vostro sito web.

Questo articolo vi mostrerà alcuni suggerimenti su come creare un file robots.txt perfettamente ottimizzato per il vostro sito WordPress, massimizzando il vostro potenziale SEO.

Che cos’è un file Robots.txt?

Robots.txt è un file di testo che i proprietari di siti web possono creare per indicare ai bot dei motori di ricerca come scansionare e indicizzare le pagine dei loro siti.

In genere viene memorizzato nella directory principale (nota anche come cartella principale) del sito web. Il formato di base di un file robots.txt è il seguente:

User-agent: [user-agent name]

Disallow: [URL string not to be crawled]

User-agent: [user-agent name]

Allow: [URL string to be crawled]

Sitemap: [URL of your XML Sitemap]

È possibile avere più righe di istruzioni per consentire o non consentire URL specifici e aggiungere più sitemap. Se non si disconosce un URL, i bot dei motori di ricerca presumono di poterlo scansionare.

Ecco come può apparire un file robots.txt di esempio:

User-Agent: *

Allow: /wp-content/uploads/

Disallow: /wp-content/plugins/

Disallow: /wp-admin/

Sitemap: https://example.com/sitemap_index.xml

Nell’esempio di robots.txt di cui sopra, abbiamo permesso ai motori di ricerca di scansionare e indicizzare i file nella cartella uploads di WordPress.

In seguito, abbiamo impedito ai bot di ricerca di effettuare il crawling e l’indicizzazione dei plugin e delle cartelle di amministrazione di WordPress.

Infine, abbiamo fornito l’URL della nostra sitemap XML.

Avete bisogno di un file Robots.txt per il vostro sito WordPress?

Se non si dispone di un file robots.txt, i motori di ricerca effettueranno comunque la scansione e l’indicizzazione del sito web. Tuttavia, non sarete in grado di dire loro quali pagine o cartelle non devono essere scansionate.

Questo non avrà molto impatto quando si apre un blog per la prima volta e non si hanno molti contenuti.

Tuttavia, quando il vostro sito web cresce e aggiungete più contenuti, è probabile che vogliate avere un controllo migliore sul modo in cui il vostro sito web viene carrellato e indicizzato.

Ecco perché.

I bot di ricerca hanno una quota di crawl per ogni sito web.

Ciò significa che il sistema esegue il crawling di un certo numero di pagine durante una sessione di crawling. Se esauriscono il budget di crawling prima di aver terminato la scansione di tutte le pagine del vostro sito, torneranno e riprenderanno la scansione nella sessione successiva.

Questo può rallentare il tasso di indicizzazione del vostro sito web.

È possibile risolvere questo problema impedendo ai bot di ricerca di tentare la scansione di pagine non necessarie, come le pagine di amministrazione di WordPress, i file dei plugin e la cartella dei temi.

Disabilitando le pagine non necessarie, si risparmia la quota di crawl. Questo aiuta i motori di ricerca a scansionare un numero ancora maggiore di pagine del vostro sito e a indicizzarle il più rapidamente possibile.

Un altro buon motivo per utilizzare un file robots.txt è quando si vuole impedire ai motori di ricerca di indicizzare un post o una pagina del proprio sito web.

Questo non è il modo più sicuro per nascondere i contenuti al pubblico, ma vi aiuterà a evitare che i contenuti appaiano nei risultati di ricerca.

Come si presenta un file Robots.txt ideale?

Molti blog popolari utilizzano un file robots.txt molto semplice. Il loro contenuto può variare a seconda delle esigenze del sito specifico:

User-agent: *

Disallow:

Sitemap: https://www.example.com/post-sitemap.xml

Sitemap: https://www.example.com/page-sitemap.xml

Questo file robots.txt consente a tutti i bot di indicizzare tutti i contenuti e fornisce loro un link alle sitemap XML del sito web.

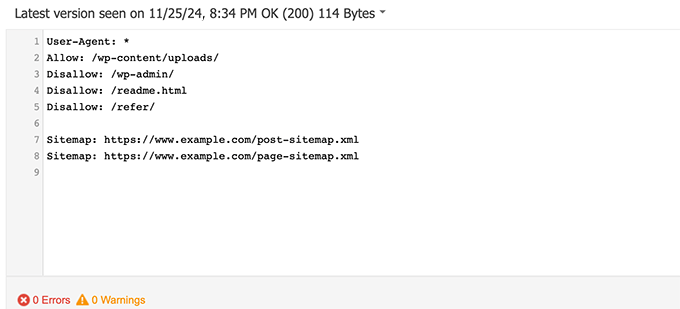

Per i siti WordPress, si consiglia di inserire le seguenti regole nel file robots.txt:

User-Agent: *

Allow: /wp-content/uploads/

Disallow: /wp-admin/

Disallow: /readme.html

Disallow: /refer/

Sitemap: https://www.example.com/post-sitemap.xml

Sitemap: https://www.example.com/page-sitemap.xml

Indica ai bot di ricerca di indicizzare tutte le immagini e i file di WordPress. Impedisce ai bot di ricerca di indicizzare l’area di amministrazione di WordPress, il file readme e i link affiliati occultati.

Aggiungendo le sitemap al file robots.txt, si facilita ai bot di Google l’individuazione di tutte le pagine del sito.

Ora che conoscete l’aspetto di un file robots.txt ideale, vediamo come creare un file robots.txt in WordPress.

Come creare un file Robots.txt in WordPress

Esistono due modi per creare un file robots.txt in WordPress. Potete scegliere il metodo che funziona meglio per voi.

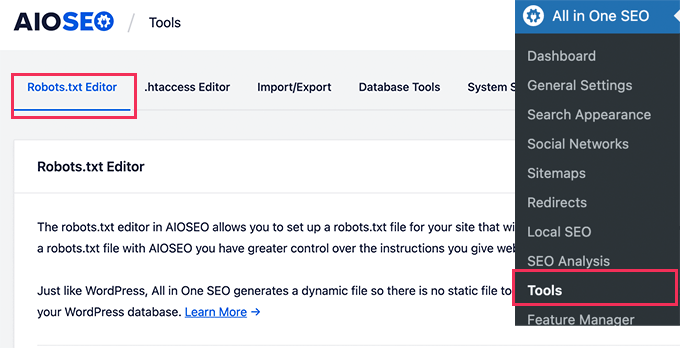

Metodo 1: Modifica del file Robots.txt con All in One SEO

All in One SEO, noto anche come AIOSEO, è il miglior plugin SEO per WordPress sul mercato, utilizzato da oltre 3 milioni di siti web. È facile da usare e viene fornito con un generatore di file robots.txt.

Per saperne di più, consultate la nostra recensione dettagliata di AIOSEO.

Se non avete ancora installato il plugin AIOSEO, potete consultare la nostra guida passo passo su come installare un plugin per WordPress.

Nota: è disponibile anche una versione gratuita di AIOSEO che dispone di questa funzione.

Una volta installato e attivato il plugin, è possibile utilizzarlo per creare e modificare il file robots.txt direttamente dall’area di amministrazione di WordPress.

Basta andare su All in One SEO ” Strumenti per modificare il file robots.txt.

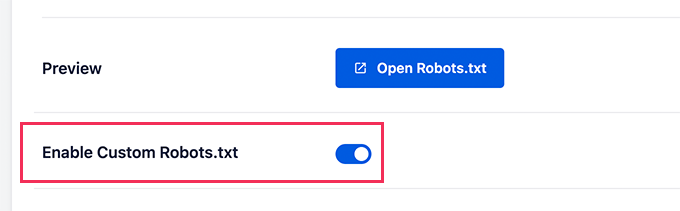

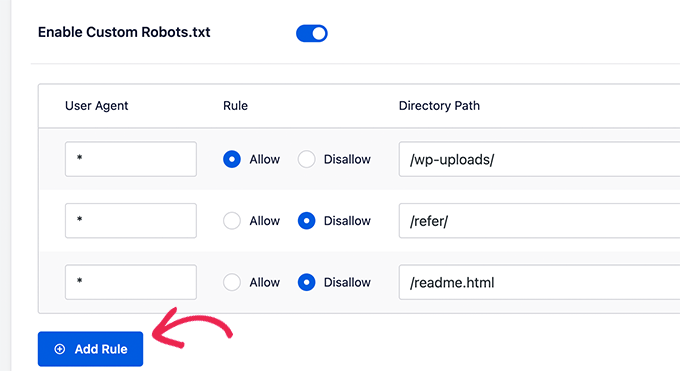

Per prima cosa, è necessario attivare l’opzione di modifica facendo clic sulla levetta blu “Enable Custom Robots.txt”.

Con questa opzione attivata, è possibile creare un file robots.txt personalizzato in WordPress.

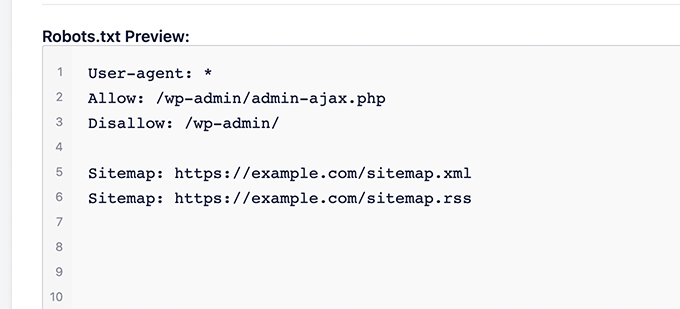

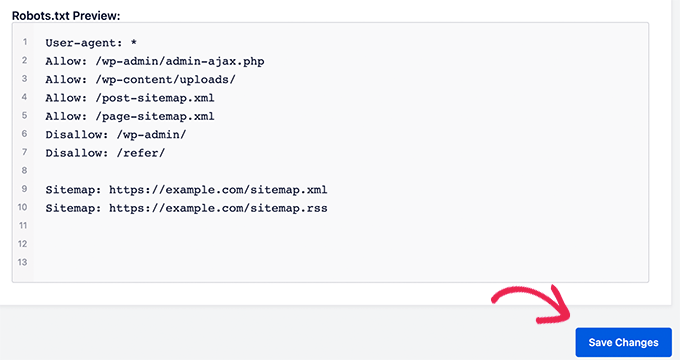

All in One SEO mostrerà il file robots.txt esistente nella sezione “Anteprima robots.txt” nella parte inferiore dello schermo.

Questa versione mostra le regole predefinite aggiunte da WordPress.

Queste regole predefinite indicano ai motori di ricerca di non effettuare il crawling dei file principali di WordPress, consentono ai bot di indicizzare tutti i contenuti e forniscono loro un link alle sitemap XML del sito.

Ora è possibile aggiungere regole personalizzate per migliorare il robots.txt per la SEO.

Per aggiungere una regola, inserire un agente utente nel campo “Agente utente”. Utilizzando un *, la regola verrà applicata a tutti gli agenti utente.

Quindi, selezionare se si desidera “Consentire” o “Disconsentire” il crawling dei motori di ricerca.

Quindi, inserire il nome del file o il percorso della directory nel campo “Percorso directory”.

La regola verrà automaticamente applicata al file robots.txt. Per aggiungere un’altra regola, basta fare clic sul pulsante “Aggiungi regola”.

Si consiglia di aggiungere regole fino a creare il formato robots.txt ideale che abbiamo condiviso sopra.

Le regole personalizzate avranno il seguente aspetto.

Una volta terminato, non dimenticate di fare clic sul pulsante “Salva modifiche” per memorizzare le modifiche.

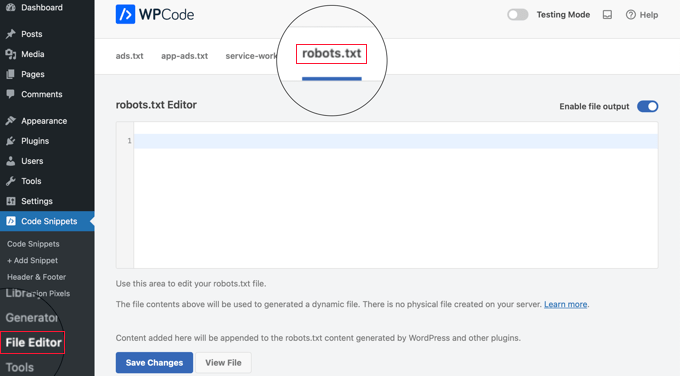

Metodo 2: Modifica del file Robots.txt con WPCode

WPCode è un potente plugin per gli snippet di codice che consente di aggiungere codice personalizzato al proprio sito web in modo semplice e sicuro.

Include anche una comoda funzione che consente di modificare rapidamente il file robots.txt.

Nota: esiste anche un plugin gratuito di WPCode, ma non include la funzione di editor di file.

La prima cosa da fare è installare il plugin WPCode. Per istruzioni passo passo, consultate la nostra guida per principianti su come installare un plugin di WordPress.

All’attivazione, è necessario navigare nella pagina WPCode ” File Editor. Una volta lì, è sufficiente fare clic sulla scheda ‘robots.txt’ per modificare il file.

Ora è possibile incollare o digitare il contenuto del file robots.txt.

Una volta terminato, assicurarsi di fare clic sul pulsante “Salva modifiche” in fondo alla pagina per memorizzare le impostazioni.

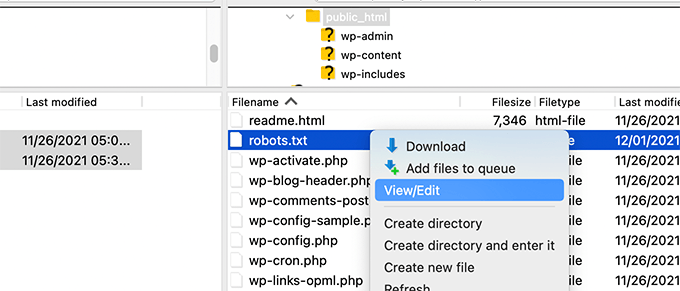

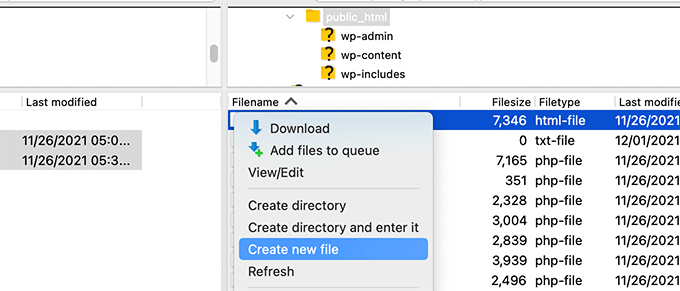

Metodo 3: Modifica manuale del file Robots.txt tramite FTP

Per questo metodo, è necessario utilizzare un client FTP per modificare il file robots.txt. In alternativa, potete utilizzare il file manager fornito dal vostro hosting WordPress.

È sufficiente collegarsi ai file del proprio sito web WordPress utilizzando un client FTP.

Una volta entrati, sarà possibile vedere il file robots.txt nella cartella principale del sito web.

Se non ne vedete uno, è probabile che non abbiate un file robots.txt.

In questo caso, si può procedere a crearne uno.

Robots.txt è un file di testo semplice, il che significa che è possibile scaricarlo sul computer e modificarlo con qualsiasi editor di testo semplice, come Notepad o TextEdit.

Dopo aver salvato le modifiche, è possibile caricare il file robots.txt nella cartella principale del sito web.

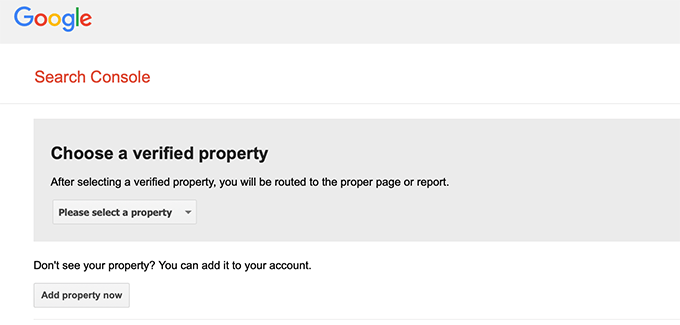

Come testare il file Robots.txt

Una volta creato il file robots.txt, è sempre una buona idea testarlo utilizzando uno strumento robots.txt tester.

Esistono molti strumenti di verifica del robots.txt, ma noi consigliamo di utilizzare quello presente all’interno di Google Search Console.

Per prima cosa, è necessario che il vostro sito sia collegato a Google Search Console. Se non l’avete ancora fatto, consultate la nostra guida su come aggiungere il vostro sito WordPress a Google Search Console.

Quindi, è possibile utilizzare lo strumento di test dei robot di Google Search Console.

È sufficiente selezionare la proprietà dall’elenco a discesa.

Lo strumento recupera automaticamente il file robots.txt del vostro sito web ed evidenzia gli errori e gli avvertimenti se ne trova qualcuno.

Pensieri finali

L’obiettivo dell’ottimizzazione del file robots.txt è quello di impedire ai motori di ricerca di scansionare le pagine che non sono disponibili pubblicamente. Ad esempio, le pagine della cartella wp-plugins o quelle della cartella di amministrazione di WordPress.

Un mito comune tra gli esperti SEO è che il blocco delle categorie, dei tag e delle pagine di archivio di WordPress migliori la velocità di crawl e porti a un’indicizzazione più rapida e a classifiche più alte.

Questo non è vero. È anche contrario alle linee guida per i webmaster di Google.

Si consiglia di seguire il formato robots.txt di cui sopra per creare un file robots.txt per il proprio sito web.

Guide di esperti sull’uso di Robots.txt in WordPress

Ora che sapete come ottimizzare il vostro file robots.txt, potreste voler vedere altri articoli relativi all’uso di robots.txt in WordPress.

- Glossario: Robots.txt

- Come nascondere una pagina di WordPress da Google

- Come impedire ai motori di ricerca di effettuare il crawling di un sito WordPress

- Come eliminare definitivamente un sito WordPress da internet

- Come nascondere facilmente (noindex) i file PDF in WordPress

- Come correggere l’errore “Googlebot non può accedere ai file CSS e JS” in WordPress

- Come configurare correttamente Tutto-in-uno SEO per WordPress (Guida definitiva)

Speriamo che questo articolo vi abbia aiutato a capire come ottimizzare il file robots.txt di WordPress per la SEO. Potreste anche voler consultare la nostra guida definitiva alla SEO di WordPress e le nostre scelte di esperti sui migliori strumenti SEO per WordPress per far crescere il vostro sito web.

Se questo articolo vi è piaciuto, iscrivetevi al nostro canale YouTube per le esercitazioni video su WordPress. Potete trovarci anche su Twitter e Facebook.

Moinuddin Waheed

Thanks for this informative post about robots.txt file.

I didn’t know that websites should maintain this file in order to have a control over Google bots that how should they crawl over our pages and posts.

for beginner websites just starting out, is there a need to have robots.txt file or is there a way like plugin which can a make a robots.txt file for our website?

WPBeginner Support

Most SEO plugins help with setting up the robots.txt for a new site to prevent bots from scrolling sections they shouuldn’t.

Admin

Jiří Vaněk

Thanks to this article, I checked the robots.txt file and added URL addresses with sitemaps. At the same time, I had other problematic lines there, which were revealed by the validator. I wasn’t familiar with sitemaps in robots.txt until now. Thanks.

WPBeginner Support

You’re welcome, glad our guide could help!

Admin

Stéphane

Hi,

Thanks for that post, it becomes clearer how to use the robots.txt file. On most websites that you find while looking for some advice regarding the robots.txt file, you can see that the following folders are explicitly excluded from crawling (for WordPress):

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

I don’t really understand the reasons to exclude those folders (is there one actually?). What would be your take regarding that matter?

WPBeginner Support

It is mainly to prevent anything in those folders from showing as a result when a user searches for your site. As that is not your content it is not something most people would want to appear for the site’s results.

Admin

zaid haris

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

GSC show the coverage error for “Disallow: /wp-admin/” Is this wrong?

WPBeginner Support

For most sites, you do not want anything from your wp-admin to appear as a search result so it is fine and expected to receive the coverage area when you deny Google the ability to scan your wp-admin.

Admin

Hansini

I am creating my robots.txt manually as you instructed for my WordPress site.

I have one doubt. when I write User-Agent: * won’t it allow another spamming robot to access my site?

Should I write User-Agent: * or User-Agent: Googlebot.?

WPBeginner Support

The User-Agent line is setting the rules that all robots should follow on your site, if you specify a specific bot on that line it would be setting rules for that specific bot and none of the others.

Admin

Nishant

What should we write to make google index my post?

WPBeginner Support

For having your site listed, you would want to take a look at our article below:

https://www.wpbeginner.com/beginners-guide/how-do-i-get-my-wordpress-site-listed-on-google-beginners-guide/

Admin

Sanjeev Pandey

should we also disallow /wp-content/themes/ ?

It is appearing in the search result when I run the command site:abcdef.com in google search

WPBeginner Support

You would not want to worry about blocking your themes folder and as you write SEO-friendly content you should no longer see the themes as a search result.

Admin

Salem

HI, What’s means ” Disallow: /readme.html & Disallow: /refer/ ” ?

WPBeginner Support

That means you’re telling search engines to not look at any referral links or the readme.html file.

Admin

sean

Hi, what are the pros and cons of blocking wp-content/uploads

Thank you

WPBeginner Support

If you block your uploads folder then search engines would not normally crawl your uploaded content like images.

Admin

Piyush

thanks for solve my problem

WPBeginner Support

You’re welcome

Admin

Ravi kumar

Sir i m very confused about robot.txt many time i submitted site map in blogger but the after 3,4 days coming the same issue what is the exactly robot.txt.. & how submit that please guide me

WPBeginner Support

It would depend on your specific issue, you may want to take a look at our page below:

https://www.wpbeginner.com/glossary/robots-txt/

Admin

Prem

If I no index a url or page using robots.txt file, does google shows any error in search console?

WPBeginner Support

No, Google will not list the page but if the page is listed it will not show an error.

Admin

Bharat

Hi

I have a question

i receive google search console coverage issue warning for blocked by robots.txt

/wp-admin/widgets.php

My question is, can i allow for wp-admin/widgets.php to robots.txt and this is safe?

WPBeginner Support

IF you wanted to you can but that is not a file that Google needs to crawl.

Admin

Anthony

Hi there, I’m wondering if you should allow: /wp-admin/admin-ajax.php?

WPBeginner Support

Normally, yes you should.

Admin

Jaira

May I know why you should allow /wp-admin/admin-ajax.php?

WPBeginner Support

It is used by different themes and plugins to appear correctly for search engines.

Amila

Hello! I really like this article and as I’m a beginner with all this crawling stuff I would like to ask something in this regard. Recently, Google has crawled and indexed one of my websites on a really terrible way, showing the pages in search results which are deleted from the website. The website didn’t have discouraged search engine from indexing in the settings of WordPress at the beginning, but it did later after Google showed even 3 more pages in the search results (those pages also doesn’t exist) and I really don’t understand how it could happen with “discourage search engine from indexing” option on. So, can the Yoast method be helpful and make a solution for my website to Google index my website on the appropriate way this time? Thanks in advance!

WPBeginner Support

The Yoast plugin should be able to assist in ensuring the pages you have are indexed properly, there is a chance before you discouraged search engines from crawling your site your page was cached.

Admin

Amila

Well yes and from all pages, it cached the once who doesn’t exist anymore. Anyway, as the current page is on “discourage” setting on, is it better to keep it like that for now or to uncheck the box and leave the Google to crawl and index it again with Yoast help? Thanks! With your articles, everything became easier!

WPBeginner Support

You would want to have Google recrawl your site once it is set up how you want.

Pradhuman Kumar

Hi I loved the article, very precise and perfect.

Just a small suggestion kindly update the image ROBOTS.txt tester, as Google Console is changed and it would be awesome if you add the link to check the robots.txt from Google.

WPBeginner Support

Thank you for the feedback, we’ll be sure to look into updating the article as soon as we are able.

Admin

Kamaljeet Singh

My blog’s robots.txt file was:

User-Agent: *

crawl-delay: 10

After reading this post, I have changed it into your recommended robots.txt file. Is that okay that I removed crawl-delay

WPBeginner Support

It should be fine, crawl-delay tells search engines to slow down how quickly to crawl your site.

Admin

reena

Very nicely described about robot.text, i am very happy

u r very good writer

WPBeginner Support

Thank you, glad you liked our article

Admin

JJ

What is Disallow: /refer/ page ? I get a 404, is this a hidden wp file?

Editorial Staff

We use /refer/ to redirect to various affiliate links on our website. We don’t want those to be indexed since they’re just redirects and not actual content.

Admin

Sagar Arakh

Thank you for sharing. This was really helpful for me to understand robots.txt

I have updated my robots.txt to the ideal one you suggested. i will wait for the results now

WPBeginner Support

You’re welcome, glad you’re willing to use our recommendations

Admin

Akash Gogoi

Very helpful article. Thank you very much.

WPBeginner Support

Glad our article was helpful

Admin

Zingylancer

Thanks for share this useful information about us.

WPBeginner Support

Glad we could share this information about the robots.txt file

Admin

Jasper

thanks for update information for me. Your article was good for Robot txt. file. It gave me a piece of new information. thanks and keep me updating with new ideas.

WPBeginner Support

Glad our guide was helpful

Admin

Imran

Thanks , I added robots.txt in WordPress .Very good article

WPBeginner Support

Thank you, glad our article was helpful

Admin