Es ist ein beunruhigendes Gefühl, wenn man feststellt, dass eine winzige, übersehene Textdatei die SEO Ihrer Website heimlich sabotiert. Viele Website-Besitzer erkennen nicht, dass ein einfacher Fehler in ihrer robots.txt-Datei verhindern kann, dass Google ihre wichtigsten Inhalte findet.

Nach der Überprüfung Tausender von WordPress-Websites haben wir dies öfter erlebt, als wir zählen können. Die gute Nachricht ist, dass die Behebung einfacher ist, als Sie denken.

In diesem Leitfaden führen wir Sie durch die genauen, praxiserprobten Schritte, die wir zur Optimierung einer WordPress robots.txt-Datei verwenden. Sie erfahren, wie Sie sie richtig einrichten und sicherstellen, dass Suchmaschinen Ihre Website effizient durchsuchen.

Fühlen Sie sich überfordert? Hier ist eine kurze Übersicht über alles, was wir in diesem Leitfaden behandeln werden. Springen Sie gerne zu dem Abschnitt, der Sie am meisten interessiert.

- Was ist eine robots.txt-Datei?

- Benötigen Sie eine Robots.txt-Datei für Ihre WordPress-Site?

- Wie sieht eine ideale robots.txt-Datei aus?

- So erstellen Sie eine Robots.txt-Datei in WordPress

- So testen Sie Ihre Robots.txt-Datei

- Abschließende Gedanken

- Häufig gestellte Fragen zu WordPress robots.txt

- Zusätzliche Ressourcen zur Verwendung von robots.txt in WordPress

Was ist eine robots.txt-Datei?

Robots.txt ist eine Textdatei, die Websitebesitzer erstellen können, um Suchmaschinen-Bots mitzuteilen, wie sie Seiten auf ihren Websites durchsuchen und indexieren sollen.

Sie ist normalerweise im Stammverzeichnis (auch Hauptordner genannt) Ihrer Website gespeichert. Das Grundformat einer robots.txt-Datei sieht wie folgt aus:

User-agent: [user-agent name]

Disallow: [URL string not to be crawled]

User-agent: [user-agent name]

Allow: [URL string to be crawled]

Sitemap: [URL of your XML Sitemap]

Sie können mehrere Zeilen mit Anweisungen haben, um bestimmte URLs zuzulassen oder zu verbieten und mehrere Sitemaps hinzuzufügen. Wenn Sie eine URL nicht verbieten, gehen Suchmaschinen-Bots davon aus, dass sie gecrawlt werden dürfen.

Hier ist ein Beispiel für eine robots.txt-Datei:

User-Agent: *

Allow: /wp-content/uploads/

Disallow: /wp-content/plugins/

Disallow: /wp-admin/

Sitemap: https://example.com/sitemap_index.xml

Im obigen robots.txt-Beispiel haben wir Suchmaschinen erlaubt, Dateien in unserem WordPress-Upload-Ordner zu crawlen und zu indexieren.

Danach haben wir Suchbots daran gehindert, Plugins und WordPress-Admin-Ordner zu crawlen und zu indizieren.

Zuletzt haben wir die URL unserer XML-Sitemap bereitgestellt.

Benötigen Sie eine Robots.txt-Datei für Ihre WordPress-Site?

Obwohl Ihre Website auch ohne eine robots.txt-Datei funktionieren kann, haben wir immer wieder festgestellt, dass Websites mit optimierten robots.txt-Dateien in den Suchergebnissen besser abschneiden.

Durch unsere Arbeit mit Kunden aus verschiedenen Branchen haben wir gesehen, wie ein ordnungsgemäßes Crawl-Budget-Management über robots.txt zu einer schnelleren Indizierung wichtiger Inhalte und einer besseren Gesamt-SEO-Leistung führen kann.

Dies wird kaum Auswirkungen haben, wenn Sie gerade erst einen Blog starten und noch nicht viel Inhalt haben.

Wenn Ihre Website jedoch wächst und Sie mehr Inhalte hinzufügen, möchten Sie wahrscheinlich eine bessere Kontrolle darüber haben, wie Ihre Website durchsucht und indexiert wird.

Hier ist der Grund.

Suchmaschinen weisen jeder Website ein von Google als „Crawl-Budget“ bezeichnetes Budget zu. Dies ist die Anzahl der Seiten, die sie innerhalb eines bestimmten Zeitraums crawlen werden.

Bei unseren Tests auf Tausenden von WordPress-Websites haben wir festgestellt, dass insbesondere größere Websites von der Optimierung dieses Budgets durch strategische robots.txt-Konfiguration profitieren.

Zum Beispiel verzeichnete einer unserer Unternehmenskunden eine Verbesserung der Crawleffizienz um 40 %, nachdem er unsere empfohlenen robots.txt-Optimierungen implementiert hatte.

Sie können Suchbots daran hindern, unnötige Seiten wie Ihre WordPress-Adminseiten, Plugin-Dateien und das Themes-Verzeichnis zu durchsuchen.

Indem Sie unnötige Seiten ablehnen, sparen Sie Ihr Crawl-Budget. Dies hilft Suchmaschinen, noch mehr Seiten auf Ihrer Website zu crawlen und sie so schnell wie möglich zu indexieren.

Ein weiterer guter Grund, eine robots.txt-Datei zu verwenden, ist, wenn Sie verhindern möchten, dass Suchmaschinen einen Beitrag oder eine Seite auf Ihrer Website indexieren.

Es ist jedoch wichtig zu wissen, dass robots.txt nicht die beste Methode ist, um Inhalte zu verbergen. Eine blockierte Seite kann immer noch in den Suchergebnissen erscheinen, wenn sie von anderen Websites verlinkt wird.

Wenn Sie zuverlässig verhindern möchten, dass eine Seite bei Google erscheint, sollten Sie stattdessen ein 'noindex'-Meta-Tag verwenden. Dies weist Suchmaschinen an, die Seite überhaupt nicht in ihren Index aufzunehmen.

Wie sieht eine ideale robots.txt-Datei aus?

Viele beliebte Blogs verwenden eine sehr einfache robots.txt-Datei. Ihr Inhalt kann je nach den Bedürfnissen der spezifischen Website variieren:

User-agent: *

Disallow:

Sitemap: https://www.example.com/post-sitemap.xml

Sitemap: https://www.example.com/page-sitemap.xml

Diese robots.txt-Datei erlaubt allen Bots, alle Inhalte zu indexieren und stellt ihnen einen Link zu den XML-Sitemaps der Website zur Verfügung.

Für WordPress-Websites empfehlen wir die folgenden Regeln in der robots.txt-Datei:

User-Agent: *

Allow: /wp-content/uploads/

Disallow: /wp-admin/

Disallow: /readme.html

Disallow: /refer/

Sitemap: https://www.example.com/post-sitemap.xml

Sitemap: https://www.example.com/page-sitemap.xml

Dies weist Suchbots an, alle Ihre WordPress-Bilder und hochgeladenen Dateien zu indexieren, indem sie speziell die Allow-Direktive verwenden, ein hilfreicher Befehl, den Suchmaschinen wie Google verstehen.

Es verbietet dann Such-Bots, den WordPress-Adminbereich, die Standarddatei readme.html (die Ihre WordPress-Version preisgeben kann) und gängige Verzeichnisse für verschleierte Affiliate-Links wie /refer/ zu indexieren.

Indem Sie Sitemaps zur robots.txt-Datei hinzufügen, erleichtern Sie Google-Bots das Auffinden aller Seiten auf Ihrer Website.

Jetzt, da Sie wissen, wie eine ideale robots.txt-Datei aussieht, sehen wir uns an, wie Sie eine robots.txt-Datei in WordPress erstellen können.

So erstellen Sie eine Robots.txt-Datei in WordPress

Es gibt zwei Möglichkeiten, eine robots.txt-Datei in WordPress zu erstellen. Sie können die Methode wählen, die für Sie am besten geeignet ist.

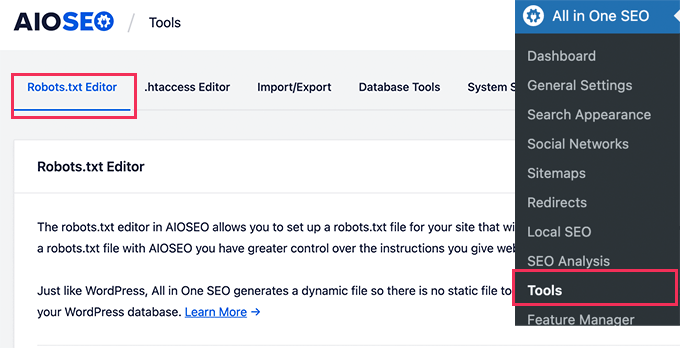

Methode 1: robots.txt-Datei mit All in One SEO bearbeiten

All in One SEO, auch bekannt als AIOSEO, ist das beste WordPress SEO-Plugin auf dem Markt und wird von über 3 Millionen Websites genutzt. Es ist einfach zu bedienen und verfügt über einen robots.txt-Dateigenerator.

Weitere Informationen finden Sie in unserem detaillierten AIOSEO-Testbericht.

Wenn Sie das AIOSEO-Plugin noch nicht installiert haben, finden Sie in unserer Schritt-für-Schritt-Anleitung, wie Sie ein WordPress-Plugin installieren.

Hinweis: Eine kostenlose Version von AIOSEO ist ebenfalls verfügbar und bietet diese Funktion.

Sobald das Plugin installiert und aktiviert ist, können Sie es verwenden, um Ihre robots.txt-Datei direkt aus Ihrem WordPress-Adminbereich zu erstellen und zu bearbeiten.

Gehen Sie einfach zu All in One SEO » Tools, um Ihre robots.txt-Datei zu bearbeiten.

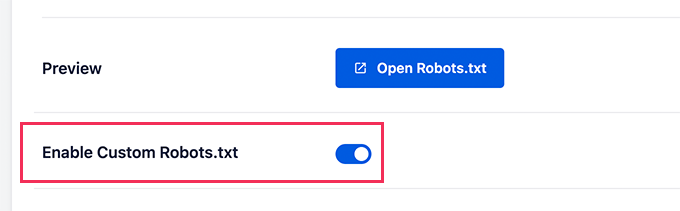

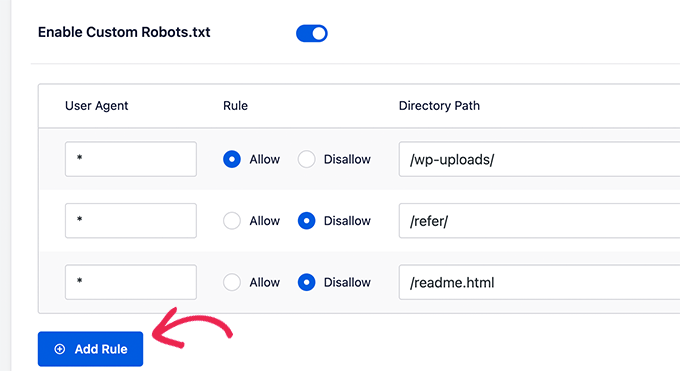

Zuerst müssen Sie die Bearbeitungsoption aktivieren, indem Sie den Schalter „Benutzerdefinierte Robots.txt aktivieren“ auf Blau stellen.

Mit diesem Schalter können Sie eine benutzerdefinierte robots.txt-Datei in WordPress erstellen.

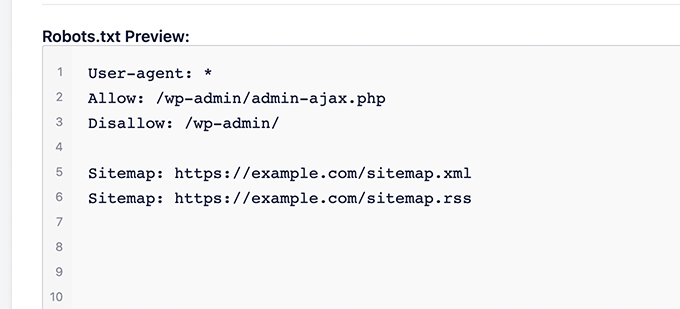

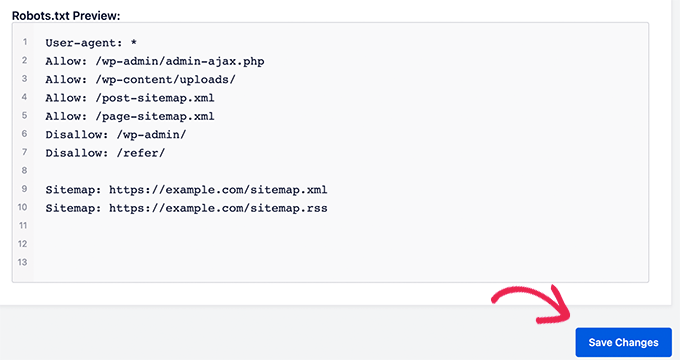

All in One SEO zeigt Ihre vorhandene robots.txt-Datei im Abschnitt „Robots.txt-Vorschau“ am unteren Bildschirmrand an.

Diese Version zeigt die Standardregeln an, die von WordPress hinzugefügt wurden.

Diese Standardregeln weisen die Suchmaschinen an, Ihre Kern-WordPress-Dateien nicht zu crawlen, die Bots zuzulassen, alle Inhalte zu indexieren, und ihnen einen Link zu den XML-Sitemaps Ihrer Website bereitzustellen.

Jetzt können Sie Ihre eigenen benutzerdefinierten Regeln hinzufügen, um Ihre robots.txt für SEO zu verbessern.

Um eine Regel hinzuzufügen, geben Sie einen User-Agenten in das Feld 'User Agent' ein. Die Verwendung eines * wendet die Regel auf alle User-Agents an.

Wählen Sie dann aus, ob Sie zulassen oder verbieten möchten, dass Suchmaschinen crawlen.

Geben Sie als Nächstes den Dateinamen oder den Verzeichnispfad in das Feld „Verzeichnispfad“ ein.

Die Regel wird automatisch auf Ihre robots.txt angewendet. Um eine weitere Regel hinzuzufügen, klicken Sie einfach auf die Schaltfläche „Regel hinzufügen“.

Wir empfehlen, Regeln hinzuzufügen, bis Sie das von uns oben geteilte ideale robots.txt-Format erstellt haben.

Ihre benutzerdefinierten Regeln werden wie folgt aussehen.

Wenn Sie fertig sind, vergessen Sie nicht, auf die Schaltfläche 'Änderungen speichern' zu klicken, um Ihre Änderungen zu speichern.

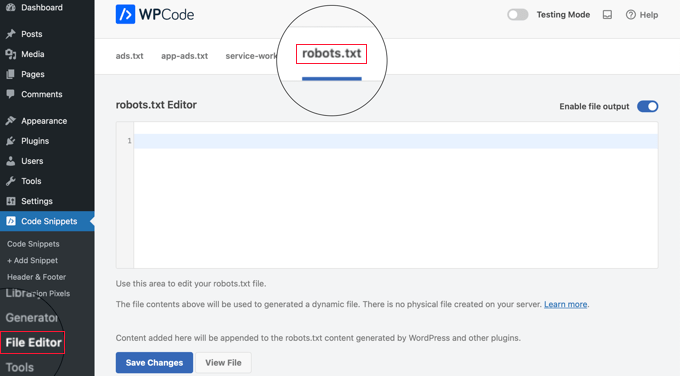

Methode 2: Bearbeiten der robots.txt-Datei mit WPCode

WPCode ist ein leistungsstarkes Code-Snippet-Plugin, mit dem Sie einfach und sicher benutzerdefinierten Code zu Ihrer Website hinzufügen können.

Es enthält auch eine praktische Funktion, mit der Sie die robots.txt-Datei schnell bearbeiten können.

Hinweis: Es gibt auch ein WPCode Free Plugin, aber es enthält nicht die Funktion des Dateieditors.

Das Erste, was Sie tun müssen, ist das WPCode-Plugin zu installieren. Eine Schritt-für-Schritt-Anleitung finden Sie in unserem Leitfaden für Anfänger unter wie man ein WordPress-Plugin installiert.

Nach der Aktivierung müssen Sie zur Seite WPCode » Dateieditor navigieren. Dort klicken Sie einfach auf den Reiter „robots.txt“, um die Datei zu bearbeiten.

Jetzt können Sie den Inhalt der robots.txt-Datei einfügen oder eingeben.

Wenn Sie fertig sind, stellen Sie sicher, dass Sie auf die Schaltfläche „Änderungen speichern“ am unteren Rand der Seite klicken, um die Einstellungen zu speichern.

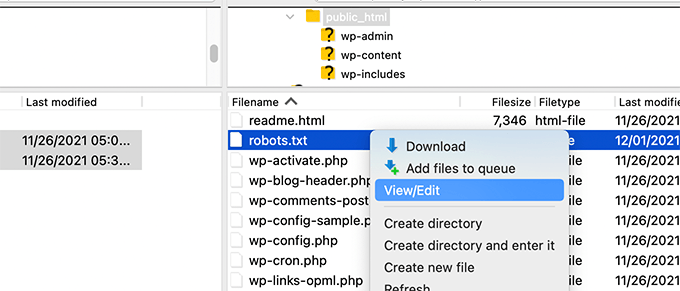

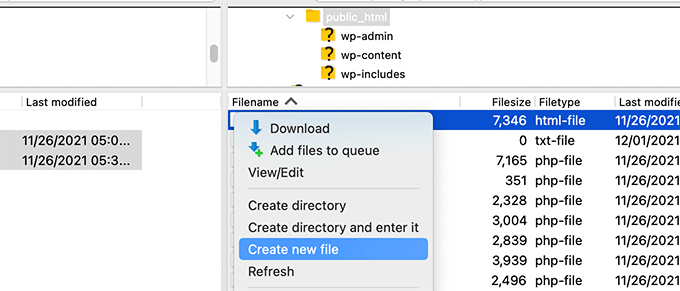

Methode 3: robots.txt-Datei manuell per FTP bearbeiten

Für diese Methode benötigen Sie einen FTP-Client, um die robots.txt-Datei zu bearbeiten. Alternativ können Sie den von Ihrem WordPress-Hosting bereitgestellten Dateimanager verwenden.

Profi-Tipp: Bevor Sie Änderungen vornehmen, empfehlen wir Ihnen, eine Sicherungskopie Ihrer ursprünglichen robots.txt-Datei (falls vorhanden) auf Ihren Computer herunterzuladen. So können Sie sie bei Problemen einfach wieder hochladen.

Verbinden Sie sich einfach mit den Dateien Ihrer WordPress-Website über einen FTP-Client.

Dort angekommen, können Sie die robots.txt-Datei in Ihrem Website-Stammordner sehen.

Wenn Sie keine sehen, haben Sie wahrscheinlich keine robots.txt-Datei.

In diesem Fall können Sie einfach fortfahren und eine erstellen.

Die robots.txt ist eine reine Textdatei, was bedeutet, dass Sie sie auf Ihren Computer herunterladen und mit einem beliebigen Texteditor wie Notepad oder TextEdit bearbeiten können.

Nach dem Speichern Ihrer Änderungen können Sie die robots.txt-Datei zurück in den Stammordner Ihrer Website hochladen.

So testen Sie Ihre Robots.txt-Datei

Nachdem Sie Ihre robots.txt-Datei erstellt oder bearbeitet haben, ist es eine gute Idee, sie auf Fehler zu überprüfen. Ein kleiner Tippfehler könnte versehentlich wichtige Seiten für Suchmaschinen blockieren, daher ist dieser Schritt sehr wichtig! 👍

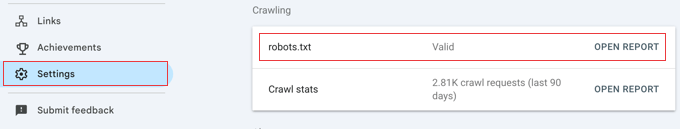

Früher hatte Google ein spezielles Testtool, aber diese Funktion wurde nun in die Hauptberichte der Google Search Console integriert.

Stellen Sie zunächst sicher, dass Ihre Website mit der Google Search Console verbunden ist. Wenn Sie das noch nicht getan haben, folgen Sie einfach unserer einfachen Anleitung, wie Sie Ihre WordPress-Website zur Google Search Console hinzufügen.

Sobald Sie eingerichtet sind, gehen Sie zu Ihrem Google Search Console-Dashboard. Navigieren Sie im Menü unten links zu Einstellungen.

Suchen Sie als Nächstes den Abschnitt 'Crawling' und klicken Sie neben 'robots.txt' auf 'Bericht öffnen'.

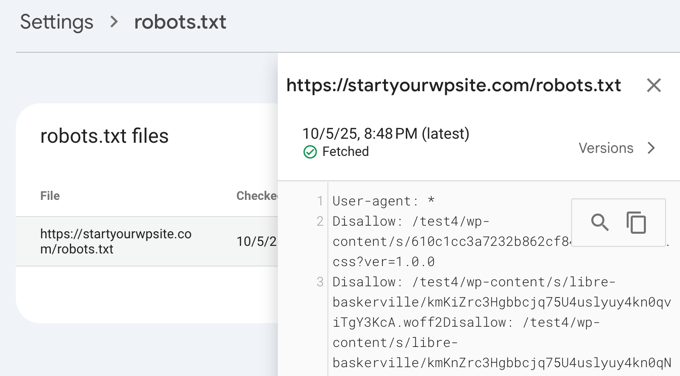

Klicken Sie einfach auf die aktuelle Version der Datei in der Liste.

Dieser Bericht zeigt Ihnen die aktuellste Version Ihrer robots.txt-Datei, die Google gefunden hat. Er hebt alle erkannten Syntaxfehler oder logischen Probleme hervor.

Machen Sie sich keine Sorgen, wenn Sie Ihre Datei gerade aktualisiert haben und die Änderungen hier nicht sofort sehen. Google prüft etwa einmal täglich automatisch auf eine neue Version Ihrer robots.txt-Datei.

Sie können diesen Bericht später erneut aufrufen, um zu bestätigen, dass Google Ihre neuesten Änderungen übernommen hat und alles in Ordnung ist.

Abschließende Gedanken

Das Ziel der Optimierung Ihrer robots.txt-Datei ist es, zu verhindern, dass Suchmaschinen Seiten crawlen, die nicht öffentlich zugänglich sind. Zum Beispiel Seiten in Ihrem wp-plugins-Ordner oder Seiten in Ihrem WordPress-Admin-Ordner.

Ein verbreiteter Mythos unter SEO-Experten ist, dass das Blockieren von WordPress-Kategorien, Tags und Archivseiten die Crawl-Rate verbessert und zu schnellerer Indexierung und höheren Rankings führt.

Das stimmt nicht. Tatsächlich wird diese Praxis von Google dringend abgeraten und verstößt gegen deren Best Practices, um ihnen beim Verständnis Ihrer Website zu helfen.

Wir empfehlen Ihnen, das obige robots.txt-Format zu befolgen, um eine robots.txt-Datei für Ihre Website zu erstellen.

Häufig gestellte Fragen zu WordPress robots.txt

Hier sind einige der häufigsten Fragen, die uns zur Optimierung der robots.txt-Datei in WordPress gestellt werden.

1. Was ist der Hauptzweck einer robots.txt-Datei?

Der Hauptzweck einer robots.txt-Datei ist die Verwaltung des Crawl-Budgets Ihrer Website. Indem Sie Suchmaschinen mitteilen, welche Seiten ignoriert werden sollen (wie Admin-Seiten oder Plugin-Dateien), helfen Sie ihnen, ihre Ressourcen effizienter für das Crawlen und Indexieren Ihrer wichtigsten Inhalte zu verwenden.

2. Wo befindet sich die robots.txt-Datei in WordPress?

Ihre robots.txt-Datei befindet sich im Stammverzeichnis Ihrer Website. Sie können sie normalerweise anzeigen, indem Sie in Ihrem Webbrowser zu IhreDomain.com/robots.txt navigieren.

3. Kann die Verwendung von robots.txt die Sicherheit meiner Website verbessern?

Nein, robots.txt ist keine Sicherheitsmaßnahme. Die Datei ist öffentlich sichtbar, sodass sie niemanden daran hindert, auf die von Ihnen aufgeführten URLs zuzugreifen. Sie gibt lediglich Anweisungen für gut funktionierende Suchmaschinen-Crawler.

4. Sollte ich WordPress-Kategorie- und Tag-Seiten in robots.txt blockieren?

Nein, Sie sollten Kategorie- und Tag-Seiten nicht blockieren. Diese Archivseiten sind für SEO nützlich, da sie Suchmaschinen helfen, die Struktur Ihrer Website zu verstehen und Ihre Inhalte zu entdecken. Das Blockieren kann sich negativ auf Ihre Suchrankings auswirken.

Zusätzliche Ressourcen zur Verwendung von robots.txt in WordPress

Jetzt, da Sie wissen, wie Sie Ihre robots.txt-Datei optimieren, möchten Sie vielleicht einige andere Artikel zum Thema robots.txt in WordPress lesen.

- Glossar: Robots.txt

- So verstecken Sie eine WordPress-Seite vor Google

- So verhindern Sie, dass Suchmaschinen eine WordPress-Website crawlen

- So löschen Sie eine WordPress-Website dauerhaft aus dem Internet

- So verstecken (Noindex) Sie PDF-Dateien in WordPress ganz einfach

- So beheben Sie den Fehler „Googlebot kann nicht auf CSS- und JS-Dateien zugreifen“ in WordPress

- Was ist llms.txt? Wie man llms.txt in WordPress hinzufügt

- So richten Sie All in One SEO für WordPress richtig ein (Ultimativer Leitfaden)

Wir hoffen, dieser Artikel hat Ihnen geholfen zu lernen, wie Sie Ihre WordPress robots.txt-Datei für SEO optimieren. Möglicherweise möchten Sie auch unseren ultimativen WordPress SEO-Leitfaden und unsere Expertenauswahl für die besten WordPress SEO-Tools ansehen, um Ihre Website zu vergrößern.

Wenn Ihnen dieser Artikel gefallen hat, abonnieren Sie bitte unseren YouTube-Kanal für WordPress-Video-Tutorials. Sie finden uns auch auf Twitter und Facebook.

Dennis Muthomi

Ich muss zugeben, ich benutze das AIOSEO-Plugin, habe aber immer die Option „Benutzerdefinierte Robots.txt aktivieren“ ignoriert, weil ich nichts durcheinanderbringen wollte.

Aber ich habe diesen Artikel gelesen und bin überzeugt, dass es sich lohnt, sich die Zeit zu nehmen, die Robots.txt-Datei meiner Website zu optimieren.

Amit Banerjee

Wenn die gesamte Vorlage für robots.txt gegeben worden wäre, wäre das hilfreich gewesen.

WPBeginner Support

We did include the entire robots.txt

Admin

Michael

Ich denke, Sie sollten Ihre Antwort ändern. Es sollte https statt http sein. Ist es richtig, auch Plugin-Dateien zu verbieten?

WPBeginner Support

Vielen Dank für den Hinweis, unser Beispiel wurde aktualisiert. Um Plugins zu sperren, sollten Sie zur Sicherheit das spezifische Plugin überprüfen.

Moinuddin Waheed

Vielen Dank für diesen informativen Beitrag über die robots.txt-Datei.

Ich wusste nicht, dass Websites diese Datei pflegen sollten, um die Kontrolle über Google-Bots zu haben, wie sie unsere Seiten und Beiträge durchsuchen sollen.

Für Anfänger-Websites, die gerade erst anfangen, ist es notwendig, eine robots.txt-Datei zu haben, oder gibt es eine Möglichkeit wie ein Plugin, das eine robots.txt-Datei für unsere Website erstellen kann?

WPBeginner Support

Die meisten SEO-Plugins helfen bei der Einrichtung der robots.txt für eine neue Website, um zu verhindern, dass Bots Bereiche durchsuchen, die sie nicht durchsuchen sollten.

Admin

Jiří Vaněk

Dank diesem Artikel habe ich die robots.txt-Datei überprüft und URL-Adressen mit Sitemaps hinzugefügt. Gleichzeitig hatte ich dort andere problematische Zeilen, die vom Validator aufgedeckt wurden. Sitemaps in robots.txt waren mir bisher nicht bekannt. Danke.

WPBeginner Support

Gern geschehen, wir freuen uns, dass unser Leitfaden helfen konnte!

Admin

Stéphane

Hallo,

Danke für diesen Beitrag, es wird klarer, wie die robots.txt-Datei verwendet wird. Auf den meisten Websites, die Sie finden, wenn Sie nach Ratschlägen zur robots.txt-Datei suchen, können Sie sehen, dass die folgenden Ordner explizit vom Crawling ausgeschlossen sind (für WordPress):

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

Ich verstehe die Gründe für den Ausschluss dieser Ordner nicht wirklich (gibt es überhaupt einen?). Was wäre Ihre Meinung dazu?

WPBeginner Support

Es dient hauptsächlich dazu, zu verhindern, dass etwas in diesen Ordnern als Ergebnis angezeigt wird, wenn ein Benutzer nach Ihrer Website sucht. Da dies nicht Ihr Inhalt ist, ist es nichts, was die meisten Leute für die Ergebnisse der Website erscheinen lassen möchten.

Admin

zaid haris

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

GSC zeigt den Abdeckungfehler für "Disallow: /wp-admin/". Ist das falsch?

WPBeginner Support

Für die meisten Websites möchten Sie nicht, dass etwas aus Ihrem wp-admin als Suchergebnis erscheint. Daher ist es in Ordnung und erwartet, die Abdeckungsfläche zu erhalten, wenn Sie Google die Fähigkeit verweigern, Ihr wp-admin zu scannen.

Admin

Hansini

Ich erstelle meine robots.txt manuell, wie Sie es für meine WordPress-Website angewiesen haben.

Ich habe einen Zweifel. Wenn ich User-Agent: * schreibe, wird dann nicht ein anderer Spam-Bot auf meine Website zugreifen können?

Sollte ich User-Agent: * oder User-Agent: Googlebot schreiben?

WPBeginner Support

Die Zeile User-Agent legt die Regeln fest, denen alle Bots auf Ihrer Website folgen sollen. Wenn Sie einen bestimmten Bot in dieser Zeile angeben, würden die Regeln nur für diesen spezifischen Bot und keinen der anderen gelten.

Admin

Nishant

Was sollen wir schreiben, damit Google meinen Beitrag indexiert?

WPBeginner Support

Damit Ihre Website gelistet wird, sollten Sie sich unseren Artikel unten ansehen:

https://www.wpbeginner.com/beginners-guide/how-do-i-get-my-wordpress-site-listed-on-google-beginners-guide/

Admin

Sanjeev Pandey

Sollten wir auch /wp-content/themes/ ablehnen?

Es erscheint in den Suchergebnissen, wenn ich den Befehl site:abcdef.com in der Google-Suche ausführe.

WPBeginner Support

Sie möchten sich keine Sorgen machen müssen, Ihren Themes-Ordner zu blockieren, und da Sie SEO-freundliche Inhalte schreiben, sollten Sie die Themes nicht mehr als Suchergebnis sehen.

Admin

Salem

Hallo, was bedeutet „Disallow: /readme.html & Disallow: /refer/ “?

WPBeginner Support

Das bedeutet, Sie weisen Suchmaschinen an, keine Verweislinks oder die readme.html-Datei zu beachten.

Admin

sean

Hallo, was sind die Vor- und Nachteile des Blockierens von wp-content/uploads

Danke

WPBeginner Support

Wenn Sie Ihren Upload-Ordner blockieren, würden Suchmaschinen Ihre hochgeladenen Inhalte wie Bilder normalerweise nicht crawlen.

Admin

Piyush

Danke, dass Sie mein Problem gelöst haben

WPBeginner Support

You’re welcome

Admin

Ravi kumar

Sir, ich bin sehr verwirrt wegen robot.txt. Viele Male habe ich die Sitemap in Blogger eingereicht, aber nach 3-4 Tagen kommt das gleiche Problem. Was ist die genaue robot.txt? & Wie reiche ich sie ein? Bitte helfen Sie mir.

WPBeginner Support

Das hängt von Ihrem spezifischen Problem ab. Möglicherweise möchten Sie einen Blick auf unsere Seite unten werfen:

https://www.wpbeginner.com/glossary/robots-txt/

Admin

Prem

Wenn ich eine URL oder Seite mit der robots.txt-Datei nicht indexiere, zeigt Google dann einen Fehler in der Search Console an?

WPBeginner Support

Nein, Google wird die Seite nicht auflisten, aber wenn die Seite aufgelistet ist, wird kein Fehler angezeigt.

Admin

Bharat

Hallo

Ich habe eine Frage

Ich erhalte eine Warnung wegen eines Problems mit der Abdeckung in der Google Search Console, das durch robots.txt blockiert wird

/wp-admin/widgets.php

Meine Frage ist, kann ich wp-admin/widgets.php für robots.txt zulassen und ist das sicher?

WPBeginner Support

Wenn Sie wollten, könnten Sie, aber das ist keine Datei, die Google crawlen muss.

Admin

Anthony

Hallo, ich frage mich, ob Sie Folgendes zulassen sollten: /wp-admin/admin-ajax.php?

WPBeginner Support

Normalerweise ja, das sollten Sie.

Admin

Jaira

Kann ich wissen, warum Sie /wp-admin/admin-ajax.php erlauben sollten?

WPBeginner Support

Sie wird von verschiedenen Themes und Plugins verwendet, um für Suchmaschinen korrekt angezeigt zu werden.

Amila

Hallo! Ich mag diesen Artikel wirklich und da ich ein Anfänger mit all diesen Crawling-Sachen bin, möchte ich dazu etwas fragen. Kürzlich hat Google eine meiner Websites auf wirklich schreckliche Weise gecrawlt und indexiert und Seiten in den Suchergebnissen angezeigt, die von der Website gelöscht wurden. Die Website hat die Suchmaschine anfangs nicht daran gehindert, in den WordPress-Einstellungen zu indexieren, aber das tat sie später, nachdem Google sogar 3 weitere Seiten in den Suchergebnissen angezeigt hatte (diese Seiten existieren auch nicht) und ich verstehe wirklich nicht, wie das mit der Option „Suchmaschinen von der Indexierung abhalten“ passieren konnte. Kann die Yoast-Methode also hilfreich sein und eine Lösung für meine Website bieten, damit Google meine Website diesmal auf die richtige Weise indexiert? Vielen Dank im Voraus!

WPBeginner Support

Das Yoast-Plugin sollte in der Lage sein, sicherzustellen, dass die von Ihnen erstellten Seiten richtig indiziert werden. Es besteht die Möglichkeit, dass Ihre Seite zwischengespeichert wurde, bevor Sie Suchmaschinen vom Crawling Ihrer Website abgehalten haben.

Admin

Amila

Nun ja, und von allen Seiten hat es die gecachten, die es nicht mehr gibt. Jedenfalls, da die aktuelle Seite auf „nicht ermutigen“ eingestellt ist, ist es besser, sie vorerst so zu belassen oder das Feld zu deaktivieren und Google es mit Yoasts Hilfe erneut crawlen und indizieren zu lassen? Danke! Mit Ihren Artikeln wurde alles einfacher!

WPBeginner Support

Sie möchten, dass Google Ihre Website neu crawlt, sobald sie wie gewünscht eingerichtet ist.

Pradhuman Kumar

Hallo, ich habe den Artikel geliebt, sehr präzise und perfekt.

Nur ein kleiner Vorschlag: Bitte aktualisieren Sie den ROBOTS.TXT-Tester, da sich die Google Console geändert hat, und es wäre großartig, wenn Sie den Link zum Überprüfen der robots.txt von Google hinzufügen würden.

WPBeginner Support

Vielen Dank für Ihr Feedback, wir werden den Artikel so bald wie möglich aktualisieren.

Admin

Kamaljeet Singh

Die robots.txt-Datei meines Blogs war:

User-Agent: *

crawl-delay: 10

Nachdem ich diesen Beitrag gelesen hatte, habe ich ihn in Ihre empfohlene robots.txt-Datei geändert. Ist es in Ordnung, dass ich crawl-delay entfernt habe

WPBeginner Support

Das sollte in Ordnung sein, crawl-delay weist Suchmaschinen an, die Geschwindigkeit zu verlangsamen, mit der sie Ihre Website crawlen.

Admin

reena

Sehr schön beschrieben über robot.text, ich bin sehr glücklich

Sie sind ein sehr guter Schreiber

WPBeginner Support

Thank you, glad you liked our article

Admin

JJ

Was ist die Seite Disallow: /refer/ ? Ich bekomme eine 404, ist das eine versteckte WP-Datei?

Redaktion

Wir verwenden /refer/, um auf verschiedene Affiliate-Links auf unserer Website weiterzuleiten. Wir möchten nicht, dass diese indexiert werden, da es sich nur um Weiterleitungen und nicht um tatsächliche Inhalte handelt.

Admin

Sagar Arakh

Vielen Dank für das Teilen. Das hat mir sehr geholfen, robots.txt zu verstehen.

Ich habe meine robots.txt auf die von Ihnen vorgeschlagene ideale Version aktualisiert. Ich werde nun auf die Ergebnisse warten.

WPBeginner Support

You’re welcome, glad you’re willing to use our recommendations

Admin

Akash Gogoi

Sehr hilfreicher Artikel. Vielen Dank.

WPBeginner Support

Glad our article was helpful

Admin

Zingylancer

Danke für das Teilen dieser nützlichen Informationen über uns.

WPBeginner Support

Glad we could share this information about the robots.txt file

Admin

Jasper

Danke für die Update-Informationen für mich. Ihr Artikel war gut für die Robot txt-Datei. Er gab mir neue Informationen. Danke und halten Sie mich mit neuen Ideen auf dem Laufenden.

WPBeginner Support

Glad our guide was helpful

Admin

Imran

Danke, ich habe robots.txt in WordPress hinzugefügt. Sehr guter Artikel

WPBeginner Support

Thank you, glad our article was helpful

Admin