É uma sensação de afundamento quando você percebe que um arquivo de texto minúsculo e esquecido pode estar sabotando silenciosamente o SEO do seu site. Muitos proprietários de sites não percebem que um erro simples em seu arquivo robots.txt pode impedir que o Google encontre seu conteúdo mais importante.

Após auditar milhares de sites WordPress, vimos isso acontecer mais vezes do que podemos contar. A boa notícia é que corrigi-lo é mais fácil do que você pensa.

Neste guia, vamos guiá-lo através dos passos exatos e testados em batalha que usamos para otimizar um arquivo robots.txt do WordPress. Você aprenderá como acertar e garantir que os motores de busca rastreiem seu site de forma eficiente.

Sentindo-se sobrecarregado? Aqui está uma visão geral rápida de tudo o que abordaremos neste guia. Sinta-se à vontade para pular para a seção que mais lhe interessa.

- O que é um arquivo robots.txt?

- Você Precisa de um Arquivo Robots.txt para o Seu Site WordPress?

- Como é um Arquivo Robots.txt Ideal?

- Como Criar um Arquivo Robots.txt no WordPress

- Como Testar Seu Arquivo Robots.txt

- Considerações Finais

- Perguntas Frequentes sobre robots.txt do WordPress

- Recursos Adicionais sobre o uso de robots.txt no WordPress

O que é um arquivo robots.txt?

Robots.txt é um arquivo de texto que os proprietários de sites podem criar para dizer aos bots de mecanismos de busca como rastrear e indexar páginas em seus sites.

Ele é normalmente armazenado no diretório raiz (também conhecido como pasta principal) do seu site. O formato básico para um arquivo robots.txt se parece com isto:

User-agent: [user-agent name]

Disallow: [URL string not to be crawled]

User-agent: [user-agent name]

Allow: [URL string to be crawled]

Sitemap: [URL of your XML Sitemap]

Você pode ter várias linhas de instruções para permitir ou negar URLs específicas e adicionar vários sitemaps. Se você não negar uma URL, os bots de mecanismos de busca assumirão que eles têm permissão para rastreá-la.

Aqui está como um arquivo robots.txt de exemplo pode parecer:

User-Agent: *

Allow: /wp-content/uploads/

Disallow: /wp-content/plugins/

Disallow: /wp-admin/

Sitemap: https://example.com/sitemap_index.xml

No exemplo de robots.txt acima, permitimos que os mecanismos de busca rastreiem e indexem arquivos em nossa pasta de uploads do WordPress.

Depois disso, negamos aos bots de busca o rastreamento e a indexação de plugins e pastas de administração do WordPress.

Por último, fornecemos o URL do nosso sitemap XML.

Você Precisa de um Arquivo Robots.txt para o Seu Site WordPress?

Embora seu site possa funcionar sem um arquivo robots.txt, descobrimos consistentemente que sites com arquivos robots.txt otimizados têm melhor desempenho nos resultados de pesquisa.

Através do nosso trabalho com clientes de diversas indústrias, vimos como o gerenciamento adequado do orçamento de rastreamento por meio do robots.txt pode levar à indexação mais rápida de conteúdo importante e a um melhor desempenho geral de SEO.

Isso não terá muito impacto quando você começar um blog e ainda não tiver muito conteúdo.

No entanto, à medida que seu site cresce e você adiciona mais conteúdo, provavelmente desejará um melhor controle sobre como seu site é rastreado e indexado.

Eis o porquê.

Os motores de busca alocam o que o Google chama de 'orçamento de rastreamento' para cada site. Este é o número de páginas que eles rastrearão dentro de um determinado período.

Em nossos testes em milhares de sites WordPress, descobrimos que sites maiores se beneficiam particularmente da otimização desse orçamento por meio de uma configuração estratégica do robots.txt.

Por exemplo, um de nossos clientes corporativos viu uma melhoria de 40% na eficiência de rastreamento após implementar as otimizações recomendadas de robots.txt.

Você pode proibir os bots de busca de tentar rastrear páginas desnecessárias, como suas páginas de administração do WordPress, arquivos de plugins e a pasta de temas.

Ao proibir páginas desnecessárias, você economiza sua cota de rastreamento. Isso ajuda os motores de busca a rastrear ainda mais páginas em seu site e indexá-las o mais rápido possível.

Outro bom motivo para usar um arquivo robots.txt é quando você deseja impedir que os motores de busca indexem uma postagem ou página em seu site.

No entanto, é importante saber que robots.txt não é a melhor maneira de ocultar conteúdo. Uma página negada ainda pode aparecer nos resultados de pesquisa se for vinculada de outros sites.

Se você quiser impedir de forma confiável que uma página apareça no Google, você deve usar uma tag meta 'noindex' em vez disso. Isso diz aos motores de busca para não adicionar a página ao seu índice.

Como é um Arquivo Robots.txt Ideal?

Muitos blogs populares usam um arquivo robots.txt muito simples. O conteúdo deles pode variar dependendo das necessidades do site específico:

User-agent: *

Disallow:

Sitemap: https://www.example.com/post-sitemap.xml

Sitemap: https://www.example.com/page-sitemap.xml

Este arquivo robots.txt permite que todos os bots indexem todo o conteúdo e fornece a eles um link para os sitemaps XML do site.

Para sites WordPress, recomendamos as seguintes regras no arquivo robots.txt:

User-Agent: *

Allow: /wp-content/uploads/

Disallow: /wp-admin/

Disallow: /readme.html

Disallow: /refer/

Sitemap: https://www.example.com/post-sitemap.xml

Sitemap: https://www.example.com/page-sitemap.xml

Isso diz aos bots de busca para indexar todas as suas imagens e arquivos carregados do WordPress usando especificamente a diretiva Allow, que é um comando útil que motores de busca como o Google entendem.

Ele então proíbe os bots de busca de indexar a área de administração do WordPress, o arquivo padrão readme.html (que pode revelar sua versão do WordPress) e diretórios comuns para links de afiliados ocultos como /refer/.

Ao adicionar sitemaps ao arquivo robots.txt, você facilita para os bots do Google encontrarem todas as páginas do seu site.

Agora que você sabe como é um arquivo robots.txt ideal, vamos ver como você pode criar um arquivo robots.txt no WordPress.

Como Criar um Arquivo Robots.txt no WordPress

Existem duas maneiras de criar um arquivo robots.txt no WordPress. Você pode escolher o método que funciona melhor para você.

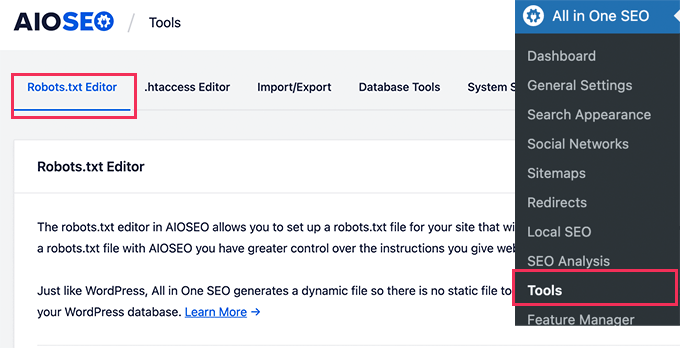

Método 1: Editando o Arquivo Robots.txt Usando All in One SEO

All in One SEO, também conhecido como AIOSEO, é o melhor plugin de SEO para WordPress do mercado, usado por mais de 3 milhões de sites. É fácil de usar e vem com um gerador de arquivo robots.txt.

Para saber mais, confira nossa análise detalhada do AIOSEO.

Se você ainda não tem o plugin AIOSEO instalado, pode ver nosso guia passo a passo sobre como instalar um plugin do WordPress.

Observação: Uma versão gratuita do AIOSEO também está disponível e possui este recurso.

Uma vez que o plugin é instalado e ativado, você pode usá-lo para criar e editar seu arquivo robots.txt diretamente da sua área de administração do WordPress.

Simplesmente vá para All in One SEO » Ferramentas para editar seu arquivo robots.txt.

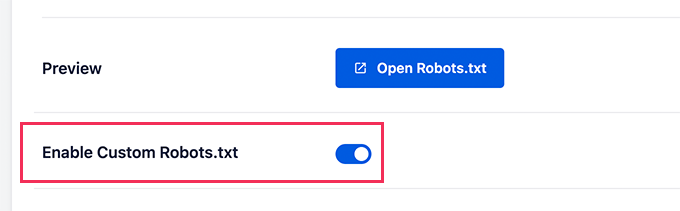

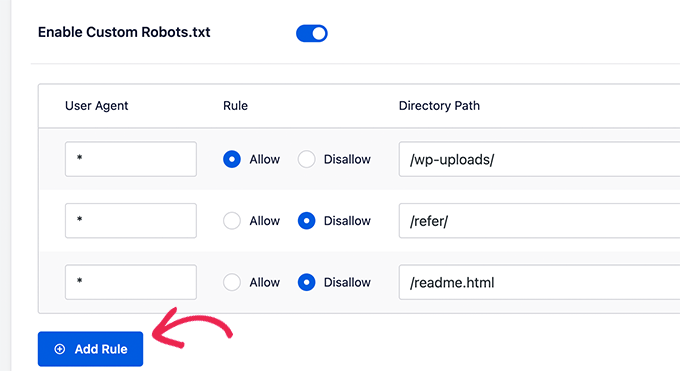

Primeiro, você precisará ativar a opção de edição clicando no botão de alternância ‘Ativar Robots.txt Personalizado’ para azul.

Com este botão ativado, você pode criar um arquivo robots.txt personalizado no WordPress.

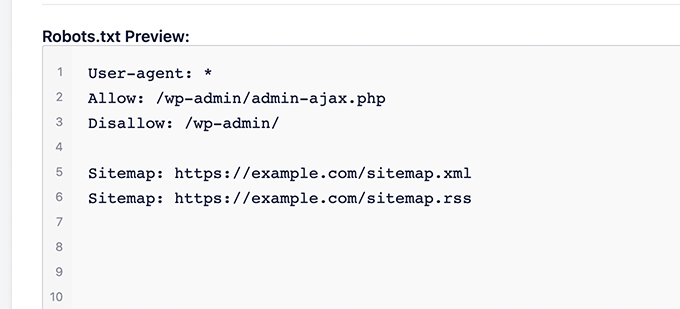

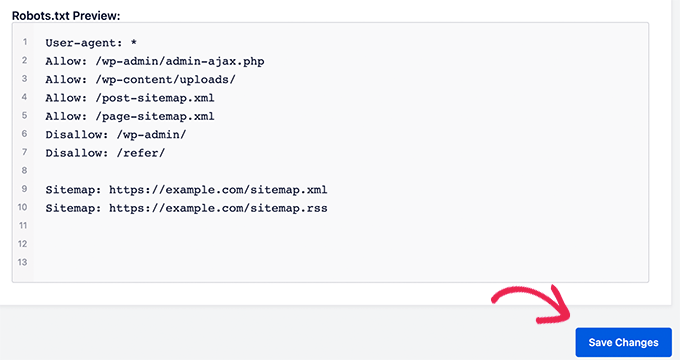

O All in One SEO mostrará seu arquivo robots.txt existente na seção ‘Prévia do Robots.txt’ na parte inferior da sua tela.

Esta versão mostrará as regras padrão que foram adicionadas pelo WordPress.

Essas regras padrão instruem os mecanismos de busca a não rastrear seus arquivos principais do WordPress, permitem que os bots indexem todo o conteúdo e fornecem a eles um link para os sitemaps XML do seu site.

Agora, você pode adicionar suas próprias regras personalizadas para melhorar seu robots.txt para SEO.

Para adicionar uma regra, insira um user agent no campo ‘User Agent’. Usar um * aplicará a regra a todos os user agents.

Em seguida, selecione se você deseja ‘Permitir’ ou ‘Negar’ o rastreamento pelos mecanismos de busca.

Em seguida, insira o nome do arquivo ou o caminho do diretório no campo ‘Caminho do Diretório’.

A regra será aplicada automaticamente ao seu robots.txt. Para adicionar outra regra, basta clicar no botão ‘Adicionar Regra’.

Recomendamos adicionar regras até que você crie o formato ideal de robots.txt que compartilhamos acima.

Suas regras personalizadas ficarão assim.

Quando terminar, não se esqueça de clicar no botão ‘Salvar Alterações’ para armazenar suas modificações.

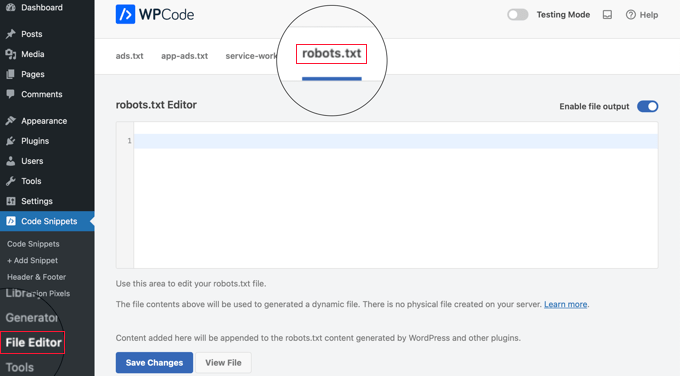

Método 2: Editando o Arquivo Robots.txt Usando WPCode

WPCode é um poderoso plugin de snippets de código que permite adicionar código personalizado ao seu site de forma fácil e segura.

Ele também inclui um recurso útil que permite editar rapidamente o arquivo robots.txt.

Observação: Existe também o WPCode Plugin Gratuito, mas ele não inclui o recurso de editor de arquivos.

A primeira coisa que você precisa fazer é instalar o plugin WPCode. Para instruções passo a passo, consulte nosso guia para iniciantes sobre como instalar um plugin do WordPress.

Ao ativar, você precisa navegar até a página WPCode » Editor de Arquivos. Uma vez lá, basta clicar na aba 'robots.txt' para editar o arquivo.

Agora, você pode colar ou digitar o conteúdo do arquivo robots.txt.

Quando terminar, certifique-se de clicar no botão ‘Salvar Alterações’ na parte inferior da página para armazenar as configurações.

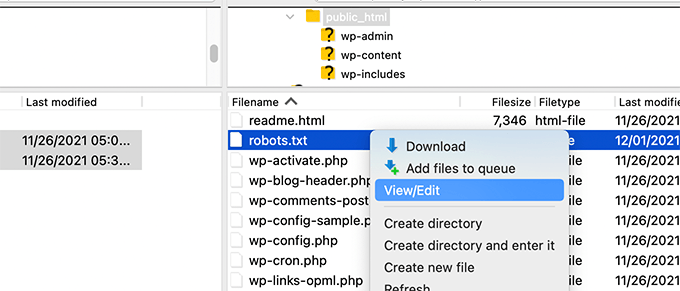

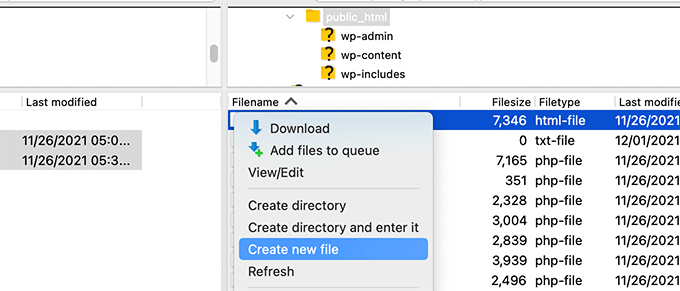

Método 3: Editando o arquivo Robots.txt Manualmente Usando FTP

Para este método, você precisará usar um cliente FTP para editar o arquivo robots.txt. Alternativamente, você pode usar o gerenciador de arquivos fornecido pela sua hospedagem WordPress.

Dica Profissional: Antes de editar, recomendamos baixar uma cópia de backup do seu arquivo robots.txt original (se existir) para o seu computador. Dessa forma, você pode reenviá-lo facilmente se algo der errado.

Simplesmente conecte-se aos arquivos do seu site WordPress usando um cliente FTP.

Uma vez dentro, você poderá ver o arquivo robots.txt na pasta raiz do seu site.

Se você não vir um, é provável que não tenha um arquivo robots.txt.

Nesse caso, você pode simplesmente prosseguir e criar um.

Robots.txt é um arquivo de texto simples, o que significa que você pode baixá-lo para o seu computador e editá-lo usando qualquer editor de texto simples como o Bloco de Notas ou o TextEdit.

Após salvar suas alterações, você pode fazer o upload do arquivo robots.txt de volta para a pasta raiz do seu site.

Como Testar Seu Arquivo Robots.txt

Após criar ou editar seu arquivo robots.txt, é uma ótima ideia verificá-lo em busca de erros. Um pequeno erro de digitação pode acidentalmente bloquear páginas importantes dos mecanismos de busca, então esta etapa é super importante! 👍

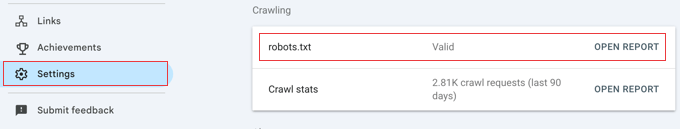

Embora o Google costumasse ter uma ferramenta de teste dedicada, eles agora integraram esse recurso aos relatórios principais do Google Search Console.

Primeiro, certifique-se de que seu site esteja conectado ao Google Search Console. Se você ainda não fez isso, basta seguir nosso guia simples sobre como adicionar seu site WordPress ao Google Search Console.

Uma vez configurado, vá para o seu painel do Google Search Console. Navegue até Configurações no menu inferior esquerdo.

Em seguida, encontre a seção 'Rastreamento' e clique em 'Abrir Relatório' ao lado de 'robots.txt'.

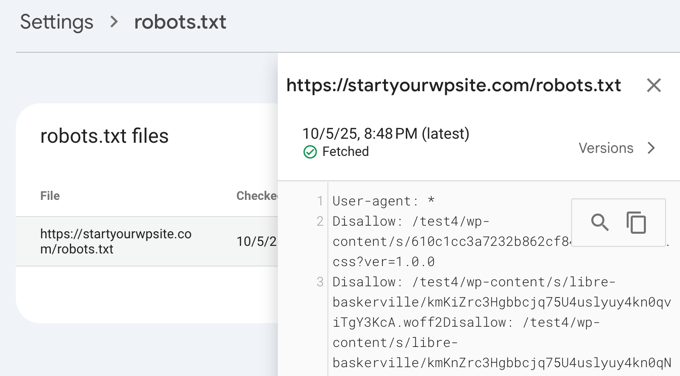

Simplesmente clique na versão atual do arquivo na lista.

Este relatório mostrará a versão mais recente do seu arquivo robots.txt que o Google encontrou. Ele destacará quaisquer erros de sintaxe ou problemas lógicos que ele detectou.

Não se preocupe se você acabou de atualizar seu arquivo e não vir as alterações aqui imediatamente. O Google verifica automaticamente uma nova versão do seu arquivo robots.txt aproximadamente uma vez por dia.

Você pode verificar este relatório mais tarde para confirmar que o Google captou suas últimas alterações e que tudo parece bom.

Considerações Finais

O objetivo de otimizar seu arquivo robots.txt é impedir que os mecanismos de pesquisa rastreiem páginas que não estão publicamente disponíveis. Por exemplo, páginas em sua pasta wp-plugins ou páginas em sua pasta de administração do WordPress.

Um mito comum entre especialistas em SEO é que bloquear categorias, tags e páginas de arquivo do WordPress melhorará a taxa de rastreamento e resultará em indexação mais rápida e classificações mais altas.

Isso não é verdade. Na verdade, essa prática é fortemente desencorajada pelo Google e vai contra suas diretrizes de melhores práticas para ajudá-los a entender seu site.

Recomendamos que você siga o formato robots.txt acima para criar um arquivo robots.txt para o seu site.

Perguntas Frequentes sobre robots.txt do WordPress

Aqui estão algumas das perguntas mais comuns que recebemos sobre a otimização do arquivo robots.txt no WordPress.

1. Qual é o principal propósito de um arquivo robots.txt?

O principal propósito de um arquivo robots.txt é gerenciar o orçamento de rastreamento do seu site. Ao dizer aos mecanismos de busca quais páginas ignorar (como páginas de administração ou arquivos de plugin), você os ajuda a gastar seus recursos rastreando e indexando seu conteúdo mais importante de forma mais eficiente.

2. Onde o arquivo robots.txt está localizado no WordPress?

Seu arquivo robots.txt está localizado no diretório raiz do seu site. Você pode visualizá-lo normalmente acessando seusite.com/robots.txt em seu navegador da web.

3. O uso do robots.txt pode melhorar a segurança do meu site?

Não, o robots.txt não é uma medida de segurança. O arquivo é visível publicamente, portanto, ele não impede ninguém de acessar os URLs que você lista. Ele simplesmente fornece diretivas para rastreadores de mecanismos de busca bem-comportados.

4. Devo bloquear páginas de categorias e tags do WordPress no robots.txt?

Não, você não deve bloquear páginas de categorias e tags. Essas páginas de arquivo são úteis para SEO porque ajudam os mecanismos de busca a entender a estrutura do seu site e a descobrir seu conteúdo. Bloqueá-las pode impactar negativamente seus rankings de busca.

Recursos Adicionais sobre o uso de robots.txt no WordPress

Agora que você sabe como otimizar seu arquivo robots.txt, talvez goste de ver outros artigos relacionados ao uso de robots.txt no WordPress.

- Glossário: Robots.txt

- Como Ocultar uma Página do WordPress do Google

- Como Impedir que Mecanismos de Busca Rastejem um Site WordPress

- Como Excluir Permanentemente um Site WordPress da Internet

- Como Ocultar Facilmente (Noindex) Arquivos PDF no WordPress

- Como Corrigir o Erro “O Googlebot não consegue acessar arquivos CSS e JS” no WordPress

- O que é llms.txt? Como adicionar llms.txt no WordPress

- Como Configurar o All in One SEO para WordPress Corretamente (Guia Definitivo)

Esperamos que este artigo tenha ajudado você a aprender como otimizar o arquivo robots.txt do seu WordPress para SEO. Você também pode querer ver nosso guia definitivo de SEO para WordPress e nossas escolhas de especialistas para as melhores ferramentas de SEO para WordPress para expandir seu site.

Se você gostou deste artigo, por favor, inscreva-se em nosso Canal do YouTube para tutoriais em vídeo do WordPress. Você também pode nos encontrar no Twitter e no Facebook.

Dennis Muthomi

Tenho que admitir, eu uso o plugin AIOSEO, mas sempre ignorei a opção “Habilitar robots.txt personalizado” porque não queria estragar nada.

Mas eu li este artigo e estou convencido de que vale a pena dedicar tempo para otimizar o arquivo robots.txt do meu site.

Amit Banerjee

Se o template completo do robots.txt tivesse sido fornecido, teria sido útil.

WPBeginner Support

We did include the entire robots.txt

Admin

Michael

Acho que você deveria modificar sua resposta. Deveria ser https em vez de http. É certo proibir também os arquivos de plugins?

WPBeginner Support

Obrigado por apontar isso, nossa amostra foi atualizada. Para proibir plugins, você deve verificar com o plugin específico para ter certeza.

Moinuddin Waheed

Obrigado por esta postagem informativa sobre o arquivo robots.txt.

Eu não sabia que os sites deveriam manter este arquivo para ter controle sobre os bots do Google sobre como eles devem rastrear nossas páginas e postagens.

para sites iniciantes que estão começando, há necessidade de ter um arquivo robots.txt ou existe uma maneira como um plugin que pode criar um arquivo robots.txt para o nosso site?

WPBeginner Support

A maioria dos plugins de SEO ajuda na configuração do robots.txt para um novo site para evitar que os bots percorram seções que não deveriam.

Admin

Jiří Vaněk

Graças a este artigo, verifiquei o arquivo robots.txt e adicionei endereços de URL com sitemaps. Ao mesmo tempo, tinha outras linhas problemáticas lá, que foram reveladas pelo validador. Eu não conhecia sitemaps em robots.txt até agora. Obrigado.

WPBeginner Support

De nada, fico feliz que nosso guia pôde ajudar!

Admin

Stéphane

Olá,

Obrigado por essa postagem, fica mais claro como usar o arquivo robots.txt. Na maioria dos sites que você encontra ao procurar algum conselho sobre o arquivo robots.txt, você pode ver que as seguintes pastas são explicitamente excluídas do rastreamento (para WordPress):

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

Eu não entendo realmente as razões para excluir essas pastas (há alguma, na verdade?). Qual seria sua opinião sobre esse assunto?

WPBeginner Support

É principalmente para evitar que qualquer coisa nessas pastas apareça como resultado quando um usuário pesquisa seu site. Como esse não é o seu conteúdo, não é algo que a maioria das pessoas gostaria que aparecesse nos resultados do site.

Admin

zaid haris

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

O GSC mostra o erro de cobertura para “Disallow: /wp-admin/”. Isso está errado?

WPBeginner Support

Para a maioria dos sites, você não quer que nada do seu wp-admin apareça como resultado de pesquisa, então é normal e esperado receber a área de cobertura quando você nega ao Google a capacidade de rastrear seu wp-admin.

Admin

Hansini

Estou criando meu robots.txt manualmente como você instruiu para o meu site WordPress.

Tenho uma dúvida. quando eu escrevo User-Agent: * não vai permitir que outro robô de spam acesse meu site?

Devo escrever User-Agent: * ou User-Agent: Googlebot.?

WPBeginner Support

A linha User-Agent define as regras que todos os robôs devem seguir em seu site. Se você especificar um bot específico nessa linha, ele definirá regras para esse bot específico e nenhum outro.

Admin

Nishant

O que devemos escrever para que o Google indexe meu post?

WPBeginner Support

Para ter seu site listado, você vai querer dar uma olhada em nosso artigo abaixo:

https://www.wpbeginner.com/beginners-guide/how-do-i-get-my-wordpress-site-listed-on-google-beginners-guide/

Admin

Sanjeev Pandey

devemos também proibir /wp-content/themes/ ?

Ele está aparecendo nos resultados de pesquisa quando executo o comando site:abcdef.com no Google Search

WPBeginner Support

Você não vai querer se preocupar em bloquear sua pasta de temas e, à medida que escreve conteúdo otimizado para SEO, não deverá mais ver os temas como resultado de pesquisa.

Admin

Salem

Olá, o que significa ” Disallow: /readme.html & Disallow: /refer/ ” ?

WPBeginner Support

Isso significa que você está dizendo aos mecanismos de busca para não olharem nenhum link de referência ou o arquivo readme.html.

Admin

sean

Olá, quais são os prós e contras de bloquear wp-content/uploads

Obrigado

WPBeginner Support

Se você bloquear sua pasta de uploads, os mecanismos de busca normalmente não rastrearão seu conteúdo carregado, como imagens.

Admin

Piyush

obrigado por resolver meu problema

WPBeginner Support

You’re welcome

Admin

Ravi kumar

Senhor, estou muito confuso sobre o robot.txt, muitas vezes enviei o sitemap no Blogger, mas depois de 3, 4 dias o mesmo problema surge, o que é exatamente o robot.txt.. & como enviá-lo, por favor, me guie

WPBeginner Support

Dependeria do seu problema específico, você pode querer dar uma olhada em nossa página abaixo:

https://www.wpbeginner.com/glossary/robots-txt/

Admin

Prem

Se eu não indexar uma URL ou página usando o arquivo robots.txt, o Google mostrará algum erro no Search Console?

WPBeginner Support

Não, o Google não listará a página, mas se a página estiver listada, não mostrará um erro.

Admin

Bharat

Olá

Tenho uma pergunta

Recebi um aviso de problema de cobertura do Google Search Console sobre bloqueado por robots.txt

/wp-admin/widgets.php

Minha pergunta é, posso permitir que wp-admin/widgets.php seja incluído no robots.txt e isso é seguro?

WPBeginner Support

Se você quisesse, poderia, mas esse não é um arquivo que o Google precisa rastrear.

Admin

Anthony

Olá, estou me perguntando se você deveria permitir: /wp-admin/admin-ajax.php?

WPBeginner Support

Normalmente, sim, você deveria.

Admin

Jaira

Posso saber por que você deveria permitir /wp-admin/admin-ajax.php?

WPBeginner Support

Ele é usado por diferentes temas e plugins para aparecer corretamente para os mecanismos de busca.

Amila

Olá! Gostei muito deste artigo e, como sou iniciante em tudo isso de rastreamento, gostaria de perguntar algo a respeito. Recentemente, o Google rastreou e indexou um dos meus sites de uma maneira terrível, mostrando as páginas nos resultados de pesquisa que foram excluídas do site. O site não havia desativado a indexação pelos mecanismos de busca nas configurações do WordPress no início, mas o fez mais tarde, depois que o Google mostrou mais 3 páginas nos resultados de pesquisa (essas páginas também não existem) e eu realmente não entendo como isso pôde acontecer com a opção "desativar indexação pelos mecanismos de busca" ativada. Então, o método Yoast pode ser útil e resolver o problema do meu site para que o Google indexe meu site da maneira apropriada desta vez? Agradeço antecipadamente!

WPBeginner Support

O plugin Yoast deve ser capaz de ajudar a garantir que as páginas que você tem sejam indexadas corretamente; há uma chance de que, antes de você desativar a indexação pelos mecanismos de busca em seu site, sua página tenha sido armazenada em cache.

Admin

Amila

Sim, e de todas as páginas, ele armazenou em cache aquelas que não existem mais. De qualquer forma, como a página atual está configurada para “desencorajar”, é melhor mantê-la assim por enquanto ou desmarcar a caixa e deixar o Google rastrear e indexar novamente com a ajuda do Yoast? Obrigado! Com seus artigos, tudo ficou mais fácil!

WPBeginner Support

Você vai querer que o Google rastreie seu site novamente assim que ele for configurado como você deseja.

Pradhuman Kumar

Oi, adorei o artigo, muito preciso e perfeito.

Apenas uma pequena sugestão, por favor, atualize a imagem do testador ROBOTS.txt, pois o Google Console mudou e seria ótimo se você adicionasse o link para verificar o robots.txt do Google.

WPBeginner Support

Obrigado pelo feedback, com certeza vamos analisar a atualização do artigo assim que possível.

Admin

Kamaljeet Singh

O arquivo robots.txt do meu blog era:

User-Agent: *

crawl-delay: 10

Depois de ler este post, eu o alterei para o seu arquivo robots.txt recomendado. Tudo bem se eu removi o crawl-delay

WPBeginner Support

Deve ficar tudo bem, crawl-delay diz aos mecanismos de busca para diminuir a velocidade com que rastreiam seu site.

Admin

reena

Muito bem descrito sobre robot.text, estou muito feliz

você é um ótimo escritor

WPBeginner Support

Thank you, glad you liked our article

Admin

JJ

O que é a página Disallow: /refer/ ? Recebo um 404, é um arquivo wp oculto?

Equipe Editorial

Usamos /refer/ para redirecionar para vários links de afiliados em nosso site. Não queremos que eles sejam indexados, pois são apenas redirecionamentos e não conteúdo real.

Admin

Sagar Arakh

Obrigado por compartilhar. Isso foi realmente útil para eu entender robots.txt

Eu atualizei meu robots.txt para o ideal que você sugeriu. aguardarei os resultados agora

WPBeginner Support

You’re welcome, glad you’re willing to use our recommendations

Admin

Akash Gogoi

Artigo muito útil. Muito obrigado.

WPBeginner Support

Glad our article was helpful

Admin

Zingylancer

Obrigado por compartilhar esta informação útil sobre nós.

WPBeginner Support

Glad we could share this information about the robots.txt file

Admin

Jasper

obrigado por me atualizar com informações. Seu artigo foi bom para o arquivo Robot txt. Ele me deu uma nova informação. obrigado e mantenha-me atualizado com novas ideias.

WPBeginner Support

Glad our guide was helpful

Admin

Imran

Obrigado, adicionei robots.txt no WordPress. Ótimo artigo

WPBeginner Support

Thank you, glad our article was helpful

Admin