È una sensazione terribile quando ti rendi conto che un piccolo file di testo trascurato potrebbe sabotare silenziosamente la SEO del tuo sito web. Molti proprietari di siti non si rendono conto che un semplice errore nel loro file robots.txt può impedire a Google di trovare i loro contenuti più importanti.

Dopo aver analizzato migliaia di siti WordPress, abbiamo visto accadere questo più volte di quante possiamo contare. La buona notizia è che risolverlo è più facile di quanto pensi.

In questa guida, ti illustreremo i passaggi esatti e testati sul campo che utilizziamo per ottimizzare un file robots.txt di WordPress. Imparerai come farlo correttamente e assicurarti che i motori di ricerca scansionino il tuo sito in modo efficiente.

Ti senti sopraffatto? Ecco una rapida panoramica di tutto ciò che tratteremo in questa guida. Sentiti libero di passare alla sezione che ti interessa di più.

- Cos'è un file Robots.txt?

- Hai bisogno di un file Robots.txt per il tuo sito WordPress?

- Come appare un file robots.txt ideale?

- Come creare un file Robots.txt in WordPress

- Come testare il tuo file Robots.txt

- Considerazioni finali

- Domande frequenti su Robots.txt di WordPress

- Risorse aggiuntive sull'uso di Robots.txt in WordPress

Cos'è un file Robots.txt?

Robots.txt è un file di testo che i proprietari di siti web possono creare per indicare ai bot dei motori di ricerca come eseguire la scansione e indicizzare le pagine sui loro siti.

È tipicamente memorizzato nella directory principale (nota anche come cartella principale) del tuo sito web. Il formato di base per un file robots.txt è il seguente:

User-agent: [user-agent name]

Disallow: [URL string not to be crawled]

User-agent: [user-agent name]

Allow: [URL string to be crawled]

Sitemap: [URL of your XML Sitemap]

Puoi avere più righe di istruzioni per consentire o negare l'accesso a URL specifici e aggiungere più sitemap. Se non neghi un URL, i bot dei motori di ricerca presumono che sia consentito eseguirne la scansione.

Ecco come può apparire un file robots.txt di esempio:

User-Agent: *

Allow: /wp-content/uploads/

Disallow: /wp-content/plugins/

Disallow: /wp-admin/

Sitemap: https://example.com/sitemap_index.xml

Nell'esempio robots.txt sopra, abbiamo consentito ai motori di ricerca di eseguire la scansione e indicizzare i file nella nostra cartella di caricamenti di WordPress.

Successivamente, abbiamo negato ai bot di ricerca la scansione e l'indicizzazione delle cartelle dei plugin e dell'amministrazione di WordPress.

Infine, abbiamo fornito l'URL della nostra sitemap XML.

Hai bisogno di un file Robots.txt per il tuo sito WordPress?

Sebbene il tuo sito possa funzionare senza un file robots.txt, abbiamo costantemente riscontrato che i siti con file robots.txt ottimizzati ottengono prestazioni migliori nei risultati di ricerca.

Grazie al nostro lavoro con clienti di vari settori, abbiamo visto come una corretta gestione del budget di scansione tramite robots.txt possa portare a un'indicizzazione più rapida dei contenuti importanti e a migliori prestazioni SEO complessive.

Questo non avrà un grande impatto quando avvii un blog e non hai molti contenuti.

Tuttavia, man mano che il tuo sito web cresce e aggiungi più contenuti, probabilmente vorrai un maggiore controllo su come il tuo sito web viene scansionato e indicizzato.

Ecco perché.

I motori di ricerca allocano a ciascun sito web quello che Google chiama un 'budget di scansione'. Questo è il numero di pagine che scansioneranno entro un determinato periodo di tempo.

Nei nostri test su migliaia di siti WordPress, abbiamo scoperto che i siti più grandi beneficiano in particolare dall'ottimizzazione di questo budget attraverso una configurazione strategica di robots.txt.

Ad esempio, uno dei nostri clienti enterprise ha visto un miglioramento del 40% nell'efficienza di scansione dopo aver implementato le ottimizzazioni robots.txt da noi raccomandate.

Puoi impedire ai bot di ricerca di tentare di scansionare pagine non necessarie come le pagine di amministrazione di WordPress, i file dei plugin e la cartella dei temi.

Impedendo l'accesso a pagine non necessarie, risparmi la tua quota di scansione. Questo aiuta i motori di ricerca a scansionare ancora più pagine sul tuo sito e a indicizzarle il più rapidamente possibile.

Un altro buon motivo per utilizzare un file robots.txt è quando vuoi impedire ai motori di ricerca di indicizzare un post o una pagina sul tuo sito web.

Tuttavia, è importante sapere che robots.txt non è il modo migliore per nascondere i contenuti. Una pagina non consentita può comunque apparire nei risultati di ricerca se è collegata da altri siti web.

Se vuoi impedire in modo affidabile che una pagina appaia su Google, dovresti usare invece un tag meta 'noindex'. Questo dice ai motori di ricerca di non aggiungere affatto la pagina al loro indice.

Come appare un file robots.txt ideale?

Molti blog popolari utilizzano un file robots.txt molto semplice. Il loro contenuto può variare a seconda delle esigenze del sito specifico:

User-agent: *

Disallow:

Sitemap: https://www.example.com/post-sitemap.xml

Sitemap: https://www.example.com/page-sitemap.xml

Questo file robots.txt consente a tutti i bot di indicizzare tutti i contenuti e fornisce loro un link alle sitemap XML del sito web.

Per i siti WordPress, raccomandiamo le seguenti regole nel file robots.txt:

User-Agent: *

Allow: /wp-content/uploads/

Disallow: /wp-admin/

Disallow: /readme.html

Disallow: /refer/

Sitemap: https://www.example.com/post-sitemap.xml

Sitemap: https://www.example.com/page-sitemap.xml

Questo dice ai bot di ricerca di indicizzare tutte le tue immagini e i file caricati di WordPress utilizzando specificamente la direttiva Allow, che è un comando utile che i motori di ricerca come Google comprendono.

Disabilita quindi i bot di ricerca dall'indicizzare l'area di amministrazione di WordPress, il file readme.html predefinito (che può rivelare la tua versione di WordPress) e le directory comuni per i link di affiliazione mascherati come /refer/.

Aggiungendo sitemap al file robots.txt, faciliti ai bot di Google la ricerca di tutte le pagine del tuo sito.

Ora che sai come dovrebbe essere un file robots.txt ideale, diamo un'occhiata a come puoi creare un file robots.txt in WordPress.

Come creare un file Robots.txt in WordPress

Ci sono due modi per creare un file robots.txt in WordPress. Puoi scegliere il metodo che funziona meglio per te.

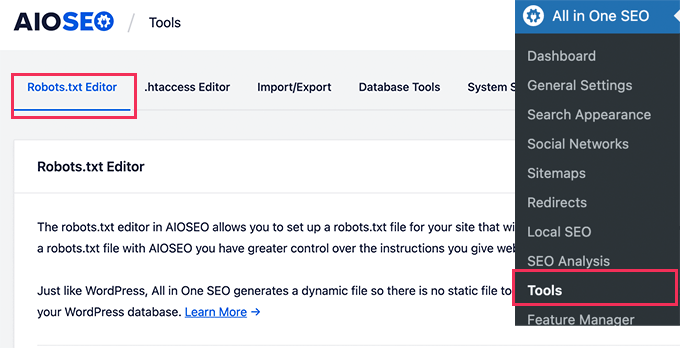

Metodo 1: Modifica del file Robots.txt utilizzando All in One SEO

All in One SEO, noto anche come AIOSEO, è il miglior plugin SEO per WordPress sul mercato, utilizzato da oltre 3 milioni di siti web. È facile da usare e include un generatore di file robots.txt.

Per saperne di più, consulta la nostra dettagliata recensione AIOSEO.

Se non hai ancora installato il plugin AIOSEO, puoi consultare la nostra guida passo passo su come installare un plugin WordPress.

Nota: È disponibile anche una versione gratuita di AIOSEO che include questa funzionalità.

Una volta installato e attivato il plugin, puoi usarlo per creare e modificare il tuo file robots.txt direttamente dall'area di amministrazione di WordPress.

Vai semplicemente su Tutto in Uno SEO » Strumenti per modificare il tuo file robots.txt.

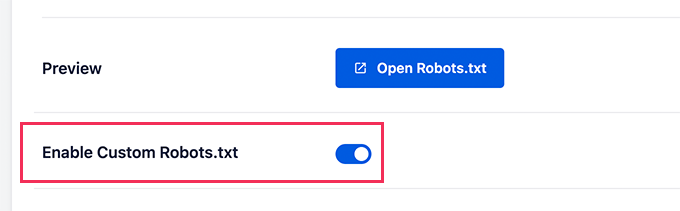

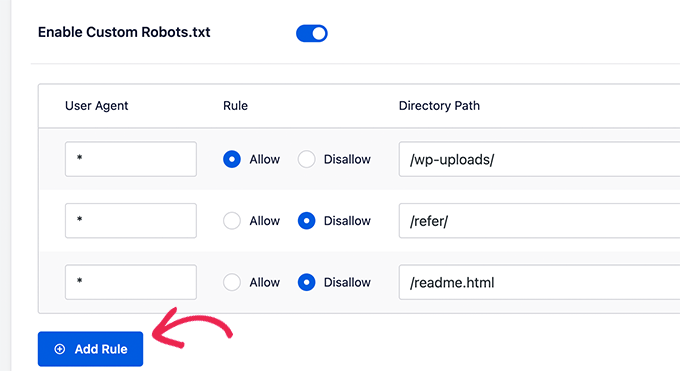

Innanzitutto, dovrai attivare l'opzione di modifica facendo clic sull'interruttore 'Abilita Robots.txt personalizzato' fino a renderlo blu.

Con questo interruttore attivato, puoi creare un file robots.txt personalizzato in WordPress.

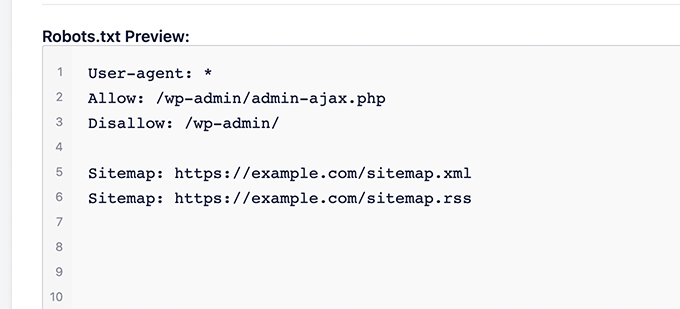

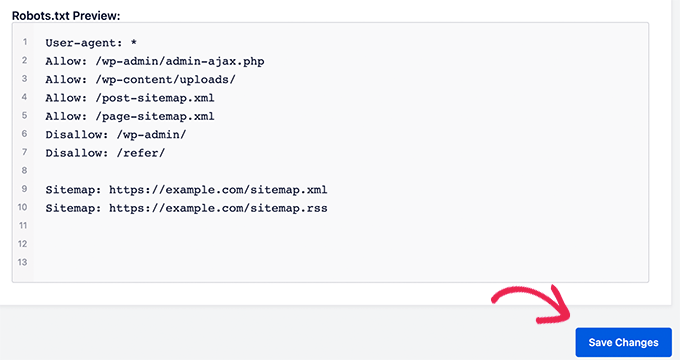

Tutto in Uno SEO mostrerà il tuo file robots.txt esistente nella sezione 'Anteprima Robots.txt' in fondo alla schermata.

Questa versione mostrerà le regole predefinite che sono state aggiunte da WordPress.

Queste regole predefinite indicano ai motori di ricerca di non eseguire la scansione dei tuoi file principali di WordPress, consentono ai bot di indicizzare tutti i contenuti e forniscono loro un link alle sitemap XML del tuo sito.

Ora, puoi aggiungere le tue regole personalizzate per migliorare il tuo robots.txt per la SEO.

Per aggiungere una regola, inserisci un user agent nel campo 'User Agent'. L'uso di un * applicherà la regola a tutti gli user agent.

Quindi, seleziona se vuoi 'Consentire' o 'Disabilitare' la scansione da parte dei motori di ricerca.

Successivamente, inserisci il nome del file o il percorso della directory nel campo 'Directory Path'.

La regola verrà automaticamente applicata al tuo robots.txt. Per aggiungere un'altra regola, fai semplicemente clic sul pulsante 'Aggiungi regola'.

Ti consigliamo di aggiungere regole fino a creare il formato ideale di robots.txt che abbiamo condiviso sopra.

Le tue regole personalizzate appariranno così.

Una volta terminato, non dimenticare di fare clic sul pulsante 'Salva modifiche' per memorizzare le tue modifiche.

Metodo 2: Modifica del file Robots.txt utilizzando WPCode

WPCode è un potente plugin per snippet di codice che ti consente di aggiungere facilmente e in sicurezza codice personalizzato al tuo sito web.

Include anche una comoda funzione che ti permette di modificare rapidamente il file robots.txt.

Nota: Esiste anche un Plugin Gratuito WPCode, ma non include la funzionalità dell'editor di file.

La prima cosa da fare è installare il plugin WPCode. Per istruzioni passo passo, consulta la nostra guida per principianti su come installare un plugin WordPress.

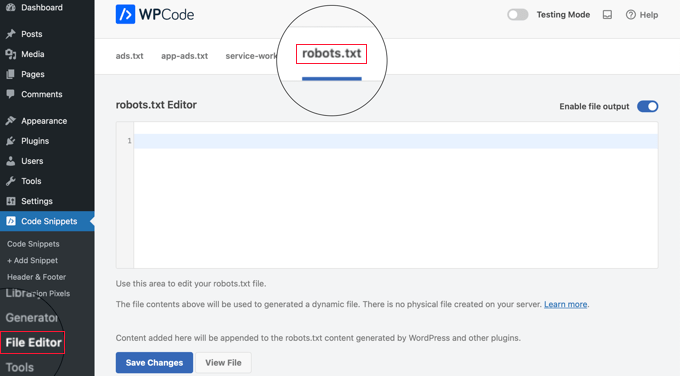

Dopo l'attivazione, devi navigare alla pagina WPCode » Editor File. Una volta lì, fai semplicemente clic sulla scheda 'robots.txt' per modificare il file.

Ora, puoi incollare o digitare il contenuto del file robots.txt.

Una volta terminato, assicurati di fare clic sul pulsante ‘Salva modifiche’ in fondo alla pagina per memorizzare le impostazioni.

Metodo 3: Modifica manuale del file Robots.txt tramite FTP

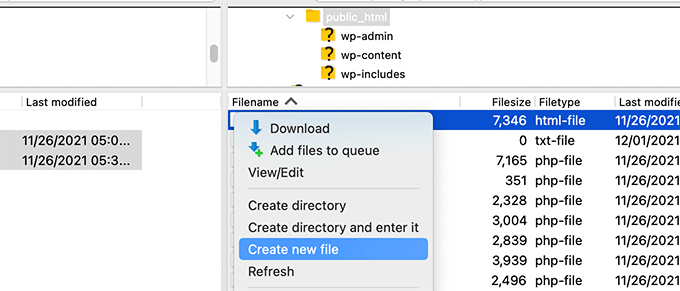

Per questo metodo, dovrai utilizzare un client FTP per modificare il file robots.txt. In alternativa, puoi utilizzare il file manager fornito dal tuo hosting WordPress.

Suggerimento Pro: Prima di apportare modifiche, ti consigliamo di scaricare una copia di backup del tuo file robots.txt originale (se esiste) sul tuo computer. In questo modo, potrai facilmente ricaricarlo se qualcosa va storto.

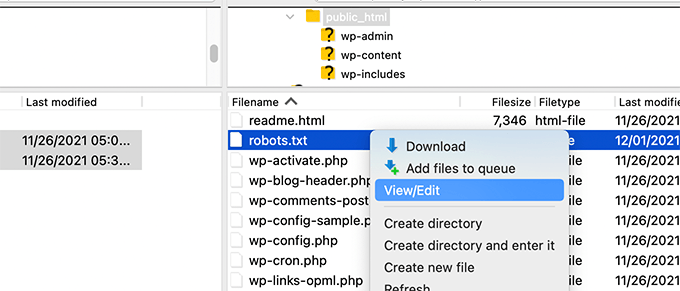

Collega semplicemente i file del tuo sito web WordPress utilizzando un client FTP.

Una volta dentro, sarai in grado di vedere il file robots.txt nella cartella principale del tuo sito web.

Se non ne vedi uno, allora probabilmente non hai un file robots.txt.

In tal caso, puoi semplicemente procedere e crearne uno.

Robots.txt è un file di testo normale, il che significa che puoi scaricarlo sul tuo computer e modificarlo utilizzando qualsiasi editor di testo semplice come Blocco note o TextEdit.

Dopo aver salvato le modifiche, puoi ricaricare il file robots.txt nella cartella principale del tuo sito web.

Come testare il tuo file Robots.txt

Dopo aver creato o modificato il tuo file robots.txt, è un'ottima idea controllarlo per eventuali errori. Un piccolo refuso potrebbe bloccare accidentalmente pagine importanti dai motori di ricerca, quindi questo passaggio è super importante! 👍

Mentre Google aveva uno strumento di test dedicato, ora ha integrato questa funzionalità nei report principali di Google Search Console.

Innanzitutto, assicurati che il tuo sito sia collegato a Google Search Console. Se non l'hai ancora fatto, segui la nostra semplice guida su come aggiungere il tuo sito WordPress a Google Search Console.

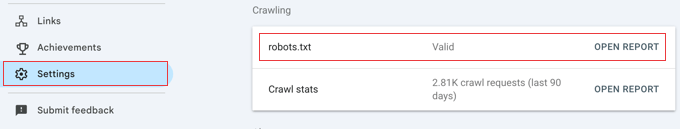

Una volta configurato, vai alla dashboard di Google Search Console. Naviga su Impostazioni nel menu in basso a sinistra.

Successivamente, trova la sezione 'Crawling' e fai clic su 'Apri report' accanto a 'robots.txt'.

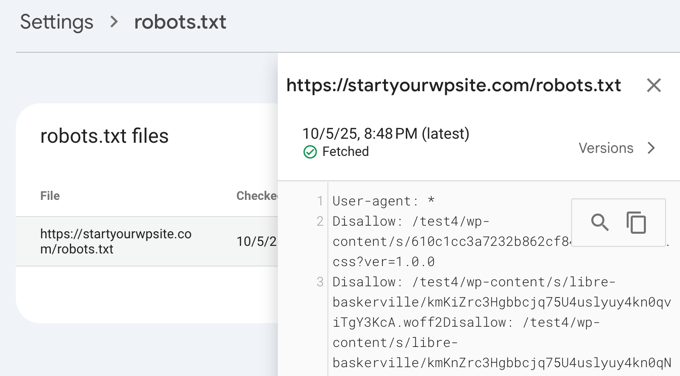

Fai semplicemente clic sulla versione corrente del file nell'elenco.

Questo report ti mostrerà la versione più recente del tuo file robots.txt che Google ha trovato. Evidenzierà eventuali errori di sintassi o problemi logici che ha rilevato.

Non preoccuparti se hai appena aggiornato il tuo file e non vedi subito le modifiche qui. Google controlla automaticamente una nuova versione del tuo file robots.txt circa una volta al giorno.

Puoi ricontrollare questo report più tardi per confermare che Google abbia recepito le tue ultime modifiche e che tutto sia a posto.

Considerazioni finali

L'obiettivo di ottimizzare il tuo file robots.txt è impedire ai motori di ricerca di eseguire la scansione di pagine non pubblicamente disponibili. Ad esempio, pagine nella tua cartella wp-plugins o pagine nella tua cartella di amministrazione di WordPress.

Un mito comune tra gli esperti SEO è che bloccare le categorie, i tag e le pagine di archivio di WordPress migliorerà il tasso di scansione e comporterà un'indicizzazione più rapida e posizionamenti più elevati.

Questo non è vero. Infatti, questa pratica è fortemente sconsigliata da Google e va contro le loro linee guida per le best practice per aiutarli a comprendere il tuo sito.

Ti consigliamo di seguire il formato robots.txt sopra indicato per creare un file robots.txt per il tuo sito web.

Domande frequenti su Robots.txt di WordPress

Ecco alcune delle domande più comuni che ci vengono poste sull'ottimizzazione del file robots.txt in WordPress.

1. Qual è lo scopo principale di un file robots.txt?

Lo scopo principale di un file robots.txt è gestire il budget di scansione del tuo sito web. Indicando ai motori di ricerca quali pagine ignorare (come pagine di amministrazione o file di plugin), li aiuti a spendere le loro risorse per scansionare e indicizzare i tuoi contenuti più importanti in modo più efficiente.

2. Dove si trova il file robots.txt in WordPress?

Il tuo file robots.txt si trova nella directory principale del tuo sito web. Di solito puoi visualizzarlo andando su tuodominio.com/robots.txt nel tuo browser web.

3. L'uso di robots.txt può migliorare la sicurezza del mio sito?

No, robots.txt non è una misura di sicurezza. Il file è visibile pubblicamente, quindi non impedisce effettivamente a nessuno di accedere agli URL che elenchi. Fornisce semplicemente direttive per i crawler dei motori di ricerca ben educati.

4. Devo bloccare le pagine delle categorie e dei tag di WordPress in robots.txt?

No, non dovresti bloccare le pagine delle categorie e dei tag. Queste pagine di archivio sono utili per la SEO perché aiutano i motori di ricerca a comprendere la struttura del tuo sito e a scoprire i tuoi contenuti. Bloccarle può influire negativamente sul tuo posizionamento nei motori di ricerca.

Risorse aggiuntive sull'uso di Robots.txt in WordPress

Ora che sai come ottimizzare il tuo file robots.txt, potresti voler consultare altri articoli relativi all'uso di robots.txt in WordPress.

- Glossario: Robots.txt

- Come nascondere una pagina WordPress da Google

- Come impedire ai motori di ricerca di scansionare un sito WordPress

- Come eliminare definitivamente un sito WordPress da Internet

- Come nascondere facilmente (Noindex) i file PDF in WordPress

- Come risolvere l'errore "Googlebot non può accedere ai file CSS e JS" in WordPress

- Cos'è llms.txt? Come aggiungere llms.txt in WordPress

- Come configurare correttamente All in One SEO per WordPress (Guida definitiva)

Speriamo che questo articolo ti abbia aiutato a imparare come ottimizzare il file robots.txt di WordPress per la SEO. Potresti anche voler consultare la nostra guida definitiva alla SEO per WordPress e le nostre scelte esperte per i migliori strumenti SEO per WordPress per far crescere il tuo sito web.

Se ti è piaciuto questo articolo, iscriviti al nostro canale YouTube per tutorial video su WordPress. Puoi anche trovarci su Twitter e Facebook.

Dennis Muthomi

Devo ammettere che uso il plugin AIOSEO ma ho sempre ignorato l'opzione "Abilita robots.txt personalizzato" perché non volevo combinare pasticci.

Ma ho letto questo articolo e sono convinto che valga la pena dedicare del tempo all'ottimizzazione del file robots.txt del mio sito.

Amit Banerjee

Se fosse stato fornito l'intero template di robots.txt, sarebbe stato d'aiuto.

Supporto WPBeginner

We did include the entire robots.txt

Amministratore

Michael

Penso che dovresti modificare la tua risposta. Dovrebbe essere https invece di http. È giusto disabilitare anche i file dei plugin?

Supporto WPBeginner

Grazie per averlo fatto notare, il nostro esempio è stato aggiornato. Per disabilitare i plugin, dovresti verificare con il plugin specifico per essere sicuro.

Moinuddin Waheed

Grazie per questo post informativo sul file robots.txt.

Non sapevo che i siti web dovessero mantenere questo file per avere un controllo sui bot di Google su come dovrebbero scansionare le nostre pagine e i nostri post.

Per i siti web principianti che stanno appena iniziando, c'è bisogno di avere un file robots.txt o c'è un modo come un plugin che può creare un file robots.txt per il nostro sito web?

Supporto WPBeginner

La maggior parte dei plugin SEO aiuta a configurare il robots.txt per un nuovo sito per impedire ai bot di scansionare sezioni che non dovrebbero.

Amministratore

Jiří Vaněk

Grazie a questo articolo, ho controllato il file robots.txt e aggiunto gli indirizzi URL con le sitemap. Allo stesso tempo, avevo altre righe problematiche lì, che sono state rivelate dal validatore. Non ero a conoscenza delle sitemap in robots.txt fino ad ora. Grazie.

Supporto WPBeginner

Prego, siamo lieti che la nostra guida sia stata utile!

Amministratore

Stéphane

Ciao,

Grazie per quel post, diventa più chiaro come usare il file robots.txt. Sulla maggior parte dei siti web che trovi mentre cerchi consigli riguardo al file robots.txt, puoi vedere che le seguenti cartelle sono esplicitamente escluse dalla scansione (per WordPress):

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

Non capisco bene le ragioni per escludere quelle cartelle (ce n'è una in realtà?). Qual è la tua opinione a riguardo?

Supporto WPBeginner

Serve principalmente a impedire che il contenuto di tali cartelle venga visualizzato nei risultati di ricerca di un utente per il tuo sito. Poiché non si tratta del tuo contenuto, non è qualcosa che la maggior parte delle persone vorrebbe che apparisse nei risultati del sito.

Amministratore

zaid haris

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

GSC mostra l'errore di copertura per “Disallow: /wp-admin/” È sbagliato?

Supporto WPBeginner

Per la maggior parte dei siti, non si desidera che nulla dalla directory wp-admin appaia nei risultati di ricerca, quindi è normale e previsto ricevere l'area di copertura quando si nega a Google la possibilità di scansionare la directory wp-admin.

Amministratore

Hansini

Sto creando il mio robots.txt manualmente come mi hai istruito per il mio sito WordPress.

Ho un dubbio. quando scrivo User-Agent: * non permetterà a un altro robot spam di accedere al mio sito?

Devo scrivere User-Agent: * o User-Agent: Googlebot.?

Supporto WPBeginner

La riga User-Agent imposta le regole che tutti i robot dovrebbero seguire sul tuo sito; se specifichi un bot specifico su quella riga, imposteresti le regole per quel bot specifico e nessun altro.

Amministratore

Nishant

Cosa dovremmo scrivere per far indicizzare i miei post da Google?

Supporto WPBeginner

Per far elencare il tuo sito, dovresti dare un'occhiata al nostro articolo qui sotto:

https://www.wpbeginner.com/beginners-guide/how-do-i-get-my-wordpress-site-listed-on-google-beginners-guide/

Amministratore

Sanjeev Pandey

dovremmo anche disallow /wp-content/themes/ ?

Appare nei risultati di ricerca quando eseguo il comando site:abcdef.com in Google Search

Supporto WPBeginner

Non dovresti preoccuparti di bloccare la cartella dei temi e, poiché scrivi contenuti ottimizzati per la SEO, non dovresti più vedere i temi come risultato di ricerca.

Amministratore

Salem

CIAO, Cosa significa ” Disallow: /readme.html & Disallow: /refer/ ” ?

Supporto WPBeginner

Ciò significa che stai dicendo ai motori di ricerca di non guardare alcun link di riferimento o il file readme.html.

Amministratore

sean

Ciao, quali sono i pro e i contro di bloccare wp-content/uploads

Grazie

Supporto WPBeginner

Se blocchi la tua cartella di caricamenti, i motori di ricerca normalmente non eseguirebbero la scansione dei tuoi contenuti caricati come le immagini.

Amministratore

Piyush

grazie per aver risolto il mio problema

Supporto WPBeginner

You’re welcome

Amministratore

Ravi kumar

Signore, sono molto confuso riguardo a robot.txt. Molte volte ho inviato la sitemap in Blogger ma dopo 3-4 giorni si ripresenta lo stesso problema. Cos'è esattamente robot.txt? E come si invia, per favore guidami.

Supporto WPBeginner

Dipenderebbe dal tuo problema specifico, potresti voler dare un'occhiata alla nostra pagina qui sotto:

https://www.wpbeginner.com/glossary/robots-txt/

Amministratore

Prem

Se non indicizzo un URL o una pagina usando il file robots.txt, Google mostra qualche errore nella Search Console?

Supporto WPBeginner

No, Google non elencherà la pagina ma se la pagina è elencata non mostrerà un errore.

Amministratore

Bharat

Ciao

Ho una domanda

Ricevo un avviso di problema di copertura da Google Search Console per bloccato da robots.txt

/wp-admin/widgets.php

La mia domanda è, posso consentire a wp-admin/widgets.php nel robots.txt e questo è sicuro?

Supporto WPBeginner

Se volessi, puoi farlo, ma non è un file che Google deve scansionare.

Amministratore

Anthony

Ciao, mi stavo chiedendo se dovresti consentire: /wp-admin/admin-ajax.php?

Supporto WPBeginner

Normalmente, sì, dovresti.

Amministratore

Jaira

Posso sapere perché dovresti consentire /wp-admin/admin-ajax.php?

Supporto WPBeginner

Viene utilizzato da diversi temi e plugin per apparire correttamente ai motori di ricerca.

Amila

Ciao! Mi piace molto questo articolo e dato che sono un principiante con tutte queste cose sul crawling, vorrei chiedere qualcosa a riguardo. Recentemente, Google ha eseguito il crawling e indicizzato uno dei miei siti web in modo davvero terribile, mostrando nelle ricerche pagine che sono state cancellate dal sito web. Il sito web non aveva scoraggiato i motori di ricerca dall'indicizzazione nelle impostazioni di WordPress all'inizio, ma lo ha fatto in seguito dopo che Google ha mostrato altre 3 pagine nei risultati di ricerca (anche quelle pagine non esistono) e non capisco davvero come sia potuto succedere con l'opzione "scoraggia i motori di ricerca dall'indicizzazione" attiva. Quindi, il metodo Yoast può essere utile e fornire una soluzione per il mio sito web affinché Google indicizzi il mio sito web nel modo appropriato questa volta? Grazie in anticipo!

Supporto WPBeginner

Il plugin Yoast dovrebbe essere in grado di aiutarti ad assicurarti che le pagine che hai vengano indicizzate correttamente, c'è la possibilità che prima che tu scoraggiassi i motori di ricerca dal crawling del tuo sito, la tua pagina fosse nella cache.

Amministratore

Amila

Beh sì e da tutte le pagine, ha messo in cache quelle che non esistono più. Comunque, dato che la pagina attuale è impostata su "scoraggia", è meglio lasciarla così per ora o deselezionare la casella e lasciare che Google la esegua nuovamente il crawling e la indicizzi con l'aiuto di Yoast? Grazie! Con i tuoi articoli, tutto è diventato più facile!

Supporto WPBeginner

Vorresti che Google scansionasse nuovamente il tuo sito una volta che è configurato come desideri.

Pradhuman Kumar

Ciao, ho adorato l'articolo, molto preciso e perfetto.

Solo un piccolo suggerimento, per favore aggiorna l'immagine ROBOTS.txt tester, poiché la Google Console è cambiata e sarebbe fantastico se aggiungessi il link per controllare il robots.txt da Google.

Supporto WPBeginner

Grazie per il feedback, ci assicureremo di aggiornare l'articolo non appena possibile.

Amministratore

Kamaljeet Singh

Il file robots.txt del mio blog era:

User-Agent: *

crawl-delay: 10

Dopo aver letto questo post, l'ho cambiato nel tuo file robots.txt consigliato. Va bene se ho rimosso crawl-delay?

Supporto WPBeginner

Dovrebbe andare bene, crawl-delay dice ai motori di ricerca di rallentare la velocità di scansione del tuo sito.

Amministratore

reena

Molto ben descritto riguardo al robot.text, sono molto felice

sei un ottimo scrittore

Supporto WPBeginner

Thank you, glad you liked our article

Amministratore

JJ

Cos'è la pagina Disallow: /refer/ ? Ottengo un 404, è un file wp nascosto?

Staff editoriale

Usiamo /refer/ per reindirizzare a vari link di affiliazione sul nostro sito web. Non vogliamo che vengano indicizzati poiché sono solo reindirizzamenti e non contenuti effettivi.

Amministratore

Sagar Arakh

Grazie per aver condiviso. Questo mi è stato davvero utile per capire robots.txt

Ho aggiornato il mio robots.txt a quello ideale che hai suggerito. Ora attenderò i risultati.

Supporto WPBeginner

You’re welcome, glad you’re willing to use our recommendations

Amministratore

Akash Gogoi

Articolo molto utile. Grazie mille.

Supporto WPBeginner

Glad our article was helpful

Amministratore

Zingylancer

Grazie per aver condiviso queste informazioni utili su di noi.

Supporto WPBeginner

Glad we could share this information about the robots.txt file

Amministratore

Jasper

grazie per avermi aggiornato. Il tuo articolo era buono per il file Robot txt. Mi ha dato una nuova informazione. grazie e tienimi aggiornato con nuove idee.

Supporto WPBeginner

Glad our guide was helpful

Amministratore

Imran

Grazie, ho aggiunto robots.txt in WordPress. Articolo molto buono

Supporto WPBeginner

Thank you, glad our article was helpful

Amministratore

Steve

Grazie per questo - come funziona su un WP Multisite però?

Supporto WPBeginner

Per un multisite, avresti bisogno di un file robots.txt nella cartella principale di ogni sito.

Amministratore

Pacifique Ndanyuzwe

Il mio sito WordPress è nuovo e il mio robot.txt di default è

user-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

Voglio che Google scansiona e indicizzi i miei contenuti. Questo robot.txt va bene?

Supporto WPBeginner

Puoi certamente usarlo se volessi

Amministratore

Ritesh Seth

Ottimo articolo…

Ero confuso da molti giorni riguardo al file Robots.txt e ai link Disallow. Ho copiato i tag per il file robots. Spero che questo risolva il problema del mio sito

Supporto WPBeginner

We hope our article will help as well

Amministratore

Kurt

I file negli screenshot della tua cartella principale si trovano in realtà sotto la cartella public_html nella mia cartella principale.

Non avevo una cartella /refer sotto la mia cartella public_html.

Non avevo file xml di post o pagine da nessuna parte sul mio account WP.

Ho incluso una voce nel file robots.txt che ho creato per impedire la scansione del mio sito sandbox. Non sono sicuro che sia necessario dato che ho già selezionato l'opzione in WP che dice ai crawler di non scansionare il mio sito sandbox, ma non credo che faccia male avere la voce.

Supporto WPBeginner

Some hosts do rename public_html to home which is why you see it there. You would want to ensure Yoast is active for the XML files to be available. The method in this article is an additional precaution to help with preventing crawling your site

Amministratore

Ahmed

Ottimo articolo

Supporto WPBeginner

Thank you

Amministratore

ASHOK KUMAR JADON

Ciao, un articolo così bello che risolve il mio problema. Quindi grazie mille

Supporto WPBeginner

Glad our article could help

Amministratore

Elyn Ashton

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php <– Questo è il mio codice robot.txt ma sono confuso sul perché il mio /wp-admin venga indicizzato? Come posso non indicizzarlo?

Supporto WPBeginner

Se è stato indicizzato in precedenza, potrebbe essere necessario attendere che la cache del motore di ricerca si svuoti

Amministratore

Ashish kumar

Questo sito web mi ispira davvero ad avviare un blog. Grazie mille per il team. Ogni singolo articolo di questo sito web ha ricchezza di informazioni e spiegazioni. Quando ho qualche problema, la prima cosa che visito è questo blog. Grazie

Supporto WPBeginner

Glad our articles can be helpful

Amministratore

Anna

Sto cercando di ottimizzare i robot per il mio sito web usando Yoast. Tuttavia, gli strumenti in Yoast non hanno l'opzione per 'File Editor'.

Ci sono solo due opzioni

(i) Importa ed esporta

(ii) Editor di massa

Potresti per favore consigliarmi come affrontare questo problema? Potrebbe essere che io sia su un'edizione gratuita di Yoast?

Supporto WPBeginner

La versione gratuita di Yoast ha ancora l'opzione, la tua installazione potrebbe impedire la modifica dei file, nel qual caso probabilmente dovresti usare il metodo FTP.

Amministratore

Emmanuel Husseni

Trovo questo articolo davvero utile perché non sapevo molto su come funziona robot.txt, ma ora lo so.

Per favore, cosa non capisco è come trovare il formato migliore di robot.txt da usare sul mio sito (intendo uno che funzioni in generale)?

Ho notato che molti grandi blog che controllo e che si posizionano bene sui motori di ricerca usano formati diversi per robot.txt..

Sarei felice di vedere una risposta da te o da chiunque possa aiutare

Staff editoriale

Avere una sitemap e consentire le aree che devono essere consentite è la parte più importante. La parte di disallow varierà in base a ciascun sito. Abbiamo condiviso un esempio nel nostro post del blog, e questo dovrebbe andare bene per la maggior parte dei siti WordPress.

Amministratore

Supporto WPBeginner

Ciao Emmanuel,

Si prega di consultare la sezione relativa al file robots.txt ideale. Dipende dalle tue esigenze. La maggior parte dei blogger esclude le cartelle di amministrazione di WordPress e dei plugin dalla scansione.

Amministratore

Emmanuel Husseni

Grazie mille.

ora capisco. Suppongo che per ora inizierò con il formato generale.

jack

Articolo ben scritto, consiglio agli utenti di creare una sitemap prima di creare e abilitare il loro testo ROBOTS, aiuterà il tuo sito a indicizzarsi più velocemente e a essere indicizzato facilmente.

Jack

Connie S Owens

Vorrei impedire ai motori di ricerca di indicizzare i miei archivi durante la loro scansione.

Emmanuel Nonye

Grazie mille, questo articolo è stato davvero utile

Cherisa

Continuo a ricevere il messaggio di errore riportato di seguito su Google Webmaster. Sono fondamentalmente bloccato. Alcune cose che non mi erano chiare in questo tutorial sono dove trovo i file root del mio sito, come si determina se ho già un "robots.txt" e come si modifica?

Supporto WPBeginner

Ciao Cherisa,

La cartella root del tuo sito è quella che contiene cartelle come wp-admin, wp-includes, wp-content, ecc. Contiene anche file come wp-config.php, wp-cron.php, wp-blogheader.php, ecc.

Se non vedi un file robots.txt in questa cartella, allora non ne hai uno. Puoi procedere e crearne uno nuovo.

Amministratore

Cherisa

Grazie per la tua risposta. Ho cercato ovunque e non riesco a trovare questi file root come descrivi. C'è un percorso di directory che posso seguire che porta a questa cartella? Come se fosse sotto Impostazioni, ecc?

Devender

Avevo un discreto traffico web sul mio sito. Improvvisamente è sceso a zero nel mese di maggio. Fino ad ora ho affrontato il problema. Per favore, aiutami a recuperare il mio sito web.

Haris Aslam

Ciao, grazie per queste informazioni, ma ho una domanda.

Ho appena creato i file sitemap.xml e robots.txt, e vengono scansionati bene. Ma come posso creare "Product-Sitemap.xml"?

C'è un elenco completo di prodotti nel file sitemap.xml. Devo creare Product-sitemap.xml separatamente?

e inviarli di nuovo a Google o Bing?

Puoi aiutarmi?

Grazie

Mahadi Hassan

Ho un problema con l'impostazione del file robots.txt. Viene visualizzato un solo robots.txt per tutti i siti web. Per favore, aiutami a visualizzare un file robots.txt separato per tutti i siti web. Ho tutti i file robots.txt separati per ogni singolo sito web. Ma nel browser viene visualizzato un solo file robots.txt per tutti i siti web.

Debu Majumdar

Per favore, spiega perché hai incluso

Disallow: /refer/

nell'esempio per principianti di Robots.txt? Non capisco le implicazioni di questa riga. È importante per i principianti? Hai spiegato le altre due righe Disallowed.

Grazie.

Supporto WPBeginner

Ciao Debu,

Questo esempio proviene dal file robots.txt di WPBeginner. Noi di WPBeginner utilizziamo ThirstyAffiliates per gestire i link di affiliazione e nascondere gli URL. Questi URL contengono /refer/, motivo per cui li blocchiamo nel nostro file robots.txt.

Amministratore

Evaristo

Come posso mettere tutti i tag/mydomain.Com in nofollow? In robots.txt per concentrare il link Juice? Grazie.

harsh kumar

ciao,, sto riscontrando un errore in yoast seo riguardo alla mappa del sito.. una volta che clicco su correggi,,, ricompare.. l'html del mio sito non si carica correttamente

Tom

Ho appena rivisto il mio account Google Webmaster Tools e, utilizzando la Search Console, ho riscontrato quanto segue:

Pagina parzialmente caricata

Non tutte le risorse della pagina sono state caricate. Ciò può influire su come Google vede e comprende la tua pagina. Risolvi i problemi di disponibilità per qualsiasi risorsa che possa influire su come Google comprende la tua pagina.

Questo accade perché tutti i fogli di stile CSS associati ai plugin sono disabilitati dal robots.txt predefinito.

Capisco le buone ragioni per cui non dovrei semplicemente rendere questo consentito, ma quale sarebbe un'alternativa, dato che sospetterei che gli algoritmi di Google stiano penalizzando il sito per non vederli.

Suren

Ciao,

Ogni volta che cerco il mio sito su Google, questo testo appare sotto il link: "Una descrizione per questo risultato non è disponibile a causa del robots.txt di questo sito".

Come posso risolvere questo problema?

Cordiali saluti

Supporto WPBeginner

Ciao Suren,

Sembra che qualcuno abbia accidentalmente modificato le impostazioni di privacy del tuo sito. Vai alla pagina Impostazioni » Lettura e scorri fino alla sezione "Visibilità per i motori di ricerca". Assicurati che la casella accanto a sia deselezionata.

Amministratore

Divyesh

Ciao

Come ho visto nello strumento per webmaster, ho ottenuto il file robot.txt come segue:

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

fatemi sapere se va bene? o dovrei usarne un altro?

John Cester

Voglio sapere, è una buona idea bloccare (disallow) "/wp-content/plugins/" in robots.tx? Ogni volta che rimuovo un plugin, viene visualizzato un errore 404 in alcune pagine di quel plugin.