C'est un sentiment de désespoir lorsque vous réalisez qu'un petit fichier texte négligé pourrait saboter silencieusement le référencement de votre site Web. De nombreux propriétaires de sites ne réalisent pas qu'une simple erreur dans leur fichier robots.txt peut empêcher Google de trouver leur contenu le plus important.

Après avoir audité des milliers de sites WordPress, nous avons vu cela se produire plus de fois que nous ne pouvons le compter. La bonne nouvelle est que le corriger est plus facile que vous ne le pensez.

Dans ce guide, nous vous présenterons les étapes exactes et éprouvées que nous utilisons pour optimiser un fichier robots.txt WordPress. Vous apprendrez comment le faire correctement et vous assurer que les moteurs de recherche explorent votre site efficacement.

Vous vous sentez dépassé ? Voici un aperçu rapide de tout ce que nous aborderons dans ce guide. N'hésitez pas à passer à la section qui vous intéresse le plus.

- Qu'est-ce qu'un fichier robots.txt ?

- Avez-vous besoin d'un fichier robots.txt pour votre site WordPress ?

- À quoi ressemble un fichier robots.txt idéal ?

- Comment créer un fichier Robots.txt dans WordPress

- Comment tester votre fichier Robots.txt

- Réflexions finales

- Questions fréquemment posées sur robots.txt WordPress

- Ressources supplémentaires sur l'utilisation de robots.txt dans WordPress

Qu'est-ce qu'un fichier robots.txt ?

Robots.txt est un fichier texte que les propriétaires de sites Web peuvent créer pour indiquer aux robots des moteurs de recherche comment explorer et indexer les pages de leurs sites.

Il est généralement stocké dans le répertoire racine (également appelé dossier principal) de votre site Web. Le format de base d'un fichier robots.txt ressemble à ceci :

User-agent: [user-agent name]

Disallow: [URL string not to be crawled]

User-agent: [user-agent name]

Allow: [URL string to be crawled]

Sitemap: [URL of your XML Sitemap]

Vous pouvez avoir plusieurs lignes d'instructions pour autoriser ou interdire des URL spécifiques et ajouter plusieurs sitemaps. Si vous n'interdisez pas une URL, les robots des moteurs de recherche supposent qu'ils sont autorisés à l'explorer.

Voici à quoi peut ressembler un exemple de fichier robots.txt :

User-Agent: *

Allow: /wp-content/uploads/

Disallow: /wp-content/plugins/

Disallow: /wp-admin/

Sitemap: https://example.com/sitemap_index.xml

Dans l'exemple de robots.txt ci-dessus, nous avons autorisé les moteurs de recherche à explorer et à indexer les fichiers de notre dossier de téléchargements WordPress.

Après cela, nous avons interdit aux robots d'exploration d'explorer et d'indexer les plugins et les dossiers d'administration de WordPress.

Enfin, nous avons fourni l'URL de notre sitemap XML.

Avez-vous besoin d'un fichier robots.txt pour votre site WordPress ?

Bien que votre site puisse fonctionner sans fichier robots.txt, nous avons constamment constaté que les sites dotés de fichiers robots.txt optimisés obtiennent de meilleurs résultats dans les moteurs de recherche.

Grâce à notre travail avec des clients de divers secteurs, nous avons constaté comment une gestion adéquate du budget d'exploration via robots.txt peut conduire à une indexation plus rapide du contenu important et à de meilleures performances SEO globales.

Cela n'aura pas beaucoup d'impact lorsque vous démarrez un blog et que vous n'avez pas beaucoup de contenu.

Cependant, à mesure que votre site Web grandit et que vous ajoutez du contenu, vous voudrez probablement mieux contrôler la manière dont votre site Web est exploré et indexé.

Voici pourquoi.

Les moteurs de recherche allouent ce que Google appelle un « budget d'exploration » à chaque site Web. C'est le nombre de pages qu'ils exploreront dans un délai donné.

Lors de nos tests sur des milliers de sites WordPress, nous avons constaté que les sites plus importants bénéficient particulièrement de l'optimisation de ce budget grâce à une configuration stratégique de robots.txt.

Par exemple, l'un de nos clients d'entreprise a constaté une amélioration de 40 % de l'efficacité de l'exploration après avoir mis en œuvre les optimisations de robots.txt que nous recommandons.

Vous pouvez interdire aux robots de recherche de tenter d'explorer des pages inutiles comme vos pages d'administration WordPress, les fichiers de plugins et le dossier des thèmes.

En interdisant les pages inutiles, vous économisez votre quota d'exploration. Cela aide les moteurs de recherche à explorer encore plus de pages sur votre site et à les indexer le plus rapidement possible.

Une autre bonne raison d'utiliser un fichier robots.txt est lorsque vous souhaitez empêcher les moteurs de recherche d'indexer un article ou une page sur votre site Web.

Cependant, il est important de savoir que robots.txt n'est pas le meilleur moyen de masquer du contenu. Une page interdite peut toujours apparaître dans les résultats de recherche si elle est liée depuis d'autres sites Web.

Si vous souhaitez empêcher de manière fiable qu'une page n'apparaisse sur Google, vous devriez plutôt utiliser une balise méta 'noindex'. Cela indique aux moteurs de recherche de ne pas ajouter la page à leur index du tout.

À quoi ressemble un fichier robots.txt idéal ?

De nombreux blogs populaires utilisent un fichier robots.txt très simple. Leur contenu peut varier en fonction des besoins du site spécifique :

User-agent: *

Disallow:

Sitemap: https://www.example.com/post-sitemap.xml

Sitemap: https://www.example.com/page-sitemap.xml

Ce fichier robots.txt autorise tous les robots à indexer tout le contenu et leur fournit un lien vers les sitemaps XML du site web.

Pour les sites WordPress, nous recommandons les règles suivantes dans le fichier robots.txt :

User-Agent: *

Allow: /wp-content/uploads/

Disallow: /wp-admin/

Disallow: /readme.html

Disallow: /refer/

Sitemap: https://www.example.com/post-sitemap.xml

Sitemap: https://www.example.com/page-sitemap.xml

Cela indique aux robots d'exploration d'indexer toutes vos images et fichiers téléchargés WordPress en utilisant spécifiquement la directive Allow, qui est une commande utile que les moteurs de recherche comme Google comprennent.

Il interdit ensuite aux robots d'exploration d'indexer la zone d'administration de WordPress, le fichier readme.html par défaut (qui peut révéler votre version de WordPress) et les répertoires courants pour les liens d'affiliation masqués comme /refer/.

En ajoutant des sitemaps au fichier robots.txt, vous facilitez la tâche des robots de Google pour trouver toutes les pages de votre site.

Maintenant que vous savez à quoi ressemble un fichier robots.txt idéal, examinons comment vous pouvez créer un fichier robots.txt dans WordPress.

Comment créer un fichier Robots.txt dans WordPress

Il existe deux méthodes pour créer un fichier robots.txt dans WordPress. Vous pouvez choisir celle qui vous convient le mieux.

Méthode 1 : Modifier le fichier Robots.txt avec All in One SEO

All in One SEO, également connu sous le nom d'AIOSEO, est le meilleur plugin SEO WordPress du marché, utilisé par plus de 3 millions de sites Web. Il est facile à utiliser et comprend un générateur de fichier robots.txt.

Pour en savoir plus, consultez notre test détaillé d'AIOSEO.

Si vous n'avez pas encore installé le plugin AIOSEO, vous pouvez consulter notre guide étape par étape sur comment installer un plugin WordPress.

Remarque : Une version gratuite d'AIOSEO est également disponible et possède cette fonctionnalité.

Une fois le plugin installé et activé, vous pouvez l'utiliser pour créer et modifier votre fichier robots.txt directement depuis votre espace d'administration WordPress.

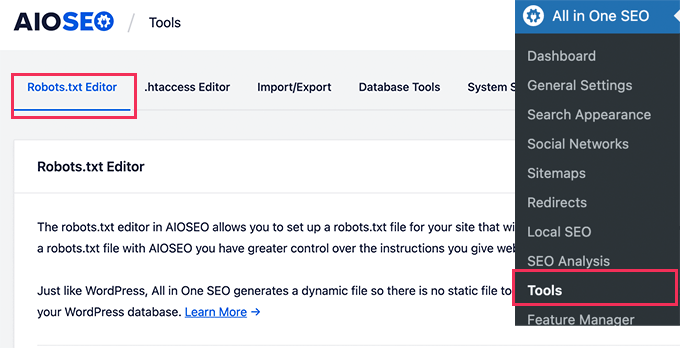

Allez simplement dans Tout-en-un SEO » Outils pour modifier votre fichier robots.txt.

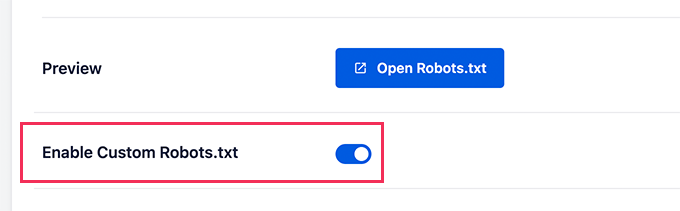

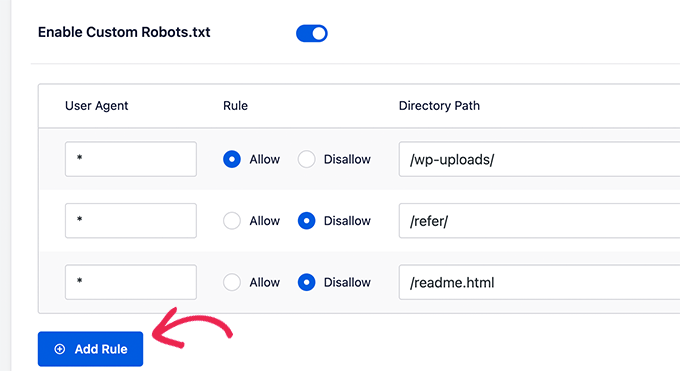

Tout d'abord, vous devrez activer l'option de modification en cliquant sur le bouton « Activer le fichier robots.txt personnalisé » pour qu'il devienne bleu.

Avec ce bouton activé, vous pouvez créer un fichier robots.txt personnalisé dans WordPress.

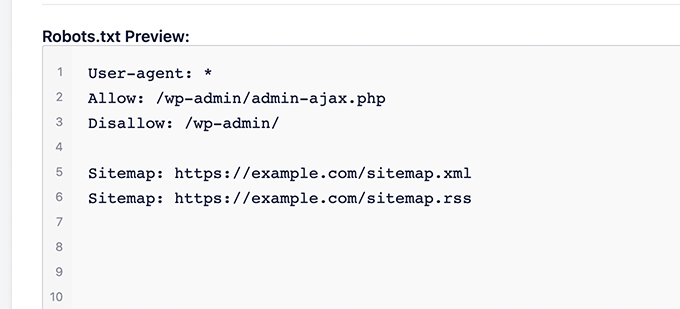

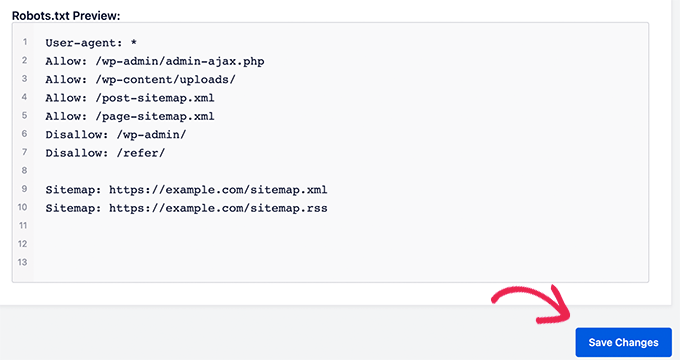

Tout-en-un SEO affichera votre fichier robots.txt existant dans la section « Aperçu du fichier robots.txt » en bas de votre écran.

Cette version affichera les règles par défaut qui ont été ajoutées par WordPress.

Ces règles par défaut indiquent aux moteurs de recherche de ne pas explorer vos fichiers WordPress principaux, autorisent les robots à indexer tout le contenu et leur fournissent un lien vers les sitemaps XML de votre site.

Vous pouvez maintenant ajouter vos propres règles personnalisées pour améliorer votre fichier robots.txt pour le SEO.

Pour ajouter une règle, entrez un agent utilisateur dans le champ « Agent utilisateur ». L'utilisation d'un * appliquera la règle à tous les agents utilisateurs.

Ensuite, sélectionnez si vous souhaitez « Autoriser » ou « Interdire » aux moteurs de recherche d'explorer.

Ensuite, entrez le nom du fichier ou le chemin du répertoire dans le champ « Chemin du répertoire ».

La règle sera automatiquement appliquée à votre fichier robots.txt. Pour ajouter une autre règle, cliquez simplement sur le bouton « Ajouter une règle ».

Nous vous recommandons d'ajouter des règles jusqu'à ce que vous créiez le format idéal de fichier robots.txt que nous avons partagé ci-dessus.

Vos règles personnalisées ressembleront à ceci.

Une fois que vous avez terminé, n'oubliez pas de cliquer sur le bouton « Enregistrer les modifications » pour sauvegarder vos changements.

Méthode 2 : Modifier le fichier Robots.txt à l'aide de WPCode

WPCode est un puissant plugin de snippets de code qui vous permet d'ajouter facilement et en toute sécurité du code personnalisé à votre site web.

Il comprend également une fonctionnalité pratique qui vous permet de modifier rapidement le fichier robots.txt.

Note : Il existe également un plugin gratuit WPCode, mais il n'inclut pas la fonctionnalité d'éditeur de fichiers.

La première chose à faire est d'installer le plugin WPCode. Pour des instructions étape par étape, consultez notre guide pour débutants sur comment installer un plugin WordPress.

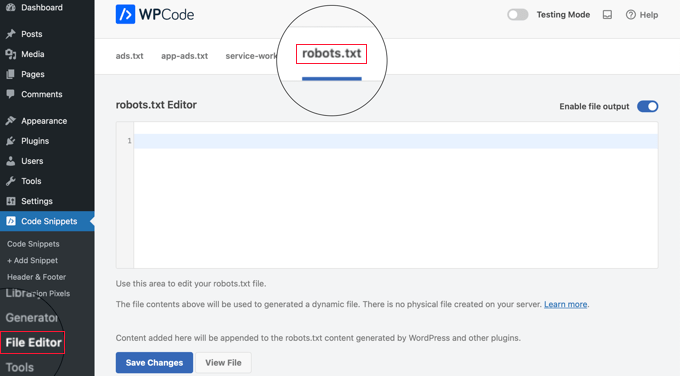

Lors de l'activation, vous devez accéder à la page WPCode » Éditeur de fichiers. Une fois sur place, cliquez simplement sur l'onglet « robots.txt » pour modifier le fichier.

Vous pouvez maintenant coller ou taper le contenu du fichier robots.txt.

Une fois que vous avez terminé, assurez-vous de cliquer sur le bouton « Enregistrer les modifications » en bas de la page pour stocker les paramètres.

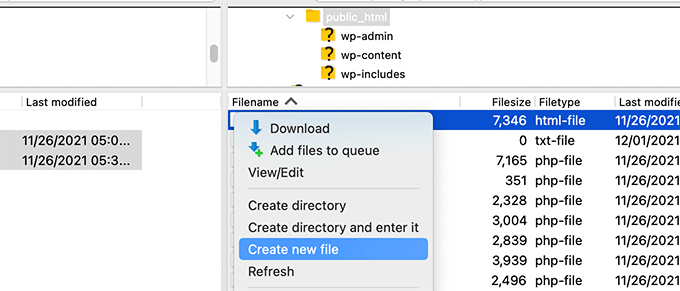

Méthode 3 : Modification manuelle du fichier Robots.txt via FTP

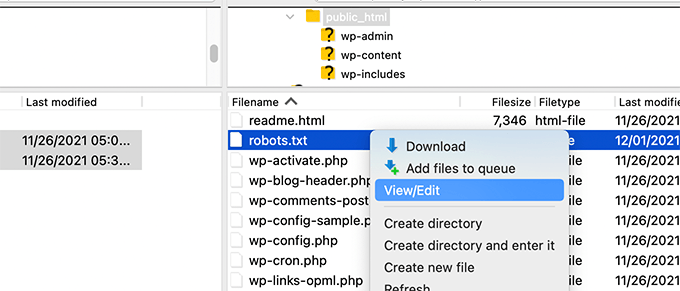

Pour cette méthode, vous devrez utiliser un client FTP pour modifier le fichier robots.txt. Alternativement, vous pouvez utiliser le gestionnaire de fichiers fourni par votre hébergement WordPress.

Astuce de pro : Avant de modifier, nous vous recommandons de télécharger une copie de sauvegarde de votre fichier robots.txt d'origine (s'il existe) sur votre ordinateur. Ainsi, vous pourrez facilement le réimporter si quelque chose tourne mal.

Connectez-vous simplement aux fichiers de votre site Web WordPress à l'aide d'un client FTP.

Une fois à l'intérieur, vous pourrez voir le fichier robots.txt dans le dossier racine de votre site Web.

Si vous n'en voyez pas, il est probable que vous n'ayez pas de fichier robots.txt.

Dans ce cas, vous pouvez simplement continuer et en créer un.

Robots.txt est un fichier texte brut, ce qui signifie que vous pouvez le télécharger sur votre ordinateur et le modifier à l'aide de n'importe quel éditeur de texte brut comme le Bloc-notes ou TextEdit.

Après avoir enregistré vos modifications, vous pouvez téléverser le fichier robots.txt dans le dossier racine de votre site Web.

Comment tester votre fichier Robots.txt

Après avoir créé ou modifié votre fichier robots.txt, il est fortement recommandé de vérifier s'il contient des erreurs. Une petite faute de frappe pourrait accidentellement bloquer des pages importantes pour les moteurs de recherche, donc cette étape est très importante ! 👍

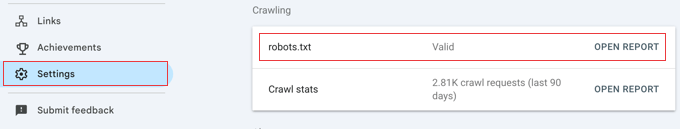

Bien que Google ait eu un outil de test dédié, ils ont maintenant intégré cette fonctionnalité dans les rapports principaux de Google Search Console.

Tout d'abord, assurez-vous que votre site est connecté à Google Search Console. Si vous ne l'avez pas encore fait, suivez simplement notre guide simple sur comment ajouter votre site WordPress à Google Search Console.

Une fois que vous êtes configuré, accédez à votre tableau de bord Google Search Console. Naviguez vers Paramètres dans le menu en bas à gauche.

Ensuite, trouvez la section « Exploration » et cliquez sur « Ouvrir le rapport » à côté de « robots.txt ».

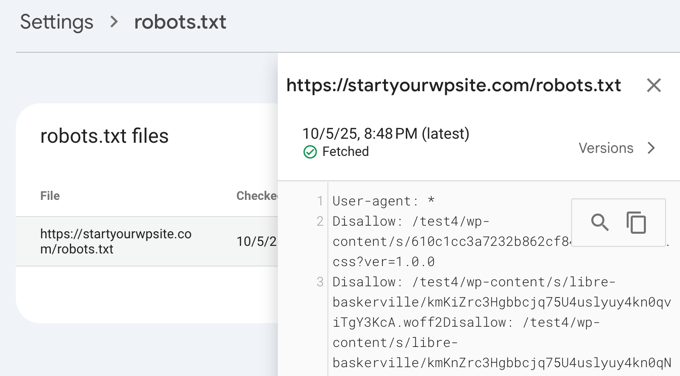

Cliquez simplement sur la version actuelle du fichier dans la liste.

Ce rapport vous montrera la version la plus récente de votre fichier robots.txt que Google a trouvée. Il mettra en évidence toutes les erreurs de syntaxe ou les problèmes logiques qu'il a détectés.

Ne vous inquiétez pas si vous venez de mettre à jour votre fichier et que les modifications n’apparaissent pas immédiatement. Google vérifie automatiquement une nouvelle version de votre fichier robots.txt environ une fois par jour.

Vous pouvez revenir plus tard sur ce rapport pour confirmer que Google a bien pris en compte vos dernières modifications et que tout est en ordre.

Réflexions finales

L'objectif de l'optimisation de votre fichier robots.txt est d'empêcher les moteurs de recherche d'explorer les pages qui ne sont pas publiquement disponibles. Par exemple, les pages de votre dossier wp-plugins ou les pages de votre dossier d'administration WordPress.

Un mythe courant parmi les experts SEO est que le blocage des catégories, des tags et des pages d'archives WordPress améliorera le taux d'exploration et entraînera une indexation plus rapide et des classements plus élevés.

C’est faux. En fait, cette pratique est fortement déconseillée par Google et va à l’encontre de leurs directives de bonnes pratiques pour les aider à comprendre votre site.

Nous vous recommandons de suivre le format robots.txt ci-dessus pour créer un fichier robots.txt pour votre site Web.

Questions fréquemment posées sur robots.txt WordPress

Voici quelques-unes des questions les plus fréquemment posées concernant l’optimisation du fichier robots.txt dans WordPress.

1. Quel est le but principal d’un fichier robots.txt ?

Le but principal d’un fichier robots.txt est de gérer le budget d’exploration de votre site web. En indiquant aux moteurs de recherche quelles pages ignorer (comme les pages d’administration ou les fichiers de plugins), vous les aidez à dépenser leurs ressources pour explorer et indexer votre contenu le plus important plus efficacement.

2. Où se trouve le fichier robots.txt dans WordPress ?

Votre fichier robots.txt se trouve dans le répertoire racine de votre site web. Vous pouvez généralement le consulter en accédant à votredomaine.com/robots.txt dans votre navigateur web.

3. L’utilisation de robots.txt peut-elle améliorer la sécurité de mon site ?

Non, le fichier robots.txt n’est pas une mesure de sécurité. Le fichier est visible publiquement, il n’empêche donc personne d’accéder aux URL que vous listez. Il fournit simplement des directives aux robots d’exploration des moteurs de recherche bien élevés.

4. Dois-je bloquer les pages de catégories et d’étiquettes de WordPress dans robots.txt ?

Non, vous ne devriez pas bloquer les pages de catégories et d’étiquettes. Ces pages d’archives sont utiles pour le SEO car elles aident les moteurs de recherche à comprendre la structure de votre site et à découvrir votre contenu. Les bloquer peut avoir un impact négatif sur votre classement dans les moteurs de recherche.

Ressources supplémentaires sur l'utilisation de robots.txt dans WordPress

Maintenant que vous savez comment optimiser votre fichier robots.txt, vous aimerez peut-être consulter d'autres articles liés à l'utilisation de robots.txt dans WordPress.

- Glossaire : Robots.txt

- Comment masquer une page WordPress de Google

- Comment empêcher les moteurs de recherche d'explorer un site WordPress

- Comment supprimer définitivement un site WordPress d'Internet

- Comment masquer facilement (Noindex) les fichiers PDF dans WordPress

- Comment résoudre l'erreur « Googlebot ne peut pas accéder aux fichiers CSS et JS » dans WordPress

- Qu'est-ce que llms.txt ? Comment ajouter llms.txt dans WordPress

- Comment configurer correctement All in One SEO pour WordPress (Guide ultime)

Nous espérons que cet article vous a aidé à apprendre comment optimiser votre fichier robots.txt WordPress pour le SEO. Vous voudrez peut-être aussi consulter notre guide ultime du SEO WordPress et nos meilleurs choix pour les meilleurs outils SEO WordPress pour développer votre site web.

Si cet article vous a plu, abonnez-vous à notre chaîne YouTube pour des tutoriels vidéo WordPress. Vous pouvez également nous retrouver sur Twitter et Facebook.

Steve

Merci pour cela – comment cela fonctionne-t-il sur un WP Multisite cependant ?

Support WPBeginner

Pour un multisite, vous auriez besoin d'un fichier robots.txt dans le dossier racine de chaque site.

Admin

Pacifique Ndanyuzwe

Mon site wordpress est nouveau et mon robot.txt par défaut est

user-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

Je veux que Google explore et indexe mon contenu. Est-ce que ce robot.txt est correct ?

Support WPBeginner

Vous pouvez certainement l'utiliser si vous le souhaitez

Admin

Ritesh Seth

Super article…

J'étais confus depuis tant de jours à propos du fichier Robots.txt et des liens Disallow. J'ai copié les balises pour le fichier robots. J'espère que cela résoudra le problème de mon site

Support WPBeginner

We hope our article will help as well

Admin

Kurt

Les fichiers dans les captures d'écran de votre dossier personnel se trouvent en fait dans le dossier public_html sous mon dossier personnel.

Je n'avais pas de dossier /refer sous mon dossier public_html.

Je n'avais pas de fichiers xml de publication ou de page nulle part sur mon compte WP.

J'ai inclus une entrée dans le fichier robots.txt que j'ai créé pour interdire l'exploration de mon site sandbox. Je ne suis pas sûr que ce soit nécessaire puisque j'ai déjà sélectionné l'option dans WP indiquant aux robots de ne pas explorer mon site sandbox, mais je ne pense pas que cela nuise d'avoir l'entrée.

Support WPBeginner

Some hosts do rename public_html to home which is why you see it there. You would want to ensure Yoast is active for the XML files to be available. The method in this article is an additional precaution to help with preventing crawling your site

Admin

Ahmed

Super article

Support WPBeginner

Thank you

Admin

ASHOK KUMAR JADON

Bonjour, quel bel article vous avez résolu mon problème. Alors merci beaucoup

Support WPBeginner

Glad our article could help

Admin

Elyn Ashton

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php <– C'est mon code robot.txt mais je suis confus pourquoi mon /wp-admin est indexé ? Comment ne pas l'indexer ?

Support WPBeginner

S'il a été indexé précédemment, vous devrez peut-être laisser le temps à la mémoire cache du moteur de recherche de se vider

Admin

Ashish kumar

Ce site web m'inspire vraiment à commencer un blog. Merci beaucoup à l'équipe. Ce site web, chaque article est riche en informations et explications. Quand j'ai un problème, je visite d'abord ce blog. Merci

Support WPBeginner

Glad our articles can be helpful

Admin

Anna

J'essaie d'optimiser les robots pour mon site web en utilisant Yoast. Cependant, les outils dans Yoast n'ont pas l'option « Éditeur de fichiers ». Il n'y a que deux options (i) Importer et exporter (ii) Éditeur en masse. Pouvez-vous s'il vous plaît me conseiller sur la façon de résoudre ce problème. Est-ce que je suis sur une édition gratuite de Yoast ?

Support WPBeginner

La version gratuite de Yoast a toujours l'option, votre installation peut interdire la modification de fichiers auquel cas vous auriez probablement besoin d'utiliser la méthode FTP.

Admin

Emmanuel Husseni

Je trouve cet article vraiment utile car je ne sais pas grand-chose sur le fonctionnement de robot.txt mais maintenant je le sais.

S'il vous plaît, ce que je ne comprends pas, c'est comment trouver le meilleur format de robot.txt à utiliser sur mon site (je veux dire un qui fonctionne généralement) ?

J'ai remarqué que de nombreux grands blogs que je consulte et qui se classent bien dans les moteurs de recherche utilisent différents formats de robot.txt...

Je serais ravi de voir une réponse de votre part ou de quiconque peut aider.

Personnel éditorial

Avoir un sitemap et autoriser les zones qui doivent être autorisées est la partie la plus importante. La partie interdire variera en fonction de chaque site. Nous avons partagé un exemple dans notre article de blog, et cela devrait convenir à la plupart des sites WordPress.

Admin

Support WPBeginner

Salut Emmanuel,

Veuillez consulter la section concernant le fichier robots.txt idéal. Cela dépend de vos propres exigences. La plupart des blogueurs excluent les dossiers d'administration et de plugins WordPress du crawl.

Admin

Emmanuel Husseni

Merci beaucoup.

maintenant je comprends. Je suppose que je vais commencer avec le format général pour l'instant.

jack

Article bien écrit, je recommande aux utilisateurs de faire un sitemap avant de créer et d'activer leur texte ROBOTS, cela aidera votre site à être exploré plus rapidement et indexé facilement.

Jack

Connie S Owens

Je voudrais empêcher les moteurs de recherche d'indexer mes archives lors de leur exploration.

Emmanuel Nonye

Merci beaucoup, cet article a été vraiment utile.

Cherisa

Je reçois continuellement le message d'erreur ci-dessous sur Google Webmaster. Je suis bloqué. Quelques points qui n'étaient pas clairs pour moi dans ce tutoriel sont : où trouver les fichiers racine de mon site, comment déterminer si j'ai déjà un fichier « robots.txt » et comment le modifier ?

Support WPBeginner

Bonjour Cherisa,

Le dossier racine de votre site est celui qui contient des dossiers comme wp-admin, wp-includes, wp-content, etc. Il contient également des fichiers comme wp-config.php, wp-cron.php, wp-blogheader.php, etc.

Si vous ne voyez pas de fichier robots.txt dans ce dossier, alors vous n'en avez pas. Vous pouvez y aller et en créer un nouveau.

Admin

Cherisa

Merci pour votre réponse. J'ai cherché partout et je n'arrive pas à trouver ces fichiers racines comme vous le décrivez. Y a-t-il un répertoire de chemin que je peux suivre pour accéder à ce dossier. Comme s'il se trouve sous Paramètres, etc. ?

Devender

J'ai eu un trafic web décent sur mon site web. Il a soudainement chuté à zéro au mois de mai. Jusqu'à présent, je rencontre le problème. S'il vous plaît, aidez-moi à récupérer mon site web.

Haris Aslam

Bonjour, merci pour cette information, mais j'ai une question.

J'ai créé le fichier sitemap.xml et robots.txt, et il est bien exploré. Mais comment puis-je créer "Product-Sitemap.xml" ?

Il y a toute la liste des produits dans le fichier sitemap.xml. Dois-je créer Product-sitemap.xml séparément ?

et le soumettre à nouveau à Google ou Bing ?

Pouvez-vous m'aider s'il vous plaît...

Merci

Mahadi Hassan

J'ai un problème avec le réglage du fichier robots.txt. Un seul robots.txt s'affiche pour tous les sites web. S'il vous plaît, aidez-moi à afficher un fichier robots.txt séparé pour tous les sites web. J'ai tous les fichiers robots.txt séparés pour chaque site web individuel. Mais un seul fichier robots.txt s'affiche dans le navigateur pour tous les sites web.

Debu Majumdar

Veuillez expliquer pourquoi vous avez inclus

Disallow: /refer/

dans l'exemple de Robots.txt pour débutants ? Je ne comprends pas les implications de cette ligne. Est-ce important pour un débutant ? Vous avez expliqué les deux autres lignes refusées.

Merci.

Support WPBeginner

Salut Debu,

Cet exemple provient du fichier robots.txt de WPBeginner. Chez WPBeginner, nous utilisons ThirstyAffiliates pour gérer les liens d'affiliation et masquer les URL. Ces URL contiennent /refer/, c'est pourquoi nous les bloquons dans notre fichier robots.txt.

Admin

Evaristo

Comment puis-je mettre toutes les balises/mondomaine.Com en nofollow ? Dans robots.txt pour concentrer le jus de lien ? Merci.

harsh kumar

salut,, j'ai une erreur dans yoast seo concernant le plan du site.. une fois que je clique sur corriger,,, ça revient encore.. le html de mon site ne se charge pas correctement

Tom

Je viens de consulter mon compte Google Webmaster Tools et en utilisant la Search Console, j'ai trouvé ce qui suit :

Page partiellement chargée

Toutes les ressources de la page n'ont pas pu être chargées. Cela peut affecter la façon dont Google voit et comprend votre page. Corrigez les problèmes de disponibilité pour toutes les ressources qui peuvent affecter la façon dont Google comprend votre page.

C'est parce que toutes les feuilles de style CSS associées aux plugins sont interdites par le fichier robots.txt par défaut.

Je comprends les bonnes raisons pour lesquelles je ne devrais pas simplement autoriser cela, mais quelle serait une alternative car je suspecterais que les algorithmes de Google pénalisent le site parce qu'ils ne les voient pas.

Suren

Bonjour,

Lorsque je recherche mon site sur Google, ce texte apparaît sous le lien : « Une description de ce résultat n'est pas disponible en raison du fichier robots.txt de ce site »

Comment puis-je résoudre ce problème ?

Cordialement

Support WPBeginner

Salut Suren,

Il semble que quelqu'un ait accidentellement modifié les paramètres de confidentialité de votre site. Allez dans Paramètres » Page Lecture et faites défiler jusqu'à la section « Visibilité pour les moteurs de recherche ». Assurez-vous que la case à côté de est décochée.

Admin

Divyesh

Bonjour

Comme je l'ai vu dans l'outil pour les webmasters, j'ai un fichier robot.txt comme suit :

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

Dites-moi si c'est correct ? Ou dois-je utiliser autre chose ?

John Cester

Je voudrais savoir s'il est judicieux de bloquer (interdire) « /wp-content/plugins/ » dans robots.tx ? Chaque fois que je supprime un plugin, une erreur 404 s'affiche sur certaines pages de ce plugin.

Himanshu singh

J'ai adoré cette explication. En tant que débutant, j'étais très confus au sujet du fichier robot.txt et de ses utilisations. Mais maintenant, je sais quel est son but.

rahul

dans certains fichiers robot.txt, index.php a été interdit. Pouvez-vous expliquer pourquoi ? est-ce une bonne pratique.

Waleed Barakat

Merci d'être passé pour ces précieuses informations.

Awais Ahmed

Pouvez-vous me dire pourquoi cela se produit dans l'outil pour les webmasters :

Réseau inaccessible : robots.txt inaccessibleNous n'avons pas pu explorer votre sitemap car nous avons trouvé un fichier robots.txt à la racine de votre site mais nous n'avons pas pu le télécharger. Veuillez vous assurer qu'il est accessible ou supprimez-le complètement.

le fichier robots.txt existe mais toujours

Dozza

Mise à jour intéressante de l'équipe Yoast à ce sujet sur

Citation : « Les anciennes bonnes pratiques consistant à avoir un robots.txt qui bloque l'accès à votre répertoire wp-includes et à votre répertoire de plugins ne sont plus valides. »

natveimaging

Autoriser : /wp-content/uploads/

Ne devrait-ce pas être ?

Disallow: /wp-content/uploads/

Parce que vous êtes conscient que Google indexera toutes vos pages de téléchargement en tant qu'URL publiques, n'est-ce pas ? Et ensuite, vous recevrez des erreurs pour la page elle-même. Y a-t-il quelque chose que je manque ici ?

nativeimaging

Dans l'ensemble, ce sont les pages réelles que Google explore pour générer des cartes d'images, PAS les dossiers de téléchargement. Ensuite, vous auriez un problème avec toutes les petites tailles d'images et d'autres images destinées à l'interface utilisateur qui seraient également indexées.

Cela semble être la meilleure option :

Disallow: /wp-content/uploads/

Si je me trompe, veuillez m'expliquer cela afin que je puisse comprendre votre point de vue.

Jason

Mon URL de blog n'est pas indexée, dois-je changer mon robots.txt ?

J'utilise ce robots.txt

iyan

comment créer un fichier robot txt qui autorise UNIQUEMENT l'indexation des pages et des articles.. merci

Simaran Singh

Je ne suis pas sûr de quel est le problème, mais mon robots.txt a deux versions.

Une à http://www.example.com/robots.txt et une seconde à example.com/robots.txt

Quelqu'un peut m'aider, s'il vous plaît ! Dites-moi quelle peut être la cause possible et comment la corriger ?

Support WPBeginner

Très probablement, votre hébergeur permet d'accéder à votre site avec les deux URL www et non-www. Essayez de modifier robots.txt à l'aide d'un client FTP. Examinez-le ensuite à partir des deux URL si vous pouvez voir vos modifications sur les deux URL, cela signifie que c'est le même fichier.

Admin

Simaran Singh

Merci pour la réponse rapide. Je l'ai déjà fait, mais je ne vois aucun changement. Y a-t-il un autre moyen de résoudre ce problème ?

Martin conde

Yoasts blogpost about this topic was right above yours in my search so of course I checked them both. They are contradicting each other a little bit.. For example yoast said that disallowing plugin directories and others, might hinder the Google crawlers when fetching your site since plugins may output css or js. Also mentioned (and from my own experience), yoast doesn’t add anything sitemap related to the robots.txt, rather generates it so that you can add it to your search console. Here is the link to his post, maybe you can re-check because it is very hard to choose whose word to take for it

MM Nauman

Comme je ne suis pas doué pour créer ce fichier Robotstxt, puis-je utiliser votre fichier Robots.txt en modifiant les paramètres comme l'URL et le sitemap de mon site, est-ce bien ? ou devrais-je en créer un différent

Mohit Chauhan

Bonjour,

Aujourd'hui, j'ai reçu cet e-mail de Google : « Googlebot ne peut pas accéder aux fichiers CSS et JS »… quelle peut être la solution ?

Merci

Parmod

Laissez-moi deviner… Vous utilisez des services CDN pour importer des fichiers CSS et JS.

ou

Il est possible que vous ayez écrit une syntaxe incorrecte dans ces fichiers.

Rahul

J'ai une question sur l'ajout de sitemaps. Comment puis-je ajouter les sitemaps Yahoo et Bing au fichier Robots et au répertoire WordPress ?

Gerbrand Petersen

Merci pour le plan détaillé de l'utilisation du fichier robots.txt. Quelqu'un sait-il si Yahoo utilise également ce robots.txt, et s'il respecte les règles mentionnées dans le fichier ? Je pose cette question car j'ai un « Disallow » pour une certaine page dans mon fichier, mais je reçois du trafic venant de Yahoo sur cette page. Rien de Google, comme il se doit. Merci d'avance.

Erwin

correction…

« Si vous utilisez le plugin Yoast’s WordPress SEO ou un autre plugin pour générer votre sitemap XML, alors votre plugin essaiera d'ajouter automatiquement les lignes relatives à votre sitemap dans le fichier robots.txt. »

Pas vrai. WordPress SEO n'ajoute pas le sitemap au robots.txt

« J'ai toujours pensé que lier votre sitemap XML depuis votre robots.txt était un peu absurde. Vous devriez les ajouter manuellement à vos Google et Bing Webmaster Tools et vous assurer de consulter leurs commentaires sur votre sitemap XML. C'est la raison pour laquelle notre plugin WordPress SEO ne l'ajoute pas à votre robots.txt. »

https://yoast.com/wordpress-robots-txt-example/

Il est également plus recommandé de ne pas interdire le répertoire wp-plugins (voir les raisons dans l'article de Yoast)

Et personnellement, j'aime simplement supprimer le fichier readme.txt...

hyma

J'ai compris le fichier robots.txt et son utilisation. Qu'est-ce que le sitemap et comment puis-je créer un sitemap pour mon site ?

Rick R. Duncan

Après avoir lu la documentation de Google, j'ai l'impression que la directive à utiliser dans le fichier robots.txt est disallow, qui indique seulement aux bots ce qu'ils peuvent et ne peuvent pas explorer. Cela ne leur dit pas ce qui peut et ne peut pas être indexé. Vous devez utiliser la balise meta robots noindex pour qu'une page ne soit pas indexée.

Nitin

article vraiment bon pour un fichier robots.txt optimisé pour le SEO. Mais j'ai besoin que vous donniez un tutoriel sur la façon de téléverser un fichier robots.txt sur un serveur. En tant que débutant, cela semble être un problème majeur de téléverser ce fichier.

Au fait, merci d'avoir partagé des informations si bénéfiques.

-Nitin

Parmod

Téléchargez-le sur votre serveur/public_hmtl/(Votre-nom-de-site)... dans ce dossier

Jenny

Quelle est la meilleure façon d'ajouter du code à HTTacess pour bloquer plusieurs referrers de bots spam pour leur URL et leur adresse IP s'il n'y a pas d'URL donnée ?

Je sais que si vous avez une syntaxe incorrecte lors de la modification de httacess, cela peut mettre votre site hors ligne. Je suis un débutant et j'ai besoin de bloquer ces multiples URL ennuyeuses de Russie, de Chine, d'Ukraine, etc.

Merci beaucoup

Hazel Andrews

Merci pour ces conseils... les fichiers robot txt sont maintenant modifiés ! youpi !

Rahat

pourquoi faut-il ajouter Allow: !!!

si je mentionne seulement ce qui doit être Disallow, c'est suffisant. Je n'ai pas besoin d'écrire de code pour Allow car Googlebot ou Bingbot exploreront automatiquement tout le reste.

Alors pourquoi devrais-je utiliser à nouveau Allow ?

Connor Rickett

Puisque l'absence du fichier Robots.txt n'empêche pas le site d'être exploré, je suis curieux : existe-t-il des données concrètes sur la façon dont la présence du fichier améliore les performances SEO ?

J'ai fait une recherche rapide sur Google et je n'ai pas trouvé de données quantitatives à ce sujet. Il y a environ un demi-million d'articles disant : « Hé, cela améliore le SEO ! », mais j'aimerais vraiment savoir de quoi nous parlons ici, même de manière générale.

Est-ce une amélioration de 5 % ? 50 ? 500 ?

Support WPBeginner

Les moteurs de recherche ne partagent pas de telles données. Bien que l'absence d'un fichier robots.txt n'empêche pas les moteurs de recherche d'explorer ou d'indexer un site web. Cependant, c'est une bonne pratique recommandée.

Admin

Connor Rickett

Merci d'avoir pris le temps de me répondre, j'apprécie !

JD Myers

Bon timing pour cela. J'essayais de trouver cette information hier.

La raison pour laquelle je la cherchais est que les outils Google Webmaster me disaient qu'ils ne pouvaient pas explorer correctement mon site car je bloquais diverses ressources nécessaires au bon rendu de la page.

Ces ressources comprenaient celles trouvées dans /wp-content/plugins/

Après avoir autorisé ce dossier, l'avertissement a disparu.

Des idées à ce sujet ?

Support WPBeginner

Vous pouvez ignorer ces avertissements en toute sécurité. Ce n'est qu'un avertissement si vous aviez réellement du contenu que vous souhaiteriez indexer. Parfois, les utilisateurs ont restreint les robots de recherche et l'ont oublié. Ces avertissements sont utiles dans ces situations.

Admin

Chetan jadhav

J'ai une question : beaucoup de gens utilisent un sitemap statique, et vous savez qu'ils ont un site WordPress. Devrions-nous utiliser un sitemap statique ou un sitemap généré par WordPress ?

Wilton Calderon

Sympa, j'aime la façon dont Wpbeginner le fait, et avec ce classement Alexa, cela me semble être la meilleure façon d'utiliser robots.txt...

Brigitte Burke

Que signifie mon fichier robots.txt s'il ressemble à ceci ?

User-agent: *

Disallow: /wp-admin/

Disallow: /wp-includes/

Disallow: /xmlrpc.php

Personnel éditorial

Cela indique simplement que les moteurs de recherche ne doivent pas indexer votre dossier wp-admin, votre dossier wp-includes et le fichier xml-rpc. Parfois, interdire /wp-includes/ peut bloquer certains scripts pour les moteurs de recherche, surtout si votre site utilise ces scripts. Cela peut nuire à votre SEO.

La meilleure chose à faire est d'aller sur Google Webmaster Tools et de récupérer votre site web en tant que bot. Si tout se charge correctement, vous n'avez rien à craindre. S'il indique que des scripts sont bloqués, vous voudrez peut-être supprimer la ligne wp-includes.

Admin

hercules

Je ne vois aucune logique dans votre idée d'avoir un script dans le répertoire includes qui puisse être utilisé par un robot d'exploration / robot... et d'autre part, s'il y a un cas isolé, il est préférable après avoir spécifié le défaut WordPress autorise ce fichier que vous imaginez que les moteurs de recherche utilisent ses scripts ! après tout, WordPress n'a certainement pas par défaut un robots.txt anti-moteurs de recherche !!!!