C'est un sentiment de désespoir lorsque vous réalisez qu'un petit fichier texte négligé pourrait saboter silencieusement le référencement de votre site Web. De nombreux propriétaires de sites ne réalisent pas qu'une simple erreur dans leur fichier robots.txt peut empêcher Google de trouver leur contenu le plus important.

Après avoir audité des milliers de sites WordPress, nous avons vu cela se produire plus de fois que nous ne pouvons le compter. La bonne nouvelle est que le corriger est plus facile que vous ne le pensez.

Dans ce guide, nous vous présenterons les étapes exactes et éprouvées que nous utilisons pour optimiser un fichier robots.txt WordPress. Vous apprendrez comment le faire correctement et vous assurer que les moteurs de recherche explorent votre site efficacement.

Vous vous sentez dépassé ? Voici un aperçu rapide de tout ce que nous aborderons dans ce guide. N'hésitez pas à passer à la section qui vous intéresse le plus.

- Qu'est-ce qu'un fichier robots.txt ?

- Avez-vous besoin d'un fichier robots.txt pour votre site WordPress ?

- À quoi ressemble un fichier robots.txt idéal ?

- Comment créer un fichier Robots.txt dans WordPress

- Comment tester votre fichier Robots.txt

- Réflexions finales

- Questions fréquemment posées sur robots.txt WordPress

- Ressources supplémentaires sur l'utilisation de robots.txt dans WordPress

Qu'est-ce qu'un fichier robots.txt ?

Robots.txt est un fichier texte que les propriétaires de sites Web peuvent créer pour indiquer aux robots des moteurs de recherche comment explorer et indexer les pages de leurs sites.

Il est généralement stocké dans le répertoire racine (également appelé dossier principal) de votre site Web. Le format de base d'un fichier robots.txt ressemble à ceci :

User-agent: [user-agent name]

Disallow: [URL string not to be crawled]

User-agent: [user-agent name]

Allow: [URL string to be crawled]

Sitemap: [URL of your XML Sitemap]

Vous pouvez avoir plusieurs lignes d'instructions pour autoriser ou interdire des URL spécifiques et ajouter plusieurs sitemaps. Si vous n'interdisez pas une URL, les robots des moteurs de recherche supposent qu'ils sont autorisés à l'explorer.

Voici à quoi peut ressembler un exemple de fichier robots.txt :

User-Agent: *

Allow: /wp-content/uploads/

Disallow: /wp-content/plugins/

Disallow: /wp-admin/

Sitemap: https://example.com/sitemap_index.xml

Dans l'exemple de robots.txt ci-dessus, nous avons autorisé les moteurs de recherche à explorer et à indexer les fichiers de notre dossier de téléchargements WordPress.

Après cela, nous avons interdit aux robots d'exploration d'explorer et d'indexer les plugins et les dossiers d'administration de WordPress.

Enfin, nous avons fourni l'URL de notre sitemap XML.

Avez-vous besoin d'un fichier robots.txt pour votre site WordPress ?

Bien que votre site puisse fonctionner sans fichier robots.txt, nous avons constamment constaté que les sites dotés de fichiers robots.txt optimisés obtiennent de meilleurs résultats dans les moteurs de recherche.

Grâce à notre travail avec des clients de divers secteurs, nous avons constaté comment une gestion adéquate du budget d'exploration via robots.txt peut conduire à une indexation plus rapide du contenu important et à de meilleures performances SEO globales.

Cela n'aura pas beaucoup d'impact lorsque vous démarrez un blog et que vous n'avez pas beaucoup de contenu.

Cependant, à mesure que votre site Web grandit et que vous ajoutez du contenu, vous voudrez probablement mieux contrôler la manière dont votre site Web est exploré et indexé.

Voici pourquoi.

Les moteurs de recherche allouent ce que Google appelle un « budget d'exploration » à chaque site Web. C'est le nombre de pages qu'ils exploreront dans un délai donné.

Lors de nos tests sur des milliers de sites WordPress, nous avons constaté que les sites plus importants bénéficient particulièrement de l'optimisation de ce budget grâce à une configuration stratégique de robots.txt.

Par exemple, l'un de nos clients d'entreprise a constaté une amélioration de 40 % de l'efficacité de l'exploration après avoir mis en œuvre les optimisations de robots.txt que nous recommandons.

Vous pouvez interdire aux robots de recherche de tenter d'explorer des pages inutiles comme vos pages d'administration WordPress, les fichiers de plugins et le dossier des thèmes.

En interdisant les pages inutiles, vous économisez votre quota d'exploration. Cela aide les moteurs de recherche à explorer encore plus de pages sur votre site et à les indexer le plus rapidement possible.

Une autre bonne raison d'utiliser un fichier robots.txt est lorsque vous souhaitez empêcher les moteurs de recherche d'indexer un article ou une page sur votre site Web.

Cependant, il est important de savoir que robots.txt n'est pas le meilleur moyen de masquer du contenu. Une page interdite peut toujours apparaître dans les résultats de recherche si elle est liée depuis d'autres sites Web.

Si vous souhaitez empêcher de manière fiable qu'une page n'apparaisse sur Google, vous devriez plutôt utiliser une balise méta 'noindex'. Cela indique aux moteurs de recherche de ne pas ajouter la page à leur index du tout.

À quoi ressemble un fichier robots.txt idéal ?

De nombreux blogs populaires utilisent un fichier robots.txt très simple. Leur contenu peut varier en fonction des besoins du site spécifique :

User-agent: *

Disallow:

Sitemap: https://www.example.com/post-sitemap.xml

Sitemap: https://www.example.com/page-sitemap.xml

Ce fichier robots.txt autorise tous les robots à indexer tout le contenu et leur fournit un lien vers les sitemaps XML du site web.

Pour les sites WordPress, nous recommandons les règles suivantes dans le fichier robots.txt :

User-Agent: *

Allow: /wp-content/uploads/

Disallow: /wp-admin/

Disallow: /readme.html

Disallow: /refer/

Sitemap: https://www.example.com/post-sitemap.xml

Sitemap: https://www.example.com/page-sitemap.xml

Cela indique aux robots d'exploration d'indexer toutes vos images et fichiers téléchargés WordPress en utilisant spécifiquement la directive Allow, qui est une commande utile que les moteurs de recherche comme Google comprennent.

Il interdit ensuite aux robots d'exploration d'indexer la zone d'administration de WordPress, le fichier readme.html par défaut (qui peut révéler votre version de WordPress) et les répertoires courants pour les liens d'affiliation masqués comme /refer/.

En ajoutant des sitemaps au fichier robots.txt, vous facilitez la tâche des robots de Google pour trouver toutes les pages de votre site.

Maintenant que vous savez à quoi ressemble un fichier robots.txt idéal, examinons comment vous pouvez créer un fichier robots.txt dans WordPress.

Comment créer un fichier Robots.txt dans WordPress

Il existe deux méthodes pour créer un fichier robots.txt dans WordPress. Vous pouvez choisir celle qui vous convient le mieux.

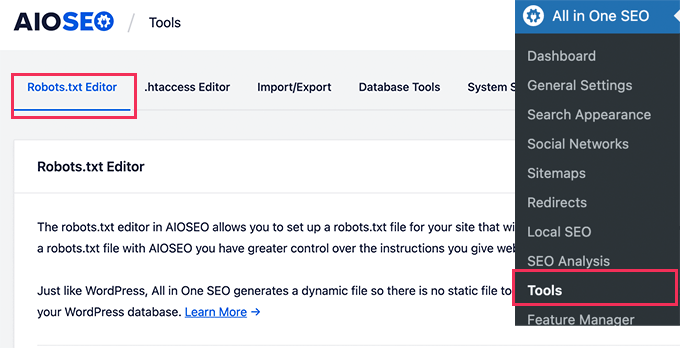

Méthode 1 : Modifier le fichier Robots.txt avec All in One SEO

All in One SEO, également connu sous le nom d'AIOSEO, est le meilleur plugin SEO WordPress du marché, utilisé par plus de 3 millions de sites Web. Il est facile à utiliser et comprend un générateur de fichier robots.txt.

Pour en savoir plus, consultez notre test détaillé d'AIOSEO.

Si vous n'avez pas encore installé le plugin AIOSEO, vous pouvez consulter notre guide étape par étape sur comment installer un plugin WordPress.

Remarque : Une version gratuite d'AIOSEO est également disponible et possède cette fonctionnalité.

Une fois le plugin installé et activé, vous pouvez l'utiliser pour créer et modifier votre fichier robots.txt directement depuis votre espace d'administration WordPress.

Allez simplement dans Tout-en-un SEO » Outils pour modifier votre fichier robots.txt.

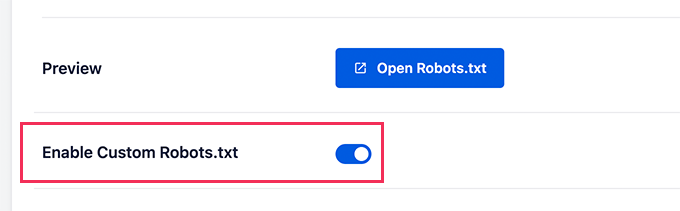

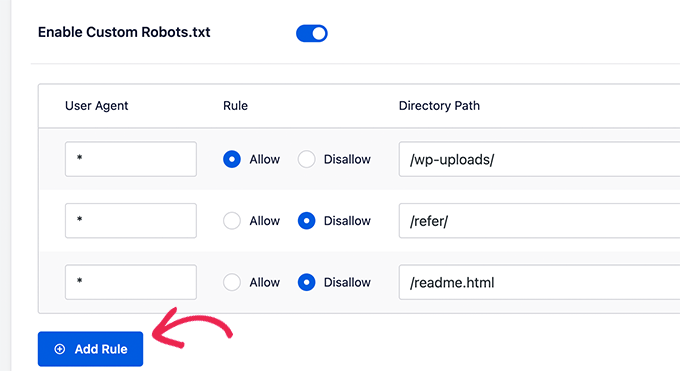

Tout d'abord, vous devrez activer l'option de modification en cliquant sur le bouton « Activer le fichier robots.txt personnalisé » pour qu'il devienne bleu.

Avec ce bouton activé, vous pouvez créer un fichier robots.txt personnalisé dans WordPress.

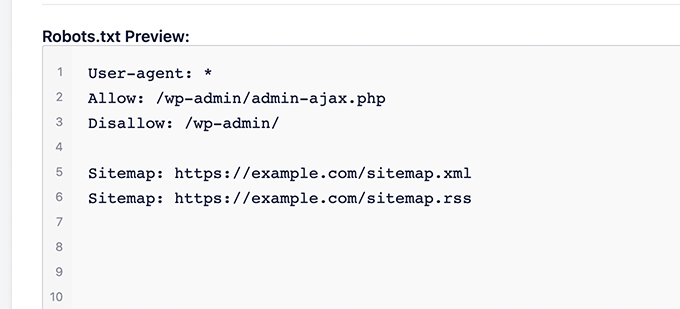

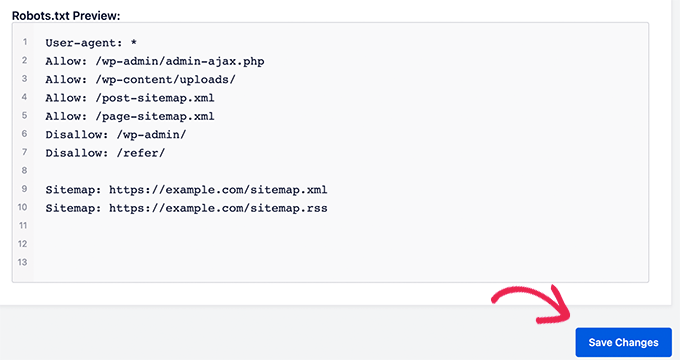

Tout-en-un SEO affichera votre fichier robots.txt existant dans la section « Aperçu du fichier robots.txt » en bas de votre écran.

Cette version affichera les règles par défaut qui ont été ajoutées par WordPress.

Ces règles par défaut indiquent aux moteurs de recherche de ne pas explorer vos fichiers WordPress principaux, autorisent les robots à indexer tout le contenu et leur fournissent un lien vers les sitemaps XML de votre site.

Vous pouvez maintenant ajouter vos propres règles personnalisées pour améliorer votre fichier robots.txt pour le SEO.

Pour ajouter une règle, entrez un agent utilisateur dans le champ « Agent utilisateur ». L'utilisation d'un * appliquera la règle à tous les agents utilisateurs.

Ensuite, sélectionnez si vous souhaitez « Autoriser » ou « Interdire » aux moteurs de recherche d'explorer.

Ensuite, entrez le nom du fichier ou le chemin du répertoire dans le champ « Chemin du répertoire ».

La règle sera automatiquement appliquée à votre fichier robots.txt. Pour ajouter une autre règle, cliquez simplement sur le bouton « Ajouter une règle ».

Nous vous recommandons d'ajouter des règles jusqu'à ce que vous créiez le format idéal de fichier robots.txt que nous avons partagé ci-dessus.

Vos règles personnalisées ressembleront à ceci.

Une fois que vous avez terminé, n'oubliez pas de cliquer sur le bouton « Enregistrer les modifications » pour sauvegarder vos changements.

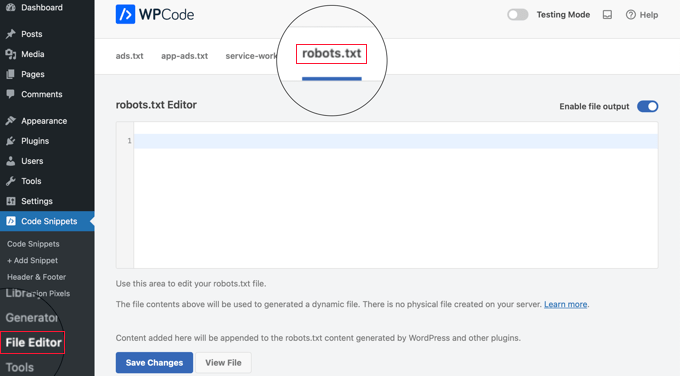

Méthode 2 : Modifier le fichier Robots.txt à l'aide de WPCode

WPCode est un puissant plugin de snippets de code qui vous permet d'ajouter facilement et en toute sécurité du code personnalisé à votre site web.

Il comprend également une fonctionnalité pratique qui vous permet de modifier rapidement le fichier robots.txt.

Note : Il existe également un plugin gratuit WPCode, mais il n'inclut pas la fonctionnalité d'éditeur de fichiers.

La première chose à faire est d'installer le plugin WPCode. Pour des instructions étape par étape, consultez notre guide pour débutants sur comment installer un plugin WordPress.

Lors de l'activation, vous devez accéder à la page WPCode » Éditeur de fichiers. Une fois sur place, cliquez simplement sur l'onglet « robots.txt » pour modifier le fichier.

Vous pouvez maintenant coller ou taper le contenu du fichier robots.txt.

Une fois que vous avez terminé, assurez-vous de cliquer sur le bouton « Enregistrer les modifications » en bas de la page pour stocker les paramètres.

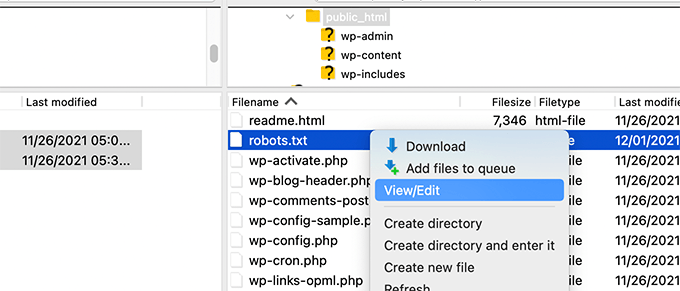

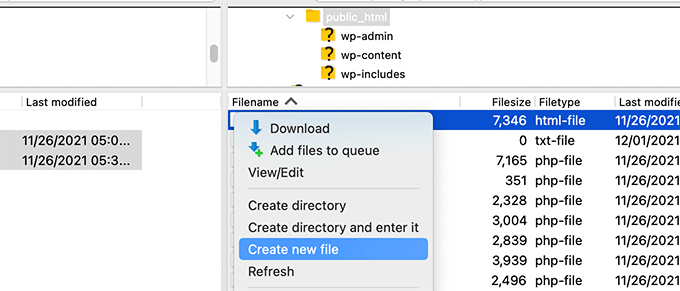

Méthode 3 : Modification manuelle du fichier Robots.txt via FTP

Pour cette méthode, vous devrez utiliser un client FTP pour modifier le fichier robots.txt. Alternativement, vous pouvez utiliser le gestionnaire de fichiers fourni par votre hébergement WordPress.

Astuce de pro : Avant de modifier, nous vous recommandons de télécharger une copie de sauvegarde de votre fichier robots.txt d'origine (s'il existe) sur votre ordinateur. Ainsi, vous pourrez facilement le réimporter si quelque chose tourne mal.

Connectez-vous simplement aux fichiers de votre site Web WordPress à l'aide d'un client FTP.

Une fois à l'intérieur, vous pourrez voir le fichier robots.txt dans le dossier racine de votre site Web.

Si vous n'en voyez pas, il est probable que vous n'ayez pas de fichier robots.txt.

Dans ce cas, vous pouvez simplement continuer et en créer un.

Robots.txt est un fichier texte brut, ce qui signifie que vous pouvez le télécharger sur votre ordinateur et le modifier à l'aide de n'importe quel éditeur de texte brut comme le Bloc-notes ou TextEdit.

Après avoir enregistré vos modifications, vous pouvez téléverser le fichier robots.txt dans le dossier racine de votre site Web.

Comment tester votre fichier Robots.txt

Après avoir créé ou modifié votre fichier robots.txt, il est fortement recommandé de vérifier s'il contient des erreurs. Une petite faute de frappe pourrait accidentellement bloquer des pages importantes pour les moteurs de recherche, donc cette étape est très importante ! 👍

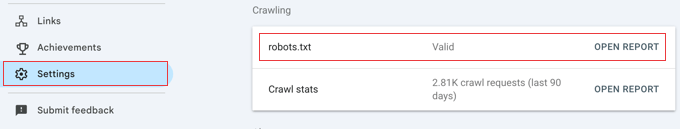

Bien que Google ait eu un outil de test dédié, ils ont maintenant intégré cette fonctionnalité dans les rapports principaux de Google Search Console.

Tout d'abord, assurez-vous que votre site est connecté à Google Search Console. Si vous ne l'avez pas encore fait, suivez simplement notre guide simple sur comment ajouter votre site WordPress à Google Search Console.

Une fois que vous êtes configuré, accédez à votre tableau de bord Google Search Console. Naviguez vers Paramètres dans le menu en bas à gauche.

Ensuite, trouvez la section « Exploration » et cliquez sur « Ouvrir le rapport » à côté de « robots.txt ».

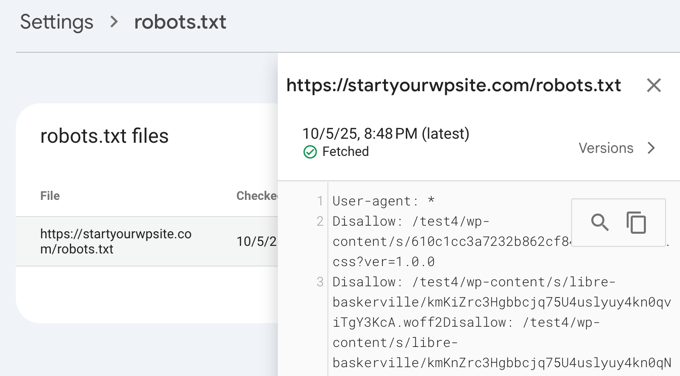

Cliquez simplement sur la version actuelle du fichier dans la liste.

Ce rapport vous montrera la version la plus récente de votre fichier robots.txt que Google a trouvée. Il mettra en évidence toutes les erreurs de syntaxe ou les problèmes logiques qu'il a détectés.

Ne vous inquiétez pas si vous venez de mettre à jour votre fichier et que les modifications n’apparaissent pas immédiatement. Google vérifie automatiquement une nouvelle version de votre fichier robots.txt environ une fois par jour.

Vous pouvez revenir plus tard sur ce rapport pour confirmer que Google a bien pris en compte vos dernières modifications et que tout est en ordre.

Réflexions finales

L'objectif de l'optimisation de votre fichier robots.txt est d'empêcher les moteurs de recherche d'explorer les pages qui ne sont pas publiquement disponibles. Par exemple, les pages de votre dossier wp-plugins ou les pages de votre dossier d'administration WordPress.

Un mythe courant parmi les experts SEO est que le blocage des catégories, des tags et des pages d'archives WordPress améliorera le taux d'exploration et entraînera une indexation plus rapide et des classements plus élevés.

C’est faux. En fait, cette pratique est fortement déconseillée par Google et va à l’encontre de leurs directives de bonnes pratiques pour les aider à comprendre votre site.

Nous vous recommandons de suivre le format robots.txt ci-dessus pour créer un fichier robots.txt pour votre site Web.

Questions fréquemment posées sur robots.txt WordPress

Voici quelques-unes des questions les plus fréquemment posées concernant l’optimisation du fichier robots.txt dans WordPress.

1. Quel est le but principal d’un fichier robots.txt ?

Le but principal d’un fichier robots.txt est de gérer le budget d’exploration de votre site web. En indiquant aux moteurs de recherche quelles pages ignorer (comme les pages d’administration ou les fichiers de plugins), vous les aidez à dépenser leurs ressources pour explorer et indexer votre contenu le plus important plus efficacement.

2. Où se trouve le fichier robots.txt dans WordPress ?

Votre fichier robots.txt se trouve dans le répertoire racine de votre site web. Vous pouvez généralement le consulter en accédant à votredomaine.com/robots.txt dans votre navigateur web.

3. L’utilisation de robots.txt peut-elle améliorer la sécurité de mon site ?

Non, le fichier robots.txt n’est pas une mesure de sécurité. Le fichier est visible publiquement, il n’empêche donc personne d’accéder aux URL que vous listez. Il fournit simplement des directives aux robots d’exploration des moteurs de recherche bien élevés.

4. Dois-je bloquer les pages de catégories et d’étiquettes de WordPress dans robots.txt ?

Non, vous ne devriez pas bloquer les pages de catégories et d’étiquettes. Ces pages d’archives sont utiles pour le SEO car elles aident les moteurs de recherche à comprendre la structure de votre site et à découvrir votre contenu. Les bloquer peut avoir un impact négatif sur votre classement dans les moteurs de recherche.

Ressources supplémentaires sur l'utilisation de robots.txt dans WordPress

Maintenant que vous savez comment optimiser votre fichier robots.txt, vous aimerez peut-être consulter d'autres articles liés à l'utilisation de robots.txt dans WordPress.

- Glossaire : Robots.txt

- Comment masquer une page WordPress de Google

- Comment empêcher les moteurs de recherche d'explorer un site WordPress

- Comment supprimer définitivement un site WordPress d'Internet

- Comment masquer facilement (Noindex) les fichiers PDF dans WordPress

- Comment résoudre l'erreur « Googlebot ne peut pas accéder aux fichiers CSS et JS » dans WordPress

- Qu'est-ce que llms.txt ? Comment ajouter llms.txt dans WordPress

- Comment configurer correctement All in One SEO pour WordPress (Guide ultime)

Nous espérons que cet article vous a aidé à apprendre comment optimiser votre fichier robots.txt WordPress pour le SEO. Vous voudrez peut-être aussi consulter notre guide ultime du SEO WordPress et nos meilleurs choix pour les meilleurs outils SEO WordPress pour développer votre site web.

Si cet article vous a plu, abonnez-vous à notre chaîne YouTube pour des tutoriels vidéo WordPress. Vous pouvez également nous retrouver sur Twitter et Facebook.

Dennis Muthomi

Je dois admettre que j'utilise le plugin AIOSEO mais j'ai toujours ignoré l'option "Activer le fichier robots.txt personnalisé" car je ne voulais rien gâcher.

Mais j'ai lu cet article et je suis convaincu que cela vaut la peine de prendre le temps d'optimiser le fichier robots.txt de mon site.

Amit Banerjee

Si tout le modèle de robots.txt avait été fourni, cela aurait été utile.

Support WPBeginner

We did include the entire robots.txt

Admin

Michael

Je pense que vous devriez modifier votre réponse. Ce devrait être https au lieu de http. Est-il juste de refuser également les fichiers de plugin ?

Support WPBeginner

Merci de l'avoir signalé, notre exemple a été mis à jour. Pour refuser les plugins, vous devriez vérifier auprès du plugin spécifique pour être sûr.

Moinuddin Waheed

Merci pour ce post informatif sur le fichier robots.txt.

Je ne savais pas que les sites web devaient maintenir ce fichier afin de contrôler les robots de Google sur la manière dont ils doivent explorer nos pages et nos posts.

Pour les sites web débutants qui commencent tout juste, est-il nécessaire d'avoir un fichier robots.txt ou existe-t-il un moyen, comme un plugin, qui peut créer un fichier robots.txt pour notre site web ?

Support WPBeginner

La plupart des plugins SEO aident à configurer le robots.txt pour un nouveau site afin d'empêcher les robots d'explorer des sections qu'ils ne devraient pas.

Admin

Jiří Vaněk

Grâce à cet article, j'ai vérifié le fichier robots.txt et ajouté les adresses URL avec les sitemaps. En même temps, j'avais d'autres lignes problématiques là-bas, qui ont été révélées par le validateur. Je ne connaissais pas les sitemaps dans robots.txt jusqu'à présent. Merci.

Support WPBeginner

De rien, heureux que notre guide ait pu vous aider !

Admin

Stéphane

Bonjour,

Merci pour ce post, il devient plus clair comment utiliser le fichier robots.txt. Sur la plupart des sites web que vous trouvez en cherchant des conseils concernant le fichier robots.txt, vous pouvez voir que les dossiers suivants sont explicitement exclus de l'exploration (pour WordPress) :

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

Je ne comprends pas vraiment les raisons d'exclure ces dossiers (y en a-t-il une en fait ?). Quelle serait votre opinion à ce sujet ?

Support WPBeginner

C'est principalement pour empêcher que quoi que ce soit dans ces dossiers n'apparaisse comme résultat lorsque l'utilisateur recherche votre site. Comme ce n'est pas votre contenu, ce n'est pas quelque chose que la plupart des gens voudraient voir apparaître dans les résultats du site.

Admin

zaid haris

Interdire : /wp-admin/

Autoriser : /wp-admin/admin-ajax.php

GSC affiche l'erreur de couverture pour « Disallow: /wp-admin/ ». Est-ce que c'est faux ?

Support WPBeginner

Pour la plupart des sites, vous ne voulez pas que quoi que ce soit de votre wp-admin apparaisse dans les résultats de recherche, il est donc normal et attendu de recevoir une zone de couverture lorsque vous refusez à Google la possibilité d'analyser votre wp-admin.

Admin

Hansini

Je crée mon robots.txt manuellement comme vous l'avez indiqué pour mon site WordPress.

J'ai un doute. quand j'écris User-Agent: * cela n'autorisera-t-il pas un autre robot de spam à accéder à mon site ?

Dois-je écrire User-Agent: * ou User-Agent: Googlebot ?

Support WPBeginner

La ligne User-Agent définit les règles que tous les robots doivent suivre sur votre site. Si vous spécifiez un bot particulier sur cette ligne, vous définissez des règles pour ce bot spécifique et aucun autre.

Admin

Nishant

Que devrions-nous écrire pour que Google indexe mon article ?

Support WPBeginner

Pour que votre site soit répertorié, vous devriez consulter notre article ci-dessous :

https://www.wpbeginner.com/beginners-guide/how-do-i-get-my-wordpress-site-listed-on-google-beginners-guide/

Admin

Sanjeev Pandey

devons-nous également interdire /wp-content/themes/ ?

Il apparaît dans les résultats de recherche lorsque j'exécute la commande site:abcdef.com dans Google Search

Support WPBeginner

Vous ne voudriez pas vous soucier de bloquer votre dossier de thèmes et, comme vous écrivez du contenu optimisé pour le SEO, vous ne devriez plus voir les thèmes comme résultat de recherche.

Admin

Salem

HI, Que signifie "Disallow: /readme.html & Disallow: /refer/" ?

Support WPBeginner

Cela signifie que vous dites aux moteurs de recherche de ne pas regarder les liens de référence ni le fichier readme.html.

Admin

sean

Bonjour, quels sont les avantages et les inconvénients du blocage de wp-content/uploads

Merci

Support WPBeginner

Si vous bloquez votre dossier d'uploads, les moteurs de recherche ne parcourraient normalement pas votre contenu téléchargé comme les images.

Admin

Piyush

merci d'avoir résolu mon problème

Support WPBeginner

You’re welcome

Admin

Ravi kumar

Monsieur, je suis très confus au sujet de robot.txt, j'ai soumis plusieurs fois mon plan de site dans Blogger, mais après 3, 4 jours, le même problème se pose. Qu'est-ce que robot.txt exactement ? & comment le soumettre, s'il vous plaît guidez-moi.

Support WPBeginner

Cela dépendrait de votre problème spécifique, vous pourriez vouloir consulter notre page ci-dessous :

https://www.wpbeginner.com/glossary/robots-txt/

Admin

Prem

Si j'indexe une URL ou une page en utilisant le fichier robots.txt, Google affiche-t-il une erreur dans la Search Console ?

Support WPBeginner

Non, Google n'affichera pas la page, mais si la page est répertoriée, elle n'affichera pas d'erreur.

Admin

Bharat

Bonjour

J'ai une question

Je reçois un avertissement de problème de couverture de Google Search Console pour bloqué par robots.txt

/wp-admin/widgets.php

Ma question est, puis-je autoriser wp-admin/widgets.php dans robots.txt et est-ce sûr ?

Support WPBeginner

Si vous le souhaitez, vous pouvez, mais ce n'est pas un fichier que Google doit explorer.

Admin

Anthony

Bonjour, je me demande si vous devriez autoriser : /wp-admin/admin-ajax.php ?

Support WPBeginner

Normalement, oui, vous devriez.

Admin

Jaira

Puis-je savoir pourquoi vous devriez autoriser /wp-admin/admin-ajax.php ?

Support WPBeginner

Il est utilisé par différents thèmes et plugins pour apparaître correctement pour les moteurs de recherche.

Amila

Bonjour ! J'aime beaucoup cet article et comme je suis débutant avec tout ce qui concerne l'exploration, j'aimerais poser une question à ce sujet. Récemment, Google a exploré et indexé l'un de mes sites web d'une manière vraiment terrible, affichant des pages dans les résultats de recherche qui sont supprimées du site web. Le site web n'avait pas découragé les moteurs de recherche d'indexer dans les paramètres de WordPress au début, mais l'a fait plus tard après que Google ait montré 3 autres pages dans les résultats de recherche (ces pages n'existent pas non plus) et je ne comprends vraiment pas comment cela a pu arriver avec l'option « décourager les moteurs de recherche d'indexer » activée. Alors, la méthode Yoast peut-elle être utile et apporter une solution pour que mon site web soit indexé correctement par Google cette fois-ci ? Merci d'avance !

Support WPBeginner

Le plugin Yoast devrait être en mesure de vous aider à garantir que les pages que vous avez sont correctement indexées, il est possible qu'avant que vous n'ayez découragé les moteurs de recherche d'explorer votre site, votre page ait été mise en cache.

Admin

Amila

Eh bien oui et de toutes les pages, il a mis en cache celles qui n'existent plus. Quoi qu'il en soit, comme la page actuelle est réglée sur « décourager », est-il préférable de la laisser ainsi pour l'instant ou de décocher la case et de laisser Google l'explorer et l'indexer à nouveau avec l'aide de Yoast ? Merci ! Avec vos articles, tout est devenu plus facile !

Support WPBeginner

Vous voudrez que Google ré-explore votre site une fois qu'il sera configuré comme vous le souhaitez.

Pradhuman Kumar

Salut, j'ai adoré l'article, très précis et parfait.

Juste une petite suggestion, merci de mettre à jour l'image du testeur ROBOTS.txt, car la console Google a changé et ce serait génial si vous ajoutiez le lien pour vérifier le robots.txt depuis Google.

Support WPBeginner

Merci pour vos commentaires, nous ne manquerons pas d'examiner la mise à jour de l'article dès que nous le pourrons.

Admin

Kamaljeet Singh

Le fichier robots.txt de mon blog était :

User-Agent: *

crawl-delay: 10

Après avoir lu cet article, je l'ai modifié pour qu'il corresponde à votre fichier robots.txt recommandé. Est-ce que c'est bon si j'ai supprimé crawl-delay

Support WPBeginner

Cela devrait aller, crawl-delay indique aux moteurs de recherche de ralentir la fréquence d'exploration de votre site.

Admin

reena

Très bien décrit à propos de robot.text, je suis très heureux

vous êtes un très bon écrivain

Support WPBeginner

Thank you, glad you liked our article

Admin

JJ

Qu'est-ce que la page Disallow: /refer/ ? J'obtiens un 404, est-ce un fichier wp caché ?

Personnel éditorial

Nous utilisons /refer/ pour rediriger vers divers liens d'affiliation sur notre site Web. Nous ne voulons pas qu'ils soient indexés car ce ne sont que des redirections et non du contenu réel.

Admin

Sagar Arakh

Merci de partager. Cela m'a vraiment aidé à comprendre robots.txt

J'ai mis à jour mon robots.txt vers celui que vous avez suggéré. J'attends maintenant les résultats

Support WPBeginner

You’re welcome, glad you’re willing to use our recommendations

Admin

Akash Gogoi

Article très utile. Merci beaucoup.

Support WPBeginner

Glad our article was helpful

Admin

Zingylancer

Merci de partager ces informations utiles sur nous.

Support WPBeginner

Glad we could share this information about the robots.txt file

Admin

Jasper

merci pour les informations mises à jour pour moi. Votre article était bon pour le fichier Robot txt. Il m'a apporté une nouvelle information. merci et tenez-moi informé des nouvelles idées.

Support WPBeginner

Glad our guide was helpful

Admin

Imran

Merci, j'ai ajouté robots.txt dans WordPress. Très bon article

Support WPBeginner

Thank you, glad our article was helpful

Admin