小さな見落としがちなテキストファイルが、静かにウェブサイトのSEOを妨害している可能性があると気づいたときの、あの沈み込むような感覚。多くのサイトオーナーは、robots.txtファイルにある簡単な間違いが、Googleが最も重要なコンテンツを見つけるのを妨げていることに気づいていません。

何千ものWordPressサイトを監査した後、私たちは数え切れないほどこの状況を目にしてきました。良いニュースは、それを修正するのがあなたが思うよりも簡単であるということです。

このガイドでは、WordPressのrobots.txtファイルを最適化するために私たちが使用する、実証済みの正確な手順を説明します。正しく設定し、検索エンジンが効率的にサイトをクロールできるようにする方法を学びます。

圧倒されていますか?このガイドでカバーするすべての内容の簡単な概要を以下に示します。興味のあるセクションに自由にジャンプしてください。

- robots.txtファイルとは何ですか?

- WordPressサイトにrobots.txtファイルは必要ですか?

- 理想的なrobots.txtファイルとはどのようなものですか?

- WordPress で Robots.txt ファイルを作成する方法

- Robots.txt ファイルをテストする方法

- 最終的な考え

- WordPressのrobots.txtに関するよくある質問

- WordPressでrobots.txtを使用するための追加リソース

robots.txtファイルとは何ですか?

Robots.txt は、ウェブサイトの所有者が作成できるテキストファイルで、検索エンジンのボットにサイト上のページをどのようにクロールおよびインデックスするかを指示します。

通常、ウェブサイトのルートディレクトリ(メインフォルダとも呼ばれます)に保存されます。robots.txtファイルの基本的な形式は次のようになります:

User-agent: [user-agent name]

Disallow: [URL string not to be crawled]

User-agent: [user-agent name]

Allow: [URL string to be crawled]

Sitemap: [URL of your XML Sitemap]

特定のURLを許可または禁止するための複数の指示行を含め、複数のサイトマップを追加できます。URLを禁止しない場合、検索エンジンのボットはそれをクロールできると想定します。

robots.txtの例ファイルは次のようになります。

User-Agent: *

Allow: /wp-content/uploads/

Disallow: /wp-content/plugins/

Disallow: /wp-admin/

Sitemap: https://example.com/sitemap_index.xml

上記のrobots.txtの例では、検索エンジンがWordPressのアップロードフォルダ内のファイルをクロールおよびインデックスすることを許可しています。

その後、プラグインとWordPress管理フォルダのクロールとインデックス作成を検索ボットに禁止しました。

最後に、XMLサイトマップのURLを提供しました。

WordPressサイトにrobots.txtファイルは必要ですか?

robots.txt ファイルがなくてもサイトは機能しますが、最適化された robots.txt ファイルを持つサイトは検索結果でより良いパフォーマンスを発揮することが一貫してわかっています。

さまざまな業界のクライアントとの連携を通じて、robots.txt による適切なクロールバジェット管理が、重要なコンテンツのインデックス作成を迅速化し、全体的な SEO パフォーマンスを向上させることを実感しています。

これは、ブログを始めたばかりで、まだコンテンツがあまりない場合には、あまり影響がありません。

ただし、ウェブサイトが成長し、コンテンツが増えるにつれて、ウェブサイトがどのようにクロールおよびインデックスされるかについて、より詳細な制御が必要になる可能性が高くなります。

その理由は次のとおりです。

検索エンジンは、Googleが「クロールバジェット」と呼ぶものを各ウェブサイトに割り当てます。これは、指定された期間内にクロールするページの数です。

数千ものWordPressサイトでのテストを通じて、大規模なサイトは戦略的なrobots.txt構成を通じてこの予算を最適化することから特に恩恵を受けることがわかりました。

例えば、当社のエンタープライズクライアントの 1 社は、推奨される robots.txt の最適化を実装した後、クロール効率が 40% 向上しました。

WordPressの管理ページ、プラグインファイル、テーマフォルダなど、検索ボットにクロールさせたくないページへのアクセスを拒否できます。

不要なページを禁止することで、クロールクォータを節約できます。これにより、検索エンジンはサイト上のさらに多くのページをクロールし、できるだけ早くインデックスできるようになります。

robots.txtファイルを使用するもう1つの良い理由は、検索エンジンがウェブサイト上の投稿やページをインデックスに登録するのを停止したい場合です。

ただし、robots.txtはコンテンツを隠すのに最適な方法ではないことを知っておくことが重要です。他のウェブサイトからリンクされている場合、disallowedページは検索結果に表示される可能性があります。

ページがGoogleに表示されないように確実にしたい場合は、代わりに「noindex」メタタグを使用する必要があります。これは、検索エンジンにページをインデックスに追加しないように指示します。

理想的なrobots.txtファイルとはどのようなものですか?

多くの人気ブログでは非常にシンプルなrobots.txtファイルを使用しています。その内容は、特定のサイトのニーズによって異なる場合があります。

User-agent: *

Disallow:

Sitemap: https://www.example.com/post-sitemap.xml

Sitemap: https://www.example.com/page-sitemap.xml

このrobots.txtファイルは、すべてのボットがすべてのコンテンツをインデックスすることを許可し、ウェブサイトのXMLサイトマップへのリンクを提供します。

WordPressサイトの場合、robots.txtファイルには以下のルールをお勧めします。

User-Agent: *

Allow: /wp-content/uploads/

Disallow: /wp-admin/

Disallow: /readme.html

Disallow: /refer/

Sitemap: https://www.example.com/post-sitemap.xml

Sitemap: https://www.example.com/page-sitemap.xml

これは、検索ボットにWordPressのすべての画像とアップロードされたファイルをインデックスするように指示します。これは、Googleのような検索エンジンが理解する便利なコマンドであるAllowディレクティブを具体的に使用します。

これにより、WordPressの管理画面、デフォルトのreadme.htmlファイル(WordPressのバージョンが明らかになる可能性があります)、および/refer/のようなクロークされたアフィリエイトリンクの一般的なディレクトリへの検索ボットによるインデックス作成が禁止されます。

robots.txt ファイルに サイトマップ を追加することで、Google ボットがサイト上のすべてのページを見つけやすくなります。

理想的なrobots.txtファイルがどのようなものかを知ったところで、WordPressでrobots.txtファイルを作成する方法を見てみましょう。

WordPress で Robots.txt ファイルを作成する方法

WordPressでrobots.txtファイルを作成するには2つの方法があります。あなたに最適な方法を選択できます。

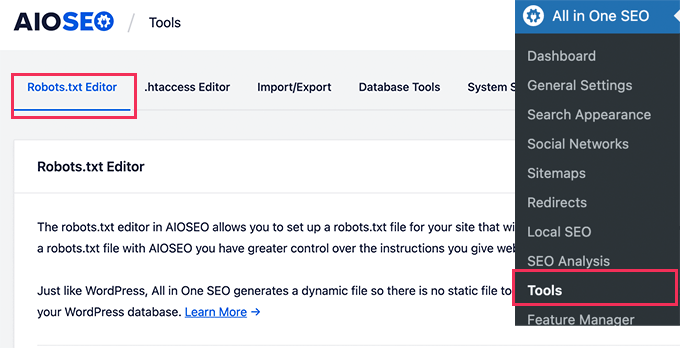

All in One SEO を使用して robots.txt ファイルを編集する方法 1

All in One SEO (AIOSEO とも呼ばれる) は、300万以上のウェブサイトで使用されている、市場で最高の WordPress SEO プラグインです。使いやすく、robots.txt ファイルジェネレーターも付属しています。

詳細については、詳細な AIOSEOレビューをご覧ください。

AIOSEOプラグインがまだインストールされていない場合は、WordPressプラグインのインストール方法に関するステップバイステップガイドをご覧ください。

注: AIOSEOの無料版も利用可能で、この機能があります。

プラグインがインストールされ有効化されると、WordPress管理画面から直接robots.txtファイルを作成および編集するために使用できます。

All in One SEO » Tools にアクセスして、robots.txt ファイルを編集してください。

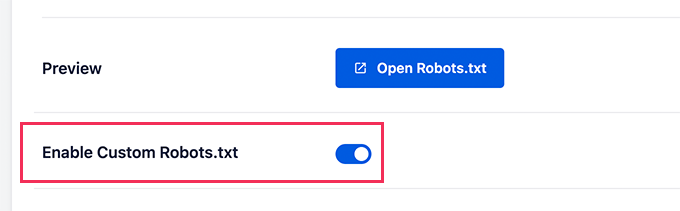

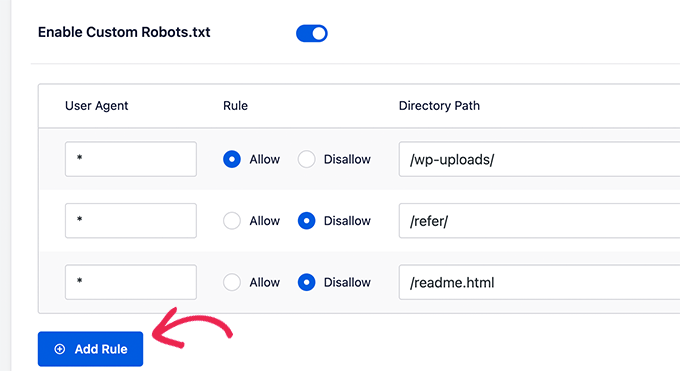

まず、「カスタムrobots.txtを有効にする」トグルを青色にクリックして、編集オプションをオンにする必要があります。

このトグルをオンにすると、WordPressでカスタムrobots.txtファイルを作成できます。

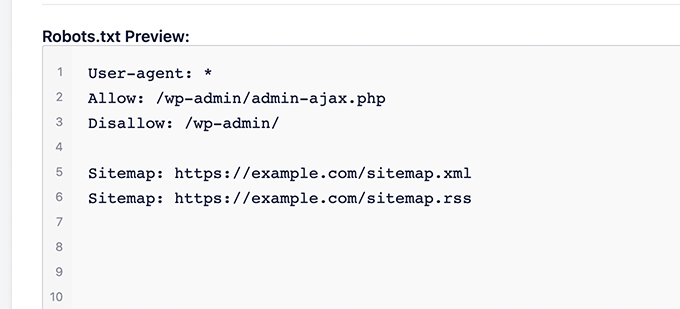

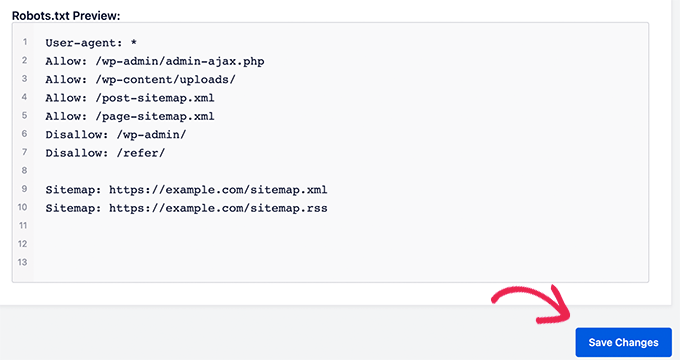

All in One SEOは、画面下部の「Robots.txtプレビュー」セクションに既存のrobots.txtファイルを表示します。

このバージョンでは、WordPress によって追加されたデフォルトのルールが表示されます。

これらのデフォルトルールは、検索エンジンに WordPress のコアファイルをクロールしないように指示し、ボットがすべてのコンテンツをインデックスできるようにし、サイトの XML サイトマップへのリンクを提供します。

これで、SEOのためにrobots.txtを改善するために独自のカスタムルールを追加できます。

ルールを追加するには、「User Agent」フィールドにユーザーエージェントを入力します。「*」を使用すると、すべてのユーザーエージェントにルールが適用されます。

次に、検索エンジンにクロールを「許可」するか「禁止」するかを選択します。

次に、「Directory Path」フィールドにファイル名またはディレクトリパスを入力します。

ルールは自動的に robots.txt に適用されます。別のルールを追加するには、「ルールの追加」ボタンをクリックするだけです。

上記で共有した理想的なrobots.txt形式を作成するまで、ルールを追加することをお勧めします。

カスタムルールは次のようになります。

完了したら、「変更を保存」ボタンをクリックして変更を保存することを忘れないでください。

方法2:WPCodeを使用したrobots.txtファイルの編集

WPCodeは、カスタムコードを簡単かつ安全にウェブサイトに追加できる強力なコードスニペットプラグインです。

また、robots.txt ファイルをすばやく編集できる便利な機能も含まれています。

注意: WPCode Free Pluginもありますが、ファイルエディタ機能は含まれていません。

まず、WPCodeプラグインをインストールする必要があります。手順については、WordPressプラグインのインストール方法に関する初心者向けガイドをご覧ください。

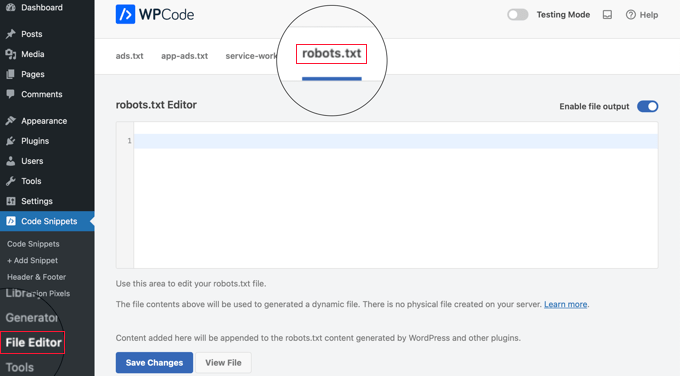

有効化すると、WPCode » ファイルエディター ページに移動する必要があります。そこに表示されたら、ファイルを編集するために「robots.txt」タブをクリックするだけです。

これで、robots.txt ファイルの内容を貼り付けるか、入力できます。

終了したら、ページ下部にある「変更を保存」ボタンをクリックして設定を保存してください。

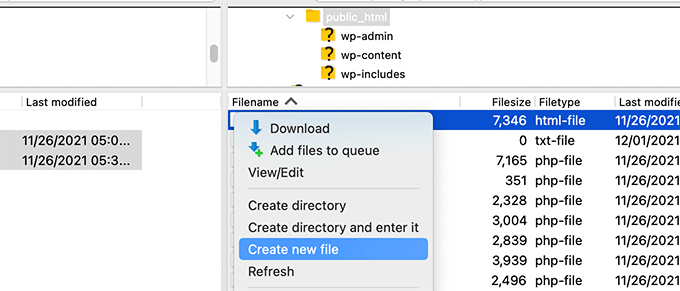

方法3:FTPを使用してrobots.txtファイルを手動で編集する

この方法では、FTPクライアントを使用してrobots.txtファイルを編集する必要があります。または、WordPressホスティングで提供されているファイルマネージャーを使用することもできます。

プロのヒント: 編集する前に、元のrobots.txtファイル(存在する場合)のバックアップコピーをコンピューターにダウンロードすることをお勧めします。そうすれば、問題が発生した場合に簡単に再アップロードできます。

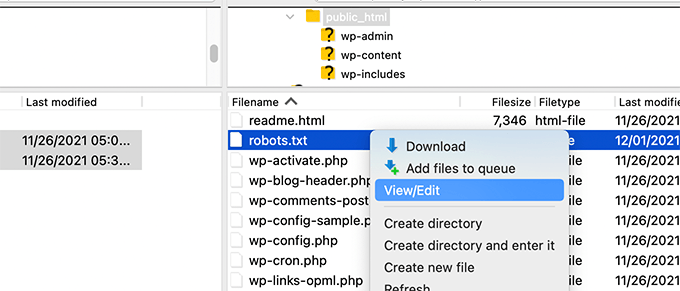

FTPクライアントを使用して、WordPressウェブサイトのファイルに接続するだけです。

サイトに入ると、ウェブサイトのルートフォルダに robots.txt ファイルが表示されます。

表示されない場合は、robots.txt ファイルがない可能性が高いです。

その場合は、そのまま作成できます。

robots.txt はプレーンテキストファイルなので、コンピューターにダウンロードして、Notepad や TextEdit のような任意のプレーンテキストエディタで編集できます。

変更を保存した後、robots.txt ファイルをウェブサイトのルートフォルダにアップロードし直すことができます。

Robots.txt ファイルをテストする方法

robots.txtファイルを作成または編集した後、エラーがないか確認するのは良い考えです。小さなタイプミスが検索エンジンから重要なページを誤ってブロックする可能性があるため、この手順は非常に重要です!👍

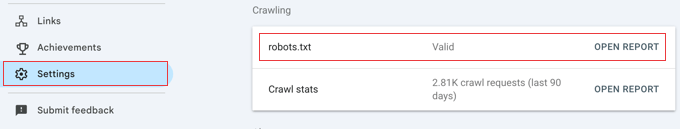

Googleには以前は専用のテストツールがありましたが、現在はその機能をメインのGoogle Search Consoleレポートに統合しています。

まず、サイトがGoogle Search Consoleに接続されていることを確認してください。まだ行っていない場合は、WordPressサイトをGoogle Search Consoleに追加する方法に関する簡単なガイドに従ってください。

設定が完了したら、Google Search Consoleダッシュボードに移動します。左下のメニューにある設定に移動します。

次に、「クロール」セクションを見つけて、「robots.txt」の横にある「レポートを開く」をクリックします。

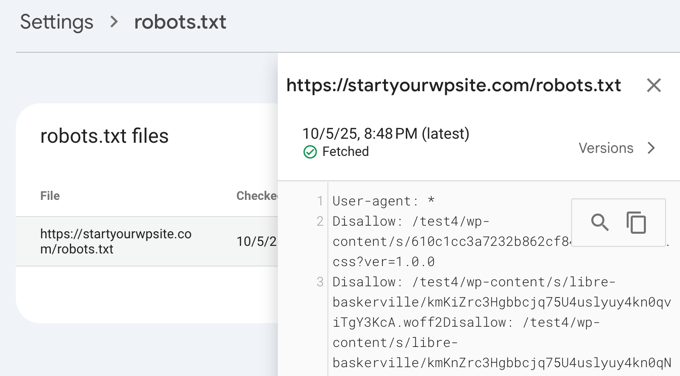

リスト内のファイルの現在のバージョンをクリックするだけです。

このレポートには、Googleが見つけたrobots.txtファイルの最新バージョンが表示されます。検出された構文エラーまたは論理的な問題が強調表示されます。

ファイルを更新したばかりで、変更がすぐにここに表示されなくても心配しないでください。Googleは、robots.txtファイルの新しいバージョンを1日に1回程度自動的にチェックします。

後でこのレポートを確認して、Googleが最新の変更を認識し、すべてが正常であることを確認できます。

最終的な考え

robots.txtファイルを最適化する目標は、公開されていないページを検索エンジンがクロールしないようにすることです。たとえば、wp-pluginsフォルダ内のページやWordPress管理フォルダ内のページなどです。

SEO専門家の間では、WordPressのカテゴリ、タグ、アーカイブページをブロックすると、クロール率が向上し、インデックス作成が速くなり、ランキングが向上するという一般的な誤解があります。

これは真実ではありません。実際、この方法はGoogleによって強く推奨されておらず、サイトの理解を助けるためのベストプラクティスガイドラインに反しています。

robots.txtファイルをウェブサイト用に作成するために、上記のrobots.txt形式に従うことをお勧めします。

WordPressのrobots.txtに関するよくある質問

WordPressでrobots.txtファイルを最適化することについて、よく寄せられる質問をいくつかご紹介します。

1. robots.txtファイルの主な目的は何ですか?

robots.txtファイルの主な目的は、ウェブサイトのクロールバジェットを管理することです。検索エンジンに無視するページ(管理ページやプラグインファイルなど)を伝えることで、最も重要なコンテンツをより効率的にクロールおよびインデックス化するためにリソースを費やすことができます。

2. WordPressではrobots.txtファイルはどこにありますか?

robots.txtファイルは、ウェブサイトのルートディレクトリにあります。通常、ウェブブラウザでyourdomain.com/robots.txtにアクセスすると表示できます。

3. robots.txtを使用すると、サイトのセキュリティを向上させることができますか?

いいえ、robots.txt はセキュリティ対策ではありません。このファイルは公開されており、リストされた URL へのアクセスを実際にブロックするものではありません。単に、礼儀正しい検索エンジンのクローラーへの指示を提供するだけです。

4. WordPress のカテゴリページとタグページを robots.txt でブロックすべきですか?

いいえ、カテゴリページとタグページをブロックすべきではありません。これらのアーカイブページは、サイトの構造を検索エンジンが理解し、コンテンツを発見するのに役立つため、SEO にとって有用です。これらをブロックすると、検索ランキングに悪影響を与える可能性があります。

WordPressでrobots.txtを使用するための追加リソース

robots.txt ファイルの最適化方法がわかったところで、WordPress で robots.txt を使用することに関連する他の記事もご覧になりたいかもしれません。

- 用語集: Robots.txt

- GoogleからWordPressのページを隠す方法

- 検索エンジンがWordPressサイトをクロールするのを停止する方法

- WordPress サイトをインターネットから完全に削除する方法

- WordPressでPDFファイルを簡単に非表示(noindex)にする方法

- WordPressで「GooglebotがCSSおよびJSファイルにアクセスできません」エラーを修正する方法

- llms.txtとは?WordPressにllms.txtを追加する方法

- WordPressのAll in One SEOを正しく設定する方法(完全ガイド)

この記事が、WordPressのrobots.txtファイルをSEOのために最適化する方法を学ぶのに役立ったことを願っています。また、初心者向けのWordPress SEO完全ガイドや、ウェブサイトを成長させるための最高のWordPress SEOツールに関する専門家のおすすめもご覧ください。

この記事が気に入ったら、WordPressのビデオチュートリアルについては、YouTubeチャンネルを購読してください。 TwitterやFacebookでもフォローできます。

Steve

これ、ありがとうございます。WP Multisite ではどのように機能しますか?

WPBeginnerサポート

マルチサイトの場合、各サイトのルートフォルダにrobots.txtファイルが必要です。

管理者

Pacifique Ndanyuzwe

私のWordPressサイトは新しく、デフォルトのrobots.txtは以下のようになっています:

user-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

Googleに私のコンテンツをクロールおよびインデックスしてもらいたいのですが、このrobots.txtで大丈夫ですか?

WPBeginnerサポート

もちろん、必要であればそれを使用できます

管理者

Ritesh Seth

素晴らしい記事です…

長い間、Robots.txt ファイルと Disallow リンクについて混乱していました。robots ファイル用のタグをコピーしました。これで私のサイトの問題が解決することを願っています。

WPBeginnerサポート

We hope our article will help as well

管理者

Kurt

ホームフォルダのスクリーンショットにあるファイルは、実際には私のホームフォルダの下のpublic_htmlフォルダ内にあります。

public_html フォルダの下に /refer フォルダがありませんでした。

WPアカウントのどこにも投稿またはページのXMLファイルがありませんでした。

作成したrobots.txtファイルに、サンドボックスサイトのクロールを拒否するエントリを含めました。WPでサンドボックスサイトをクロールしないようにクローラーに指示するオプションをすでに選択しているので、これは必要ないかもしれませんが、エントリがあっても害はないと思います。

WPBeginnerサポート

Some hosts do rename public_html to home which is why you see it there. You would want to ensure Yoast is active for the XML files to be available. The method in this article is an additional precaution to help with preventing crawling your site

管理者

Ahmed

素晴らしい記事です

WPBeginnerサポート

Thank you

管理者

ASHOK KUMAR JADON

こんにちは、素晴らしい記事です。私の問題を解決してくれました。本当にありがとうございます。

WPBeginnerサポート

Glad our article could help

管理者

エリン・アシュトン

User-agent: * Disallow: /wp-admin/ Allow: /wp-admin/admin-ajax.php <– これが私のrobot.txtコードですが、なぜ私の/wp-adminがインデックスされるのか混乱しています。どのようにインデックスしないようにすればよいですか?

WPBeginnerサポート

以前にインデックス登録された場合、検索エンジンのキャッシュがクリアされるまで時間がかかる場合があります

管理者

Ashish kumar

このウェブサイトは、ブログを始める上で本当に刺激になります。多くのチームに感謝します。このウェブサイトの各記事には、豊富な情報と説明があります。何か問題が発生した場合、まずこのブログを訪れます。ありがとうございます。

WPBeginnerサポート

Glad our articles can be helpful

管理者

Anna

Yoastを使用してウェブサイトのロボットを最適化しようとしています。しかし、Yoastのツールには「ファイルエディター」のオプションがありません。

オプションは2つしかありません。

(i) インポートとエクスポート

(ii) 一括エディター

この問題にどのように対処できるかアドバイスいただけますでしょうか。もしかして、Yoastの無料版を使用していますか?

WPBeginnerサポート

Yoastの無料バージョンにはまだオプションがあります。インストールでファイル編集が無効になっている可能性があります。その場合は、FTPメソッドを使用する必要があるでしょう。

管理者

Emmanuel Husseni

robot.txt がどのように機能するかあまり知らなかったので、この記事は本当に役に立ちました。今ではわかっています。

サイトで一般的に機能するrobots.txtの最適な形式をどのように見つけるのか理解できません。

チェックしている多くの有名なブログが検索エンジンで上位表示されているのを見ると、異なるrobot.txt形式を使用していることに気づきました。

あなたからの返信、または助けてくれる誰かからの返信を楽しみにしています。

編集スタッフ

サイトマップを作成し、許可する必要のある領域を許可することが最も重要です。禁止する部分はサイトごとに異なります。ブログ記事でサンプルを共有しましたが、ほとんどのWordPressサイトでこれで十分でしょう。

管理者

WPBeginnerサポート

Emmanuel さん、こんにちは。

理想的なrobots.txtファイルに関するセクションを参照してください。それはあなたの要件によります。ほとんどのブロガーは、WordPressの管理フォルダとプラグインフォルダをクロールから除外します。

管理者

Emmanuel Husseni

本当にありがとうございます。

今わかりました。とりあえず一般的な形式から始めようと思います。

ジャック

よく書かれた記事です。ユーザーには、ROBOTSテキストを作成して有効にする前にサイトマップを作成することをお勧めします。これにより、サイトのクロールが速くなり、インデックスが容易になります。

Jack

Connie S Owens

検索エンジンがクロール中に私のアーカイブをインデックスに登録するのを停止したいです。

エマニュエル・ノニエ

ありがとうございます。この記事は本当に役に立ちました。

Cherisa

Google ウェブマスターで以下のエラーメッセージが表示され続けます。基本的に行き詰まっています。このチュートリアルで不明だった点がいくつかあります。サイトのルートファイルはどこで見つけられますか?「robots.txt」がすでに存在するかどうかをどのように判断しますか?また、どのように編集しますか?

WPBeginnerサポート

Cherisaさん、こんにちは。

サイトのルートフォルダとは、wp-admin、wp-includes、wp-content などのフォルダが含まれるフォルダのことです。また、wp-config.php、wp-cron.php、wp-blogheader.php などのファイルも含まれます。

このフォルダにrobots.txtファイルが見つからない場合は、ファイルが存在しないということです。新しいファイルを作成しても構いません。

管理者

Cherisa

ご返信ありがとうございます。説明されているルートファイルを見つけることができませんでした。設定などの下に、このフォルダにつながるパスディレクトリはありますか?

Devender

ウェブサイトへのトラフィックは順調でしたが、5月に入って突然ゼロになりました。現在もこの問題に直面しています。ウェブサイトを復旧するために助けてください。

ハリス・アスラム

こんにちは。この情報ありがとうございます。しかし、質問があります。

Sitemap.xmlとRobots.txtファイルを作成したばかりで、正常にクロールされています。しかし、「Product-Sitemap.xml」をどのように作成できますか?

Sitemap.xmlファイルにはすべての製品リストがあります。Product-sitemap.xmlを別途作成する必要がありますか?

GoogleまたはBingに再度送信しますか?

手伝っていただけませんか…

ありがとうございます

Mahadi Hassan

robots.txtファイルの設定で問題が発生しています。すべてのウェブサイトでrobots.txtが1つしか表示されません。すべてのウェブサイトのrobots.txtファイルを個別に表示できるようにしてください。個々のウェブサイトごとにrobots.txtファイルをすべて個別に持っています。しかし、ブラウザにはすべてのウェブサイトに対してrobots.txtファイルが1つしか表示されません。

Debu Majumdar

初心者向けRobots.txtの例に

Disallow: /refer/

を含めた理由を説明してください。この行の意味が理解できません。これは初心者にとって重要ですか?他の2つのDisallowedについては説明されています。

ありがとう。

WPBeginnerサポート

Debuさん、こんにちは。

この例はWPBeginnerのrobots.txtファイルからのものです。WPBeginnerでは、ThirstyAffiliatesを使用してアフィリエイトリンクとURLのマスクを管理しています。これらのURLには「/refer/」が含まれているため、robots.txtファイルでブロックしています。

管理者

エバリスト

すべてのタグ/mydomain.Comをnofollowにするにはどうすればよいですか?リンクジュースを集中させるためにrobots.txtで?ありがとう。

ハルシュ・クマール

こんにちは、Yoast SEOでサイトマップに関するエラーが出ています。修正をクリックすると、また元に戻ってしまいます。サイトのHTMLが正しく読み込まれていません。

トム

Google Search Consoleのアカウントを確認したところ、以下の問題が見つかりました。

ページの一部が読み込まれていません

ページのすべてのリソースを読み込めませんでした。これは、Googleがページをどのように認識し、理解するかに影響を与える可能性があります。Googleがページをどのように理解するかに影響を与える可能性のあるリソースの可用性の問題を修正してください。

これは、プラグインに関連するすべてのCSSスタイルシートが、デフォルトのrobots.txtによって禁止されているためです。

これを許可しない方が良い理由を理解していますが、Googleのアルゴリズムがサイトを低く評価しているのではないかと疑われる場合、代替手段は何になりますか?

スーレン

こんにちは、

Googleで私のサイトを検索すると、リンクの下に次のテキストが表示されます。「このサイトのrobots.txtのため、この結果の説明は利用できません。」

この問題をどのように解決できますか?

Regards

WPBeginnerサポート

Surenさん、こんにちは。

サイトのプライバシー設定が誤って変更されたようです。「設定 » 表示設定」ページに移動し、「検索エンジンの可視性」セクションまでスクロールしてください。の横にあるチェックボックスがオフになっていることを確認してください。

管理者

ディビエシュ

こんにちは

ウェブマスターツールで見たところ、以下のような robot.txt ファイルがありました。

User-agent: * Disallow: /wp-admin/ Allow: /wp-admin/admin-ajax.php

これで大丈夫ですか?それとも何か他のものを使うべきですか?

John Cester

「/wp-content/plugins/」をrobots.txtでブロック(無効化)するのは良い考えですか? プラグインを削除するたびに、そのプラグインの一部のページで404エラーが表示されます。

Himanshu singh

この説明はとても気に入りました。初心者としてrobot.txtファイルとその用途について非常に混乱していましたが、今ではその目的がわかりました。

rahul

robots.txt ファイルで index.php がディスアローされています。その理由を説明していただけますか?それは良い習慣ですか?

Waleed Barakat

この貴重な情報を共有していただきありがとうございます。

Awais Ahmed

Webmaster Toolでこれが起こる理由を教えていただけますか?

ネットワークに到達できません: robots.txt に到達できませんサイトマップをクロールできませんでした。サイトのルートに robots.txt ファイルが見つかりましたが、ダウンロードできませんでした。アクセス可能であることを確認するか、完全に削除してください。

robots.txtファイルは存在しますが、まだ

Dozza

Yoastチームからのこの件に関する興味深いアップデートはこちらです。

引用:「robots.txtでwp-includesディレクトリやプラグインディレクトリへのアクセスをブロックするという古いベストプラクティスはもはや有効ではありません。」

natveimaging

Allow: /wp-content/uploads/

これは~ではないでしょうか?

Disallow: /wp-content/uploads/

Googleはアップロードしたすべてのページを公開URLとしてインデックスすることを認識しているからですよね?そして、ページ自体にエラーが表示されることになります。何か見落としていることはありますか?

nativeimaging

全体として、Google が画像マップを生成するためにクロールするのは実際のページであり、アップロードフォルダではありません。そうすると、すべての小さな画像サイズや UI 用の他の画像もインデックスに登録されるという問題が発生します。

これが最善の選択肢のようです:

Disallow: /wp-content/uploads/

私が間違っている場合は、あなたの考えを理解できるように説明してください。

ジェイソン

私のブログの URL がインデックスに登録されません。robots.txt を変更する必要がありますか? この robots.txt を使用しています。

iyan

ページと投稿のみをインデックス許可するrobots.txtの作成方法を教えてください。ありがとうございます。

Simaran Singh

何が問題なのかはっきりしませんが、robots.txt が 2 つあります。 1 つは http://www.example.com/robots.txt にあり、もう 1 つは example.com/robots.txt にあります。

どなたか、助けてください!原因と修正方法を教えていただけますか?

WPBeginnerサポート

おそらく、お使いのウェブホストでは、サイトに wwwとnon-wwwのURLの両方でアクセスできるようになっています。FTPクライアントを使用してrobots.txtを変更してみてください。その後、両方のURLから確認して、両方のURLで変更が見られる場合は、同じファイルであることを意味します。

管理者

Simaran Singh

早速のご返信ありがとうございます。すでに試しましたが、変更が見られません。他に解決策はありますか?

Martin conde

Yoasts blogpost about this topic was right above yours in my search so of course I checked them both. They are contradicting each other a little bit.. For example yoast said that disallowing plugin directories and others, might hinder the Google crawlers when fetching your site since plugins may output css or js. Also mentioned (and from my own experience), yoast doesn’t add anything sitemap related to the robots.txt, rather generates it so that you can add it to your search console. Here is the link to his post, maybe you can re-check because it is very hard to choose whose word to take for it

MM Nauman

このRobotstxtファイルをうまく作成できないので、URLやサイトマップなどのパラメータを変更してあなたのRobots.txtファイルを使用しても良いですか?それは良いことですか?それとも別のものを作成すべきですか?

Mohit Chauhan

こんにちは。 今日、Googleから「GooglebotがCSSおよびJSファイルにアクセスできません」というメールを受け取りました。解決策は何でしょうか?

ありがとう

Parmod

推測させてください… CSS および JS ファイルをインポートするために CDN サービスを使用していますか? または これらのファイルに間違った構文を記述した可能性があります。

ラフル

サイトマップの追加について質問があります。YahooとBingのサイトマップをrobotsファイルとWordPressディレクトリに追加するにはどうすればよいですか?

Gerbrand Petersen

robotsファイルの使用に関する詳細な概要をありがとうございます。Yahooもこのrobots.txtを使用しており、ファイルに記載されているルールに従うかご存知の方はいらっしゃいますか?特定のページに「Disallow」を設定しているのですが、Yahooからはそのページへのトラフィックがあります。Googleからは、あるべき姿の通り、ありません。よろしくお願いします。

アーウィン

訂正…

「YoastのWordPress SEOプラグインやその他のプラグインを使用してXMLサイトマップを生成している場合、プラグインはサイトマップ関連の行をrobots.txtファイルに自動的に追加しようとします。」

事実ではありません。WordPress SEOはサイトマップをrobots.txtに追加しません。

「XMLサイトマップをrobots.txtにリンクするのは少し無意味だと常々感じていました。GoogleとBingのWebmaster Toolsに手動で追加し、XMLサイトマップに関するフィードバックを確認する必要があります。これが、当社のWordPress SEOプラグインがrobots.txtに追加しない理由です。」

https://yoast.com/wordpress-robots-txt-example/

wp-pluginsディレクトリをdisallowしないこともさらに推奨されます(理由についてはYoastの記事を参照)。

そして個人的には、readme.txtファイルを削除するだけでいいと思っています…

hyma

robots.txt ファイルと robots ファイルの使用について理解しました。サイトマップとは何ですか?自分のサイトのサイトマップを作成するにはどうすればよいですか?

Rick R. Duncan

Googleのドキュメントを読んだ後、robots.txtファイルで使用するディレクティブは、ボットがクロールできるものとできないものを伝えるだけのdisallowであるという印象を受けました。それは、ページがインデックスされるものとされないものを伝えるものではありません。ページをnoindexにするには、noindex robots metaタグを使用する必要があります。

Nitin

SEOに最適化されたrobots.txtファイルに関する非常に良い記事です。しかし、robots.txtファイルをサーバーにアップロードする方法についてのチュートリアルを教えていただく必要があります。初心者なので、そのファイルをアップロードするのは大変な問題のように思えます。

ところで、このような有益な情報を共有していただきありがとうございます。

-Nitin

Parmod

サーバー/public_hmtl/(あなたのサイト名) … このフォルダにアップロードしてください

ジェニー

URLが指定されていない場合に、URLとIPアドレスで複数のスパムボットリファラーをブロックするために、HTTacessにコードを追加する最良の方法は何ですか?

httacessで構文を間違えるとサイトがオフラインになることがあるのは知っています。私は初心者で、ロシア、中国、ウクライナなどからの迷惑な複数のURLをブロックする必要があります。

ありがとうございます

Hazel Andrews

これらのヒントをありがとう…ロボットtxtファイルを修正しました!やった!

Rahat

なぜAllow: !!!を追加する必要があるのですか? Disallowしたいものだけを言及すれば十分ではないでしょうか。GooglebotやBingbotは他のすべてを自動的にクロールするので、Allowのコードを書く必要はありません。 では、なぜ再びAllowを使用する必要があるのでしょうか?

Connor Rickett

Robots.txtファイルがないとサイトのクロールが止まるわけではないので、疑問に思っています。ファイルがあることでSEOパフォーマンスがどれだけ向上するかについての具体的なデータはありますか?

簡単なGoogle検索をしましたが、定量的なデータは見つかりませんでした。「SEOが向上する!」という記事が約50万件ありますが、具体的に何について話しているのか、一般的にでも知りたいです。

これは5%のブーストですか? 50? 500?

WPBeginnerサポート

検索エンジンはこのようなデータを共有しません。robots.txtファイルがないからといって、検索エンジンがウェブサイトをクロールまたはインデックスすることを停止するわけではありません。ただし、推奨されるベストプラクティスです。

管理者

Connor Rickett

ご連絡いただきありがとうございます。感謝いたします!

JD Myers

タイミングが良いですね。まさに昨日この情報を探していました。

Googleウェブマスターツールが、ページの適切なレンダリングに必要なさまざまなリソースをブロックしているため、サイトを適切にクロールできないと通知していたため、それを検索していました。

これらのリソースには、 /wp-content/plugins/ にあるものが含まれていました。

このフォルダを許可した後、警告は消えました。

これについて何か考えはありますか?

WPBeginnerサポート

これらの警告は無視しても安全です。インデックスさせたいコンテンツが実際にある場合にのみ警告となります。ユーザーが検索ボットを制限していて、それを忘れている場合があります。これらの警告は、そのような状況で役立ちます。

管理者

Chetan jadhav

静的なサイトマップを使用している人が多く、WordPressサイトを使っていることをご存知かと思います。静的なサイトマップを使うべきか、WordPressが生成するサイトマップを使うべきか、という質問があります。

Wilton Calderon

いいですね。Wpbeginnerの方法が好きです。アレクサのランクを考えると、robots.txtを「訴える」のが最善の方法のように見えます。

Brigitte Burke

robots.txtファイルがこのようになっている場合、どういう意味ですか?

User-agent: * Disallow: /wp-admin/ Disallow: /wp-includes/ Disallow: /xmlrpc.php

編集スタッフ

これは、検索エンジンがwp-adminフォルダ、wp-includesフォルダ、およびxml-rpcファイルをインデックスしないように指示しているだけです。場合によっては、/wp-includes/をDisallowすると、サイトがそれらのスクリプトを使用している場合に、検索エンジン用の特定のスクリプトがブロックされる可能性があります。これはSEOに悪影響を与える可能性があります。

最善の方法は、Googleウェブマスターツールにアクセスし、そこでボットとしてウェブサイトを取得することです。すべて正常に読み込まれる場合は、心配する必要はありません。スクリプトがブロックされていると表示される場合は、wp-includes行を削除することを検討してください。

管理者

ヘラクレス

クロール/ロボットが使用できるincludesディレクトリ内のスクリプトを持つというあなたの考えには論理が見当たりません。また、もし孤立したケースがあるなら、デフォルトのWordPressがこのファイルを許可した後で指定する方が良いでしょう。検索エンジンは彼のスクリプトを使用します!結局のところ、WordPressは確かにデフォルトで検索エンジン用のrobots.txtアンチエンジンを持っていません!!!!