To uczucie, gdy zdajesz sobie sprawę, że mały, przeoczony plik tekstowy może potajemnie sabotować SEO Twojej witryny. Wielu właścicieli witryn nie zdaje sobie sprawy, że prosty błąd w pliku robots.txt może uniemożliwić Google znalezienie ich najważniejszych treści.

Po audycie tysięcy witryn WordPress widzieliśmy, jak to się dzieje więcej razy, niż możemy policzyć. Dobra wiadomość jest taka, że naprawienie tego jest łatwiejsze, niż myślisz.

W tym przewodniku przeprowadzimy Cię przez dokładne, sprawdzone w boju kroki, które stosujemy, aby zoptymalizować plik robots.txt WordPress. Dowiesz się, jak zrobić to dobrze i zapewnić, że wyszukiwarki efektywnie indeksują Twoją witrynę.

Czujesz się przytłoczony? Oto szybki przegląd wszystkiego, co omówimy w tym przewodniku. Zachęcamy do przejścia do sekcji, która najbardziej Cię interesuje.

- Czym jest plik robots.txt?

- Czy potrzebujesz pliku Robots.txt dla swojej witryny WordPress?

- Jak wygląda idealny plik robots.txt?

- Jak utworzyć plik Robots.txt w WordPress

- Jak przetestować plik Robots.txt

- Końcowe przemyślenia

- Często zadawane pytania dotyczące robots.txt w WordPress

- Dodatkowe zasoby dotyczące korzystania z robots.txt w WordPress

Czym jest plik robots.txt?

Robots.txt to plik tekstowy, który właściciele witryn mogą utworzyć, aby poinformować boty wyszukiwarek, jak indeksować strony w ich witrynach.

Zazwyczaj jest przechowywany w katalogu głównym (znanym również jako główny folder) Twojej witryny. Podstawowy format pliku robots.txt wygląda następująco:

User-agent: [user-agent name]

Disallow: [URL string not to be crawled]

User-agent: [user-agent name]

Allow: [URL string to be crawled]

Sitemap: [URL of your XML Sitemap]

Możesz mieć wiele linii instrukcji zezwalających lub zabraniających indeksowania określonych adresów URL i dodawać wiele map witryn. Jeśli nie zabronisz indeksowania adresu URL, boty wyszukiwarek zakładają, że mogą go przeszukiwać.

Oto jak może wyglądać przykładowy plik robots.txt:

User-Agent: *

Allow: /wp-content/uploads/

Disallow: /wp-content/plugins/

Disallow: /wp-admin/

Sitemap: https://example.com/sitemap_index.xml

W powyższym przykładzie robots.txt zezwoliliśmy wyszukiwarkom na indeksowanie i przeszukiwanie plików w naszym folderze WordPress uploads.

Następnie zabroniliśmy botom wyszukiwarek indeksowania i przeglądania folderów wtyczek i panelu administracyjnego WordPress.

Na koniec podaliśmy adres URL naszej mapy witryny w formacie XML.

Czy potrzebujesz pliku Robots.txt dla swojej witryny WordPress?

Chociaż Twoja witryna może działać bez pliku robots.txt, konsekwentnie stwierdziliśmy, że witryny ze zoptymalizowanymi plikami robots.txt osiągają lepsze wyniki w wynikach wyszukiwania.

Dzięki naszej pracy z klientami z różnych branż widzieliśmy, jak właściwe zarządzanie budżetem indeksowania za pomocą robots.txt może prowadzić do szybszego indeksowania ważnych treści i lepszej ogólnej wydajności SEO.

Nie będzie to miało dużego wpływu, gdy dopiero rozpoczynasz bloga i nie masz dużo treści.

Jednak w miarę rozwoju Twojej witryny i dodawania większej ilości treści, prawdopodobnie będziesz chciał mieć lepszą kontrolę nad tym, jak Twoja witryna jest przeszukiwana i indeksowana.

Oto dlaczego.

Wyszukiwarki przydzielają każdej stronie internetowej to, co Google nazywa „budżetem indeksowania”. Jest to liczba stron, które przeszukają w określonym czasie.

W naszych testach na tysiącach witryn WordPress odkryliśmy, że większe witryny szczególnie korzystają z optymalizacji tego budżetu poprzez strategiczną konfigurację robots.txt.

Na przykład jeden z naszych klientów korporacyjnych odnotował 40% poprawę efektywności indeksowania po wdrożeniu naszych zalecanych optymalizacji robots.txt.

Możesz zablokować botom wyszukiwarek próbę indeksowania niepotrzebnych stron, takich jak strony administracyjne WordPress, pliki wtyczek i folder motywów.

Blokując niepotrzebne strony, oszczędzasz swój limit przeszukiwania. Pomaga to wyszukiwarkom szybciej przeszukiwać i indeksować więcej stron na Twojej witrynie.

Innym dobrym powodem do używania pliku robots.txt jest sytuacja, gdy chcesz zatrzymać wyszukiwarki przed indeksowaniem posta lub strony na swojej stronie internetowej.

Należy jednak pamiętać, że robots.txt nie jest najlepszym sposobem na ukrycie treści. Zablokowana strona może nadal pojawiać się w wynikach wyszukiwania, jeśli linkuje do niej inne witryny.

Jeśli chcesz niezawodnie zapobiec pojawieniu się strony w Google, zamiast tego powinieneś użyć tagu meta „noindex”. Informuje to wyszukiwarki, aby w ogóle nie dodawały strony do ich indeksu.

Jak wygląda idealny plik robots.txt?

Wiele popularnych blogów używa bardzo prostego pliku robots.txt. Ich zawartość może się różnić w zależności od potrzeb konkretnej witryny:

User-agent: *

Disallow:

Sitemap: https://www.example.com/post-sitemap.xml

Sitemap: https://www.example.com/page-sitemap.xml

Ten plik robots.txt pozwala wszystkim botom indeksować całą zawartość i zapewnia im link do map witryny XML.

Dla stron WordPress zalecamy następujące reguły w pliku robots.txt:

User-Agent: *

Allow: /wp-content/uploads/

Disallow: /wp-admin/

Disallow: /readme.html

Disallow: /refer/

Sitemap: https://www.example.com/post-sitemap.xml

Sitemap: https://www.example.com/page-sitemap.xml

To mówi botom wyszukiwarek, aby indeksowały wszystkie Twoje obrazy i przesłane pliki WordPress, używając dyrektywy Allow, która jest pomocnym poleceniem, które wyszukiwarki takie jak Google rozumieją.

Następnie uniemożliwia botom wyszukiwarek indeksowanie obszaru administracyjnego WordPress, domyślnego pliku readme.html (który może ujawnić wersję WordPress) oraz typowych katalogów dla ukrytych linków partnerskich, takich jak /refer/.

Dodając mapy witryn do pliku robots.txt, ułatwiasz botom Google znalezienie wszystkich stron w Twojej witrynie.

Teraz, gdy już wiesz, jak powinien wyglądać idealny plik robots.txt, przyjrzyjmy się, jak możesz utworzyć plik robots.txt w WordPressie.

Jak utworzyć plik Robots.txt w WordPress

Istnieją dwa sposoby utworzenia pliku robots.txt w WordPress. Możesz wybrać metodę, która najlepiej Ci odpowiada.

Metoda 1: Edycja pliku Robots.txt za pomocą All in One SEO

All in One SEO, znany również jako AIOSEO, to najlepsza wtyczka SEO dla WordPress na rynku, używana przez ponad 3 miliony witryn. Jest łatwa w użyciu i zawiera generator pliku robots.txt.

Aby dowiedzieć się więcej, zapoznaj się z naszą szczegółową recenzją AIOSEO.

Jeśli nie masz jeszcze zainstalowanego wtyczki AIOSEO, możesz zapoznać się z naszym przewodnikiem krok po kroku na temat jak zainstalować wtyczkę WordPress.

Uwaga: Dostępna jest również darmowa wersja AIOSEO, która posiada tę funkcję.

Po zainstalowaniu i aktywowaniu wtyczki możesz jej użyć do tworzenia i edycji pliku robots.txt bezpośrednio z panelu administracyjnego WordPress.

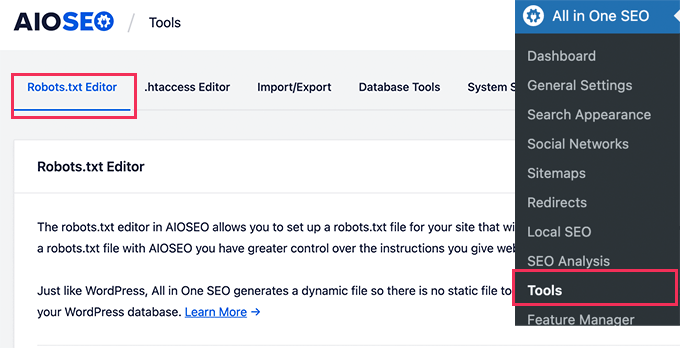

Po prostu przejdź do Wszystko w jednym SEO » Narzędzia, aby edytować plik robots.txt.

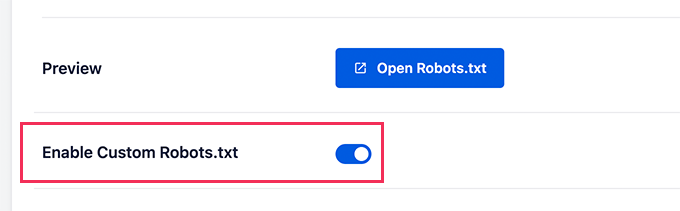

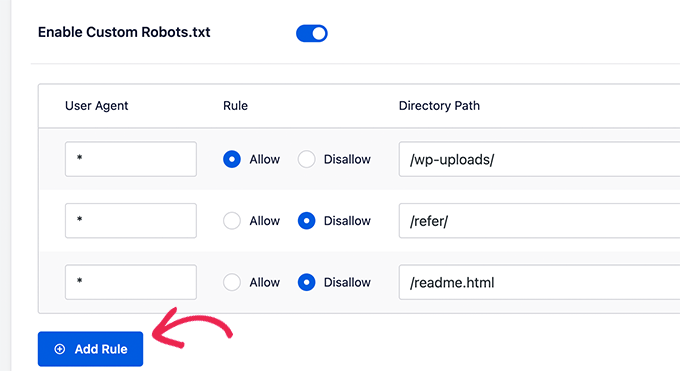

Najpierw musisz włączyć opcję edycji, klikając przełącznik „Włącz niestandardowy robots.txt” na niebiesko.

Dzięki temu przełącznikowi możesz utworzyć niestandardowy plik robots.txt w WordPress.

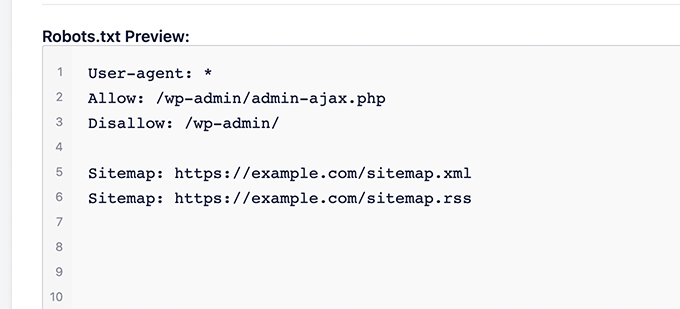

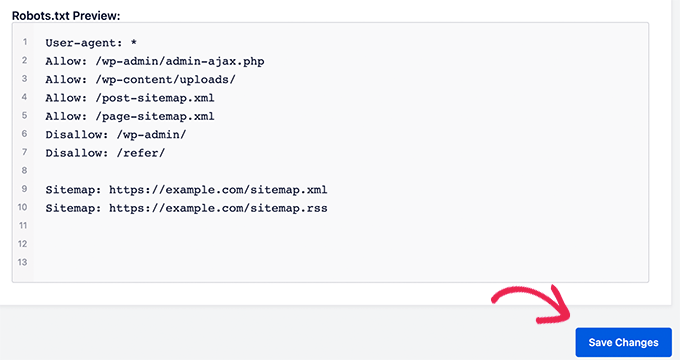

All in One SEO pokaże Twój istniejący plik robots.txt w sekcji „Podgląd Robots.txt” na dole ekranu.

Ta wersja pokaże domyślne reguły dodane przez WordPress.

Te domyślne reguły nakazują wyszukiwarkom nie indeksować Twoich podstawowych plików WordPress, zezwalają botom na indeksowanie całej zawartości i dostarczają im link do map witryny XML.

Teraz możesz dodać własne niestandardowe reguły, aby ulepszyć swój robots.txt dla SEO.

Aby dodać regułę, wprowadź agenta użytkownika w polu „Agent użytkownika”. Użycie * zastosuje regułę do wszystkich agentów użytkownika.

Następnie wybierz, czy chcesz zezwolić, czy zabronić wyszukiwarkom przeszukiwania.

Następnie wprowadź nazwę pliku lub ścieżkę katalogu w polu „Ścieżka katalogu”.

Reguła zostanie automatycznie zastosowana do Twojego pliku robots.txt. Aby dodać kolejną regułę, kliknij przycisk „Dodaj regułę”.

Zalecamy dodawanie reguł, dopóki nie stworzysz idealnego formatu robots.txt, który udostępniliśmy powyżej.

Twoje niestandardowe reguły będą wyglądać tak.

Po zakończeniu nie zapomnij kliknąć przycisku „Zapisz zmiany”, aby je zachować.

Metoda 2: Edycja pliku robots.txt za pomocą WPCode

WPCode to potężny wtyczka do fragmentów kodu, która pozwala łatwo i bezpiecznie dodawać niestandardowy kod do swojej witryny.

Zawiera również przydatną funkcję, która pozwala szybko edytować plik robots.txt.

Uwaga: Istnieje również bezpłatna wtyczka WPCode, ale nie zawiera ona funkcji edytora plików.

Pierwszą rzeczą, którą musisz zrobić, jest zainstalowanie wtyczki WPCode. Instrukcje krok po kroku znajdziesz w naszym przewodniku dla początkujących na temat jak zainstalować wtyczkę WordPress.

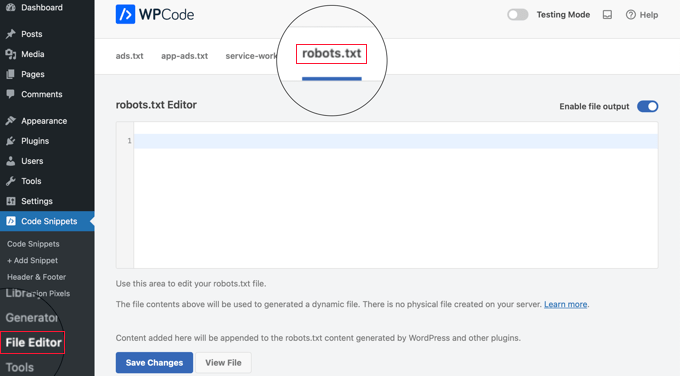

Po aktywacji musisz przejść do strony WPCode » Edytor plików. Po dotarciu tam, po prostu kliknij zakładkę „robots.txt”, aby edytować plik.

Teraz możesz wkleić lub wpisać zawartość pliku robots.txt.

Po zakończeniu upewnij się, że klikniesz przycisk „Zapisz zmiany” na dole strony, aby zapisać ustawienia.

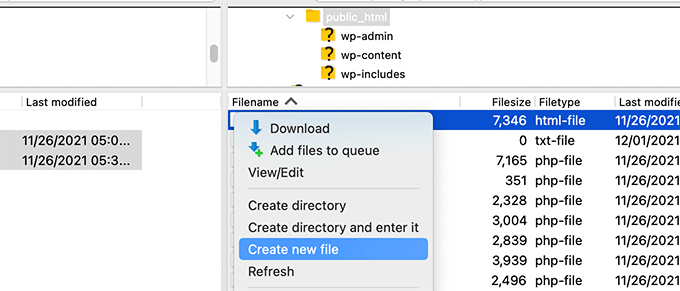

Metoda 3: Ręczna edycja pliku Robots.txt za pomocą FTP

W przypadku tej metody będziesz potrzebować klienta FTP do edycji pliku robots.txt. Alternatywnie możesz użyć menedżera plików dostarczonego przez hosting WordPress.

Wskazówka: Przed dokonaniem edycji zalecamy pobranie kopii zapasowej oryginalnego pliku robots.txt (jeśli istnieje) na swój komputer. W ten sposób można go łatwo przesłać ponownie, jeśli coś pójdzie nie tak.

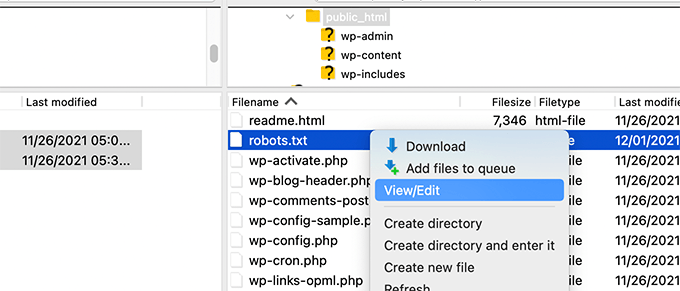

Po prostu połącz się z plikami swojej witryny WordPress za pomocą klienta FTP.

Po zalogowaniu będziesz mógł zobaczyć plik robots.txt w folderze głównym Twojej witryny.

Jeśli go nie widzisz, prawdopodobnie nie masz pliku robots.txt.

W takim przypadku możesz po prostu przejść dalej i go utworzyć.

Robots.txt to zwykły plik tekstowy, co oznacza, że możesz go pobrać na swój komputer i edytować za pomocą dowolnego edytora zwykłego tekstu, takiego jak Notatnik czy TextEdit.

Po zapisaniu zmian możesz przesłać plik robots.txt z powrotem do głównego folderu swojej witryny.

Jak przetestować plik Robots.txt

Po utworzeniu lub edycji pliku robots.txt warto sprawdzić go pod kątem błędów. Mała literówka może przypadkowo zablokować ważne strony przed wyszukiwarkami, dlatego ten krok jest niezwykle ważny! 👍

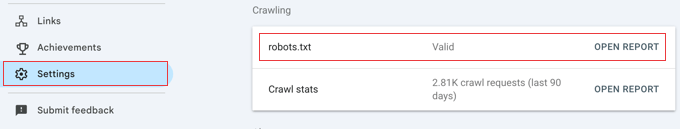

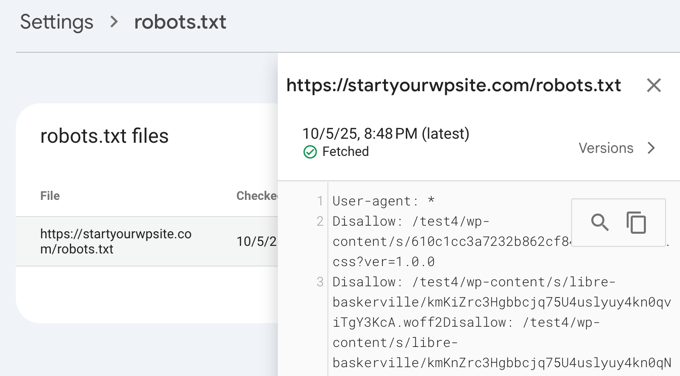

Chociaż Google kiedyś miało dedykowane narzędzie do testowania, teraz zintegrowali tę funkcję z głównymi raportami Google Search Console.

Najpierw upewnij się, że Twoja witryna jest połączona z Google Search Console. Jeśli jeszcze tego nie zrobiłeś, po prostu postępuj zgodnie z naszym prostym przewodnikiem na temat dodawania witryny WordPress do Google Search Console.

Po skonfigurowaniu przejdź do panelu Google Search Console. W menu po lewej stronie na dole wybierz Ustawienia.

Następnie znajdź sekcję „Crawling” i kliknij „Otwórz raport” obok „robots.txt”.

Po prostu kliknij bieżącą wersję pliku na liście.

Ten raport pokaże najnowszą wersję pliku robots.txt, którą Google znalazło. Podświetli wszelkie błędy składni lub problemy logiczne, które wykryło.

Nie martw się, jeśli właśnie zaktualizowałeś swój plik i nie widzisz od razu zmian. Google automatycznie sprawdza nową wersję pliku robots.txt mniej więcej raz dziennie.

Możesz później wrócić do tego raportu, aby potwierdzić, że Google wykrył Twoje najnowsze zmiany i że wszystko wygląda dobrze.

Końcowe przemyślenia

Celem optymalizacji pliku robots.txt jest zapobieganie przeszukiwaniu przez wyszukiwarki stron, które nie są publicznie dostępne. Na przykład stron w folderze wp-plugins lub stron w folderze administracyjnym WordPress.

Powszechnym mitem wśród ekspertów SEO jest to, że blokowanie kategorii, tagów i stron archiwów WordPress poprawi wskaźnik indeksowania i doprowadzi do szybszego indeksowania oraz wyższych pozycji.

To nieprawda. W rzeczywistości praktyka ta jest zdecydowanie odradzana przez Google i jest sprzeczna z ich najlepszymi praktykami dotyczącymi pomocy w zrozumieniu Twojej witryny.

Zalecamy postępowanie zgodnie z powyższym formatem robots.txt w celu utworzenia pliku robots.txt dla Twojej witryny.

Często zadawane pytania dotyczące robots.txt w WordPress

Oto niektóre z najczęstszych pytań, jakie otrzymujemy na temat optymalizacji pliku robots.txt w WordPress.

1. Jaki jest główny cel pliku robots.txt?

Głównym celem pliku robots.txt jest zarządzanie budżetem indeksowania Twojej witryny. Mówiąc wyszukiwarkom, które strony mają zignorować (takie jak strony administracyjne lub pliki wtyczek), pomagasz im efektywniej wykorzystywać zasoby do indeksowania i przeglądania Twoich najważniejszych treści.

2. Gdzie znajduje się plik robots.txt w WordPress?

Twój plik robots.txt znajduje się w głównym katalogu Twojej witryny. Zazwyczaj możesz go wyświetlić, wpisując w przeglądarce internetowej twojadomena.com/robots.txt.

3. Czy używanie robots.txt może poprawić bezpieczeństwo mojej witryny?

Nie, robots.txt nie jest środkiem bezpieczeństwa. Plik jest publicznie dostępny, więc w rzeczywistości nie blokuje nikogo przed dostępem do wymienionych adresów URL. Po prostu zawiera dyrektywy dla dobrze zachowujących się robotów wyszukiwarek.

4. Czy powinienem blokować strony kategorii i tagów WordPress w robots.txt?

Nie, nie powinieneś blokować stron kategorii i tagów. Te strony archiwalne są przydatne dla SEO, ponieważ pomagają wyszukiwarkom zrozumieć strukturę Twojej witryny i odkryć Twoje treści. Blokowanie ich może negatywnie wpłynąć na Twoje rankingi wyszukiwania.

Dodatkowe zasoby dotyczące korzystania z robots.txt w WordPress

Teraz, gdy wiesz, jak zoptymalizować plik robots.txt, możesz zapoznać się z innymi artykułami dotyczącymi używania pliku robots.txt w WordPress.

- Słowniczek: Robots.txt

- Jak ukryć stronę WordPress przed Google

- Jak uniemożliwić wyszukiwarkom indeksowanie strony WordPress

- Jak trwale usunąć witrynę WordPress z Internetu

- Jak łatwo ukryć (noindex) pliki PDF w WordPress

- Jak naprawić błąd „Googlebot nie może uzyskać dostępu do plików CSS i JS” w WordPressie

- Co to jest llms.txt? Jak dodać llms.txt w WordPress

- Jak poprawnie skonfigurować All in One SEO dla WordPress (Kompletny przewodnik)

Mamy nadzieję, że ten artykuł pomógł Ci nauczyć się optymalizować plik robots.txt WordPress dla SEO. Możesz również zapoznać się z naszym kompletnym przewodnikiem po SEO WordPress oraz naszymi ekskluzywnymi wyborami najlepszych narzędzi SEO WordPress, aby rozwijać swoją witrynę.

Jeśli podobał Ci się ten artykuł, zasubskrybuj nasz kanał YouTube po samouczki wideo WordPress. Możesz nas również znaleźć na Twitterze i Facebooku.

Dennis Muthomi

Muszę przyznać, że używam wtyczki AIOSEO, ale zawsze ignorowałem opcję „Włącz niestandardowy plik robots.txt”, ponieważ nie chciałem niczego zepsuć.

Ale przeczytałem ten artykuł i jestem przekonany, że warto poświęcić czas na optymalizację pliku robots.txt mojej witryny.

Amit Banerjee

Gdyby podano cały szablon robots.txt, byłoby to pomocne.

Wsparcie WPBeginner

We did include the entire robots.txt

Admin

Michael

Myślę, że powinieneś zmodyfikować swoją odpowiedź. Powinno być https zamiast http. Czy można zablokować również pliki wtyczek?

Wsparcie WPBeginner

Dziękujemy za zwrócenie uwagi, nasza próbka została zaktualizowana. Aby zablokować wtyczki, najlepiej skontaktować się z konkretną wtyczką.

Moinuddin Waheed

Dzięki za ten informacyjny post o pliku robots.txt.

Nie wiedziałem, że strony internetowe powinny utrzymywać ten plik, aby mieć kontrolę nad botami Google, jak powinny one indeksować nasze strony i posty.

Czy dla początkujących stron internetowych, które dopiero zaczynają, istnieje potrzeba posiadania pliku robots.txt, czy istnieje sposób, na przykład wtyczka, która może stworzyć plik robots.txt dla naszej strony internetowej?

Wsparcie WPBeginner

Większość wtyczek SEO pomaga w konfiguracji robots.txt dla nowej witryny, aby zapobiec indeksowaniu przez boty sekcji, których nie powinny.

Admin

Jiří Vaněk

Dzięki temu artykułowi sprawdziłem plik robots.txt i dodałem adresy URL z mapami witryn. Jednocześnie miałem tam inne problematyczne linie, które ujawnił walidator. Nie znałem wcześniej map witryn w robots.txt. Dziękuję.

Wsparcie WPBeginner

Proszę bardzo, cieszę się, że nasz przewodnik mógł pomóc!

Admin

Stéphane

Cześć,

Dzięki za ten post, staje się jaśniejsze, jak używać pliku robots.txt. Na większości stron internetowych, które znajdziesz szukając porad dotyczących pliku robots.txt, możesz zobaczyć, że następujące foldery są wyraźnie wykluczone z indeksowania (dla WordPressa):

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

Nie do końca rozumiem powody wykluczenia tych folderów (czy faktycznie jakiś jest?). Co byś o tym sądził?

Wsparcie WPBeginner

Chodzi głównie o to, aby zapobiec pojawianiu się czegokolwiek w tych folderach jako wynik, gdy użytkownik wyszukuje Twoją witrynę. Ponieważ nie jest to Twój kontent, większość ludzi nie chciałaby, aby pojawił się w wynikach witryny.

Admin

zaid haris

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

GSC pokazuje błąd pokrycia dla „Disallow: /wp-admin/”. Czy to jest błędne?

Wsparcie WPBeginner

W przypadku większości witryn nie chcesz, aby cokolwiek z Twojego wp-admin pojawiało się w wynikach wyszukiwania, więc jest to w porządku i oczekiwane, że otrzymasz obszar pokrycia, gdy odmówisz Google możliwości skanowania Twojego wp-admin.

Admin

Hansini

Tworzę mój robots.txt ręcznie, zgodnie z Twoimi instrukcjami dla mojej strony WordPress.

Mam jedno wątpliwość. kiedy piszę User-Agent: * czy nie pozwoli to innemu robotowi spamującemu na dostęp do mojej strony?

Czy powinienem napisać User-Agent: * czy User-Agent: Googlebot.?

Wsparcie WPBeginner

Linia User-Agent ustawia reguły, których wszystkie roboty powinny przestrzegać w Twojej witrynie; jeśli określisz konkretnego bota w tej linii, ustawiałbyś reguły dla tego konkretnego bota, a nie dla żadnego innego.

Admin

Nishant

Co powinniśmy napisać, aby Google zaindeksowało mój post?

Wsparcie WPBeginner

Aby Twoja witryna została uwzględniona w wynikach wyszukiwania, zapoznaj się z naszym poniższym artykułem:

https://www.wpbeginner.com/beginners-guide/how-do-i-get-my-wordpress-site-listed-on-google-beginners-guide/

Admin

Sanjeev Pandey

czy powinniśmy również zablokować /wp-content/themes/ ?

Pojawia się w wynikach wyszukiwania, gdy wpisuję polecenie site:abcdef.com w wyszukiwarce Google

Wsparcie WPBeginner

Nie chciałbyś martwić się o blokowanie folderu motywów, a pisząc treści przyjazne dla SEO, nie powinieneś już widzieć motywów jako wynik wyszukiwania.

Admin

Salem

Cześć, co oznacza „Disallow: /readme.html & Disallow: /refer/”?

Wsparcie WPBeginner

Oznacza to, że mówisz wyszukiwarkom, aby nie przeglądały żadnych linków polecających ani pliku readme.html.

Admin

sean

Cześć, jakie są zalety i wady blokowania wp-content/uploads

Dziękuję

Wsparcie WPBeginner

Jeśli zablokujesz folder przesyłania, wyszukiwarki zazwyczaj nie będą indeksować przesłanych treści, takich jak obrazy.

Admin

Piyush

dzięki za rozwiązanie mojego problemu

Wsparcie WPBeginner

You’re welcome

Admin

Ravi kumar

Panie, jestem bardzo zdezorientowany co do robot.txt, wiele razy przesyłałem mapę witryny na Bloggera, ale po 3-4 dniach pojawia się ten sam problem, co dokładnie oznacza robot.txt.. & jak to przesłać, proszę o wskazówki

Wsparcie WPBeginner

Zależałoby to od Twojego konkretnego problemu, możesz zapoznać się z naszą poniższą stroną:

https://www.wpbeginner.com/glossary/robots-txt/

Admin

Prem

Jeśli nie indeksuję adresu URL lub strony za pomocą pliku robots.txt, czy Google wyświetla jakiś błąd w konsoli wyszukiwania?

Wsparcie WPBeginner

Nie, Google nie umieści strony na liście, ale jeśli strona jest na liście, nie wyświetli błędu.

Admin

Bharat

Cześć

Mam pytanie

Otrzymałem ostrzeżenie o problemie z indeksowaniem w Google Search Console dotyczące zablokowania przez robots.txt

/wp-admin/widgets.php

Moje pytanie brzmi, czy mogę zezwolić na wp-admin/widgets.php w robots.txt i czy jest to bezpieczne?

Wsparcie WPBeginner

Jeśli chcesz, możesz, ale nie jest to plik, który Google musi indeksować.

Admin

Anthony

Witam, zastanawiam się, czy powinniście zezwolić na: /wp-admin/admin-ajax.php?

Wsparcie WPBeginner

Zazwyczaj tak, powinieneś.

Admin

Jaira

Czy mogę wiedzieć, dlaczego należy zezwolić na /wp-admin/admin-ajax.php?

Wsparcie WPBeginner

Jest on używany przez różne motywy i wtyczki, aby poprawnie wyświetlać się w wyszukiwarkach.

Amila

Witaj! Bardzo podoba mi się ten artykuł i ponieważ jestem początkujący we wszystkim, co dotyczy indeksowania, chciałbym o coś zapytać. Ostatnio Google zaindeksował jedną z moich stron internetowych w naprawdę okropny sposób, pokazując w wynikach wyszukiwania strony, które zostały usunięte z witryny. Początkowo witryna nie zniechęcała wyszukiwarek do indeksowania w ustawieniach WordPress, ale zrobiła to później, gdy Google pokazał jeszcze 3 dodatkowe strony w wynikach wyszukiwania (tych stron również nie ma) i naprawdę nie rozumiem, jak mogło się to zdarzyć przy włączonej opcji „zniechęcaj wyszukiwarki do indeksowania”. Czy metoda Yoast może być pomocna i rozwiązać problem mojej witryny, aby Google tym razem zaindeksował moją witrynę w odpowiedni sposób? Z góry dziękuję!

Wsparcie WPBeginner

Wtyczka Yoast powinna pomóc w zapewnieniu prawidłowego indeksowania stron, które posiadasz. Istnieje szansa, że zanim zniechęciłeś wyszukiwarki do indeksowania Twojej strony, Twoja strona została już zbuforowana.

Admin

Amila

Cóż, tak i ze wszystkich stron, zindeksował te, które już nie istnieją. Tak czy inaczej, ponieważ bieżąca strona ma ustawienie „zniechęcaj”, czy lepiej zostawić ją tak na razie, czy odznaczyć pole i pozwolić Google ponownie ją przeszukać i zaindeksować z pomocą Yoast? Dzięki! Z Twoimi artykułami wszystko stało się łatwiejsze!

Wsparcie WPBeginner

Będziesz chciał, aby Google ponownie przeskanowało Twoją witrynę, gdy zostanie ona skonfigurowana zgodnie z Twoimi oczekiwaniami.

Pradhuman Kumar

Cześć, uwielbiałem artykuł, bardzo precyzyjny i doskonały.

Tylko mała sugestia, proszę zaktualizuj obrazek testera ROBOTS.txt, ponieważ Konsola Google została zmieniona i byłoby wspaniale, gdybyś dodał link do sprawdzenia robots.txt z Google.

Wsparcie WPBeginner

Dziękujemy za opinię, z pewnością zajmiemy się aktualizacją artykułu, gdy tylko będzie to możliwe.

Admin

Kamaljeet Singh

Plik robots.txt mojego bloga wyglądał tak:

User-Agent: *

crawl-delay: 10

Po przeczytaniu tego posta zmieniłem go na zalecany plik robots.txt. Czy mogę usunąć crawl-delay?

Wsparcie WPBeginner

Powinno być w porządku, crawl-delay mówi wyszukiwarkom, aby spowolniły szybkość indeksowania Twojej witryny.

Admin

reena

Bardzo ładnie opisane o robot.text, jestem bardzo zadowolony

jesteś bardzo dobrym pisarzem

Wsparcie WPBeginner

Thank you, glad you liked our article

Admin

JJ

Co to jest strona Disallow: /refer/ ? Otrzymuję 404, czy to ukryty plik wp?

Personel redakcyjny

Używamy /refer/ do przekierowania do różnych linków partnerskich na naszej stronie internetowej. Nie chcemy, aby były one indeksowane, ponieważ są to tylko przekierowania, a nie faktyczna treść.

Admin

Sagar Arakh

Dziękuję za udostępnienie. To było naprawdę pomocne w zrozumieniu robots.txt

Zaktualizowałem mój robots.txt do idealnego, który zasugerowałeś. Teraz poczekam na wyniki.

Wsparcie WPBeginner

You’re welcome, glad you’re willing to use our recommendations

Admin

Akash Gogoi

Bardzo pomocny artykuł. Dziękuję bardzo.

Wsparcie WPBeginner

Glad our article was helpful

Admin

Zingylancer

Dziękuję za udostępnienie tych przydatnych informacji o nas.

Wsparcie WPBeginner

Glad we could share this information about the robots.txt file

Admin

Jasper

dziękuję za aktualne informacje. Twój artykuł był dobry dla pliku Robot txt. Zawierał nowe informacje. dziękuję i informuj mnie o nowych pomysłach.

Wsparcie WPBeginner

Glad our guide was helpful

Admin

Imran

Dzięki, dodałem robots.txt w WordPressie. Bardzo dobry artykuł

Wsparcie WPBeginner

Thank you, glad our article was helpful

Admin