To uczucie, gdy zdajesz sobie sprawę, że mały, przeoczony plik tekstowy może potajemnie sabotować SEO Twojej witryny. Wielu właścicieli witryn nie zdaje sobie sprawy, że prosty błąd w pliku robots.txt może uniemożliwić Google znalezienie ich najważniejszych treści.

Po audycie tysięcy witryn WordPress widzieliśmy, jak to się dzieje więcej razy, niż możemy policzyć. Dobra wiadomość jest taka, że naprawienie tego jest łatwiejsze, niż myślisz.

W tym przewodniku przeprowadzimy Cię przez dokładne, sprawdzone w boju kroki, które stosujemy, aby zoptymalizować plik robots.txt WordPress. Dowiesz się, jak zrobić to dobrze i zapewnić, że wyszukiwarki efektywnie indeksują Twoją witrynę.

Czujesz się przytłoczony? Oto szybki przegląd wszystkiego, co omówimy w tym przewodniku. Zachęcamy do przejścia do sekcji, która najbardziej Cię interesuje.

- Czym jest plik robots.txt?

- Czy potrzebujesz pliku Robots.txt dla swojej witryny WordPress?

- Jak wygląda idealny plik robots.txt?

- Jak utworzyć plik Robots.txt w WordPress

- Jak przetestować plik Robots.txt

- Końcowe przemyślenia

- Często zadawane pytania dotyczące robots.txt w WordPress

- Dodatkowe zasoby dotyczące korzystania z robots.txt w WordPress

Czym jest plik robots.txt?

Robots.txt to plik tekstowy, który właściciele witryn mogą utworzyć, aby poinformować boty wyszukiwarek, jak indeksować strony w ich witrynach.

Zazwyczaj jest przechowywany w katalogu głównym (znanym również jako główny folder) Twojej witryny. Podstawowy format pliku robots.txt wygląda następująco:

User-agent: [user-agent name]

Disallow: [URL string not to be crawled]

User-agent: [user-agent name]

Allow: [URL string to be crawled]

Sitemap: [URL of your XML Sitemap]

Możesz mieć wiele linii instrukcji zezwalających lub zabraniających indeksowania określonych adresów URL i dodawać wiele map witryn. Jeśli nie zabronisz indeksowania adresu URL, boty wyszukiwarek zakładają, że mogą go przeszukiwać.

Oto jak może wyglądać przykładowy plik robots.txt:

User-Agent: *

Allow: /wp-content/uploads/

Disallow: /wp-content/plugins/

Disallow: /wp-admin/

Sitemap: https://example.com/sitemap_index.xml

W powyższym przykładzie robots.txt zezwoliliśmy wyszukiwarkom na indeksowanie i przeszukiwanie plików w naszym folderze WordPress uploads.

Następnie zabroniliśmy botom wyszukiwarek indeksowania i przeglądania folderów wtyczek i panelu administracyjnego WordPress.

Na koniec podaliśmy adres URL naszej mapy witryny w formacie XML.

Czy potrzebujesz pliku Robots.txt dla swojej witryny WordPress?

Chociaż Twoja witryna może działać bez pliku robots.txt, konsekwentnie stwierdziliśmy, że witryny ze zoptymalizowanymi plikami robots.txt osiągają lepsze wyniki w wynikach wyszukiwania.

Dzięki naszej pracy z klientami z różnych branż widzieliśmy, jak właściwe zarządzanie budżetem indeksowania za pomocą robots.txt może prowadzić do szybszego indeksowania ważnych treści i lepszej ogólnej wydajności SEO.

Nie będzie to miało dużego wpływu, gdy dopiero rozpoczynasz bloga i nie masz dużo treści.

Jednak w miarę rozwoju Twojej witryny i dodawania większej ilości treści, prawdopodobnie będziesz chciał mieć lepszą kontrolę nad tym, jak Twoja witryna jest przeszukiwana i indeksowana.

Oto dlaczego.

Wyszukiwarki przydzielają każdej stronie internetowej to, co Google nazywa „budżetem indeksowania”. Jest to liczba stron, które przeszukają w określonym czasie.

W naszych testach na tysiącach witryn WordPress odkryliśmy, że większe witryny szczególnie korzystają z optymalizacji tego budżetu poprzez strategiczną konfigurację robots.txt.

Na przykład jeden z naszych klientów korporacyjnych odnotował 40% poprawę efektywności indeksowania po wdrożeniu naszych zalecanych optymalizacji robots.txt.

Możesz zablokować botom wyszukiwarek próbę indeksowania niepotrzebnych stron, takich jak strony administracyjne WordPress, pliki wtyczek i folder motywów.

Blokując niepotrzebne strony, oszczędzasz swój limit przeszukiwania. Pomaga to wyszukiwarkom szybciej przeszukiwać i indeksować więcej stron na Twojej witrynie.

Innym dobrym powodem do używania pliku robots.txt jest sytuacja, gdy chcesz zatrzymać wyszukiwarki przed indeksowaniem posta lub strony na swojej stronie internetowej.

Należy jednak pamiętać, że robots.txt nie jest najlepszym sposobem na ukrycie treści. Zablokowana strona może nadal pojawiać się w wynikach wyszukiwania, jeśli linkuje do niej inne witryny.

Jeśli chcesz niezawodnie zapobiec pojawieniu się strony w Google, zamiast tego powinieneś użyć tagu meta „noindex”. Informuje to wyszukiwarki, aby w ogóle nie dodawały strony do ich indeksu.

Jak wygląda idealny plik robots.txt?

Wiele popularnych blogów używa bardzo prostego pliku robots.txt. Ich zawartość może się różnić w zależności od potrzeb konkretnej witryny:

User-agent: *

Disallow:

Sitemap: https://www.example.com/post-sitemap.xml

Sitemap: https://www.example.com/page-sitemap.xml

Ten plik robots.txt pozwala wszystkim botom indeksować całą zawartość i zapewnia im link do map witryny XML.

Dla stron WordPress zalecamy następujące reguły w pliku robots.txt:

User-Agent: *

Allow: /wp-content/uploads/

Disallow: /wp-admin/

Disallow: /readme.html

Disallow: /refer/

Sitemap: https://www.example.com/post-sitemap.xml

Sitemap: https://www.example.com/page-sitemap.xml

To mówi botom wyszukiwarek, aby indeksowały wszystkie Twoje obrazy i przesłane pliki WordPress, używając dyrektywy Allow, która jest pomocnym poleceniem, które wyszukiwarki takie jak Google rozumieją.

Następnie uniemożliwia botom wyszukiwarek indeksowanie obszaru administracyjnego WordPress, domyślnego pliku readme.html (który może ujawnić wersję WordPress) oraz typowych katalogów dla ukrytych linków partnerskich, takich jak /refer/.

Dodając mapy witryn do pliku robots.txt, ułatwiasz botom Google znalezienie wszystkich stron w Twojej witrynie.

Teraz, gdy już wiesz, jak powinien wyglądać idealny plik robots.txt, przyjrzyjmy się, jak możesz utworzyć plik robots.txt w WordPressie.

Jak utworzyć plik Robots.txt w WordPress

Istnieją dwa sposoby utworzenia pliku robots.txt w WordPress. Możesz wybrać metodę, która najlepiej Ci odpowiada.

Metoda 1: Edycja pliku Robots.txt za pomocą All in One SEO

All in One SEO, znany również jako AIOSEO, to najlepsza wtyczka SEO dla WordPress na rynku, używana przez ponad 3 miliony witryn. Jest łatwa w użyciu i zawiera generator pliku robots.txt.

Aby dowiedzieć się więcej, zapoznaj się z naszą szczegółową recenzją AIOSEO.

Jeśli nie masz jeszcze zainstalowanego wtyczki AIOSEO, możesz zapoznać się z naszym przewodnikiem krok po kroku na temat jak zainstalować wtyczkę WordPress.

Uwaga: Dostępna jest również darmowa wersja AIOSEO, która posiada tę funkcję.

Po zainstalowaniu i aktywowaniu wtyczki możesz jej użyć do tworzenia i edycji pliku robots.txt bezpośrednio z panelu administracyjnego WordPress.

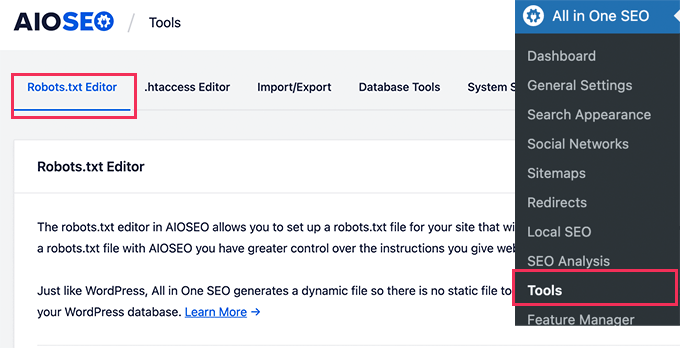

Po prostu przejdź do Wszystko w jednym SEO » Narzędzia, aby edytować plik robots.txt.

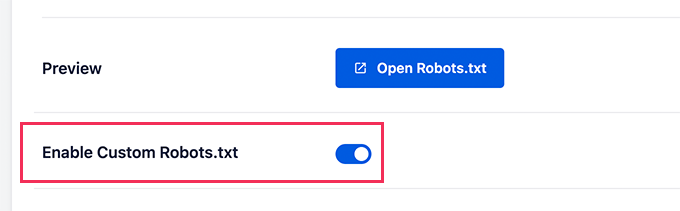

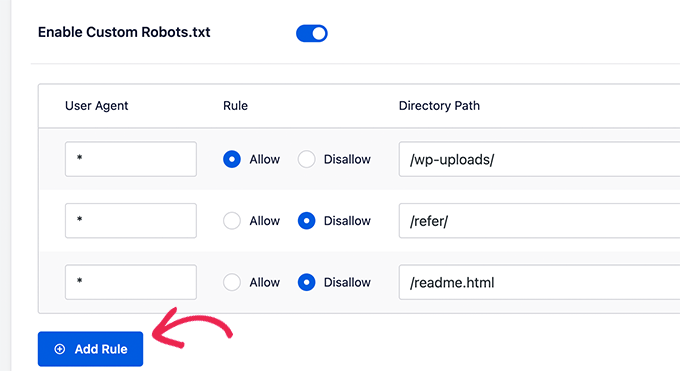

Najpierw musisz włączyć opcję edycji, klikając przełącznik „Włącz niestandardowy robots.txt” na niebiesko.

Dzięki temu przełącznikowi możesz utworzyć niestandardowy plik robots.txt w WordPress.

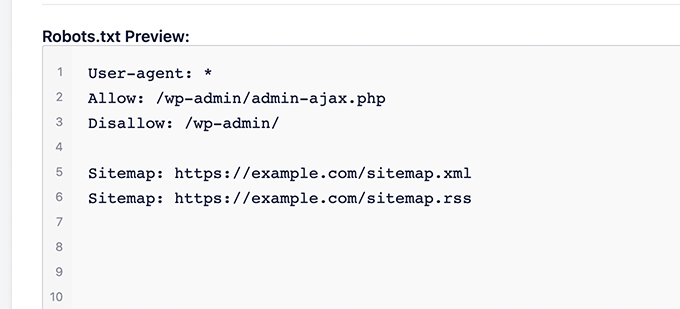

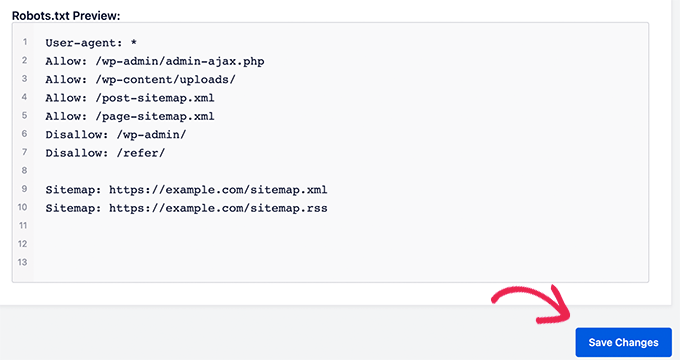

All in One SEO pokaże Twój istniejący plik robots.txt w sekcji „Podgląd Robots.txt” na dole ekranu.

Ta wersja pokaże domyślne reguły dodane przez WordPress.

Te domyślne reguły nakazują wyszukiwarkom nie indeksować Twoich podstawowych plików WordPress, zezwalają botom na indeksowanie całej zawartości i dostarczają im link do map witryny XML.

Teraz możesz dodać własne niestandardowe reguły, aby ulepszyć swój robots.txt dla SEO.

Aby dodać regułę, wprowadź agenta użytkownika w polu „Agent użytkownika”. Użycie * zastosuje regułę do wszystkich agentów użytkownika.

Następnie wybierz, czy chcesz zezwolić, czy zabronić wyszukiwarkom przeszukiwania.

Następnie wprowadź nazwę pliku lub ścieżkę katalogu w polu „Ścieżka katalogu”.

Reguła zostanie automatycznie zastosowana do Twojego pliku robots.txt. Aby dodać kolejną regułę, kliknij przycisk „Dodaj regułę”.

Zalecamy dodawanie reguł, dopóki nie stworzysz idealnego formatu robots.txt, który udostępniliśmy powyżej.

Twoje niestandardowe reguły będą wyglądać tak.

Po zakończeniu nie zapomnij kliknąć przycisku „Zapisz zmiany”, aby je zachować.

Metoda 2: Edycja pliku robots.txt za pomocą WPCode

WPCode to potężny wtyczka do fragmentów kodu, która pozwala łatwo i bezpiecznie dodawać niestandardowy kod do swojej witryny.

Zawiera również przydatną funkcję, która pozwala szybko edytować plik robots.txt.

Uwaga: Istnieje również bezpłatna wtyczka WPCode, ale nie zawiera ona funkcji edytora plików.

Pierwszą rzeczą, którą musisz zrobić, jest zainstalowanie wtyczki WPCode. Instrukcje krok po kroku znajdziesz w naszym przewodniku dla początkujących na temat jak zainstalować wtyczkę WordPress.

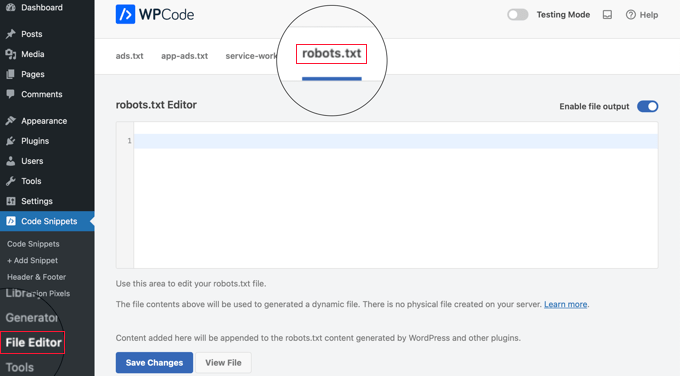

Po aktywacji musisz przejść do strony WPCode » Edytor plików. Po dotarciu tam, po prostu kliknij zakładkę „robots.txt”, aby edytować plik.

Teraz możesz wkleić lub wpisać zawartość pliku robots.txt.

Po zakończeniu upewnij się, że klikniesz przycisk „Zapisz zmiany” na dole strony, aby zapisać ustawienia.

Metoda 3: Ręczna edycja pliku Robots.txt za pomocą FTP

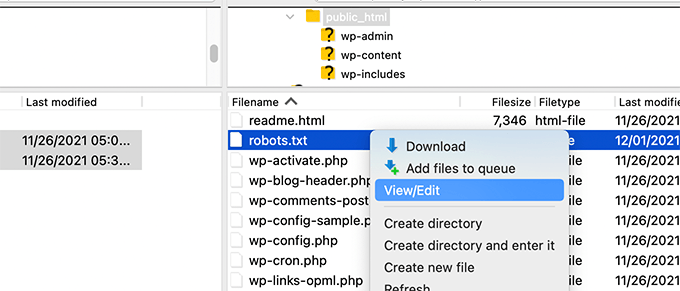

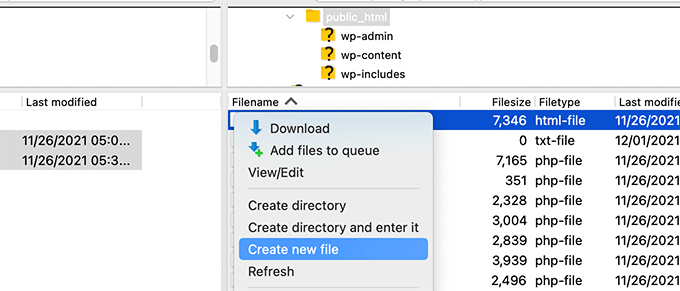

W przypadku tej metody będziesz potrzebować klienta FTP do edycji pliku robots.txt. Alternatywnie możesz użyć menedżera plików dostarczonego przez hosting WordPress.

Wskazówka: Przed dokonaniem edycji zalecamy pobranie kopii zapasowej oryginalnego pliku robots.txt (jeśli istnieje) na swój komputer. W ten sposób można go łatwo przesłać ponownie, jeśli coś pójdzie nie tak.

Po prostu połącz się z plikami swojej witryny WordPress za pomocą klienta FTP.

Po zalogowaniu będziesz mógł zobaczyć plik robots.txt w folderze głównym Twojej witryny.

Jeśli go nie widzisz, prawdopodobnie nie masz pliku robots.txt.

W takim przypadku możesz po prostu przejść dalej i go utworzyć.

Robots.txt to zwykły plik tekstowy, co oznacza, że możesz go pobrać na swój komputer i edytować za pomocą dowolnego edytora zwykłego tekstu, takiego jak Notatnik czy TextEdit.

Po zapisaniu zmian możesz przesłać plik robots.txt z powrotem do głównego folderu swojej witryny.

Jak przetestować plik Robots.txt

Po utworzeniu lub edycji pliku robots.txt warto sprawdzić go pod kątem błędów. Mała literówka może przypadkowo zablokować ważne strony przed wyszukiwarkami, dlatego ten krok jest niezwykle ważny! 👍

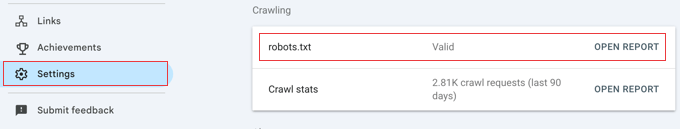

Chociaż Google kiedyś miało dedykowane narzędzie do testowania, teraz zintegrowali tę funkcję z głównymi raportami Google Search Console.

Najpierw upewnij się, że Twoja witryna jest połączona z Google Search Console. Jeśli jeszcze tego nie zrobiłeś, po prostu postępuj zgodnie z naszym prostym przewodnikiem na temat dodawania witryny WordPress do Google Search Console.

Po skonfigurowaniu przejdź do panelu Google Search Console. W menu po lewej stronie na dole wybierz Ustawienia.

Następnie znajdź sekcję „Crawling” i kliknij „Otwórz raport” obok „robots.txt”.

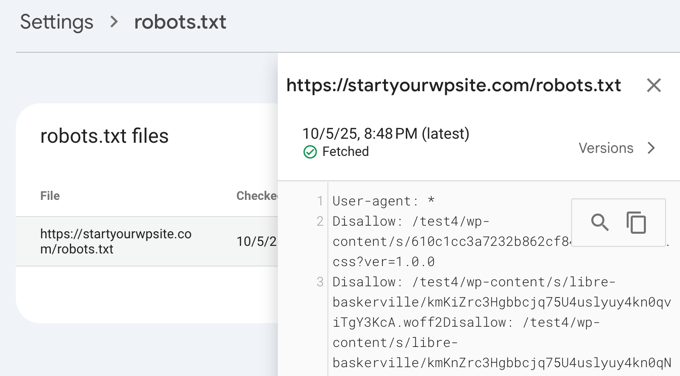

Po prostu kliknij bieżącą wersję pliku na liście.

Ten raport pokaże najnowszą wersję pliku robots.txt, którą Google znalazło. Podświetli wszelkie błędy składni lub problemy logiczne, które wykryło.

Nie martw się, jeśli właśnie zaktualizowałeś swój plik i nie widzisz od razu zmian. Google automatycznie sprawdza nową wersję pliku robots.txt mniej więcej raz dziennie.

Możesz później wrócić do tego raportu, aby potwierdzić, że Google wykrył Twoje najnowsze zmiany i że wszystko wygląda dobrze.

Końcowe przemyślenia

Celem optymalizacji pliku robots.txt jest zapobieganie przeszukiwaniu przez wyszukiwarki stron, które nie są publicznie dostępne. Na przykład stron w folderze wp-plugins lub stron w folderze administracyjnym WordPress.

Powszechnym mitem wśród ekspertów SEO jest to, że blokowanie kategorii, tagów i stron archiwów WordPress poprawi wskaźnik indeksowania i doprowadzi do szybszego indeksowania oraz wyższych pozycji.

To nieprawda. W rzeczywistości praktyka ta jest zdecydowanie odradzana przez Google i jest sprzeczna z ich najlepszymi praktykami dotyczącymi pomocy w zrozumieniu Twojej witryny.

Zalecamy postępowanie zgodnie z powyższym formatem robots.txt w celu utworzenia pliku robots.txt dla Twojej witryny.

Często zadawane pytania dotyczące robots.txt w WordPress

Oto niektóre z najczęstszych pytań, jakie otrzymujemy na temat optymalizacji pliku robots.txt w WordPress.

1. Jaki jest główny cel pliku robots.txt?

Głównym celem pliku robots.txt jest zarządzanie budżetem indeksowania Twojej witryny. Mówiąc wyszukiwarkom, które strony mają zignorować (takie jak strony administracyjne lub pliki wtyczek), pomagasz im efektywniej wykorzystywać zasoby do indeksowania i przeglądania Twoich najważniejszych treści.

2. Gdzie znajduje się plik robots.txt w WordPress?

Twój plik robots.txt znajduje się w głównym katalogu Twojej witryny. Zazwyczaj możesz go wyświetlić, wpisując w przeglądarce internetowej twojadomena.com/robots.txt.

3. Czy używanie robots.txt może poprawić bezpieczeństwo mojej witryny?

Nie, robots.txt nie jest środkiem bezpieczeństwa. Plik jest publicznie dostępny, więc w rzeczywistości nie blokuje nikogo przed dostępem do wymienionych adresów URL. Po prostu zawiera dyrektywy dla dobrze zachowujących się robotów wyszukiwarek.

4. Czy powinienem blokować strony kategorii i tagów WordPress w robots.txt?

Nie, nie powinieneś blokować stron kategorii i tagów. Te strony archiwalne są przydatne dla SEO, ponieważ pomagają wyszukiwarkom zrozumieć strukturę Twojej witryny i odkryć Twoje treści. Blokowanie ich może negatywnie wpłynąć na Twoje rankingi wyszukiwania.

Dodatkowe zasoby dotyczące korzystania z robots.txt w WordPress

Teraz, gdy wiesz, jak zoptymalizować plik robots.txt, możesz zapoznać się z innymi artykułami dotyczącymi używania pliku robots.txt w WordPress.

- Słowniczek: Robots.txt

- Jak ukryć stronę WordPress przed Google

- Jak uniemożliwić wyszukiwarkom indeksowanie strony WordPress

- Jak trwale usunąć witrynę WordPress z Internetu

- Jak łatwo ukryć (noindex) pliki PDF w WordPress

- Jak naprawić błąd „Googlebot nie może uzyskać dostępu do plików CSS i JS” w WordPressie

- Co to jest llms.txt? Jak dodać llms.txt w WordPress

- Jak poprawnie skonfigurować All in One SEO dla WordPress (Kompletny przewodnik)

Mamy nadzieję, że ten artykuł pomógł Ci nauczyć się optymalizować plik robots.txt WordPress dla SEO. Możesz również zapoznać się z naszym kompletnym przewodnikiem po SEO WordPress oraz naszymi ekskluzywnymi wyborami najlepszych narzędzi SEO WordPress, aby rozwijać swoją witrynę.

Jeśli podobał Ci się ten artykuł, zasubskrybuj nasz kanał YouTube po samouczki wideo WordPress. Możesz nas również znaleźć na Twitterze i Facebooku.

Steve

Dzięki za to – jak to działa na WP Multisite?

Wsparcie WPBeginner

W przypadku multisite, musiałbyś mieć plik robots.txt w głównym folderze każdej witryny.

Admin

Pacifique Ndanyuzwe

Moja strona wordpress jest nowa, a mój plik robot.txt domyślnie wygląda tak:

user-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

Chcę, aby Google indeksował moje treści. Czy ten robots.txt jest w porządku?

Wsparcie WPBeginner

Możesz oczywiście tego użyć, jeśli chcesz

Admin

Ritesh Seth

Świetny artykuł…

Od wielu dni miałem wątpliwości co do pliku Robots.txt i linków Disallow. Skopiowałem tagi dla pliku robots. Mam nadzieję, że to rozwiąże problem mojej witryny

Wsparcie WPBeginner

We hope our article will help as well

Admin

Kurt

Pliki na zrzutach ekranu mojego folderu głównego znajdują się faktycznie w folderze public_html w moim folderze głównym.

Nie miałem folderu /refer pod moim folderem public_html.

Nie miałem plików xml postów ani stron nigdzie na moim koncie WP.

Uwzględniłem wpis w pliku robots.txt, który utworzyłem, aby zablokować indeksowanie mojej strony-piaskownicy. Nie jestem pewien, czy jest to konieczne, ponieważ już wybrałem opcję w WP, która mówi robotom, aby nie indeksowały mojej strony-piaskownicy, ale myślę, że dodanie tego wpisu nie zaszkodzi.

Wsparcie WPBeginner

Some hosts do rename public_html to home which is why you see it there. You would want to ensure Yoast is active for the XML files to be available. The method in this article is an additional precaution to help with preventing crawling your site

Admin

Ahmed

Świetny artykuł

Wsparcie WPBeginner

Thank you

Admin

ASHOK KUMAR JADON

Cześć, taki miły artykuł, rozwiązałeś mój problem. Dziękuję bardzo

Wsparcie WPBeginner

Glad our article could help

Admin

Elyn Ashton

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php <– To jest mój kod robot.txt, ale nie rozumiem, dlaczego mój /wp-admin jest indeksowany? Jak go nie indeksować?

Wsparcie WPBeginner

Jeśli zostało wcześniej zaindeksowane, może być konieczne odczekanie, aż pamięć podręczna wyszukiwarki zostanie wyczyszczona

Admin

Ashish kumar

Ta strona naprawdę inspiruje mnie do założenia bloga. Dziękuję za wiele tematów. Każdy artykuł na tej stronie jest bogaty w informacje i wyjaśnienia. Kiedy mam jakiś problem, najpierw odwiedzam ten blog. Dziękuję

Wsparcie WPBeginner

Glad our articles can be helpful

Admin

Anna

Próbuję zoptymalizować roboty dla mojej strony internetowej za pomocą Yoast. Jednak Narzędzia w Yoast nie mają opcji „Edytor plików”.

Są tylko dwie opcje

(i) Import i eksport

(ii) Edytor masowy

Czy możesz doradzić, jak można to rozwiązać. Czy to możliwe, że korzystam z darmowej wersji Yoast?

Wsparcie WPBeginner

Darmowa wersja Yoast nadal ma tę opcję, Twoja instalacja może blokować edycję plików, w takim przypadku prawdopodobnie będziesz musiał użyć metody FTP.

Admin

Emmanuel Husseni

Naprawdę uważam ten artykuł za pomocny, ponieważ naprawdę niewiele wiem o tym, jak działa robot.txt, ale teraz wiem.

Proszę, czego nie rozumiem, to jak znaleźć najlepszy format robot.txt do użycia na mojej stronie (mam na myśli taki, który działa ogólnie)?

Zauważyłem, że wiele dużych blogów, które sprawdzam, zajmuje wysokie pozycje w wyszukiwarkach i używa innego formatu robot.txt..

Chętnie zobaczę odpowiedź od Ciebie lub kogokolwiek, kto może pomóc.

Personel redakcyjny

Posiadanie mapy witryny i zezwolenie na obszary, które wymagają zezwolenia, jest najważniejszą częścią. Część z odmową będzie się różnić w zależności od każdej witryny. Udostępniliśmy przykład w naszym poście na blogu, i to powinno wystarczyć dla większości witryn WordPress.

Admin

Wsparcie WPBeginner

Cześć Emmanuel,

Proszę zapoznać się z sekcją dotyczącą idealnego pliku robots.txt. Zależy to od Twoich własnych wymagań. Większość blogerów wyklucza foldery administracyjne WordPress i foldery wtyczek z indeksowania.

Admin

Emmanuel Husseni

Dziękuję bardzo.

teraz rozumiem. Chyba zacznę od ogólnego formatu na razie.

jack

Dobrze napisany artykuł, polecam użytkownikom utworzenie mapy witryny przed utworzeniem i włączeniem ich tekstu ROBOTS, pomoże to Twojej witrynie szybciej się indeksować i łatwiej ją przeszukiwać.

Jack

Connie S Owens

Chciałbym uniemożliwić wyszukiwarkom indeksowanie moich archiwów podczas ich indeksowania.

Emmanuel Nonye

Wielkie dzięki, ten artykuł był naprawdę pomocny

Cherisa

Ciągle otrzymuję poniższy komunikat o błędzie w Google Webmaster. Jestem w zasadzie zablokowany. Kilka rzeczy, które nie były dla mnie jasne w tym poradniku, to: gdzie znaleźć pliki główne mojej witryny, jak sprawdzić, czy mam już „robots.txt” i jak go edytować?

Wsparcie WPBeginner

Cześć Cherisa,

Folder główny Twojej witryny to ten, który zawiera foldery takie jak wp-admin, wp-includes, wp-content itp. Zawiera również pliki takie jak wp-config.php, wp-cron.php, wp-blogheader.php itp.

Jeśli nie widzisz pliku robots.txt w tym folderze, to go nie masz. Możesz śmiało utworzyć nowy.

Admin

Cherisa

Dziękuję za odpowiedź. Szukałem wszędzie i nie mogę znaleźć tych głównych plików, tak jak opisujesz. Czy jest jakaś ścieżka katalogu, którą mogę podążać, prowadząca do tego folderu? Na przykład, czy jest on pod Ustawieniami itp.?

Devender

Miałem przyzwoity ruch internetowy na mojej stronie. Nagle spadł do zera w miesiącu maju. Do tej pory mam problem. Proszę, pomóż mi odzyskać moją stronę.

Haris Aslam

Witaj, dziękuję za te informacje, ale mam pytanie.

Właśnie utworzyłem pliki sitemap.xml i robots.txt, i są one dobrze indeksowane. Ale jak mogę utworzyć „Product-Sitemap.xml”?

W pliku sitemap.xml znajduje się cała lista produktów. Czy muszę utworzyć Product-sitemap.xml osobno?

i ponownie przesłać do Google lub Bing?

Czy możesz mi pomóc...

Dziękuję

Mahadi Hassan

Mam problem z ustawieniem pliku robots.txt. Tylko jeden robots.txt jest wyświetlany dla wszystkich stron internetowych. Proszę, pomóż mi wyświetlić osobny plik robots.txt dla wszystkich stron internetowych. Mam wszystkie osobne pliki robots.txt dla każdej indywidualnej strony internetowej. Ale tylko jeden plik robots.txt jest wyświetlany w przeglądarce dla wszystkich stron internetowych.

Debu Majumdar

Proszę wyjaśnij, dlaczego włączyłeś

Disallow: /refer/

w przykładzie Robots.txt dla początkujących? Nie rozumiem implikacji tej linii. Czy jest to ważne dla początkujących? Wyjaśniłeś pozostałe dwie linie z Disallow.

Dzięki.

Wsparcie WPBeginner

Cześć Debu,

Ten przykład pochodzi z pliku robots.txt WPBeginner. W WPBeginner używamy ThirstyAffiliates do zarządzania linkami partnerskimi i ukrywania adresów URL. Te adresy URL zawierają /refer/, dlatego blokujemy je w naszym pliku robots.txt.

Admin

Evaristo

Jak mogę umieścić wszystkie tagi/mydomain.Com w nofollow? W robots.txt, aby skoncentrować link Juice? Dzięki.

harsh kumar

cześć,, mam błąd w yoast seo dotyczący mapy strony.. gdy klikam napraw, to pojawia się ponownie.. moja strona html nie ładuje się poprawnie

Tom

Przeglądałem właśnie moje konto Google Search Console i korzystając z Narzędzi dla webmasterów Google, znalazłem następujące informacje:

Strona załadowana częściowo

Nie wszystkie zasoby strony mogły zostać załadowane. Może to wpłynąć na sposób, w jaki Google widzi i rozumie Twoją stronę. Rozwiąż problemy z dostępnością wszelkich zasobów, które mogą wpłynąć na sposób, w jaki Google rozumie Twoją stronę.

Dzieje się tak, ponieważ wszystkie arkusze stylów CSS powiązane z wtyczkami są niedozwolone przez domyślny robots.txt.

Rozumiem dobre powody, dla których nie powinienem po prostu zezwalać na to, ale jaka byłaby alternatywa, ponieważ podejrzewam, że algorytmy Google obniżają ocenę witryny za ich niewidzenie.

Suren

Cześć,

Kiedy wyszukuję moją witrynę w Google, poniżej linku pojawia się tekst: „Opis tego wyniku nie jest dostępny z powodu pliku robots.txt tej witryny”.

Jak mogę rozwiązać ten problem?

Pozdrawiam

Wsparcie WPBeginner

Cześć Suren,

Wygląda na to, że ktoś przypadkowo zmienił ustawienia prywatności Twojej witryny. Przejdź do strony Ustawienia » Czytanie i przewiń w dół do sekcji „Widoczność dla wyszukiwarek”. Upewnij się, że pole obok jest odznaczone.

Admin

Divyesh

Cześć

Jak widziałem w narzędziu dla webmasterów, mam plik robot.txt jak poniżej:

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

daj znać, czy jest OK? czy powinienem użyć czegoś innego?

John Cester

Chciałbym wiedzieć, czy dobrym pomysłem jest blokowanie (niedozwalanie) „/wp-content/plugins/” w robots.tx? Za każdym razem, gdy usuwam wtyczkę, na niektórych stronach tej wtyczki pojawia się błąd 404.

Himanshu singh

Uwielbiałem to wyjaśnienie. Jako początkujący byłem bardzo zdezorientowany plikiem robot.txt i jego zastosowaniami. Ale teraz wiem, jaki jest jego cel.

rahul

W niektórych plikach robots.txt zablokowano index.php. Czy możesz wyjaśnić dlaczego? Czy jest to dobra praktyka.

Waleed Barakat

Dzięki za podzielenie się cennymi informacjami.

Awais Ahmed

Czy możesz mi powiedzieć, dlaczego tak się dzieje w narzędziu dla webmasterów:

Sieć niedostępna: robots.txt niedostępnyNie udało nam się zaindeksować mapy witryny, ponieważ znaleźliśmy plik robots.txt w głównym katalogu Twojej witryny, ale nie udało nam się go pobrać. Upewnij się, że jest dostępny lub usuń go całkowicie.

plik robots.txt istnieje, ale nadal

Dozza

Ciekawa aktualizacja od zespołu Yoast na ten temat pod adresem

Cytat: „Stare najlepsze praktyki dotyczące pliku robots.txt blokującego dostęp do katalogu wp-includes i katalogu wtyczek nie są już ważne.”

natveimaging

Allow: /wp-content/uploads/

Czy tak nie powinno być?

Disallow: /wp-content/uploads/

Ponieważ wiesz, że Google zaindeksuje wszystkie twoje przesłane strony jako publiczne adresy URL, prawda? A potem dostaniesz błędy dotyczące samej strony. Czy czegoś tu nie rozumiem?

nativeimaging

Ogólnie rzecz biorąc, to rzeczywiste strony są indeksowane przez Google do generowania map obrazów, a NIE foldery z przesłanymi plikami. Wtedy pojawiłby się problem wszystkich mniejszych rozmiarów obrazów i innych obrazów, które służą do interfejsu użytkownika, również zostaną zaindeksowane.

To wydaje się najlepszą opcją:

Disallow: /wp-content/uploads/

Jeśli się mylę, proszę, wyjaśnij mi to, abym mógł zrozumieć Twój punkt widzenia.

Jason

Mój adres URL bloga nie jest indeksowany, czy muszę zmienić mój robots.txt? Używam tego robots.txt

iyan

jak stworzyć plik robot txt, który zezwala na indeksowanie TYLKO stron i Postów.. dzięki

Simaran Singh

Nie jestem pewien, co jest problemem, ale mój robots.txt ma dwie wersje. Jedna pod adresem http://www.example.com/robots.txt, a druga pod adresem example.com/robots.txt

Ktokolwiek, proszę, pomóż! Dajcie mi znać, jaka może być możliwa przyczyna i jak to naprawić?

Wsparcie WPBeginner

Najprawdopodobniej Twój hosting pozwala na dostęp do Twojej witryny zarówno z adresów www, jak i bez www. Spróbuj zmienić robots.txt za pomocą klienta FTP. Następnie sprawdź go z obu adresów URL, jeśli widzisz swoje zmiany na obu adresach, oznacza to, że jest to ten sam plik.

Admin

Simaran Singh

Dzięki za szybką odpowiedź. Już to zrobiłem, ale nie widzę żadnej zmiany. Czy jest inny sposób, aby to rozwiązać?

Martin Conde

Yoasts blogpost about this topic was right above yours in my search so of course I checked them both. They are contradicting each other a little bit.. For example yoast said that disallowing plugin directories and others, might hinder the Google crawlers when fetching your site since plugins may output css or js. Also mentioned (and from my own experience), yoast doesn’t add anything sitemap related to the robots.txt, rather generates it so that you can add it to your search console. Here is the link to his post, maybe you can re-check because it is very hard to choose whose word to take for it

MM Nauman

Ponieważ nie jestem dobry w tworzeniu pliku robots.txt, czy mogę użyć Twojego pliku robots.txt, zmieniając parametry takie jak adres URL i mapa witryny mojej strony, czy to jest dobre? Czy powinienem stworzyć inny?

Mohit Chauhan

Cześć,

Dzisiaj dostałem tego maila od Google „Googlebot nie może uzyskać dostępu do plików CSS i JS”… jakie może być rozwiązanie?

Dzięki

Parmod

Pozwól, że zgadnę… Używasz usług CDN do importowania plików CSS i JS. lub Możliwe, że napisałeś złą składnię w tych plikach.

Rahul

Mam pytanie dotyczące dodawania map witryn. Jak mogę dodać mapy witryn Yahoo i Bing do pliku Robots i katalogu WordPress?

Gerbrand Petersen

Dzięki za szczegółowy opis używania pliku robots.txt. Czy ktoś wie, czy Yahoo również korzysta z tego robots.txt i czy przestrzega zasad w nim zawartych? Pytam, ponieważ mam „Disallow” dla określonej strony w moim pliku, ale otrzymuję ruch z Yahoo na tej stronie. Nic z Google, tak jak powinno być. Z góry dziękuję.

Erwin

poprawka…

„Jeśli używasz wtyczki Yoast’s WordPress SEO lub innej wtyczki do generowania mapy witryny XML, Twoja wtyczka spróbuje automatycznie dodać linie związane z mapą witryny do pliku robots.txt.”

Nieprawda. WordPress SEO nie dodaje mapy witryny do robots.txt

„Zawsze uważałem, że linkowanie do mapy witryny XML z pliku robots.txt jest trochę bez sensu. Powinieneś dodawać je ręcznie do Narzędzi Google i Bing dla Webmasterów i zwracać uwagę na ich opinie dotyczące mapy witryny XML. Z tego powodu nasza wtyczka WordPress SEO nie dodaje jej do pliku robots.txt.”

https://yoast.com/wordpress-robots-txt-example/

Bardziej zalecane jest również niedysallowanie katalogu wp-plugins (powody zobacz post Yoast)

A osobiście wolę po prostu usunąć plik readme.txt...

hyma

Zrozumiałem plik robots.txt i jego użycie. Czym jest mapa witryny i jak ją utworzyć dla mojej witryny.

Rick R. Duncan

Po przeczytaniu dokumentacji Google mam wrażenie, że dyrektywą do użycia w pliku robots.txt jest disallow, która tylko mówi botom, co mogą, a czego nie mogą indeksować. Nie mówi im, co może, a co nie może być indeksowane. Aby strona nie była indeksowana, musisz użyć meta tagu robots noindex.

Nitin

naprawdę dobry artykuł o zoptymalizowanym pod kątem SEO pliku robots.txt. Ale potrzebuję samouczka, jak przesłać plik robots.txt na serwer. Ponieważ jako początkujący wydaje się to być ogromnym problemem z przesłaniem tego pliku.

Nawiasem mówiąc, dziękuję za udostępnienie tak korzystnych informacji.

-Nitin

Parmod

Prześlij go na swój serwer/public_hmtl/(Nazwa-Twojej-witryny) … w tym folderze

Jenny

Jaki jest najlepszy sposób na dodanie kodu do HTTacess, aby zablokować wielu spamujących botów referujących ze względu na ich adres URL i adres IP, jeśli nie podano adresu URL

Wiem, że jeśli popełnisz błąd składniowy podczas edycji pliku httacess, możesz wyłączyć swoją stronę. Jestem początkujący i muszę zablokować te irytujące wielokrotne adresy URL z Rosji, Chin, Ukrainy itp.

Wielkie dzięki

Hazel Andrews

Dzięki za te wskazówki... pliki robots txt już poprawione! yay!

Rahat

dlaczego trzeba dodać Allow: !!!

jeśli wspomnę tylko, co mam Disallow, to wystarczy. Nie muszę pisać kodu dla Allow, ponieważ Googlebot lub Bingbot automatycznie zaindeksuje wszystko inne.

Więc dlaczego mam ponownie używać Allow?

Connor Rickett

Ponieważ brak pliku Robots.txt nie powstrzymuje witryny przed indeksowaniem, jestem ciekawy: czy istnieją jakieś twarde dane na temat tego, jak bardzo posiadanie tego pliku poprawi wydajność SEO?

Szybko przeszukałem Google i nie znalazłem żadnych ilościowych danych na ten temat. Jest około pół miliona artykułów mówiących: „Hej, to poprawia SEO!”, ale naprawdę chciałbym wiedzieć, o czym mówimy, nawet ogólnie.

Czy to jest 5% wzrostu? 50? 500?

Wsparcie WPBeginner

Wyszukiwarki nie udostępniają takich danych. Brak pliku robots.txt nie powstrzymuje wyszukiwarek przed indeksowaniem strony. Jest to jednak zalecana najlepsza praktyka.

Admin

Connor Rickett

Dziękuję za poświęcony czas na odpowiedź, doceniam to!

JD Myers

Dobry czas na to. Właśnie wczoraj próbowałem znaleźć te informacje.

Powodem, dla którego go szukałem, było to, że narzędzia Google Webmaster Tools informowały mnie, że nie mogą prawidłowo indeksować mojej witryny, ponieważ blokowałem różne zasoby potrzebne do prawidłowego renderowania strony.

Zasoby te obejmowały te znalezione w /wp-content/plugins/

Po zezwoleniu na ten folder ostrzeżenie zniknęło.

Masz jakieś przemyślenia na ten temat?

Wsparcie WPBeginner

Możesz bezpiecznie zignorować te ostrzeżenia. Jest to tylko ostrzeżenie, jeśli faktycznie miałeś tam treść, którą chciałbyś zaindeksować. Czasami użytkownicy ograniczyli boty wyszukiwarek i zapomnieli o tym. Te ostrzeżenia są przydatne w takich sytuacjach.

Admin

Chetan jadhav

Mam pytanie, wielu ludzi używa statycznych map witryn, a wiesz, że mają stronę WordPress. Czy powinniśmy używać statycznych, czy map generowanych przez WordPress.

Wilton Calderon

Fajnie, podoba mi się sposób, w jaki robi to Wpbeginner, a biorąc pod uwagę ich pozycję w Alexie, wydaje mi się, że to jeden z najlepszych sposobów na wykorzystanie robots.txt..

Brigitte Burke

co oznacza mój plik robots.txt, jeśli wygląda tak?

User-agent: * Disallow: /wp-admin/ Disallow: /wp-includes/ Disallow: /xmlrpc.php

Personel redakcyjny

Mówi tylko, że wyszukiwarki nie powinny indeksować folderu wp-admin, folderu wp-includes i pliku xml-rpc. Czasami zablokowanie /wp-includes/ może zablokować niektóre skrypty dla wyszukiwarek, zwłaszcza jeśli Twoja witryna korzysta z tych skryptów. Może to zaszkodzić Twojemu SEO.

Najlepszym rozwiązaniem jest przejście do Narzędzi dla webmasterów Google i pobranie swojej witryny jako bota. Jeśli wszystko ładuje się poprawnie, nie masz się czym martwić. Jeśli mówi, że skrypty są zablokowane, możesz rozważyć usunięcie linii wp-includes.

Admin

hercules

Nie widzę logiki w Twoim pomyśle posiadania skryptu w katalogu includes, który może być używany przez robota / bota... a po drugie, jeśli jest odosobniony przypadek, lepiej jest po określeniu domyślnego WordPressa zezwolić na ten plik, wyobrażasz sobie, że wyszukiwarki używają swoich skryptów! w końcu WordPress z pewnością nie ma domyślnie pliku robots.txt blokującego wyszukiwarki!!!!