Este un sentiment de scufundare când realizezi că un fișier text mic, trecut cu vederea, ar putea sabota în tăcere SEO-ul site-ului tău. Mulți proprietari de site-uri nu își dau seama că o greșeală simplă în fișierul lor robots.txt poate împiedica Google să găsească cel mai important conținut al lor.

După auditarea a mii de site-uri WordPress, am văzut acest lucru întâmplându-se de mai multe ori decât putem număra. Vestea bună este că remedierea este mai ușoară decât crezi.

În acest ghid, vă vom prezenta pașii exacți, testați în luptă, pe care îi folosim pentru a optimiza un fișier robots.txt WordPress. Veți învăța cum să îl faceți corect și să vă asigurați că motoarele de căutare vă accesează site-ul eficient.

Te simți copleșit? Iată o prezentare rapidă a tot ceea ce vom acoperi în acest ghid. Nu ezitați să săriți la secțiunea care vă interesează cel mai mult.

- Ce este un fișier Robots.txt?

- Ai Nevoie de un Fișier Robots.txt pentru Site-ul Tău WordPress?

- Cum arată un fișier robots.txt ideal?

- Cum să creezi un fișier Robots.txt în WordPress

- Cum să-ți testezi fișierul Robots.txt

- Gânduri finale

- Întrebări frecvente despre Robots.txt WordPress

- Resurse suplimentare despre utilizarea Robots.txt în WordPress

Ce este un fișier Robots.txt?

Robots.txt este un fișier text pe care proprietarii de site-uri web îl pot crea pentru a spune roboților motoarelor de căutare cum să acceseze și să indexeze paginile de pe site-urile lor.

De obicei, este stocat în directorul rădăcină (cunoscut și sub denumirea de folder principal) al site-ului dvs. web. Formatul de bază pentru un fișier robots.txt arată astfel:

User-agent: [user-agent name]

Disallow: [URL string not to be crawled]

User-agent: [user-agent name]

Allow: [URL string to be crawled]

Sitemap: [URL of your XML Sitemap]

Puteți avea mai multe linii de instrucțiuni pentru a permite sau a interzice URL-uri specifice și pentru a adăuga mai multe sitemap-uri. Dacă nu interziceți un URL, atunci roboții motoarelor de căutare presupun că li se permite să-l acceseze.

Iată cum poate arăta un fișier robots.txt exemplu:

User-Agent: *

Allow: /wp-content/uploads/

Disallow: /wp-content/plugins/

Disallow: /wp-admin/

Sitemap: https://example.com/sitemap_index.xml

În exemplul robots.txt de mai sus, am permis motoarelor de căutare să acceseze și să indexeze fișierele din folderul de încărcări WordPress.

După aceea, am interzis roboților de căutare să acceseze și să indexeze folderele de pluginuri și de administrare WordPress.

În cele din urmă, am furnizat URL-ul sitemap-ului nostru XML.

Ai Nevoie de un Fișier Robots.txt pentru Site-ul Tău WordPress?

Deși site-ul dvs. poate funcționa fără un fișier robots.txt, am constatat în mod constant că site-urile cu fișiere robots.txt optimizate au performanțe mai bune în rezultatele căutării.

Prin munca noastră cu clienți din diverse industrii, am văzut cum gestionarea corectă a bugetului de crawl prin robots.txt poate duce la o indexare mai rapidă a conținutului important și la o performanță SEO generală mai bună.

Acest lucru nu va avea un impact mare atunci când începi un blog și nu ai mult conținut.

Cu toate acestea, pe măsură ce site-ul dvs. crește și adăugați mai mult conținut, veți dori probabil un control mai bun asupra modului în care site-ul dvs. este parcurs și indexat.

Iată de ce.

Motoarele de căutare alocă fiecărui site web ceea ce Google numește un „buget de scanare”. Acesta este numărul de pagini pe care le vor scana într-un anumit interval de timp.

În testele noastre pe mii de site-uri WordPress, am constatat că site-urile mai mari beneficiază în special de optimizarea acestui buget prin configurarea strategică a fișierului robots.txt.

De exemplu, unul dintre clienții noștri enterprise a înregistrat o îmbunătățire de 40% a eficienței de crawl după implementarea optimizărilor noastre recomandate pentru robots.txt.

Puteți interzice roboților motoarelor de căutare să încerce să acceseze pagini inutile, cum ar fi paginile de administrare WordPress, fișierele plugin-urilor și folderul temelor.

Prin interzicerea paginilor inutile, economisiți cota de acces. Acest lucru ajută motoarele de căutare să acceseze și mai multe pagini de pe site-ul dvs. și să le indexeze cât mai rapid posibil.

Un alt motiv bun pentru a utiliza un fișier robots.txt este atunci când doriți să opriți motoarele de căutare să indexeze un post sau o pagină pe site-ul dvs.

Cu toate acestea, este important să știți că robots.txt nu este cea mai bună modalitate de a ascunde conținutul. O pagină interzisă poate apărea în continuare în rezultatele căutării dacă este legată de pe alte site-uri web.

Dacă doriți să opriți în mod fiabil o pagină să apară pe Google, ar trebui să utilizați în schimb o etichetă meta „noindex”. Aceasta spune motoarelor de căutare să nu adauge deloc pagina în indexul lor.

Cum arată un fișier robots.txt ideal?

Multe bloguri populare folosesc un fișier robots.txt foarte simplu. Conținutul acestora poate varia în funcție de nevoile site-ului specific:

User-agent: *

Disallow:

Sitemap: https://www.example.com/post-sitemap.xml

Sitemap: https://www.example.com/page-sitemap.xml

Acest fișier robots.txt permite tuturor roboților să indexeze tot conținutul și le oferă un link către sitemap-urile XML ale site-ului.

Pentru site-urile WordPress, recomandăm următoarele reguli în fișierul robots.txt:

User-Agent: *

Allow: /wp-content/uploads/

Disallow: /wp-admin/

Disallow: /readme.html

Disallow: /refer/

Sitemap: https://www.example.com/post-sitemap.xml

Sitemap: https://www.example.com/page-sitemap.xml

Aceasta spune roboților de căutare să indexeze toate imaginile și fișierele încărcate de WordPress prin utilizarea specifică a directivei Allow, care este o comandă utilă pe care motoarele de căutare precum Google o înțeleg.

Apoi, interzice roboților de căutare să indexeze zona de administrare WordPress, fișierul implicit readme.html (care poate dezvălui versiunea dvs. de WordPress) și directoarele comune pentru linkuri afiliate mascate precum /refer/.

Adăugând sitemap-uri în fișierul robots.txt, faci ca roboții Google să găsească ușor toate paginile de pe site-ul tău.

Acum că știți cum arată un fișier robots.txt ideal, să vedem cum puteți crea un fișier robots.txt în WordPress.

Cum să creezi un fișier Robots.txt în WordPress

Există două moduri de a crea un fișier robots.txt în WordPress. Poți alege metoda care funcționează cel mai bine pentru tine.

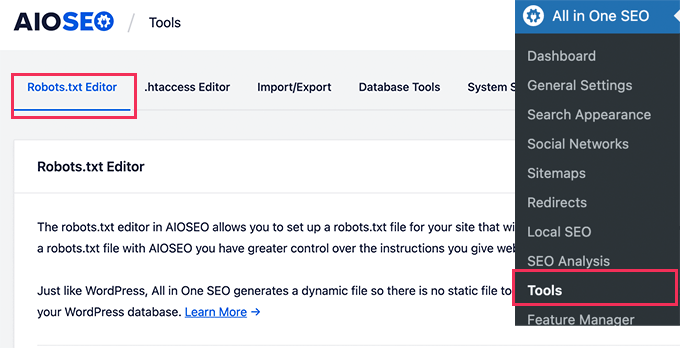

Metoda 1: Editarea fișierului Robots.txt folosind All in One SEO

All in One SEO, cunoscut și sub denumirea de AIOSEO, este cel mai bun plugin SEO pentru WordPress de pe piață, folosit de peste 3 milioane de site-uri web. Este ușor de utilizat și vine cu un generator de fișiere robots.txt.

Pentru a afla mai multe, consultați recenzia noastră detaliată AIOSEO.

Dacă nu ai deja instalat pluginul AIOSEO, poți consulta ghidul nostru pas cu pas despre cum să instalezi un plugin WordPress.

Notă: O versiune gratuită a AIOSEO este, de asemenea, disponibilă și are această funcționalitate.

Odată ce pluginul este instalat și activat, îl puteți folosi pentru a crea și edita fișierul robots.txt direct din zona de administrare WordPress.

Pur și simplu accesați All in One SEO » Tools pentru a edita fișierul robots.txt.

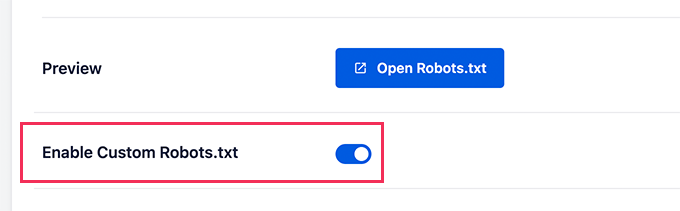

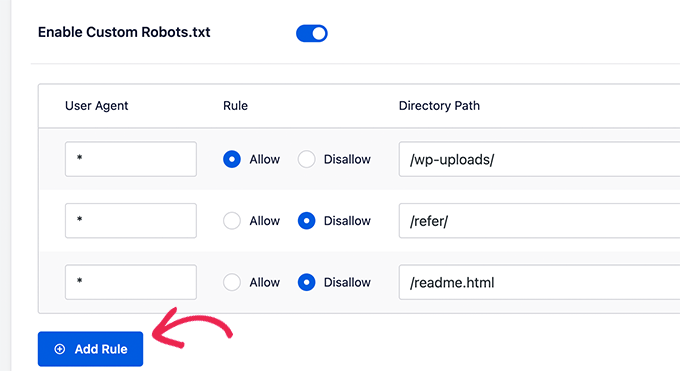

Mai întâi, va trebui să activați opțiunea de editare făcând clic pe comutatorul „Enable Custom Robots.txt” pentru a deveni albastru.

Cu acest comutator activat, puteți crea un fișier robots.txt personalizat în WordPress.

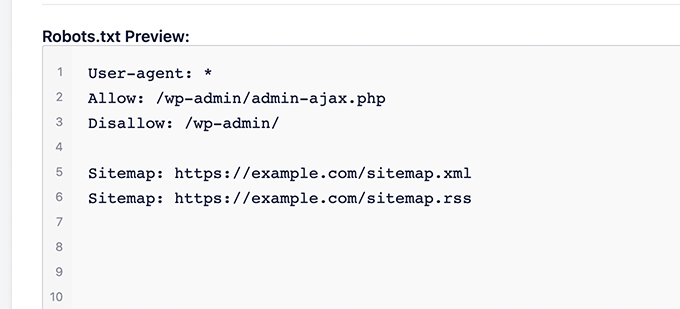

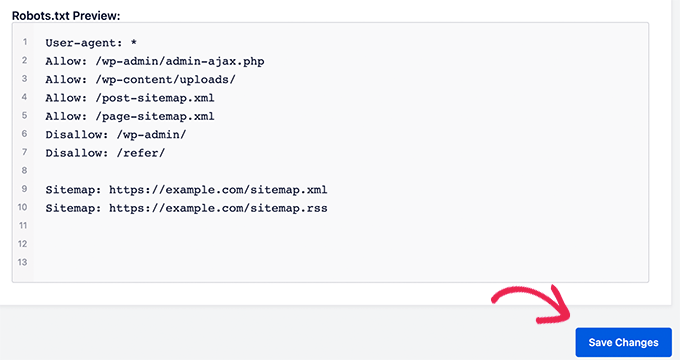

All in One SEO va afișa fișierul dvs. robots.txt existent în secțiunea „Previzualizare Robots.txt” din partea de jos a ecranului.

Această versiune va afișa regulile implicite care au fost adăugate de WordPress.

Aceste reguli implicite spun motoarelor de căutare să nu acceseze fișierele dvs. de bază WordPress, permit roboților să indexeze tot conținutul și le oferă un link către hărțile site-ului dvs. XML.

Acum, puteți adăuga propriile reguli personalizate pentru a vă îmbunătăți robots.txt pentru SEO.

Pentru a adăuga o regulă, introduceți un agent de utilizator în câmpul „Agent de utilizator”. Utilizarea unui * va aplica regula tuturor agenților de utilizator.

Apoi, selectați dacă doriți să „Permiteți” sau să „Interziceți” motoarelor de căutare să acceseze.

Apoi, introduceți numele fișierului sau calea directorului în câmpul „Calea directorului”.

Regula va fi aplicată automat fișierului robots.txt. Pentru a adăuga o altă regulă, pur și simplu faceți clic pe butonul „Adăugare regulă”.

Recomandăm adăugarea de reguli până când creați formatul ideal robots.txt pe care l-am partajat mai sus.

Regulile tale personalizate vor arăta așa.

Când ai terminat, nu uita să dai clic pe butonul „Salvează modificările” pentru a-ți stoca modificările.

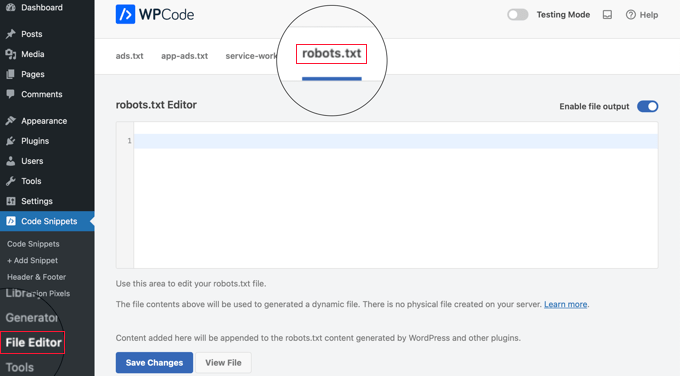

Metoda 2: Editarea fișierului Robots.txt folosind WPCode

WPCode este un plugin puternic pentru fragmente de cod care vă permite să adăugați cod personalizat pe site-ul dvs. web ușor și în siguranță.

Include, de asemenea, o funcție utilă care vă permite să editați rapid fișierul robots.txt.

Notă: Există și un Plugin Gratuit WPCode, dar nu include funcția de editor de fișiere.

Primul lucru pe care trebuie să îl faceți este să instalați pluginul WPCode. Pentru instrucțiuni pas cu pas, consultați ghidul nostru pentru începători despre cum să instalați un plugin WordPress.

La activare, trebuie să navigați la pagina WPCode » File Editor. Odată ajuns acolo, pur și simplu faceți clic pe fila „robots.txt” pentru a edita fișierul.

Acum, puteți lipi sau tasta conținutul fișierului robots.txt.

După ce ați terminat, asigurați-vă că faceți clic pe butonul „Salvare modificări” din partea de jos a paginii pentru a stoca setările.

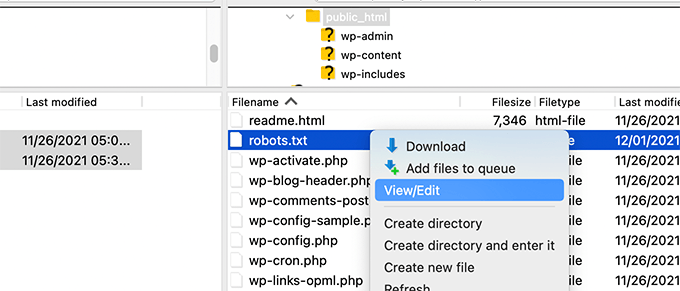

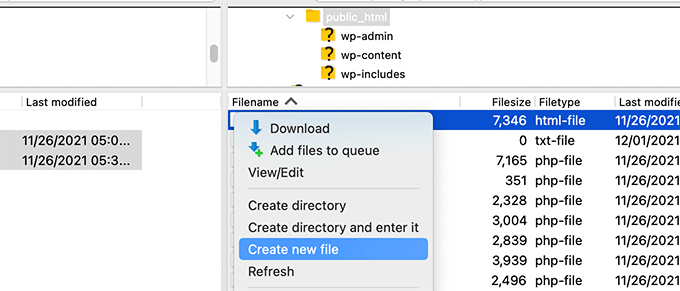

Metoda 3: Editarea fișierului Robots.txt manual folosind FTP

Pentru această metodă, va trebui să folosiți un client FTP pentru a edita fișierul robots.txt. Alternativ, puteți folosi managerul de fișiere furnizat de găzduirea dvs. WordPress.

Sfat Pro: Înainte de a edita, vă recomandăm să descărcați o copie de rezervă a fișierului dvs. original robots.txt (dacă există) pe computer. Astfel, îl puteți reîncărca cu ușurință dacă ceva nu merge bine.

Pur și simplu conectați-vă la fișierele site-ului dvs. WordPress folosind un client FTP.

Odată intrat, vei putea vedea fișierul robots.txt în folderul rădăcină al site-ului tău.

Dacă nu vezi unul, probabil că nu ai un fișier robots.txt.

În acest caz, puteți merge mai departe și crea unul.

Robots.txt este un fișier text simplu, ceea ce înseamnă că îl puteți descărca pe computer și îl puteți edita folosind orice editor de text simplu, cum ar fi Notepad sau TextEdit.

După salvarea modificărilor, puteți încărca fișierul robots.txt înapoi în folderul rădăcină al site-ului dvs. web.

Cum să-ți testezi fișierul Robots.txt

După crearea sau editarea fișierului robots.txt, este o idee excelentă să îl verificați pentru erori. O mică greșeală de scriere ar putea bloca accidental pagini importante de la motoarele de căutare, așa că acest pas este super important! 👍

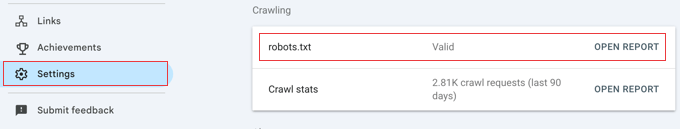

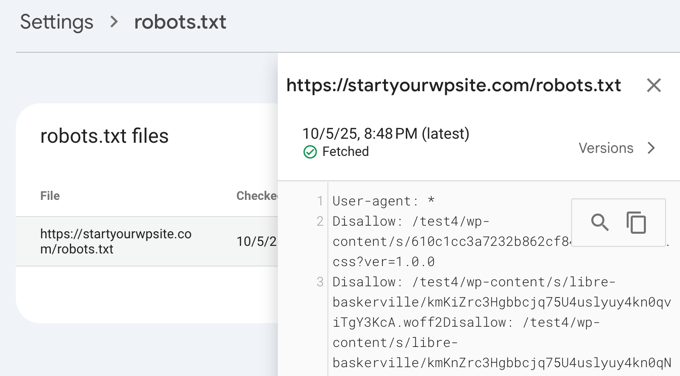

În timp ce Google avea un instrument de testare dedicat, acum au integrat această funcționalitate în rapoartele principale ale Google Search Console.

Mai întâi, asigurați-vă că site-ul dvs. este conectat la Google Search Console. Dacă nu ați făcut acest lucru încă, urmați ghidul nostru simplu despre cum să adăugați site-ul dvs. WordPress la Google Search Console.

Odată ce sunteți configurat, accesați tabloul de bord Google Search Console. Navigați la Setări în meniul din stânga jos.

Apoi, găsiți secțiunea „Crawling” și faceți clic pe „Deschide raport” lângă „robots.txt”.

Pur și simplu faceți clic pe versiunea curentă a fișierului din listă.

Acest raport vă va arăta cea mai recentă versiune a fișierului dvs. robots.txt pe care Google a găsit-o. Va evidenția orice erori de sintaxă sau probleme logice pe care le-a detectat.

Nu vă faceți griji dacă tocmai ați actualizat fișierul și nu vedeți imediat modificările aici. Google verifică automat o nouă versiune a fișierului robots.txt aproximativ o dată pe zi.

Puteți reveni mai târziu la acest raport pentru a confirma că Google a preluat ultimele modificări și că totul arată bine

Gânduri finale

Scopul optimizării fișierului robots.txt este de a împiedica motoarele de căutare să acceseze paginile care nu sunt disponibile public. De exemplu, paginile din folderul wp-plugins sau paginile din folderul de administrare WordPress.

Un mit comun printre experții SEO este că blocarea categoriilor, etichetelor și paginilor de arhivă WordPress va îmbunătăți rata de accesare și va duce la o indexare mai rapidă și la clasări mai înalte.

Acest lucru nu este adevărat. De fapt, această practică este puternic descurajată de Google și contravine ghidurilor lor de bune practici pentru a-i ajuta să vă înțeleagă site-ul.

Vă recomandăm să urmați formatul robots.txt de mai sus pentru a crea un fișier robots.txt pentru site-ul dvs.

Întrebări frecvente despre Robots.txt WordPress

Iată câteva dintre cele mai frecvente întrebări pe care le primim despre optimizarea fișierului robots.txt în WordPress.

1. Care este scopul principal al unui fișier robots.txt?

Scopul principal al unui fișier robots.txt este de a gestiona bugetul de crawl al site-ului dvs. web. Spunând motoarelor de căutare ce pagini să ignore (cum ar fi paginile de administrare sau fișierele plugin), le ajutați să își folosească resursele pentru a parcurge și indexa mai eficient conținutul dvs. cel mai important.

2. Unde este localizat fișierul robots.txt în WordPress?

Fișierul dvs. robots.txt este localizat în directorul rădăcină al site-ului dvs. web. De obicei, îl puteți vizualiza accesând yourdomain.com/robots.txt în browserul dvs. web.

3. Poate utilizarea robots.txt să îmbunătățească securitatea site-ului meu?

Nu, robots.txt nu este o măsură de securitate. Fișierul este vizibil public, deci nu împiedică pe nimeni să acceseze URL-urile pe care le listați. Acesta oferă pur și simplu directive pentru roboții motoarelor de căutare bine intenționați.

4. Ar trebui să blochez paginile de categorii și etichete WordPress în robots.txt?

Nu, nu ar trebui să blocați paginile de categorii și etichete. Aceste pagini de arhivă sunt utile pentru SEO, deoarece ajută motoarele de căutare să înțeleagă structura site-ului dvs. și să descopere conținutul dvs. Blocarea lor poate afecta negativ clasamentele dvs. de căutare.

Resurse suplimentare despre utilizarea Robots.txt în WordPress

Acum că știți cum să vă optimizați fișierul robots.txt, s-ar putea să doriți să vedeți alte articole legate de utilizarea robots.txt în WordPress.

- Glosar: Robots.txt

- Cum să ascunzi o pagină WordPress de Google

- Cum să împiedici motoarele de căutare să acceseze un site WordPress

- Cum să ștergi permanent un site WordPress de pe internet

- Cum să ascundeți ușor (Noindex) fișierele PDF în WordPress

- Cum să remediați eroarea „Googlebot nu poate accesa fișierele CSS și JS” în WordPress

- Ce este llms.txt? Cum să adăugați llms.txt în WordPress

- Cum să configurați corect All in One SEO pentru WordPress (Ghid complet)

Sperăm că acest articol v-a ajutat să învățați cum să optimizați fișierul robots.txt WordPress pentru SEO. De asemenea, ați putea dori să consultați ghidul nostru SEO WordPress complet pentru începători și selecțiile noastre de experți pentru cele mai bune instrumente SEO WordPress pentru a vă dezvolta site-ul.

Dacă ți-a plăcut acest articol, te rugăm să te abonezi la canalul nostru de YouTube pentru tutoriale video WordPress. Ne poți găsi, de asemenea, pe Twitter și Facebook.

Dennis Muthomi

Trebuie să recunosc, folosesc pluginul AIOSEO, dar am ignorat întotdeauna opțiunea „Activează Robots.txt personalizat” pentru că nu voiam să stric nimic.

Dar am citit acest articol și sunt convins că merită să-mi iau timp pentru a optimiza fișierul robots.txt al site-ului meu.

Amit Banerjee

Dacă ar fi fost oferit întregul șablon al fișierului robots.txt, ar fi fost de ajutor.

Suport WPBeginner

We did include the entire robots.txt

Admin

Michael

Cred că ar trebui să vă modificați răspunsul. Ar trebui să fie https în loc de http. Este corect să interziceți și fișierele plugin?

Suport WPBeginner

Vă mulțumim că ați semnalat acest lucru, eșantionul nostru a fost actualizat. Pentru a interzice plugin-urile, ar trebui să verificați cu plugin-ul specific pentru a fi sigur.

Moinuddin Waheed

Mulțumesc pentru acest post informativ despre fișierul robots.txt.

Nu știam că site-urile web ar trebui să întrețină acest fișier pentru a avea control asupra roboților Google, cum ar trebui să scaneze paginile și postările noastre.

pentru site-urile web începătoare, este necesar să avem un fișier robots.txt sau există o modalitate precum un plugin care poate crea un fișier robots.txt pentru site-ul nostru?

Suport WPBeginner

Majoritatea pluginurilor SEO ajută la configurarea fișierului robots.txt pentru un site nou, pentru a împiedica roboții să acceseze secțiuni pe care nu ar trebui.

Admin

Jiří Vaněk

Datorită acestui articol, am verificat fișierul robots.txt și am adăugat adrese URL cu hărți de site. În același timp, am avut și alte linii problematice acolo, care au fost dezvăluite de validator. Nu eram familiarizat cu hărțile de site în robots.txt până acum. Mulțumesc.

Suport WPBeginner

Cu plăcere, ne bucurăm că ghidul nostru v-a putut ajuta!

Admin

Stéphane

Salut,

Mulțumesc pentru postarea respectivă, devine mai clar cum să folosești fișierul robots.txt. Pe majoritatea site-urilor web pe care le găsești în timp ce cauți sfaturi referitoare la fișierul robots.txt, poți vedea că următoarele foldere sunt explicit excluse de la indexare (pentru WordPress):

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

Nu înțeleg cu adevărat motivele pentru excluderea acelor foldere (există vreunul de fapt?). Care ar fi părerea dumneavoastră în această privință?

Suport WPBeginner

Este în principal pentru a preveni ca orice din acele foldere să apară ca rezultat atunci când un utilizator caută site-ul dvs. Deoarece nu este conținutul dvs., nu este ceva ce majoritatea oamenilor ar dori să apară în rezultatele site-ului.

Admin

zaid haris

Interzice: /wp-admin/

Permite: /wp-admin/admin-ajax.php

GSC arată eroarea de acoperire pentru „Disallow: /wp-admin/”. Este greșit?

Suport WPBeginner

Pentru majoritatea site-urilor, nu doriți ca nimic din wp-admin să apară ca rezultat al căutării, deci este în regulă și de așteptat să primiți zona de acoperire atunci când refuzați Google posibilitatea de a scana wp-admin.

Admin

Hansini

Îmi creez robots.txt manual, așa cum ați indicat, pentru site-ul meu WordPress.

Am o nelămurire. când scriu User-Agent: * nu va permite altui robot de spam să acceseze site-ul meu?

Ar trebui să scriu User-Agent: * sau User-Agent: Googlebot.?

Suport WPBeginner

Linia User-Agent stabilește regulile pe care toți roboții ar trebui să le urmeze pe site-ul dvs.; dacă specificați un bot anume pe acea linie, ar stabili reguli pentru acel bot specific și pentru niciunul dintre ceilalți.

Admin

Nishant

Ce ar trebui să scriem pentru ca Google să-mi indexeze postarea?

Suport WPBeginner

Pentru a-ți lista site-ul, ar trebui să consulți articolul nostru de mai jos:

https://www.wpbeginner.com/beginners-guide/how-do-i-get-my-wordpress-site-listed-on-google-beginners-guide/

Admin

Sanjeev Pandey

ar trebui să interzicem și /wp-content/themes/ ?

Apare în rezultatele căutării atunci când rulez comanda site:abcdef.com în căutarea Google

Suport WPBeginner

Nu ați dori să vă faceți griji cu privire la blocarea folderului temelor dvs. și, pe măsură ce scrieți conținut optimizat SEO, nu ar trebui să mai vedeți temele ca rezultat al căutării.

Admin

Salem

Salut, ce înseamnă „ Disallow: /readme.html & Disallow: /refer/ ”?

Suport WPBeginner

Asta înseamnă că le spui motoarelor de căutare să nu ia în considerare niciun link de referință sau fișierul readme.html.

Admin

sean

Bună, care sunt avantajele și dezavantajele blocării wp-content/uploads

Mulțumesc

Suport WPBeginner

Dacă îți blochezi folderul de încărcări, motoarele de căutare nu ar accesa în mod normal conținutul tău încărcat, cum ar fi imaginile.

Admin

Piyush

mulțumesc pentru rezolvarea problemei mele

Suport WPBeginner

You’re welcome

Admin

Ravi kumar

Domnule, sunt foarte confuz în legătură cu robot.txt, de multe ori am trimis harta site-ului pe blogger, dar după 3, 4 zile apare aceeași problemă, ce este exact robot.txt.. & cum să-l trimit, vă rog să mă ghidați

Suport WPBeginner

Ar depinde de problema dvs. specifică, ați putea dori să consultați pagina noastră de mai jos:

https://www.wpbeginner.com/glossary/robots-txt/

Admin

Prem

Dacă nu indexez o adresă URL sau o pagină folosind fișierul robots.txt, Google afișează vreo eroare în Search Console?

Suport WPBeginner

Nu, Google nu va lista pagina, dar dacă pagina este listată, nu va afișa o eroare.

Admin

Bharat

Salut

Am o întrebare

Am primit un avertisment de la Google Search Console privind probleme de acoperire, blocat de robots.txt

/wp-admin/widgets.php

Întrebarea mea este, pot permite fișierului robots.txt accesul la wp-admin/widgets.php și este sigur acest lucru?

Suport WPBeginner

DACĂ ai vrea, ai putea, dar acesta nu este un fișier pe care Google să-l acceseze.

Admin

Anthony

Salut, mă întreb dacă ar trebui să permiți: /wp-admin/admin-ajax.php?

Suport WPBeginner

În mod normal, da, ar trebui.

Admin

Jaira

Pot să știu de ce ar trebui să permiteți /wp-admin/admin-ajax.php?

Suport WPBeginner

Este utilizat de diferite teme și plugin-uri pentru a apărea corect pentru motoarele de căutare.

Amila

Bună ziua! Îmi place foarte mult acest articol și, fiind începător cu toate aceste chestiuni legate de crawling, aș dori să întreb ceva în acest sens. Recent, Google a accesat și indexat unul dintre site-urile mele într-un mod foarte neplăcut, afișând pagini în rezultatele căutării care au fost șterse de pe site. Site-ul nu a descurajat motoarele de căutare de la indexare în setările WordPress la început, dar a făcut-o mai târziu, după ce Google a afișat încă 3 pagini în rezultatele căutării (acele pagini, de asemenea, nu există) și chiar nu înțeleg cum s-ar fi putut întâmpla acest lucru cu opțiunea „descurajează motoarele de căutare de la indexare” activată. Deci, metoda Yoast poate fi utilă și poate oferi o soluție pentru ca site-ul meu să fie indexat corect de Google de data aceasta? Mulțumesc anticipat!

Suport WPBeginner

Plugin-ul Yoast ar trebui să vă ajute să vă asigurați că paginile pe care le aveți sunt indexate corect; există posibilitatea ca, înainte de a descuraja motoarele de căutare să acceseze site-ul dvs., pagina să fi fost cache-uită.

Admin

Amila

Ei bine, da și din toate paginile, a cache-uit pe cele care nu mai există. Oricum, deoarece pagina curentă este setată pe „descurajează”, este mai bine să o lăsați așa deocamdată sau să debifați căsuța și să lăsați Google să o scaneze și să o indexeze din nou cu ajutorul Yoast? Mulțumesc! Cu articolele dvs., totul a devenit mai ușor!

Suport WPBeginner

Ai dori ca Google să-ți re-crawleze site-ul odată ce este configurat așa cum dorești.

Pradhuman Kumar

Salut, mi-a plăcut foarte mult articolul, foarte precis și perfect.

Doar o mică sugestie, actualizați, vă rog, imaginea testerului ROBOTS.txt, deoarece consola Google s-a schimbat și ar fi grozav dacă ați adăuga linkul pentru a verifica robots.txt de la Google.

Suport WPBeginner

Vă mulțumim pentru feedback, vom fi siguri că vom actualiza articolul cât mai curând posibil.

Admin

Kamaljeet Singh

Fișierul robots.txt al blogului meu a fost:

User-Agent: *

crawl-delay: 10

După ce am citit acest post, l-am schimbat în fișierul robots.txt recomandat de tine. Este în regulă că am eliminat crawl-delay?

Suport WPBeginner

Ar trebui să fie în regulă, crawl-delay spune motoarelor de căutare să încetinească cât de repede să acceseze site-ul dvs.

Admin

reena

Foarte frumos descris despre robot.text, sunt foarte fericit

ești un scriitor foarte bun

Suport WPBeginner

Thank you, glad you liked our article

Admin

JJ

Ce este pagina Disallow: /refer/ ? Obțin un 404, este un fișier wp ascuns?

Personal editorial

Folosim /refer/ pentru a redirecționa către diverse linkuri afiliate de pe site-ul nostru. Nu dorim ca acestea să fie indexate, deoarece sunt doar redirecționări și nu conținut real.

Admin

Sagar Arakh

Mulțumesc pentru distribuire. Acest lucru mi-a fost de mare ajutor pentru a înțelege robots.txt

Mi-am actualizat robots.txt la cel ideal pe care l-ați sugerat. Voi aștepta rezultatele acum

Suport WPBeginner

You’re welcome, glad you’re willing to use our recommendations

Admin

Akash Gogoi

Articol foarte util. Vă mulțumesc foarte mult.

Suport WPBeginner

Glad our article was helpful

Admin

Zingylancer

Mulțumesc pentru partajarea acestei informații utile despre noi.

Suport WPBeginner

Glad we could share this information about the robots.txt file

Admin

Jasper

mulțumesc pentru informațiile actualizate pentru mine. Articolul tău a fost bun pentru fișierul Robot txt. Mi-a oferit o informație nouă. mulțumesc și ține-mă la curent cu idei noi.

Suport WPBeginner

Glad our guide was helpful

Admin

Imran

Mulțumesc, am adăugat robots.txt în WordPress. Foarte bun articol.

Suport WPBeginner

Thank you, glad our article was helpful

Admin

Steve

Mulțumesc pentru asta – cum funcționează pe un WP Multisite totuși?

Suport WPBeginner

Pentru o rețea multisite, ar trebui să aveți un fișier robots.txt în folderul rădăcină al fiecărui site.

Admin

Pacifique Ndanyuzwe

Site-ul meu wordpress este nou și fișierul meu robot.txt implicit este

user-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

Vreau ca Google să acceseze și să indexeze conținutul meu. Este acel robot.txt în regulă?

Suport WPBeginner

Sigur puteți folosi asta dacă ați dori

Admin

Ritesh Seth

Articol grozav…

Am fost confuz zile întregi în legătură cu fișierul Robots.txt și legăturile Disallow. Am copiat etichetele pentru fișierul robots. Sper că acest lucru va rezolva problema site-ului meu

Suport WPBeginner

We hope our article will help as well

Admin

Kurt

Fișierele din capturile de ecran ale folderului dvs. de acasă sunt de fapt localizate sub folderul public_html din folderul meu de acasă.

Nu am avut un folder /refer sub folderul meu public_html.

Nu am avut fișiere xml pentru postări sau pagini nicăieri în contul meu WP.

Am inclus o intrare în fișierul robots.txt pe care l-am creat pentru a interzice indexarea site-ului meu sandbox. Nu sunt sigur dacă este necesar, deoarece am selectat deja opțiunea în WP care spune motoarelor de căutare să nu-mi indexeze site-ul sandbox, dar nu cred că va dăuna să am intrarea.

Suport WPBeginner

Some hosts do rename public_html to home which is why you see it there. You would want to ensure Yoast is active for the XML files to be available. The method in this article is an additional precaution to help with preventing crawling your site

Admin

Ahmed

Articol grozav

Suport WPBeginner

Thank you

Admin

ASHOK KUMAR JADON

Salut, un articol atât de frumos, mi-ați rezolvat problema. Deci, vă mulțumesc foarte mult

Suport WPBeginner

Glad our article could help

Admin

Elyn Ashton

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php <– Acesta este codul meu robot.txt, dar sunt confuz de ce /wp-admin este indexat? Cum să-l fac no-index?

Suport WPBeginner

Dacă a fost indexat anterior, este posibil să fie nevoie să acordați timp pentru ca memoria cache a motorului de căutare să se golească

Admin

Ashish kumar

Acest site web mă inspiră cu adevărat să încep un blog. Mulțumesc pentru multe teme. Acest site, fiecare articol are informații și explicații bogate. Când am o problemă, vizitez mai întâi acest blog. Mulțumesc

Suport WPBeginner

Glad our articles can be helpful

Admin

Anna

Încerc să optimizez roboții pentru site-ul meu folosind Yoast. Cu toate acestea, instrumentele din Yoast nu au opțiunea pentru „Editor fișiere”.

Există doar două opțiuni

(i) Import și Export

(ii) Editor în masă

Mă puteți sfătui cum poate fi rezolvată această problemă. Ar putea fi faptul că folosesc o ediție gratuită a Yoast?

Suport WPBeginner

Versiunea gratuită a Yoast are încă opțiunea, instalarea dvs. ar putea interzice editarea fișierelor, caz în care probabil va trebui să utilizați metoda FTP.

Admin

Emmanuel Husseni

Găsesc acest articol cu adevărat util, deoarece nu știu prea multe despre cum funcționează robot.txt, dar acum știu.

Vă rog, ce nu înțeleg este cum găsesc formatul cel mai bun de robot.txt pe care să îl folosesc pe site-ul meu (mă refer la unul care funcționează în general)?

Am observat că multe bloguri mari pe care le verific se clasează sus în motoarele de căutare folosind un format diferit de robot.txt.

Aș fi bucuros să văd un răspuns de la dumneavoastră sau de la oricine mă poate ajuta.

Personal editorial

Având o hartă a site-ului și permițând zonele care trebuie permise este cea mai importantă parte. Partea de interzicere va varia în funcție de fiecare site. Am partajat un exemplu în postarea noastră de pe blog și ar trebui să fie bun pentru majoritatea site-urilor WordPress.

Admin

Suport WPBeginner

Salut Emmanuel,

Vă rugăm să consultați secțiunea referitoare la fișierul robots.txt ideal. Depinde de cerințele dumneavoastră. Majoritatea bloggerilor exclud folderele de administrare WordPress și de pluginuri din indexare.

Admin

Emmanuel Husseni

Mulțumesc mult.

acum înțeleg. Cred că voi începe cu formatul general deocamdată.

jack

Articol bine scris, recomand utilizatorilor să facă un sitemap înainte de a crea și activa textul ROBOTS, acest lucru va ajuta site-ul dvs. să fie parcurs mai rapid și indexat mai ușor.

Jack

Connie S Owens

Aș dori să împiedic motoarele de căutare să-mi indexeze arhivele în timpul scanării lor.

Emmanuel Nonye

Mulțumesc mult, acest articol a fost foarte util.

Cherisa

Continui să primesc mesajul de eroare de mai jos pe Google Webmaster. Practic sunt blocat. Câteva lucruri care nu mi-au fost clare în acest tutorial sunt unde găsesc fișierele rădăcină ale site-ului meu, cum determini dacă ai deja un „robots.txt” și cum îl editezi?

Suport WPBeginner

Salut Cherisa,

Folderul rădăcină al site-ului dvs. este cel care conține foldere precum wp-admin, wp-includes, wp-content etc. Conține, de asemenea, fișiere precum wp-config.php, wp-cron.php, wp-blogheader.php etc.

Dacă nu vedeți un fișier robots.txt în acest folder, atunci nu aveți unul. Puteți merge mai departe și crea unul nou.

Admin

Cherisa

Vă mulțumesc pentru răspuns. Am căutat peste tot și nu reușesc să localizez aceste fișiere rădăcină așa cum le descrieți. Există un director de cale pe care îl pot urma care duce la acest folder. De exemplu, este sub Setări, etc.?

Devender

Am avut un trafic web decent pe site-ul meu. Brusc a scăzut la zero în luna mai. Până acum mă confrunt cu problema. Vă rog să mă ajutați să-mi recuperez site-ul.

Haris Aslam

Salutare Vă mulțumesc pentru această informație, dar am o întrebare

Am creat deja fișierul Sitemap.xml și Robots.txt, & se indexează bine. Dar cum pot crea „Product-Sitemap.xml”

Există o listă completă de produse în fișierul sitemap.xml. Trebuie să creez Product-sitemap.xml separat?

și să trimit din nou la Google sau Bing?

Mă puteți ajuta, vă rog...

Vă mulțumesc

Mahadi Hassan

Am o problemă cu setarea fișierului robots.txt. Se afișează doar un singur robots.txt pentru toate site-urile web. Vă rog să mă ajutați să afișez fișierul robots.txt separat pentru toate site-urile web. Am toate fișierele robots.txt separate pentru fiecare site web individual. Dar se afișează doar un singur fișier robots.txt în browser pentru toate site-urile web.

Debu Majumdar

Vă rugăm să explicați de ce ați inclus

Disallow: /refer/

în exemplul Robots.txt pentru începători? Nu înțeleg implicațiile acestei linii. Este importantă pentru începători? Ați explicat celelalte două interzise.

Mulțumesc.

Suport WPBeginner

Salut Debu,

Acest exemplu provine din fișierul robots.txt al WPBeginner. La WPBeginner folosim ThirstyAffiliates pentru a gestiona linkurile de afiliere și a masca URL-urile. Aceste URL-uri conțin /refer/, de aceea le blocăm în fișierul nostru robots.txt.

Admin

Evaristo

Cum pot pune toate tag-urile/mydomain.Com în nofollow? În robots.txt pentru a concentra sucul de linkuri? Mulțumesc.

harsh kumar

salut,,am o eroare în yoast seo referitoare la harta site-ului..odată ce dau clic pe corectare, aceasta reapare..codul html al site-ului meu nu se încarcă corect

Tom

Tocmai mi-am revizuit contul Google Webmaster Tools și, folosind Search Console, am descoperit următoarele:

Pagina s-a încărcat parțial

Nu toate resursele paginii au putut fi încărcate. Acest lucru poate afecta modul în care Google vede și înțelege pagina dvs. Remediați problemele de disponibilitate pentru orice resurse care pot afecta modul în care Google înțelege pagina dvs.

Acest lucru se datorează faptului că toate foile de stil CSS asociate cu pluginurile sunt interzise de robots.txt-ul implicit.

Înțeleg motive întemeiate pentru care nu ar trebui să permit acest lucru, dar care ar fi o alternativă, având în vedere că bănuiesc că algoritmii Google penalizează site-ul pentru că nu le vede.

Suren

Salut,

Ori de câte ori îmi caut site-ul pe Google, acest text apare sub link: „Nu este disponibilă o descriere pentru acest rezultat din cauza fișierului robots.txt al site-ului”

Cum pot rezolva această problemă?

Cu stimă

Suport WPBeginner

Salut Suren,

Se pare că cineva a modificat din greșeală setările de confidențialitate ale site-ului dvs. Accesați Setări » Pagina Citire și derulați în jos la secțiunea „Vizibilitate pentru motoarele de căutare”. Asigurați-vă că nu este bifată căsuța de lângă.

Admin

Divyesh

Salut

Așa cum am văzut în instrumentul pentru webmasteri, am fișierul robot.txt ca mai jos:

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

Spuneți-mi dacă este în regulă? Sau ar trebui să folosesc altceva?

John Cester

Vreau să știu, este o idee bună să blochez (disallow) „/wp-content/plugins/” în robots.tx? De fiecare dată când elimin un plugin, acesta afișează eroarea 404 pe unele pagini ale acelui plugin.