Det är en obehaglig känsla när du inser att en liten, förbisedd textfil kan tyst sabotera din webbplats SEO. Många webbplatsägare inser inte att ett enkelt misstag i deras robots.txt-fil kan hindra Google från att hitta deras viktigaste innehåll.

Efter att ha granskat tusentals WordPress-webbplatser har vi sett detta hända fler gånger än vi kan räkna. Den goda nyheten är att det är enklare att fixa än du tror.

I den här guiden går vi igenom de exakta, beprövade stegen vi använder för att optimera en WordPress robots.txt-fil. Du kommer att lära dig hur du gör rätt och säkerställer att sökmotorer genomsöker din webbplats effektivt.

Känner du dig överväldigad? Här är en snabb översikt över allt vi kommer att täcka i den här guiden. Hoppa gärna till avsnittet som intresserar dig mest.

- Vad är en robots.txt-fil?

- Behöver du en Robots.txt-fil för din WordPress-sajt?

- Hur ser en idealisk robots.txt-fil ut?

- Hur man skapar en Robots.txt-fil i WordPress

- Hur du testar din Robots.txt-fil

- Slutliga tankar

- Vanliga frågor om WordPress robots.txt

- Ytterligare resurser om användning av robots.txt i WordPress

Vad är en robots.txt-fil?

Robots.txt är en textfil som webbplatsägare kan skapa för att tala om för sökmotorernas robotar hur de ska genomsöka och indexera sidor på sina webbplatser.

Den lagras vanligtvis i rotkatalogen (även känd som huvudmappen) på din webbplats. Grundformatet för en robots.txt-fil ser ut så här:

User-agent: [user-agent name]

Disallow: [URL string not to be crawled]

User-agent: [user-agent name]

Allow: [URL string to be crawled]

Sitemap: [URL of your XML Sitemap]

Du kan ha flera rader med instruktioner för att tillåta eller neka specifika URL:er och lägga till flera sitemap. Om du inte nekar en URL, antar sökmotorrobotar att de får krypa den.

Här är hur en exempelrobots.txt-fil kan se ut:

User-Agent: *

Allow: /wp-content/uploads/

Disallow: /wp-content/plugins/

Disallow: /wp-admin/

Sitemap: https://example.com/sitemap_index.xml

I exemplet med robots.txt ovan har vi tillåtit sökmotorer att krypa och indexera filer i vår WordPress-uppladdningsmapp.

Därefter förbjöd vi sökmotorrobotar från att genomsöka och indexera plugins och WordPress-administratörsordlistor.

Slutligen har vi angett URL:en till vår XML-webbplatskarta.

Behöver du en Robots.txt-fil för din WordPress-sajt?

Även om din webbplats kan fungera utan en robots.txt-fil, har vi konsekvent funnit att webbplatser med optimerade robots.txt-filer presterar bättre i sökresultaten.

Genom vårt arbete med kunder inom olika branscher har vi sett hur korrekt hantering av krypbudget genom robots.txt kan leda till snabbare indexering av viktigt innehåll och bättre övergripande SEO-prestanda.

Detta kommer inte att ha stor inverkan när du först startar en blogg och inte har mycket innehåll.

Men när din webbplats växer och du lägger till mer innehåll, då kommer du troligen att vilja ha bättre kontroll över hur din webbplats genomsöks och indexeras.

Här är varför.

Sökmotorer allokerar vad Google kallar en 'genomsökningsbudget' till varje webbplats. Detta är antalet sidor de kommer att genomsöka inom en given tidsperiod.

I vår testning över tusentals WordPress-webbplatser har vi funnit att större webbplatser särskilt drar nytta av att optimera denna budget genom strategisk robots.txt-konfiguration.

Till exempel såg en av våra företagskunder en 40% förbättring av genomsökningseffektiviteten efter att ha implementerat våra rekommenderade robots.txt-optimeringar.

Du kan förbjuda sökmotorer från att försöka genomsöka onödiga sidor som dina WordPress-administratörssidor, plugin-filer och teman-mapp.

Genom att neka onödiga sidor sparar du din krypningskvot. Detta hjälper sökmotorer att krypa ännu fler sidor på din webbplats och indexera dem så snabbt som möjligt.

En annan bra anledning att använda en robots.txt-fil är när du vill förhindra sökmotorer från att indexera ett inlägg eller en sida på din webbplats.

Det är dock viktigt att veta att robots.txt inte är det bästa sättet att dölja innehåll. En sida som är förbjuden kan fortfarande visas i sökresultaten om den länkas till från andra webbplatser.

Om du vill stoppa en sida från att visas på Google på ett tillförlitligt sätt bör du istället använda en 'noindex'-metatagg. Detta talar om för sökmotorer att inte lägga till sidan i sitt index alls.

Hur ser en idealisk robots.txt-fil ut?

Många populära bloggar använder en mycket enkel robots.txt-fil. Deras innehåll kan variera beroende på den specifika webbplatsens behov:

User-agent: *

Disallow:

Sitemap: https://www.example.com/post-sitemap.xml

Sitemap: https://www.example.com/page-sitemap.xml

Denna robots.txt-fil tillåter alla bottar att indexera allt innehåll och ger dem en länk till webbplatsens XML-webbplatskartor.

För WordPress-webbplatser rekommenderar vi följande regler i robots.txt-filen:

User-Agent: *

Allow: /wp-content/uploads/

Disallow: /wp-admin/

Disallow: /readme.html

Disallow: /refer/

Sitemap: https://www.example.com/post-sitemap.xml

Sitemap: https://www.example.com/page-sitemap.xml

Detta talar om för sökmotorrobotar att indexera alla dina WordPress-bilder och uppladdade filer genom att specifikt använda direktivet Allow, vilket är ett användbart kommando som sökmotorer som Google förstår.

Den förhindrar sedan sökmotorrobotar från att indexera WordPress administrationsområde, standardfilen readme.html (som kan avslöja din WordPress-version) och vanliga kataloger för dolda affiliate-länkar som /refer/.

Genom att lägga till webbplatskartor i robots.txt-filen gör du det enkelt för Google-robotar att hitta alla sidor på din webbplats.

Nu när du vet hur en idealisk robots.txt-fil ser ut, låt oss titta på hur du kan skapa en robots.txt-fil i WordPress.

Hur man skapar en Robots.txt-fil i WordPress

Det finns två sätt att skapa en robots.txt-fil i WordPress. Du kan välja den metod som fungerar bäst för dig.

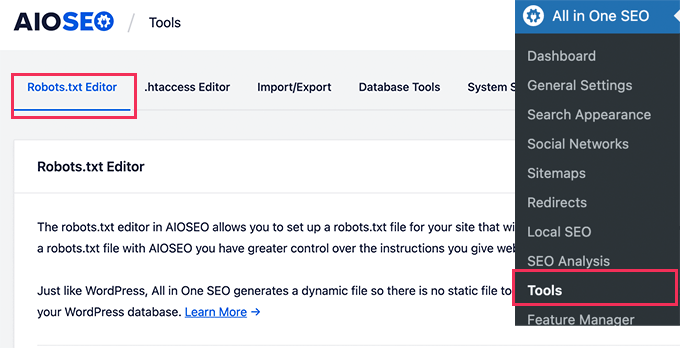

Metod 1: Redigera robots.txt-filen med All in One SEO

All in One SEO, även känt som AIOSEO, är det bästa WordPress SEO-pluginet på marknaden, som används av över 3 miljoner webbplatser. Det är lätt att använda och kommer med en generator för robots.txt-fil.

För att lära dig mer, se vår detaljerade AIOSEO-recension.

Om du inte redan har AIOSEO-pluginet installerat kan du se vår steg-för-steg-guide om hur man installerar ett WordPress-plugin.

Notera: En gratisversion av AIOSEO finns också tillgänglig och har den här funktionen.

När pluginet är installerat och aktiverat kan du använda det för att skapa och redigera din robots.txt-fil direkt från ditt WordPress-administrationsområde.

Gå helt enkelt till Allt i ett SEO » Verktyg för att redigera din robots.txt-fil.

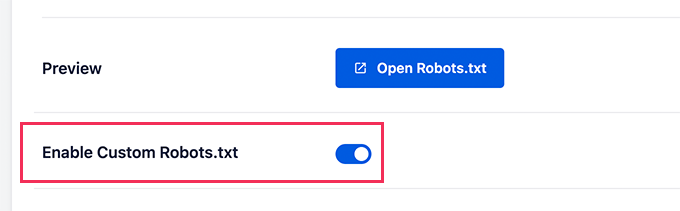

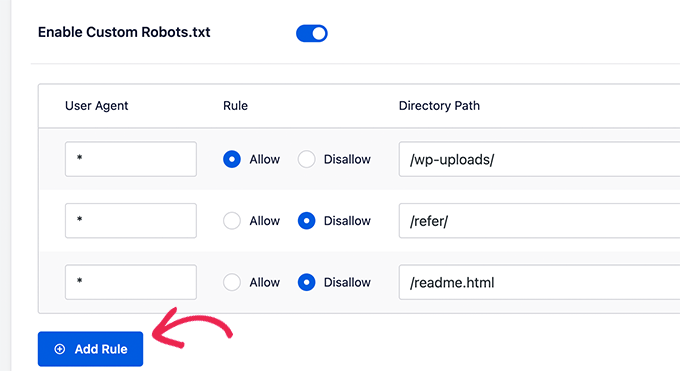

Först måste du aktivera redigeringsalternativet genom att klicka på växlingsknappen ‘Aktivera anpassad Robots.txt’ till blått.

Med den här växlingsknappen kan du skapa en anpassad robots.txt-fil i WordPress.

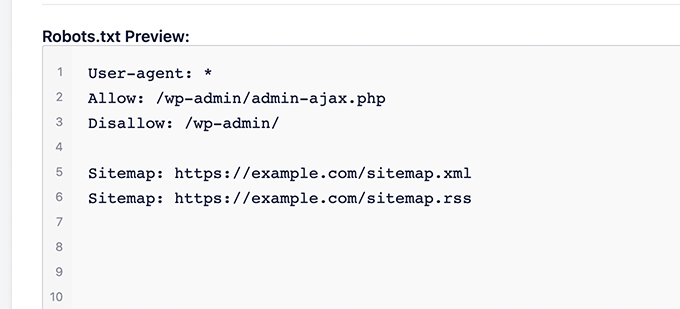

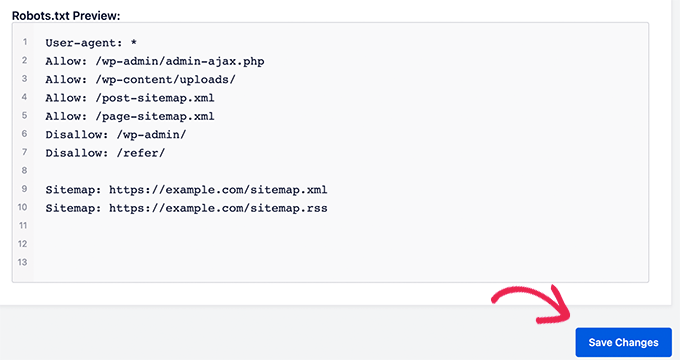

All in One SEO kommer att visa din befintliga robots.txt-fil i avsnittet 'Robots.txt-förhandsgranskning' längst ner på skärmen.

Den här versionen visar standardreglerna som lades till av WordPress.

Dessa standardregler talar om för sökmotorerna att inte genomsöka dina kärn-WordPress-filer, tillåta botarna att indexera allt innehåll och ge dem en länk till webbplatsens XML-sitemaps.

Nu kan du lägga till dina egna anpassade regler för att förbättra din robots.txt för SEO.

För att lägga till en regel, ange en användaragent i fältet 'User Agent'. Att använda en * kommer att tillämpa regeln på alla användaragenter.

Välj sedan om du vill att sökmotorerna ska 'Tillåta' eller 'Neka' att krypa.

Ange sedan filnamnet eller sökvägen till katalogen i fältet 'Directory Path'.

Regeln kommer automatiskt att tillämpas på din robots.txt. För att lägga till en annan regel, klicka bara på knappen 'Lägg till regel'.

Vi rekommenderar att du lägger till regler tills du skapar det ideala robots.txt-formatet som vi delade ovan.

Dina anpassade regler kommer att se ut så här.

När du är klar, glöm inte att klicka på knappen 'Spara ändringar' för att lagra dina ändringar.

Metod 2: Redigera robots.txt-filen med WPCode

WPCode är ett kraftfullt plugin för kodavsnitt som låter dig lägga till anpassad kod på din webbplats enkelt och säkert.

Den innehåller också en praktisk funktion som låter dig snabbt redigera robots.txt-filen.

Notera: Det finns också ett WPCode Free Plugin, men det inkluderar inte filredigeringsfunktionen.

Det första du behöver göra är att installera WPCode-pluginet. För steg-för-steg-instruktioner, se vår nybörjarguide om hur man installerar ett WordPress-plugin.

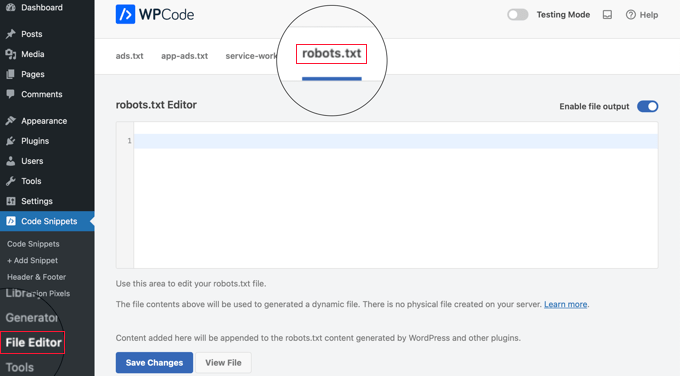

Vid aktivering måste du navigera till sidan WPCode » Filredigerare. Väl där klickar du helt enkelt på fliken ‘robots.txt’ för att redigera filen.

Nu kan du klistra in eller skriva innehållet i robots.txt-filen.

När du är klar, se till att du klickar på knappen 'Spara ändringar' längst ner på sidan för att spara inställningarna.

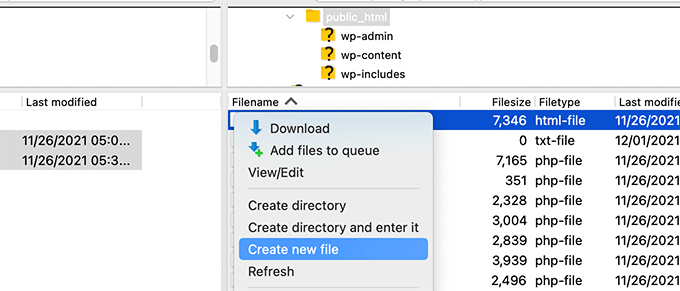

Metod 3: Redigera robots.txt-filen manuellt med FTP

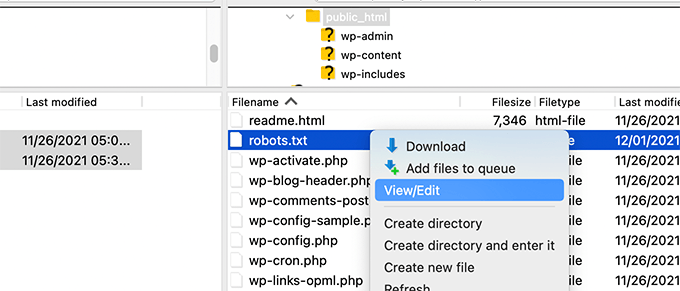

För den här metoden behöver du använda en FTP-klient för att redigera robots.txt-filen. Alternativt kan du använda filhanteraren som tillhandahålls av din WordPress-värd.

Proffstips: Innan du gör några ändringar rekommenderar vi att du laddar ner en säkerhetskopia av din ursprungliga robots.txt-fil (om en sådan finns) till din dator. På så sätt kan du enkelt ladda upp den igen om något går fel.

Anslut helt enkelt till dina WordPress-webbplats-filer med en FTP-klient.

Väl inne kommer du att kunna se robots.txt-filen i din webbplats rotmapp.

Om du inte ser en, har du troligen ingen robots.txt-fil.

I så fall kan du bara fortsätta och skapa en.

Robots.txt är en vanlig textfil, vilket innebär att du kan ladda ner den till din dator och redigera den med vilken vanlig textredigerare som Anteckningar eller Textredigerare.

Efter att ha sparat dina ändringar kan du ladda upp robots.txt-filen tillbaka till din webbplats rotmapp.

Hur du testar din Robots.txt-fil

Efter att ha skapat eller redigerat din robots.txt-fil är det en bra idé att kontrollera den efter fel. En liten felskrivning kan oavsiktligt blockera viktiga sidor från sökmotorer, så detta steg är superviktigt! 👍

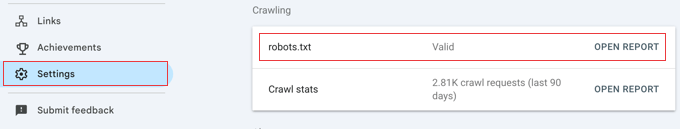

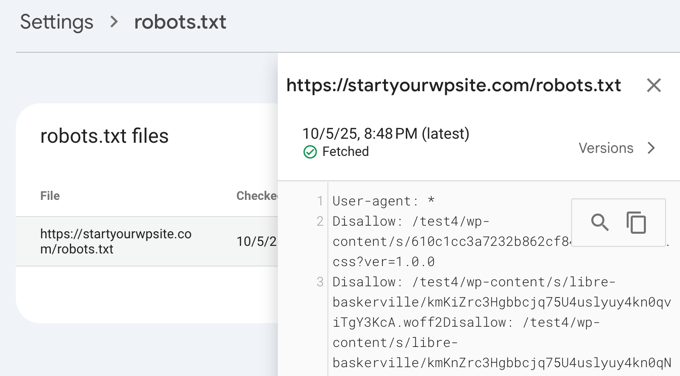

Medan Google tidigare hade ett dedikerat testverktyg, har de nu integrerat den här funktionen i de huvudsakliga rapporterna i Google Search Console.

Kontrollera först att din webbplats är ansluten till Google Search Console. Om du inte har gjort det än, följ bara vår enkla guide om hur du lägger till din WordPress-webbplats i Google Search Console.

När du är inställd, gå till din Google Search Console-instrumentpanel. Navigera till Inställningar i menyn längst ner till vänster.

Hitta sedan sektionen 'Crawling' och klicka på 'Öppna rapport' bredvid 'robots.txt'.

Klicka helt enkelt på den aktuella versionen av filen i listan.

Den här rapporten visar dig den senaste versionen av din robots.txt-fil som Google har hittat. Den kommer att markera eventuella syntaxfel eller logiska problem som den har upptäckt.

Oroa dig inte om du precis har uppdaterat din fil och inte ser ändringarna här omedelbart. Google kontrollerar automatiskt efter en ny version av din robots.txt-fil ungefär en gång om dagen.

Du kan återkomma till den här rapporten senare för att bekräfta att Google har plockat upp dina senaste ändringar och att allt ser bra ut

Slutliga tankar

Målet med att optimera din robots.txt-fil är att förhindra sökmotorer från att krypa sidor som inte är offentligt tillgängliga. Till exempel sidor i din wp-plugins-mapp eller sidor i din WordPress-administratörs-mapp.

En vanlig myt bland SEO-experter är att blockering av WordPress-kategorier, taggar och arkivsidor kommer att förbättra genomsökningshastigheten och resultera i snabbare indexering och högre ranking.

Detta är inte sant. Faktum är att denna praxis starkt avråds av Google och går emot deras bästa praxisriktlinjer för att hjälpa dem att förstå din webbplats.

Vi rekommenderar att du följer ovanstående robots.txt-format för att skapa en robots.txt-fil för din webbplats.

Vanliga frågor om WordPress robots.txt

Här är några av de vanligaste frågorna vi får om optimering av robots.txt-filen i WordPress.

1. Vad är huvudsyftet med en robots.txt-fil?

Huvudsyftet med en robots.txt-fil är att hantera din webbplats krypbudget. Genom att tala om för sökmotorer vilka sidor de ska ignorera (som administratörssidor eller plugin-filer) hjälper du dem att använda sina resurser till att krypa och indexera ditt viktigaste innehåll mer effektivt.

2. Var finns robots.txt-filen i WordPress?

Din robots.txt-fil finns i rotkatalogen på din webbplats. Du kan vanligtvis se den genom att gå till dindomän.com/robots.txt i din webbläsare.

3. Kan användning av robots.txt förbättra min webbplats säkerhet?

Nej, robots.txt är inte en säkerhetsåtgärd. Filen är offentligt synlig, så den hindrar faktiskt ingen från att komma åt de URL:er du listar. Den ger helt enkelt direktiv till väluppfostrade sökmotor-crawlers.

4. Ska jag blockera WordPress-kategori- och taggsidor i robots.txt?

Nej, du bör inte blockera kategori- och taggsidor. Dessa arkivsidor är användbara för SEO eftersom de hjälper sökmotorer att förstå din webbplats struktur och upptäcka ditt innehåll. Att blockera dem kan negativt påverka dina sökrankningar.

Ytterligare resurser om användning av robots.txt i WordPress

Nu när du vet hur du optimerar din robots.txt-fil, kanske du vill se några andra artiklar relaterade till att använda robots.txt i WordPress.

- Ordlista: Robots.txt

- Hur man döljer en WordPress-sida från Google

- Hur man stoppar sökmotorer från att krypa på en WordPress-sajt

- Hur man permanent raderar en WordPress-webbplats från internet

- Hur du enkelt döljer (Noindex) PDF-filer i WordPress

- Hur man åtgärdar felet "Googlebot kan inte komma åt CSS- och JS-filer" i WordPress

- Vad är llms.txt? Hur man lägger till llms.txt i WordPress

- Hur du ställer in All in One SEO för WordPress korrekt (ultimat guide)

Vi hoppas att den här artikeln hjälpte dig att lära dig hur du optimerar din WordPress robots.txt-fil för SEO. Du kanske också vill se vår ultimata WordPress SEO-guide och våra experttips för de bästa WordPress SEO-verktygen för att växa din webbplats.

Om du gillade den här artikeln, prenumerera då på vår YouTube-kanal för WordPress-videoguider. Du kan också hitta oss på Twitter och Facebook.

Steve

Tack för detta – hur fungerar det på en WP Multisite dock?

WPBeginner Support

För en multisite skulle du behöva ha en robots.txt-fil i rotmappen för varje webbplats.

Admin

Pacifique Ndanyuzwe

Min wordpress-sida är ny och min robot.txt som standard är

user-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

Jag vill att Google ska genomsöka och indexera mitt innehåll. Är den robots.txt okej?

WPBeginner Support

Du kan absolut använda det om du vill

Admin

Ritesh Seth

Bra artikel...

Jag var förvirrad i så många dagar om Robots.txt-filen och Disallow-länkar. Har kopierat taggarna för robots-filen. Hoppas detta löser problemet med min webbplats

WPBeginner Support

We hope our article will help as well

Admin

Kurt

Filerna i skärmdumparna av din hemmapp finns faktiskt under mappen public_html i min hemmapp.

Jag hade ingen /refer-mapp under min public_html-mapp.

Jag hade inga XML-filer för inlägg eller sidor någonstans på mitt WP-konto.

Jag inkluderade en post i robots.txt-filen jag skapade för att förbjuda genomsökning av min sandbox-webbplats. Jag är inte säker på att det är nödvändigt eftersom jag redan har valt alternativet i WP som säger åt sökmotorer att inte genomsöka min sandbox-webbplats, men jag tror inte att det skadar att ha posten.

WPBeginner Support

Some hosts do rename public_html to home which is why you see it there. You would want to ensure Yoast is active for the XML files to be available. The method in this article is an additional precaution to help with preventing crawling your site

Admin

Ahmed

Bra artikel

WPBeginner Support

Thank you

Admin

ASHOK KUMAR JADON

Hej, en så fin artikel du löste mitt problem. Så tack så mycket

WPBeginner Support

Glad our article could help

Admin

Elyn Ashton

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php <– Detta är min robot.txt-kod men jag är förvirrad över varför min /wp-admin indexeras? Hur kan jag undvika indexering av den?

WPBeginner Support

Om det indexerades tidigare kan du behöva ge tid för sökmotorns cache att rensas

Admin

Ashish kumar

Den här webbplatsen inspirerar mig verkligen att starta en blogg. Tack för allt team. Den här webbplatsens varje artikel är rik på information och förklaringar. När jag har något problem besöker jag först den här bloggen. Tack

WPBeginner Support

Glad our articles can be helpful

Admin

Anna

Jag försöker optimera robotar för min webbplats med Yoast. Men verktygen i Yoast har inte alternativet för 'Filredigerare'.

Det finns bara två alternativ

(i) Importera och exportera

(ii) Massredigerare

Kan du snälla ge råd om hur detta kan åtgärdas. Kan det vara så att jag använder en gratisversion av Yoast?

WPBeginner Support

Den kostnadsfria versionen av Yoast har fortfarande alternativet, din installation kan förhindra filredigering, i vilket fall du troligen skulle behöva använda FTP-metoden.

Admin

Emmanuel Husseni

Jag tycker verkligen att den här artikeln är hjälpsam eftersom jag verkligen inte vet mycket om hur robot.txt fungerar, men nu gör jag det.

Snälla, vad jag inte förstår är hur jag hittar det bästa formatet av robot.txt att använda på min webbplats (jag menar ett som fungerar generellt)?

Jag märkte att många stora bloggar jag följer rankar högt på sökmotorer och använder olika robot.txt-format.

Jag skulle vara glad att se ett svar från dig eller bara någon som kan hjälpa till

Redaktionell personal

Att ha en webbplatskarta och tillåta de områden som behöver tillåtas är den viktigaste delen. Avviseringsdelen varierar beroende på varje webbplats. Vi delade ett exempel i vårt blogginlägg, och det bör fungera för de flesta WordPress-webbplatser.

Admin

WPBeginner Support

Hej Emmanuel,

Se avsnittet om den ideala robots.txt-filen. Det beror på dina egna krav. De flesta bloggare exkluderar WordPress admin- och plugin-mappar från genomsökningen.

Admin

Emmanuel Husseni

Tack så mycket.

nu förstår jag. Jag antar att jag börjar med det allmänna formatet för nu.

jack

Välskriven artikel, jag rekommenderar användarna att göra en sitemap innan de skapar och aktiverar sin ROBOTS-text, det kommer att hjälpa din webbplats att genomsökas snabbare och indexeras enkelt.

Jack

Connie S Owens

Jag vill hindra sökmotorer från att indexera mina arkiv under deras genomsökning.

Emmanuel Nonye

Tack så mycket, den här artikeln var verkligen hjälpsam

Cherisa

Jag får hela tiden felmeddelandet nedan på Googles webbansvariga. Jag sitter i princip fast. Några saker som inte var tydliga för mig i den här handledningen är var hittar jag min webbplats rotfiler, hur avgör man om man redan har en "robots.txt" och hur redigerar man den?

WPBeginner Support

Hej Cherisa,

Din webbplats rotmapp är den som innehåller mappar som wp-admin, wp-includes, wp-content, etc. Den innehåller också filer som wp-config.php, wp-cron.php, wp-blogheader.php, etc.

Om du inte ser en robots.txt-fil i den här mappen, då har du ingen. Du kan fortsätta och skapa en ny.

Admin

Cherisa

Tack för ditt svar. Jag har letat överallt och kan inte hitta dessa rotfiler som du beskriver. Finns det en sökvägsmapp jag kan följa som leder till den här mappen. Som att den ligger under Inställningar, etc?

Devender

Jag hade en anständig webbtrafik till min webbplats. Plötsligt sjönk den till noll i maj månad. Ännu nu har jag haft problemet. Vänligen hjälp mig att återställa min webbplats.

Haris Aslam

Hej där Tack för denna information, men jag har en fråga

Jag skapar bara Sitemap.xml och Robots.txt-filen, och den indexeras bra. Men hur skapar jag "Product-Sitemap.xml"

Det finns en lista över produkter i sitemap.xml-filen. Måste jag skapa Product-sitemap.xml separat?

och skicka till Google eller Bing igen?

Kan du hjälpa mig?

Tack

Mahadi Hassan

Jag har ett problem med inställningen av robots.txt-filen. Endast en robots.txt visas för alla webbplatser. Vänligen hjälp mig att visa separata robots.txt-filer för alla webbplatser. Jag har alla separata robots.txt-filer för alla enskilda webbplatser. Men endast en robots.txt-fil visas i webbläsaren för alla webbplatser.

Debu Majumdar

Kan du förklara varför du inkluderade

Disallow: /refer/

i exemplet för nybörjare i Robots.txt? Jag förstår inte innebörden av den här raden. Är den viktig för nybörjare? Du har förklarat de andra två förbjudna raderna.

Tack.

WPBeginner Support

Hej Debu,

Detta exempel kommer från WPBeginners robots.txt-fil. På WPBeginner använder vi ThirstyAffiliates för att hantera affiliatelänkar och dölja URL:er. Dessa URL:er har /refer/ i sig, det är därför vi blockerar dem i vår robots.txt-fil.

Admin

Evaristo

Hur kan jag sätta alla taggar/mydomain.Com till nofollow? I robots.txt för att koncentrera länkkraften? Tack.

harsh kumar

hej,,jag får ett fel i yoast seo angående sitemap..när jag klickar på fixa det,,,kommer det igen..min webbplats html laddas inte ordentligt

Tom

Jag har precis granskat mitt Google Webmaster Tools-konto och med hjälp av Search Console har jag hittat följande:

Sidan laddades delvis

Alla sidresurser kunde inte laddas. Detta kan påverka hur Google ser och förstår din sida. Åtgärda tillgänglighetsproblem för alla resurser som kan påverka hur Google förstår din sida.

Detta beror på att alla CSS-stilmallar som är associerade med plugins är förbjudna av standard robots.txt.

Jag förstår goda skäl till varför jag inte bara borde tillåta detta, men vad skulle vara ett alternativ eftersom jag skulle misstänka att Googles algoritmer nedgraderar webbplatsen för att inte se dessa.

Suren

Hej,

När jag söker på min webbplats på Google visas den här texten under länken: "En beskrivning för detta resultat är inte tillgänglig på grund av webbplatsens robots.txt"

Hur kan jag lösa detta problem?

Med vänliga hälsningar

WPBeginner Support

Hej Suren,

Det verkar som att någon av misstag ändrade din webbplats sekretessinställningar. Gå till Inställningar » Läsa-sidan och scrolla ner till avsnittet 'Sökmotorers synlighet'. Se till att rutan bredvid är avmarkerad.

Admin

Divyesh

Hej

Som jag sett i webmasterverktyget fick jag en robot.txt-fil som nedan:

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

Låt mig veta om det är okej? Eller ska jag använda något annat?

John Cester

Jag vill veta, är det en bra idé att blockera (förbjuda) “/wp-content/plugins/” i robots.tx? Varje gång jag tar bort ett plugin får jag 404-fel på vissa sidor av det pluginet.

Himanshu singh

Jag älskade den här förklaringen. Som nybörjare var jag väldigt förvirrad över robot.txt-filen och dess användningsområden. Men nu vet jag vad dess syfte är.

rahul

i vissa robot.txt-filer har index.php förbjudits. Kan du förklara varför? Är det god praxis.

Waleed Barakat

Tack för att du tittade förbi denna värdefulla information.

Awais Ahmed

Kan du snälla berätta varför detta händer i webmasterverktyget:

Nätverket går inte att nå: robots.txt går inte att nåVi kunde inte krypa din webbplatskarta eftersom vi hittade en robots.txt-fil i roten av din webbplats men inte kunde ladda ner den. Se till att den är tillgänglig eller ta bort den helt.

robots.txt-fil finns men ändå

Dozza

Intressant uppdatering från Yoast-teamet om detta på

Citat: ”De gamla bästa metoderna att ha en robots.txt som blockerar åtkomst till din wp-includes-katalog och din plugins-katalog är inte längre giltiga.”

natveimaging

Tillåt: /wp-content/uploads/

Borde inte detta vara?

Disallow: /wp-content/uploads/

För du är medveten om att Google kommer att indexera alla dina uppladdningssidor som offentliga URL:er, eller hur? Och då kommer du att få felmeddelanden för själva sidan. Är det något jag missar här?

nativeimaging

Sammantaget är det de faktiska sidorna som Google kryper för att generera bildkartor, INTE uppladdningsmapparna. Då skulle du ha problem med att alla mindre bildstorlekar och andra bilder som är för UI också kommer att indexeras.

Detta verkar vara det bästa alternativet:

Disallow: /wp-content/uploads/

Om jag har fel, förklara detta för mig så att jag kan förstå din vinkel här.

Jason

Min bloggs URL indexeras inte, behöver jag ändra min robots.txt?

Jag använder denna robots.txt

iyan

hur man skapar robot txt som ENDAST tillåter indexering för sida och inlägg.. tack

Simaran Singh

Jag är inte säker på vad problemet är, men min robots.txt har två versioner.

En på http://www.example.com/robots.txt och en annan på example.com/robots.txt

Någon, snälla hjälp! Låt mig veta vad som kan vara den möjliga orsaken och hur jag kan korrigera det?

WPBeginner Support

Mest troligt tillåter din webbhotell att din webbplats nås med både www och icke-www-URL:er. Försök att ändra robots.txt med en FTP-klient. Granska den sedan från båda URL:erna om du kan se dina ändringar på båda URL:erna, då betyder det att det är samma fil.

Admin

Simaran Singh

Tack för det snabba svaret. Jag har redan gjort det, men jag kan inte se någon förändring. Finns det något annat sätt att lösa det?

Martin conde

Yoasts blogpost about this topic was right above yours in my search so of course I checked them both. They are contradicting each other a little bit.. For example yoast said that disallowing plugin directories and others, might hinder the Google crawlers when fetching your site since plugins may output css or js. Also mentioned (and from my own experience), yoast doesn’t add anything sitemap related to the robots.txt, rather generates it so that you can add it to your search console. Here is the link to his post, maybe you can re-check because it is very hard to choose whose word to take for it

MM Nauman

Eftersom jag inte är bra på att skapa den här Robotstxt-filen, kan jag använda din Robots.txt-fil genom att ändra parametrarna som URL och sitemap för min webbplats, är det bra? eller ska jag skapa en annan?

Mohit Chauhan

Hej,

Idag fick jag detta mejl från Google “Googlebot kan inte komma åt CSS- och JS-filer”…vad kan vara lösningen?

Tack

Parmod

Låt mig gissa… Du använder CDN-tjänster för att importera CSS- och JS-filer.

eller

Det kan vara så att du har skrivit fel syntax i dessa filer.

Rahul

Jag har en fråga om att lägga till Sitemaps. Hur kan jag lägga till Yahoo och Bing Sitemap till Robots-filen och WordPress-katalogen?

Gerbrand Petersen

Tack för den utförliga översikten över hur man använder robots-filen. Vet någon om Yahoo också använder denna robots.txt, och följer den reglerna som nämns i filen? Jag frågar detta eftersom jag har en "Disallow" för en viss sida i min fil, men jag får trafik från Yahoo till den sidan. Inget från Google, som det ska vara. Tack på förhand.

Erwin

korrigering...

"Om du använder Yoasts WordPress SEO-plugin eller något annat plugin för att generera din XML-sitemap, kommer ditt plugin att försöka lägga till dina sitemap-relaterade rader automatiskt i robots.txt-filen."

Inte sant. WordPress SEO lägger inte till sitemappen i robots.txt

"Jag har alltid ansett att det är lite nonsens att länka till din XML-sitemap från din robots.txt. Du bör lägga till dem manuellt i dina Google och Bing Webmaster Tools och se till att du tittar på deras feedback om din XML-sitemap. Det är anledningen till att vårt WordPress SEO-plugin inte lägger till det i din robots.txt."

https://yoast.com/wordpress-robots-txt-example/

Det rekommenderas också mer att inte blockera katalogen wp-plugins (skäl se Yoasts inlägg)

Och personligen gillar jag att bara ta bort readme.txt-filen...

hyma

Jag förstod det med robots.txt-filen och användningen av robots-filen. Vad är webbplatskartan, hur skapar jag en webbplatskarta för min webbplats.

Rick R. Duncan

Efter att ha läst Googles dokumentation är jag av den uppfattningen att direktivet att använda i robots.txt-filen är disallow, vilket bara talar om för robotarna vad de kan och inte kan krypa. Det talar inte om för dem vad som kan och inte kan indexeras. Du måste använda noindex robots meta-taggen för att en sida inte ska indexeras.

Nitin

riktigt bra artikel för SEO-optimerade robots.txt-filer. Men jag behöver att du ger en handledning om hur man laddar upp robots.txt-filen till servern. Eftersom det verkar vara ett stort problem för en nybörjare att ladda upp den filen.

Förresten, tack för att du delade sådan gynnsam information.

-Nitin

Parmod

Ladda upp den till din server/public_hmtl/(Ditt-webbplatsnamn) ... i den här mappen

Jenny

Vad är det bästa sättet att lägga till kod i HTTacess för att blockera flera spamrobotreferenser för deras URL och IP-adress om ingen URL anges

Jag vet att om du får fel syntax när du gör httacess kan det ta din webbplats offline. Jag är nybörjare och behöver blockera dessa irriterande flera URL:er från Ryssland, Kina, Ukraina etc.

Många tack

Hazel Andrews

Tack för de tipsen....robot txt-filerna är nu ändrade! jippi!

Rahat

varför måste man lägga till Allow: !!!

om jag bara nämner vad som ska Disallow räcker det. Behöver inte skriva kod för Allow eftersom Googlebot eller Bingbot kommer att genomsöka allt annat automatiskt.

Så varför ska jag använda Allow igen?

Connor Rickett

Eftersom avsaknaden av Robots.txt-filen inte hindrar webbplatsen från att krypas, är jag nyfiken: Finns det några hårda data om exakt hur mycket filen kommer att förbättra SEO-prestandan?

Jag gjorde en snabb Google-sökning och såg ingen kvantitativ data om det. Det finns ungefär en halv miljon artiklar som säger: ”Hej, det här förbättrar SEO!” men jag skulle verkligen vilja veta vad vi pratar om här, även generellt.

Är det en ökning med 5 %? 50? 500?

WPBeginner Support

Sökmotorer delar inte sådan data. Även om det inte finns någon robots.txt-fil hindrar det inte sökmotorer från att krypa eller indexera en webbplats. Det är dock en rekommenderad bästa praxis.

Admin

Connor Rickett

Tack för att du tog dig tid att svara, jag uppskattar det!

JD Myers

Bra tajming för detta. Jag försökte hitta den här informationen igår.

Anledningen till att jag sökte efter det är att Google Webmaster Tools sa till mig att de inte kunde krypa min webbplats ordentligt eftersom jag blockerade olika resurser som behövdes för korrekt rendering av sidan.

Dessa resurser inkluderade de som finns i /wp-content/plugins/

Efter att jag tillät den här mappen försvann varningen.

Några tankar om detta?

WPBeginner Support

Du kan tryggt ignorera dessa varningar. Det är bara en varning om du faktiskt hade innehåll där som du skulle vilja indexera. Ibland har användare begränsat sökmotorer och har glömt bort det. Dessa varningar är användbara i de situationerna.

Admin

Chetan jadhav

Jag har en fråga, många där ute använder statiska sitemap, och du vet att de har en WordPress-sida. Ska vi använda statisk eller sitemap genererad av WordPress.

Wilton Calderon

Trevligt, jag gillar hur Wpbeginner har det, och med den rankingen i Alexa, ser det ut för mig som ett av de bästa sätten att använda robots.txt..

Brigitte Burke

vad betyder min robots.txt-fil om den ser ut så här?

User-agent: *

Disallow: /wp-admin/

Disallow: /wp-includes/

Disallow: /xmlrpc.php

Redaktionell personal

Det säger bara att sökmotorer inte ska indexera din wp-admin-mapp, wp-includes-mapp och xml-rpc-filen. Ibland kan blockering av /wp-includes/ blockera vissa skript för sökmotorer, särskilt om din webbplats använder dessa skript. Detta kan skada din SEO.

Det bästa är att gå till Google Webmaster Tools och hämta din webbplats som en bot där. Om allt laddas bra, då har du inget att oroa dig för. Om det står att skript blockeras, då kanske du vill ta bort wp-includes-raden.

Admin

hercules

Jag ser ingen logik i din idé om att ha ett skript inom inkluderingskatalogen som kan användas av en crawler / robot .. och en annan, om det finns ett isolerat fall, är det bättre efter att ha specificerat standard WordPress tillåt denna fil du föreställer dig att sökmotorer använder sina skript! trots allt har WordPress säkert inte som standard en robots.txt mot sökmotorer!!!!